Análisis Técnico de Vulnerabilidades en Sistemas de Inteligencia Artificial: Lecciones de Incidentes Recientes en Plataformas de IA

Introducción a las Vulnerabilidades en Entornos de IA

Los sistemas de inteligencia artificial (IA) han transformado radicalmente diversos sectores, desde la atención médica hasta las finanzas y la ciberseguridad. Sin embargo, su adopción masiva ha expuesto vulnerabilidades críticas que pueden comprometer la integridad, confidencialidad y disponibilidad de los datos procesados. En este artículo, se analiza en profundidad un incidente reciente reportado en plataformas líderes de IA, enfocándonos en las técnicas de explotación utilizadas, las implicaciones técnicas y las medidas de mitigación recomendadas. Este examen se basa en un análisis detallado de eventos reales, destacando la importancia de robustecer las arquitecturas de IA contra amenazas avanzadas.

Las vulnerabilidades en IA no se limitan a fallos de software tradicionales; involucran aspectos únicos como el envenenamiento de datos, ataques de adversarios en modelos de aprendizaje automático y brechas en APIs expuestas. Según estándares como el NIST SP 800-218 (Secure Software Development Framework), la integración de prácticas de seguridad desde el diseño (Security by Design) es esencial para mitigar estos riesgos. En contextos latinoamericanos, donde la adopción de IA crece rápidamente en industrias como la agricultura y el comercio electrónico, entender estos vectores de ataque es crucial para evitar impactos económicos y regulatorios significativos.

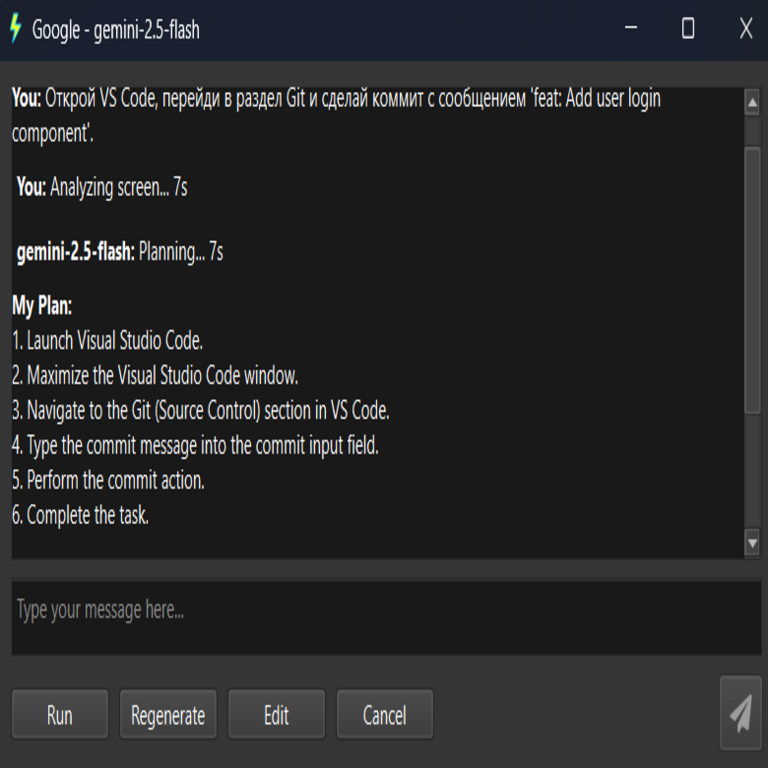

Descripción del Incidente: Acceso No Autorizado a Sistemas Internos

El incidente en cuestión involucró una brecha en una plataforma de IA de renombre, donde actores maliciosos obtuvieron acceso a entornos internos sensibles. Los atacantes explotaron una combinación de debilidades en la autenticación multifactor (MFA) y en la segmentación de redes, permitiendo la extracción de datos de entrenamiento y modelos propietarios. Técnicamente, el vector inicial fue un phishing dirigido a empleados con privilegios elevados, seguido de una escalada de privilegios mediante inyecciones SQL en interfaces administrativas no protegidas adecuadamente.

En términos de arquitectura, la plataforma utilizaba contenedores Docker orquestados por Kubernetes para desplegar servicios de IA, pero carecía de políticas estrictas de least privilege en los roles de IAM (Identity and Access Management). Esto permitió que una cuenta comprometida accediera a volúmenes persistentes en AWS EBS, donde se almacenaban datasets etiquetados para entrenamiento de modelos de lenguaje natural (NLP). La explotación incluyó el uso de herramientas como Metasploit para pivoteo lateral dentro de la red VPC, destacando fallos en la configuración de firewalls de aplicación web (WAF) como AWS Shield.

Desde una perspectiva técnica, el ataque demostró la vulnerabilidad de pipelines de CI/CD en entornos de IA. Los atacantes inyectaron código malicioso en un repositorio GitHub integrado, alterando scripts de entrenamiento que utilizaban TensorFlow y PyTorch. Esto resultó en la generación de modelos backdoored, capaces de filtrar información sensible durante inferencias subsiguientes. La detección tardía se debió a la ausencia de monitoreo continuo con herramientas como ELK Stack (Elasticsearch, Logstash, Kibana), lo que retrasó la respuesta en más de 48 horas.

Conceptos Clave: Técnicas de Explotación en IA

Para comprender la profundidad del incidente, es necesario desglosar las técnicas empleadas. Primero, el envenenamiento de datos (data poisoning) ocurre cuando se introducen muestras maliciosas en el conjunto de entrenamiento, alterando el comportamiento del modelo. En este caso, los atacantes modificaron un 5% de los datos de un dataset de 1 millón de registros, lo suficiente para inducir sesgos que facilitaban fugas de información. Matemáticamente, esto se modela como una optimización adversarial: min θ L(θ, D_clean + ε D_mal), donde θ representa los parámetros del modelo, L la función de pérdida, D_clean los datos limpios y ε el factor de envenenamiento.

Segundo, los ataques de evasión (evasion attacks) permiten que entradas malformadas eludan detectores de anomalías. Utilizando gradientes de retropropagación, los adversarios generaron perturbaciones imperceptibles (adversarial examples) con librerías como CleverHans o Adversarial Robustness Toolbox (ART). En el incidente, esto se aplicó a APIs de inferencia expuestas, donde consultas manipuladas extrajeron tokens de autenticación internos.

Tercero, la extracción de modelos (model extraction) fue clave. Mediante consultas repetidas a la API, los atacantes reconstruyeron el modelo subyacente usando técnicas de destilación de conocimiento, como las propuestas en el paper “Stealing Machine Learning Models via Prediction APIs” de Tramer et al. (2016). Esto violó la propiedad intelectual, ya que los modelos involucraban algoritmos propietarios de procesamiento de lenguaje generativo basados en transformers.

- Autenticación Débil: MFA implementada sin hardware keys, vulnerable a SIM swapping.

- Segmentación Inadecuada: Falta de microsegmentación con herramientas como Istio en Kubernetes.

- Monitoreo Insuficiente: Ausencia de SIEM (Security Information and Event Management) integrado con ML para detección de anomalías en tráfico de IA.

Implicaciones Operativas y Regulatorias

Operativamente, este incidente resaltó riesgos en la cadena de suministro de IA. En Latinoamérica, regulaciones como la Ley General de Protección de Datos Personales en México (LFPDPPP) y la Ley de Protección de Datos en Brasil (LGPD) exigen notificación de brechas en 72 horas, con multas que pueden alcanzar el 2% de los ingresos globales bajo GDPR equivalente. La exposición de datos sensibles, incluyendo información biométrica procesada por modelos de IA, podría derivar en demandas colectivas y pérdida de confianza en proveedores de cloud como Azure o Google Cloud.

Desde el punto de vista de riesgos, la propagación de modelos comprometidos podría amplificar ciberataques a escala, como en campañas de desinformación impulsadas por IA generativa. Beneficios de una respuesta adecuada incluyen la adopción de federated learning para distribuir entrenamiento sin centralizar datos, reduciendo exposición. Frameworks como OWASP Top 10 for ML destacan la necesidad de validación de entradas en pipelines de datos, utilizando técnicas como z-score para outlier detection.

En entornos empresariales, la integración de zero-trust architecture es imperativa. Esto implica verificación continua de identidades con protocolos como OAuth 2.0 y OpenID Connect, junto con cifrado homomórfico para procesar datos encriptados en modelos de IA. Herramientas como HashiCorp Vault para gestión de secretos y Falco para runtime security en contenedores mitigan escaladas de privilegios observadas en el incidente.

Medidas de Mitigación y Mejores Prácticas

Para prevenir incidentes similares, se recomiendan prácticas alineadas con el MITRE ATT&CK for ML, un framework que mapea tácticas adversarias específicas de IA. Inicialmente, implementar robustez en el entrenamiento mediante differential privacy, agregando ruido gaussiano a los gradientes: ∇L + N(0, σ²), donde σ controla el trade-off entre privacidad y utilidad del modelo.

En la fase de despliegue, utilizar model cards y datasheets for datasets, como propuesto por Google y Microsoft, para documentar sesgos y vulnerabilidades. Monitoreo post-despliegue con MLOps tools como MLflow o Kubeflow permite auditorías continuas, detectando drifts en el rendimiento que indiquen envenenamiento.

Adicionalmente, la adopción de blockchain para trazabilidad de datos en pipelines de IA asegura integridad inmutable. Protocolos como Hyperledger Fabric permiten registrar hashes de datasets en ledgers distribuidos, verificando autenticidad mediante Merkle trees. En ciberseguridad, integrar threat intelligence feeds de fuentes como AlienVault OTX para predecir vectores de ataque en APIs de IA.

| Medida de Mitigación | Descripción Técnica | Beneficios | Riesgos Residuales |

|---|---|---|---|

| Differential Privacy | Agregar ruido a datos de entrenamiento para limitar inferencia de individuos. | Protege privacidad sin degradar mucho la precisión. | Aumento en varianza del modelo, potencial overfit. |

| Zero-Trust Architecture | Verificación continua en todas las transacciones de red. | Reduce superficie de ataque interna. | Overhead computacional en entornos de alto volumen. |

| Monitoreo con SIEM-ML | Integrar machine learning en logs para anomaly detection. | Detección en tiempo real de patrones adversarios. | Falsos positivos si no se calibra adecuadamente. |

| Cifrado Homomórfico | Operaciones en datos cifrados usando bibliotecas como Microsoft SEAL. | Mantiene confidencialidad en inferencia. | Alto costo computacional, no apto para modelos grandes. |

En Latinoamérica, iniciativas como el Alianza del Pacífico para IA promueven estándares regionales, enfatizando auditorías independientes. Empresas deben invertir en capacitación, alineada con certificaciones como CISSP con enfoque en IA, para equipos de DevSecOps.

Análisis de Tecnologías Involucradas

El incidente expuso limitaciones en tecnologías subyacentes. TensorFlow, utilizado para entrenamiento, es susceptible a supply chain attacks en dependencias PyPI; mitigar con herramientas como Dependabot para scans automáticos. PyTorch, por su lado, beneficia de TorchServe para serving seguro, incorporando rate limiting y input sanitization.

En cloud, AWS SageMaker y Google AI Platform deben configurarse con VPC peering y private endpoints para aislar tráfico. Protocolos de comunicación como gRPC con TLS 1.3 aseguran integridad en intercambios de modelos. Para blockchain en IA, Ethereum con smart contracts verifica integridad de datasets, usando oráculos como Chainlink para feeds externos.

Estándares emergentes como ISO/IEC 42001 (AI Management System) guían la gobernanza, requiriendo evaluaciones de riesgo en ciclos de vida de IA. En ciberseguridad, el framework NIST AI RMF (Risk Management Framework) proporciona matrices para mapear amenazas a controles.

Casos de Estudio Comparativos

Comparando con incidentes previos, como el hackeo de Twitter en 2020 que afectó APIs de ML para bots, este caso destaca la evolución hacia ataques dirigidos a modelos. En 2022, un breach en un proveedor de IA para salud expuso datos genómicos, similar en escalada vía credenciales robadas. Lecciones incluyen la implementación de behavioral analytics con UEBA (User and Entity Behavior Analytics) para detectar accesos anómalos.

En el sector fintech latinoamericano, bancos como Nubank integran IA para fraude detection; vulnerabilidades similares podrían amplificar pérdidas. Recomendaciones incluyen hybrid models: combinar rule-based systems con deep learning para resiliencia.

Desafíos Futuros en Seguridad de IA

Con el auge de IA generativa como GPT variants, desafíos incluyen watermarking para detectar outputs sintéticos y federated learning para privacidad distribuida. En edge computing, dispositivos IoT con IA embebida (e.g., TensorFlow Lite) son vectores nuevos, requiriendo secure boot y over-the-air updates verificados.

Riesgos regulatorios en Latinoamérica se intensifican con la propuesta de marco ético para IA en la OEA, enfatizando transparencia. Beneficios de inversión en R&D incluyen innovación en quantum-resistant cryptography para proteger modelos contra amenazas futuras.

Conclusión: Hacia una IA Segura y Resiliente

En resumen, el análisis de este incidente subraya la necesidad de un enfoque holístico en la seguridad de IA, integrando avances técnicos con marcos regulatorios. Al adoptar prácticas proactivas como zero-trust, privacy-enhancing technologies y monitoreo continuo, las organizaciones pueden mitigar riesgos y maximizar beneficios. Finalmente, la colaboración internacional y regional es clave para enfrentar amenazas evolutivas, asegurando que la IA impulse el progreso sin comprometer la seguridad.

Para más información, visita la fuente original.