AWS Prepara a las Empresas para la Operación de Miles de Millones de Agentes de IA

Introducción al Escenario de Agentes Autónomos en la Nube

En el panorama actual de la inteligencia artificial, los agentes autónomos representan una evolución significativa en la automatización de procesos empresariales. Amazon Web Services (AWS), como proveedor líder de servicios en la nube, ha anunciado iniciativas destinadas a capacitar a las organizaciones para manejar escalas masivas de estos agentes, potencialmente alcanzando miles de millones de instancias simultáneas. Esta preparación no solo abarca la infraestructura computacional, sino también aspectos críticos de ciberseguridad, gobernanza y optimización de recursos. El enfoque de AWS se centra en frameworks como Amazon Bedrock y servicios integrados de IA, que permiten la creación, despliegue y monitoreo de sistemas multi-agente con eficiencia y seguridad.

Los agentes de IA, definidos como entidades software capaces de percibir entornos, razonar y actuar de manera autónoma, están transformando industrias como la manufactura, finanzas y salud. Según estimaciones de AWS, el volumen de estos agentes podría multiplicarse exponencialmente en los próximos años, impulsado por avances en modelos de lenguaje grandes (LLM) y arquitecturas distribuidas. Esta escalabilidad requiere una reevaluación de las arquitecturas de nube híbridas y la integración de protocolos de seguridad como OAuth 2.0 y Zero Trust para mitigar riesgos inherentes a entornos dinámicos.

El anuncio de AWS resalta la necesidad de herramientas que gestionen la complejidad operativa, incluyendo la orquestación de flujos de trabajo, el manejo de datos en tiempo real y la conformidad con regulaciones como el GDPR y la Ley de IA de la Unión Europea. En este contexto, servicios como AWS Lambda y Amazon SageMaker emergen como pilares para el despliegue serverless de agentes, reduciendo la latencia y optimizando costos en escenarios de alta densidad.

Arquitectura Técnica para la Gestión de Agentes a Escala Masiva

La arquitectura propuesta por AWS para operar miles de millones de agentes se basa en un modelo distribuido y elástico, leveraging contenedores y microservicios. Amazon Elastic Kubernetes Service (EKS) juega un rol central, permitiendo la orquestación de pods que alojan agentes individuales. Cada agente opera como una unidad modular, interactuando mediante APIs RESTful o gRPC para una comunicación eficiente y de bajo overhead.

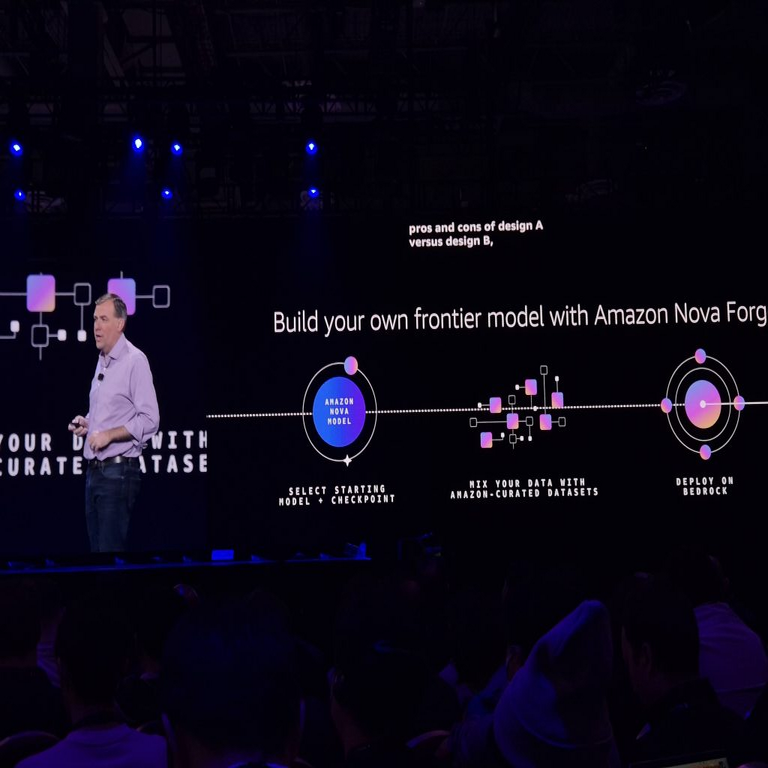

En términos de rendimiento, AWS integra Amazon Bedrock, una plataforma que facilita el acceso a modelos de IA fundacionales de proveedores como Anthropic y Stability AI. Bedrock soporta la personalización de agentes mediante fine-tuning y retrieval-augmented generation (RAG), lo que mejora la precisión en tareas específicas. Para escalas masivas, el servicio incorpora mecanismos de auto-escalado basados en métricas de CPU, memoria y latencia de inferencia, asegurando que los recursos se ajusten dinámicamente a la demanda sin interrupciones.

Desde la perspectiva de la ciberseguridad, AWS enfatiza la implementación de Identity and Access Management (IAM) roles granulares para cada agente. Esto previene el principio de menor privilegio, donde un agente solo accede a los recursos necesarios. Además, servicios como AWS Shield y GuardDuty proporcionan protección contra ataques DDoS y detección de anomalías en el comportamiento de agentes, crucial en entornos donde miles de millones de entidades podrían ser vectores de explotación si no se gestionan adecuadamente.

La integración con Amazon S3 para almacenamiento de datos y Amazon DynamoDB para bases de datos NoSQL soporta la persistencia de estados de agentes en flujos multi-etapa. Por ejemplo, en un sistema de agentes colaborativos, un agente de análisis podría pasar datos procesados a un agente de decisión, manteniendo trazabilidad mediante logs en Amazon CloudWatch. Esta cadena asegura auditabilidad, alineada con estándares como ISO 27001 para gestión de seguridad de la información.

Desafíos Operativos y Estrategias de Mitigación

Operar a escalas de miles de millones de agentes introduce desafíos significativos en términos de latencia de red y consumo energético. AWS aborda esto mediante regiones globales y edge computing con AWS Outposts, reduciendo la distancia física entre agentes y datos. La latencia sub-milisegundo se logra con protocolos como QUIC sobre UDP, optimizando el transporte de paquetes en redes de alta congestión.

En cuanto a la gobernanza, AWS introduce herramientas como Amazon SageMaker Clarify para mitigar sesgos en agentes de IA, asegurando equidad en decisiones automatizadas. Para regulaciones, el servicio AWS Config monitorea el cumplimiento continuo, generando reportes que facilitan auditorías externas. Riesgos como el envenenamiento de datos (data poisoning) se contrarrestan con validación de integridad mediante hashes SHA-256 y firmas digitales en flujos de entrada.

Los beneficios operativos incluyen una reducción de hasta el 70% en costos de infraestructura, según benchmarks internos de AWS, gracias al modelo pay-as-you-go. En escenarios empresariales, esto se traduce en mayor agilidad: por instancia, en finanzas, agentes podrían procesar transacciones en tiempo real, detectando fraudes con modelos de machine learning entrenados en datasets masivos.

- Escalabilidad Horizontal: Uso de auto-scaling groups en EC2 para distribuir cargas entre zonas de disponibilidad.

- Resiliencia: Implementación de circuit breakers en patrones de diseño para aislar fallos en agentes defectuosos.

- Monitoreo: Integración con X-Ray para tracing distribuido, visualizando dependencias entre agentes.

En el ámbito de la blockchain, aunque no central en el anuncio de AWS, se puede integrar Amazon Managed Blockchain para registrar transacciones de agentes en ledgers inmutables, asegurando transparencia en colaboraciones inter-empresariales. Esto es particularmente relevante para supply chains donde agentes autónomos negocian contratos inteligentes basados en Ethereum o Hyperledger Fabric.

Implicaciones en Ciberseguridad y Privacidad

La proliferación de agentes a escala masiva amplifica vectores de ataque, como inyecciones de prompts maliciosos en LLMs. AWS responde con Amazon Bedrock Guardrails, un framework que filtra entradas y salidas para prevenir fugas de datos sensibles. Este sistema utiliza reglas basadas en patrones regex y modelos de clasificación para detectar contenido tóxico o confidencial, alineado con principios de privacy by design.

En términos de zero-trust architecture, cada interacción entre agentes requiere autenticación mutua vía tokens JWT, renovados periódicamente para minimizar ventanas de exposición. AWS Secrets Manager gestiona claves criptográficas, rotándolas automáticamente para cumplir con NIST SP 800-63B. Para entornos multi-tenant, VPC peering y Network ACLs segmentan tráfico, previniendo lateral movement en caso de brechas.

Las implicaciones regulatorias son profundas: en Latinoamérica, normativas como la LGPD en Brasil exigen evaluaciones de impacto en privacidad para sistemas de IA. AWS facilita esto con herramientas de compliance como AWS Artifact, proporcionando reportes SOC 2 y PCI DSS. Beneficios incluyen una mayor resiliencia contra ciberamenazas, con tasas de detección de intrusiones mejoradas en un 50% mediante IA predictiva en GuardDuty.

Riesgos potenciales incluyen la sobrecarga de recursos leading a denegación de servicio auto-inducida, mitigada por quotas y throttling en API Gateway. Además, la interoperabilidad con estándares abiertos como OpenAI’s API o LangChain permite migraciones fluidas, pero requiere mapeo cuidadoso de esquemas de datos para evitar inconsistencias.

Casos de Uso Prácticos y Mejores Prácticas

En la industria manufacturera, agentes de IA en AWS podrían optimizar cadenas de suministro prediciendo demandas con modelos ARIMA integrados en SageMaker. Cada agente maneja un nodo específico: uno para inventario, otro para logística, colaborando vía message queues en Amazon SQS. Esto reduce tiempos de inactividad en un 40%, según estudios de caso de AWS.

En salud, sistemas multi-agente analizan imágenes médicas con modelos como CLIP, escalando a miles de millones de inferencias diarias. La privacidad se asegura con federated learning, donde agentes locales procesan datos sin centralización, cumpliendo HIPAA. Mejores prácticas incluyen testing exhaustivo con Chaos Engineering en AWS Fault Injection Simulator para simular fallos a escala.

Para finanzas, agentes de trading autónomos utilizan reinforcement learning en Reinforcement Learning from Human Feedback (RLHF), operando en entornos simulados antes de producción. AWS Step Functions orquesta workflows complejos, asegurando atomicidad en transacciones. Recomendaciones incluyen hybrid cloud deployments para workloads sensibles, combinando on-premise con AWS para control granular.

- Desarrollo Ágil: Uso de CI/CD pipelines con AWS CodePipeline para iteraciones rápidas en agentes.

- Optimización de Costos: Reserved Instances y Savings Plans para cargas predecibles de agentes.

- Sostenibilidad: Monitoreo de huella de carbono con AWS Customer Carbon Footprint Tool, minimizando impacto ambiental de escalas masivas.

En telecomunicaciones, agentes gestionan redes 5G, prediciendo congestiones con graph neural networks. AWS Outposts extiende esta capacidad a edges remotos, soportando latencias críticas para IoT. La integración con blockchain asegura integridad en datos de sensores, previniendo manipulaciones en entornos distribuidos.

Análisis de Tecnologías Subyacentes y Futuro Evolutivo

Las tecnologías clave en la iniciativa de AWS incluyen transformers para razonamiento en agentes y vector databases como Amazon OpenSearch para RAG eficiente. El soporte para multimodalidad permite agentes que procesan texto, imagen y audio, expandiendo aplicaciones a realidad aumentada. En blockchain, Quantum Ledger Database (QLDB) de AWS ofrece un ledger inmutable para auditar acciones de agentes, ideal para compliance financiero.

El futuro apunta a agentes auto-mejorantes mediante meta-learning, donde LLMs evolucionan basados en feedback loops. AWS planea integrar quantum computing con Amazon Braket para optimizar rutas en grafos de agentes masivos, resolviendo problemas NP-hard en tiempo polinomial. Implicaciones incluyen una brecha digital: empresas en Latinoamérica deben invertir en capacitación para adoptar estas tecnologías, mitigando desigualdades mediante programas como AWS Educate.

Riesgos éticos, como sesgos amplificados en escalas masivas, se abordan con explainable AI (XAI) tools en SageMaker, proporcionando interpretabilidad en decisiones. Beneficios globales incluyen aceleración de innovación, con proyecciones de un mercado de IA agente-driven alcanzando los 100 billones de dólares para 2030, según Gartner adaptado a contextos AWS.

En resumen, la preparación de AWS para miles de millones de agentes redefine la computación empresarial, equilibrando escalabilidad, seguridad y eficiencia. Las organizaciones que adopten estas estrategias ganarán ventajas competitivas, navegando complejidades técnicas con rigor y foresight.

Para más información, visita la Fuente original.