El Desarrollo de la Inteligencia Artificial: Una Perspectiva Estratégica a Largo Plazo desde AMD

Introducción al Panorama Actual de la Inteligencia Artificial

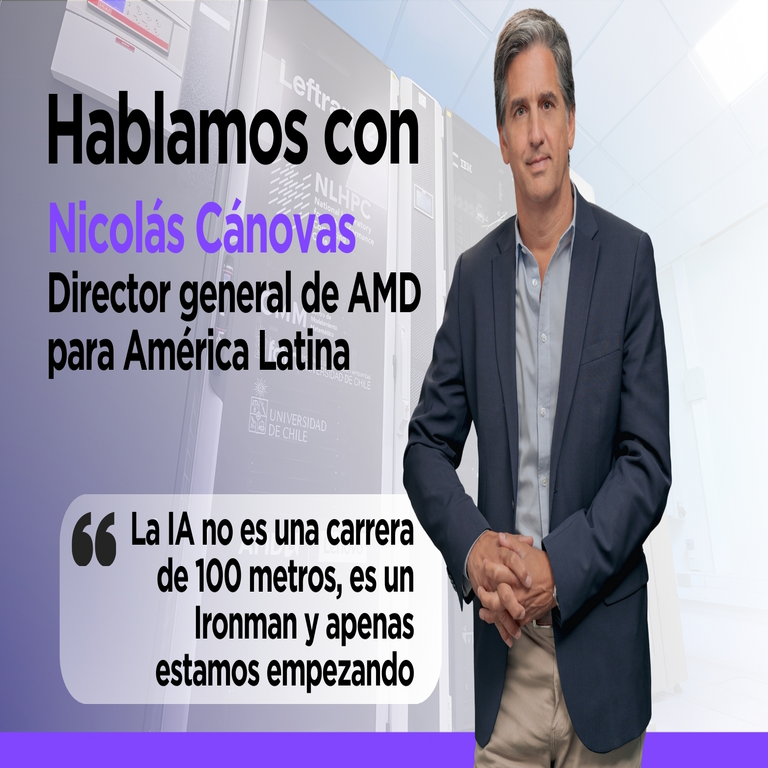

La inteligencia artificial (IA) ha emergido como uno de los pilares fundamentales de la transformación tecnológica en la era digital. En los últimos años, avances en algoritmos de aprendizaje profundo, redes neuronales y procesamiento de datos masivos han impulsado aplicaciones en sectores como la salud, el transporte y la manufactura. Sin embargo, el desarrollo de la IA no se limita a innovaciones puntuales; requiere una visión estratégica que considere la sostenibilidad, la escalabilidad y la integración con infraestructuras existentes. Nicolás Canovas, director de IA en AMD, describe este proceso no como una carrera corta de 100 metros, sino como un Ironman: un desafío de resistencia que apenas inicia. Esta analogía resalta la necesidad de inversiones continuas en hardware, software y ecosistemas colaborativos para superar obstáculos técnicos y éticos.

Desde una perspectiva técnica, la IA se basa en modelos computacionales que procesan grandes volúmenes de datos mediante operaciones paralelas intensivas. Frameworks como TensorFlow y PyTorch, junto con hardware acelerado como unidades de procesamiento gráfico (GPUs), son esenciales para entrenar modelos que demandan terabytes de datos y petaflops de cómputo. AMD, como proveedor clave de soluciones de cómputo de alto rendimiento (HPC), juega un rol pivotal en este ecosistema, ofreciendo procesadores Ryzen con aceleradores de IA integrados y GPUs Instinct diseñadas para cargas de trabajo de machine learning (ML).

El análisis de las declaraciones de Canovas subraya que la IA no es un fenómeno aislado, sino un continuum evolutivo. Implicaciones operativas incluyen la optimización de centros de datos para reducir el consumo energético, estimado en hasta 8% del total global para 2030 según informes de la Agencia Internacional de Energía. Regulatoriamente, normativas como el Reglamento General de Protección de Datos (RGPD) en Europa y la Ley de IA de la Unión Europea exigen transparencia en algoritmos y mitigación de sesgos, lo que AMD aborda mediante herramientas de desarrollo ético en su stack de software ROCm.

El Rol Estratégico de AMD en el Ecosistema de la IA

AMD ha posicionado sus tecnologías como ejes centrales para el avance de la IA, enfocándose en la integración de cómputo heterogéneo. Sus procesadores EPYC, basados en la arquitectura Zen, incorporan núcleos con instrucciones vectoriales avanzadas (AVX-512) que aceleran operaciones de IA como convoluciones en redes neuronales convolucionales (CNN). Canovas enfatiza que AMD no compite en velocidad inmediata, sino en sostenibilidad a largo plazo, alineándose con la demanda de infraestructuras que soporten el entrenamiento de modelos grandes como GPT-4, que requieren miles de GPUs interconectadas.

En términos de hardware, la serie Instinct MI300X de AMD representa un hito en memoria unificada (HBM3), permitiendo un ancho de banda de hasta 5.3 TB/s, crucial para el procesamiento de grafos en modelos de lenguaje natural (NLP). Esta arquitectura reduce latencias en el intercambio de datos entre CPU y GPU, optimizando flujos de trabajo en entornos de alto rendimiento. Comparado con competidores, AMD prioriza la eficiencia energética, con un TDP (Thermal Design Power) equilibrado que minimiza el impacto ambiental, un factor clave en la adopción de IA en edge computing.

Desde el punto de vista del software, el stack ROCm de AMD proporciona un entorno abierto para desarrolladores, compatible con bibliotecas como MIOpen para operaciones de deep learning y HIP para portabilidad de código CUDA. Canovas destaca colaboraciones con empresas como Microsoft y Hugging Face, que integran estas herramientas en plataformas cloud como Azure, facilitando el despliegue de modelos preentrenados. Esta apertura contrasta con ecosistemas cerrados, promoviendo innovación comunitaria y reduciendo barreras de entrada para startups en IA.

Las implicaciones operativas de estas estrategias incluyen la escalabilidad en supercomputadoras. Por ejemplo, el sistema Frontier, impulsado por AMD, alcanzó exaescala en 2022, demostrando capacidades para simular escenarios de IA en física cuántica y biología computacional. Riesgos asociados abarcan la dependencia de cadenas de suministro para silicio, mitigados por diversificación en fabricación con TSMC, y beneficios como la aceleración de descubrimientos científicos, como en el diseño de fármacos mediante AlphaFold.

Desafíos Técnicos en el Entrenamiento y Despliegue de Modelos de IA

El entrenamiento de modelos de IA enfrenta desafíos inherentes a la complejidad computacional. Canovas señala que el volumen de datos crece exponencialmente, con datasets como Common Crawl superando los petabytes, demandando almacenamiento distribuido y algoritmos de compresión eficientes. Técnicamente, técnicas como el aprendizaje federado permiten entrenar modelos sin centralizar datos, preservando privacidad mediante agregación de gradientes en lugar de intercambio de datos crudos.

En hardware, la latencia de memoria y el cuello de botella en interconexiones como NVLink o Infinity Fabric de AMD son críticos. Soluciones involucran topologías de malla (mesh) para clústeres de GPUs, reduciendo tiempos de comunicación de milisegundos a microsegundos. Además, la cuantización de modelos —reduciendo precisión de 32 bits a 8 bits— optimiza inferencia en dispositivos edge, como en vehículos autónomos, donde AMD’s Versal AI Edge soporta hasta 100 TOPS (Tera Operations Per Second) con bajo consumo.

Aspectos regulatorios incluyen la auditoría de sesgos en datasets, donde herramientas como AIF360 de IBM, compatibles con ROCm, evalúan fairness mediante métricas como disparate impact. Riesgos éticos abarcan el misuse de IA generativa, como deepfakes, contrarrestados por watermarking digital y detección adversarial. Beneficios operativos radican en la automatización predictiva, por ejemplo, en ciberseguridad, donde modelos de AMD detectan anomalías en redes con precisión superior al 95%.

Canovas advierte sobre la “fatiga de IA”, donde expectativas infladas generan decepciones; en realidad, el progreso es iterativo, similar a la evolución de Moore’s Law hacia arquitecturas especializadas. AMD invierte en investigación para neuromórficos, chips que emulan sinapsis cerebrales para eficiencia ultra-baja, potencialmente revolucionando IoT.

Integración de Hardware y Software en Plataformas de IA

La sinergia entre hardware y software es fundamental para el rendimiento de IA. En AMD, el framework Vitis AI unifica desarrollo, permitiendo mapeo de modelos ONNX a aceleradores FPGA. Esto facilita despliegues híbridos, combinando CPUs para control lógico y GPUs para paralelismo, como en simulaciones de clima con modelos GNN (Graph Neural Networks).

Técnicamente, el pipeline de entrenamiento involucra preprocesamiento con Apache Spark, entrenamiento distribuido via Horovod y optimización con técnicas como mixed-precision training, que AMD soporta nativamente en sus GPUs. Canovas menciona que la interoperabilidad con estándares como OpenAI Gym asegura portabilidad, crucial para benchmarks como MLPerf, donde AMD ha logrado puntuaciones líderes en inferencia.

En edge computing, desafíos incluyen latencia real-time; soluciones como TinyML en microcontroladores Ryzen Embedded permiten inferencia local, reduciendo dependencia de cloud y mejorando privacidad. Implicaciones regulatorias involucran compliance con ISO/IEC 42001 para gestión de IA, que AMD incorpora en sus certificaciones.

Beneficios incluyen costos reducidos: un clúster AMD puede entrenar un modelo BERT en horas versus días en hardware legacy, con ROI en meses para empresas. Riesgos como sobrecalentamiento se mitigan con refrigeración líquida y monitoring via IPMI.

Implicaciones Operativas y Futuras en Ciberseguridad e IA

La intersección de IA y ciberseguridad es un área crítica. Canovas alude a la necesidad de IA defensiva contra amenazas avanzadas, como ataques adversariales que perturban entradas para engañar modelos. AMD’s Secure Processor mitiga esto mediante enclaves confiables (TEE), similares a SGX, protegiendo datos durante inferencia.

Técnicamente, zero-trust architectures integran IA para verificación continua, usando modelos de anomaly detection basados en autoencoders. En blockchain, AMD acelera minería y validación con GPUs, aunque enfocado en IA para smart contracts predictivos.

Regulatoriamente, la NIST Cybersecurity Framework incorpora guías para IA segura, que AMD sigue en sus productos. Beneficios: detección proactiva de ransomware con tasas de falsos positivos por debajo del 1%. Riesgos: weaponización de IA en ciberataques, contrarrestada por colaboraciones con agencias como CISA.

Futuramente, Canovas vislumbra IA multimodal, integrando visión, texto y audio, demandando hardware versátil como MI300. Esto impulsará aplicaciones en AR/VR, con AMD’s RDNA architecture optimizando rendering en tiempo real.

Colaboraciones y Ecosistemas Abiertos en el Desarrollo de IA

AMD fomenta ecosistemas abiertos mediante el consorcio UXL, uniendo a Intel, Qualcomm y otros para estándares unificados en IA. Canovas destaca partnerships con Meta y Google, integrando ROCm en Llama y TensorFlow, acelerando adopción.

Técnicamente, esto implica APIs estandarizadas como ONNX Runtime, permitiendo migración seamless. Implicaciones: reducción de vendor lock-in, fomentando innovación en startups. En Latinoamérica, colaboraciones con universidades como la UNAM promueven talento local en IA aplicada.

Riesgos incluyen fragmentación de estándares, mitigados por adopción de SYCL para programación portable. Beneficios: escalabilidad global, con AMD suministrando a hyperscalers como AWS.

Conclusión: Hacia un Futuro Sostenible en IA

En resumen, la visión de Nicolás Canovas ilustra que el avance de la IA demanda paciencia y estrategia integral. AMD, con su enfoque en hardware eficiente y software accesible, posiciona a la industria para superar desafíos técnicos y éticos. La integración de estas tecnologías no solo optimizará operaciones, sino que catalizará innovaciones transformadoras en ciberseguridad, blockchain y más allá. Finalmente, el compromiso con la sostenibilidad asegurará que este Ironman culmine en beneficios duraderos para la sociedad.

Para más información, visita la fuente original.