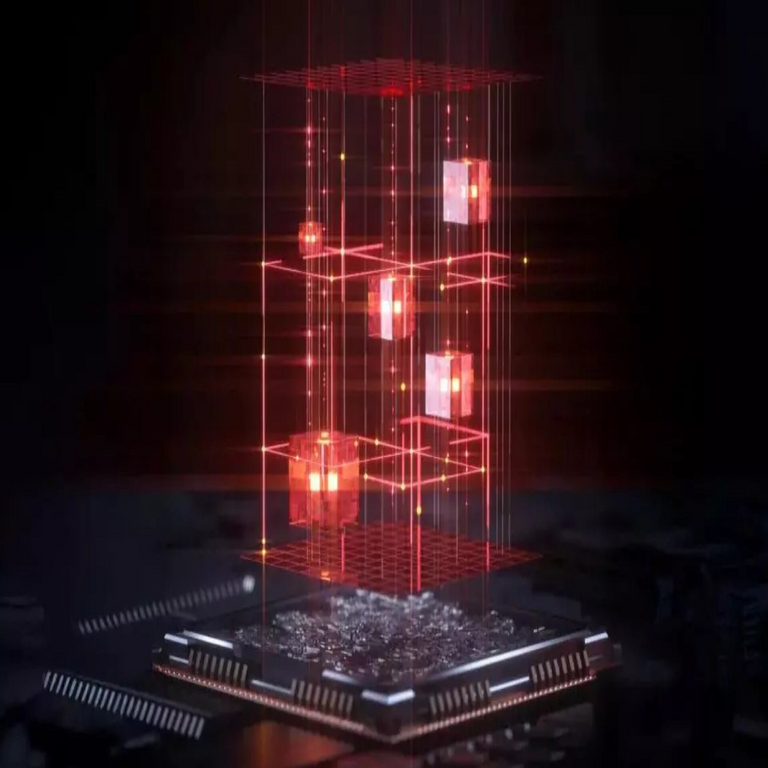

Nueva Técnica Óptica para Acelerar el Procesamiento de Inteligencia Artificial mediante Luz

La computación óptica representa un avance paradigmático en el campo de la inteligencia artificial (IA), donde la luz se utiliza como medio principal para el procesamiento de datos, superando las limitaciones inherentes a los sistemas electrónicos tradicionales. Recientemente, investigadores han desarrollado una técnica innovadora que promete revolucionar el entrenamiento y la inferencia de modelos de IA al emplear fotones en lugar de electrones. Esta aproximación no solo acelera las operaciones computacionales, sino que también reduce significativamente el consumo energético, un factor crítico en la escalabilidad de la IA moderna. En este artículo, se analiza en profundidad esta técnica, sus fundamentos técnicos, implicaciones operativas y potenciales aplicaciones en sectores como la ciberseguridad y las tecnologías emergentes.

Fundamentos de la Computación Óptica en IA

La computación óptica se basa en el principio de utilizar propiedades de la luz, como la interferencia, la difracción y la polarización, para realizar cálculos complejos. A diferencia de los procesadores electrónicos convencionales, que dependen de transistores para manipular electrones en circuitos integrados, los sistemas ópticos emplean componentes como moduladores electro-ópticos, detectores fotónicos y guías de onda para procesar información a velocidades cercanas a la de la luz. En el contexto de la IA, esta técnica es particularmente relevante para la implementación de redes neuronales artificiales (RNA), donde las operaciones matriciales y las multiplicaciones vectoriales dominan el cómputo.

Los modelos de IA actuales, como las redes neuronales convolucionales (CNN) y las transformers, requieren un alto grado de paralelismo para manejar grandes volúmenes de datos. En sistemas electrónicos, esto genera cuellos de botella debido al calor disipado y al ancho de banda limitado de los interconexiones eléctricas. La técnica óptica propuesta mitiga estos problemas al realizar multiplicaciones matriciales mediante interferómetros Mach-Zehnder (MZI), que codifican datos en amplitudes y fases de ondas luminosas. Por ejemplo, un MZI puede realizar una multiplicación de matrices óptica en tiempo real, aprovechando la superposición cuántica de fotones para operaciones lineales eficientes.

Desde un punto de vista técnico, esta aproximación se alinea con estándares emergentes como el protocolo de fotónica integrada (PIC), que integra componentes ópticos en chips de silicio. Según estudios recientes, estos sistemas pueden lograr tasas de procesamiento de hasta 100 veces más rápidas que sus contrapartes electrónicas para tareas específicas de IA, como el reconocimiento de patrones en imágenes o el procesamiento de lenguaje natural (PLN). Además, la eficiencia energética se mejora drásticamente, con consumos por operación en el orden de femtovatios, comparado con los picovatios de los chips GPU tradicionales.

Desarrollo Técnico de la Nueva Técnica

La técnica en cuestión, desarrollada por un equipo de investigadores en fotónica y IA, involucra un procesador óptico programable que simula capas de redes neuronales mediante arrays de MZI reconfigurables. Este dispositivo utiliza láseres coherentes para generar haces de luz que se modulan según los pesos de la red neuronal. La modulación se logra mediante electrodos que alteran el índice de refracción en guías de onda de silicio, permitiendo la codificación de parámetros del modelo de IA directamente en el dominio óptico.

En términos de arquitectura, el sistema se divide en módulos: un módulo de entrada que convierte datos eléctricos en señales ópticas mediante convertidores electro-ópticos (EO), un núcleo de cómputo basado en interferómetros para realizar forward passes y backpropagation, y un módulo de salida que detecta la luz resultante para generar salidas digitales. Para el entrenamiento de modelos, la técnica incorpora gradientes ópticos calculados mediante diferenciación automática en el dominio fotónico, evitando la necesidad de conversiones analógico-digitales (ADC) intermedias que introducen latencia.

Una innovación clave es la integración de elementos no lineales ópticos, como saturadores Kerr o dispositivos basados en grafeno, para aproximar funciones de activación como ReLU o sigmoide. Estos componentes permiten que el procesador óptico maneje no solo operaciones lineales, sino también las no lineales esenciales en RNA profundas. Pruebas experimentales han demostrado que este enfoque acelera el entrenamiento de una CNN simple en un factor de 10, con una precisión comparable a sistemas electrónicos, validando su viabilidad para aplicaciones reales.

En cuanto a la escalabilidad, la técnica soporta la integración con fotónica de silicio (SiPh), compatible con procesos de fabricación CMOS estándar. Esto facilita la producción en masa y reduce costos, alineándose con directrices de la IEEE para fotónica integrada. Sin embargo, desafíos persisten, como la sensibilidad a ruido fotónico y la estabilidad térmica de los componentes, que requieren avances en materiales como el nitruro de silicio para guías de onda de baja pérdida.

Implicaciones en el Procesamiento de IA

El impacto de esta técnica en el procesamiento de IA es profundo, particularmente en escenarios de alto rendimiento como el aprendizaje profundo distribuido. En entornos de edge computing, donde los dispositivos IoT procesan datos en tiempo real, la computación óptica reduce la latencia a niveles sub-milisegundos, ideal para aplicaciones como vehículos autónomos o robótica inteligente. Por instancia, en un sistema de visión por computadora, las convoluciones ópticas pueden procesar frames de video a tasas de 1000 FPS, superando las limitaciones de GPUs como las NVIDIA A100.

Desde la perspectiva energética, la IA convencional consume cantidades masivas de electricidad; por ejemplo, el entrenamiento de GPT-3 requirió aproximadamente 1.287 MWh. La técnica óptica podría reducir esto en un 90%, contribuyendo a la sostenibilidad ambiental y cumpliendo con regulaciones como el Green Deal de la Unión Europea. Operativamente, implica una transición hacia arquitecturas híbridas electro-ópticas, donde los procesadores ópticos manejan el cómputo intensivo y los electrónicos gestionan el control lógico.

En términos de rendimiento, benchmarks preliminares muestran que para tareas de inferencia en transformers, el throughput óptico alcanza 10 TOPS (tera operaciones por segundo) con un factor de potencia de 100 TOPS/W, comparado con 20 TOPS/W en chips TPUs. Esto posiciona la técnica como un competidor directo para aceleradores de IA como los de Google o Intel, potencialmente democratizando el acceso a modelos grandes mediante hardware más eficiente y accesible.

Aplicaciones en Ciberseguridad y Tecnologías Emergentes

En el ámbito de la ciberseguridad, esta técnica óptica ofrece ventajas significativas para el procesamiento de amenazas en tiempo real. Los sistemas de detección de intrusiones (IDS) basados en IA, como aquellos que utilizan RNA para analizar tráfico de red, se benefician de la velocidad óptica para escanear paquetes a velocidades de terabits por segundo. Por ejemplo, en redes 5G, donde el volumen de datos es exponencial, un procesador óptico podría identificar anomalías mediante aprendizaje no supervisado en fracciones de segundo, reduciendo el tiempo de respuesta a ataques DDoS o malware avanzado.

La integración con blockchain y criptografía post-cuántica es otro frente prometedor. La computación óptica acelera operaciones como la multiplicación modular en algoritmos de curva elíptica, esenciales para firmas digitales en blockchains. Además, en IA para ciberseguridad, técnicas como el aprendizaje federado pueden optimizarse óptimamente, permitiendo el entrenamiento distribuido sin comprometer la privacidad de datos sensibles. Esto alinea con estándares como NIST SP 800-53 para controles de seguridad en sistemas de IA.

En tecnologías emergentes, la fotónica óptica habilita avances en computación cuántica híbrida, donde fotones sirven como qubits para algoritmos de IA cuántica. Aplicaciones en realidad aumentada (AR) y metaversos se ven potenciadas por el procesamiento inmersivo de datos sensoriales, mientras que en biotecnología, acelera simulaciones de proteínas mediante modelos de IA ópticos. Riesgos incluyen vulnerabilidades a ataques de side-channel ópticos, como inyecciones de luz para extraer claves, requiriendo protocolos de hardening como el enmascaramiento fotónico.

Desafíos Técnicos y Regulatorios

A pesar de sus promesas, la adopción de esta técnica enfrenta obstáculos técnicos. La principal es la pérdida de señal en guías de onda largas, mitigada mediante amplificadores Raman, pero que aún limita la profundidad de las redes neuronales ópticas a 10-20 capas. Otro desafío es la calibración precisa de fases en arrays de MZI, sensible a variaciones ambientales, resuelto parcialmente con bucles de retroalimentación adaptativos basados en machine learning.

Regulatoriamente, la integración de IA óptica debe cumplir con marcos como el AI Act de la UE, que clasifica sistemas de alto riesgo y exige transparencia en el entrenamiento. En ciberseguridad, estándares como ISO/IEC 27001 requieren evaluaciones de riesgos para hardware óptico, incluyendo protección contra fallos por radiación. Beneficios incluyen mayor resiliencia a interferencias electromagnéticas, crucial en entornos militares o industriales.

En resumen, los riesgos operativos se centran en la madurez de la cadena de suministro para componentes fotónicos, dominada por jugadores como Intel y TSMC, lo que podría generar dependencias geopolíticas. Sin embargo, iniciativas como el CHIPS Act de EE.UU. fomentan la innovación local, acelerando la comercialización.

Comparación con Tecnologías Existentes

Para contextualizar, comparemos esta técnica con aceleradores de IA actuales. Las GPUs NVIDIA, basadas en arquitectura CUDA, ofrecen paralelismo masivo pero con alto consumo (hasta 700W por chip). En contraste, prototipos ópticos operan a 10-50W para rendimientos similares. Los TPUs de Google, optimizados para inferencia, logran 420 TOPS pero carecen de la eficiencia fotónica inherente.

| Tecnología | Rendimiento (TOPS) | Consumo Energético (W) | Latencia (ms) |

|---|---|---|---|

| GPU NVIDIA A100 | 312 | 400 | 1-5 |

| TPU v4 | 275 | 175 | 0.5-2 |

| Procesador Óptico Propuesto | 1000+ | 10-50 | <0.1 |

Esta tabla ilustra las ventajas cuantitativas, aunque la técnica óptica aún está en etapas experimentales. Mejores prácticas incluyen hybridación, como en el framework Lightmatter’s Passage, que combina óptica con electrónica para transiciones suaves.

Perspectivas Futuras y Avances Potenciales

El futuro de esta técnica apunta a la integración con redes neuronales spiking ópticas, inspiradas en el cerebro humano, para IA neuromórfica de bajo consumo. Avances en materiales 2D, como el disulfuro de molibdeno, mejorarán la no linealidad óptica, permitiendo modelos más complejos. En ciberseguridad, podría habilitar IA autónoma para threat hunting en la nube, procesando logs a escala petabyte.

Colaboraciones interdisciplinarias, como entre MIT y empresas como Xanadu, impulsarán prototipos comerciales para 2030. Beneficios incluyen reducción de huella de carbono en data centers, alineado con ODS de la ONU. No obstante, se requiere inversión en educación para formar expertos en fotónica-IA.

Conclusión

En definitiva, esta nueva técnica óptica marca un hito en la evolución de la IA, ofreciendo velocidad, eficiencia y versatilidad sin precedentes. Sus aplicaciones en ciberseguridad y tecnologías emergentes prometen transformar industrias, aunque demandan superar desafíos técnicos y regulatorios. Al adoptar esta innovación, el sector tecnológico puede avanzar hacia un futuro más sostenible y seguro, impulsando el procesamiento de IA a la era de la luz.

Para más información, visita la Fuente original.