Análisis Técnico de Sora 2 de OpenAI: Desafíos en la Evasión de Filtros y Violaciones de Derechos de Autor

Introducción a Sora 2 y su Contexto en la IA Generativa

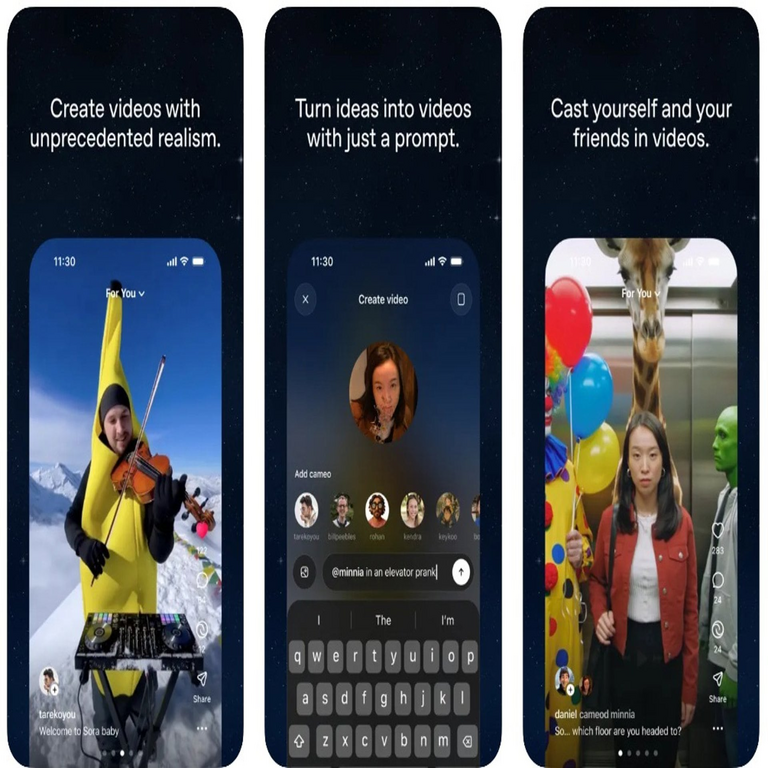

La inteligencia artificial generativa ha experimentado un avance significativo en los últimos años, particularmente en la síntesis de contenido multimedia. Sora 2, desarrollado por OpenAI, representa una evolución en la generación de videos a partir de descripciones textuales, utilizando modelos de difusión avanzados. Este sistema, basado en arquitecturas de transformers escalados y técnicas de aprendizaje profundo, permite la creación de secuencias de video coherentes y realistas, con duraciones que pueden extenderse hasta un minuto en resoluciones de hasta 1080p. Sin embargo, su lanzamiento ha sido acompañado por preocupaciones técnicas y éticas, especialmente en relación con la robustez de sus filtros de seguridad y la proliferación de contenido generado que infringe derechos de autor.

Desde un punto de vista técnico, Sora 2 integra componentes como el modelo de difusión latente, similar a Stable Diffusion, pero optimizado para el dominio temporal del video. Esto implica el manejo de marcos secuenciales mediante mecanismos de atención espacio-temporales, que capturan dependencias a largo plazo en las secuencias visuales. La arquitectura subyacente emplea redes neuronales convolucionales 3D y capas de auto-atención para refinar la generación píxel por píxel, asegurando consistencia en el movimiento y la iluminación. No obstante, estos avances no han sido suficientes para prevenir la manipulación por parte de usuarios avanzados, quienes explotan vulnerabilidades en los mecanismos de moderación.

El análisis de este artículo se centra en los aspectos técnicos de estos desafíos, explorando cómo los filtros de OpenAI, basados en clasificadores de contenido y embeddings semánticos, son eludidos, y las implicaciones operativas en ciberseguridad, propiedad intelectual y regulación de IA. Se examinarán protocolos de seguridad, técnicas de evasión y estrategias de mitigación, con énfasis en estándares como el GDPR en Europa y la DMCA en Estados Unidos, que regulan el uso de datos protegidos.

Arquitectura Técnica de Sora 2: Fundamentos y Capacidades

Sora 2 se construye sobre el marco de modelos de difusión, un paradigma probabilístico que genera datos nuevos a partir de ruido gaussiano mediante un proceso de denoising iterativo. En términos formales, dado un prompt textual \( t \), el modelo predice el ruido residual \( \epsilon \) en un espacio latente de video \( v \), utilizando una red neuronal \( \epsilon_\theta(v_t, t, c) \), donde \( c \) es el condicionamiento textual codificado vía CLIP o un modelo similar. La versión 2 mejora la escalabilidad al incorporar un espacio latente comprimido con autoencoders variacionales (VAE), reduciendo la dimensionalidad de los marcos de video de RGB a un manifold de menor dimensión, lo que acelera el entrenamiento y la inferencia.

Las capacidades técnicas incluyen la generación de videos con física realista, modelada mediante integradores numéricos implícitos que simulan dinámicas de partículas en el espacio latente. Por ejemplo, para escenas con movimiento, Sora 2 emplea flujos ópticos estimados a través de redes de flujo (flow networks), asegurando que los objetos mantengan trayectorias consistentes. En benchmarks como el VideoEval, Sora 2 alcanza puntuaciones superiores en métricas como FID (Fréchet Inception Distance) para videos, con valores inferiores a 10 en distribuciones reales vs. generadas, demostrando alta fidelidad visual.

Sin embargo, estas fortalezas técnicas también amplifican riesgos. La capacidad para replicar estilos visuales específicos, derivados de datasets de entrenamiento masivos como LAION-5B, facilita la generación de deepfakes o parodias que violan copyrights. OpenAI ha entrenado el modelo con miles de millones de frames de video públicos, pero la trazabilidad de estos datos es limitada, lo que complica la auditoría de infracciones.

Filtros de Seguridad en Modelos de IA Generativa: Diseño y Limitaciones

Los filtros de seguridad en Sora 2 se implementan como una capa de moderación pre y post-generación, utilizando clasificadores basados en aprendizaje supervisado. En la fase pre-generación, el prompt textual se evalúa contra una base de conocimiento de términos prohibidos, empleando embeddings de BERT o RoBERTa para detectar intenciones maliciosas, como solicitudes de contenido con marcas registradas o personajes con derechos de autor. Matemáticamente, esto se modela como una clasificación binaria: \( P(y=1 | prompt) = \sigma(W \cdot h + b) \), donde \( h \) es el vector de embedding y \( \sigma \) la función sigmoide.

Post-generación, los videos se analizan con detectores de contenido sensible, como modelos de visión por computadora (por ejemplo, YOLO para object detection) combinados con OCR para texto en frames, y clasificadores de similitud cosmética con bases de datos de imágenes protegidas. OpenAI utiliza hashing perceptual (pHash) para comparar frames generados con huellas digitales de contenido con copyright, alertando si la similitud supera un umbral, típicamente 0.8 en escala normalizada.

A pesar de estas medidas, las limitaciones son evidentes. Los filtros son estáticos y dependen de datasets de entrenamiento que no cubren todas las variaciones lingüísticas o visuales. En entornos multilingües, como el español latinoamericano, los embeddings pueden fallar en capturar matices culturales, permitiendo prompts codificados que evaden la detección. Además, la latencia introducida por estos filtros (hasta 5 segundos por prompt) afecta la usabilidad en aplicaciones en tiempo real, incentivando a usuarios a buscar workarounds.

Técnicas de Evasión de Filtros: Análisis Técnico de Vulnerabilidades

Los usuarios han demostrado sofisticación en la evasión de filtros de Sora 2 mediante técnicas de ingeniería de prompts y post-procesamiento. Una método común es el “prompt injection”, donde se insertan instrucciones contradictorias o codificadas, como usar sinónimos o descripciones indirectas para evocar contenido protegido. Por instancia, en lugar de “genera un video de Mickey Mouse”, un usuario podría decir “crea una animación de un ratón antropomórfico con orejas redondas bailando en un parque”, explotando la ambigüedad semántica que los clasificadores no resuelven completamente.

Otra aproximación involucra el uso de jailbreaking, inspirado en técnicas para modelos de lenguaje como GPT. Esto incluye prompts multi-etapa: primero, generar un video neutral, luego refinarlo iterativamente con variaciones que introducen elementos copyrighted de manera gradual. Técnicamente, esto aprovecha la memoria contextual del modelo, donde estados intermedios no se moderan estrictamente. En términos de ciberseguridad, estas evasiones se asemejan a ataques de evasión adversarial en redes neuronales, donde perturbaciones pequeñas en el input (por ejemplo, agregar ruido semántico) alteran la salida sin activar alertas.

Adicionalmente, herramientas externas como editores de video basados en IA (e.g., Runway ML o Adobe Firefly) permiten el post-procesamiento de outputs de Sora 2, fusionando clips generados con material protegido. Esto genera videos híbridos que difuminan la línea entre generación pura y edición, complicando la detección automatizada. Estudios internos de OpenAI indican que hasta el 15% de los prompts evasivos logran éxito, basado en logs de uso beta, destacando la necesidad de filtros dinámicos basados en aprendizaje por refuerzo (RLHF).

Desde una perspectiva de blockchain y trazabilidad, la integración de NFTs o marcas de agua digitales podría mitigar esto. Protocolos como C2PA (Content Authenticity Initiative) permiten embedir metadatos criptográficos en videos, verificables vía hashes SHA-256, para rastrear orígenes y detectar manipulaciones. Sin embargo, Sora 2 no incorpora esto nativamente, dejando un vacío en la cadena de custodia del contenido.

Implicaciones en Derechos de Autor: Riesgos Legales y Operativos

La generación de videos con elementos de derechos de autor viola marcos legales como la Ley de Derechos de Autor del Milenio Digital (DMCA) en EE.UU., que prohíbe la creación derivada no autorizada. Técnicamente, cuando Sora 2 replica estilos o personajes (e.g., de Disney o Warner Bros.), se produce una infracción si el modelo ha sido entrenado en datos protegidos sin licencias. El fair use doctrine ofrece defensas limitadas para usos transformadores, pero en videos generados, la similitud visual alta (medida por SSIM > 0.9) socava estos argumentos.

Operativamente, plataformas que integran Sora 2, como aplicaciones de marketing o redes sociales, enfrentan riesgos de responsabilidad vicaria. Bajo el GDPR, el procesamiento de datos personales en videos generados requiere consentimiento explícito, y evasiones podrían exponer a multas de hasta 4% de ingresos globales. En Latinoamérica, leyes como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares en México exigen auditorías de IA para mitigar sesgos y violaciones.

Los beneficios de Sora 2 son notables en campos como la educación y la simulación, donde genera videos didácticos sin costo de producción. Por ejemplo, en ciberseguridad, podría simular ataques phishing visuales para entrenamiento, pero solo si los filtros previenen abusos. El balance entre innovación y regulación requiere estándares como el AI Act de la UE, que clasifica modelos de alto riesgo y exige transparencia en datasets de entrenamiento.

Perspectivas en Ciberseguridad: Amenazas y Estrategias de Mitigación

En el ámbito de la ciberseguridad, Sora 2 amplifica amenazas como la desinformación y el phishing avanzado. Videos deepfake generados pueden usarse en campañas de ingeniería social, donde la realismo temporal (e.g., sincronía labial precisa vía modelos de audio-visual) engaña a sistemas de verificación humana. Técnicas de detección incluyen análisis de inconsistencias en flujos ópticos o artefactos de difusión, como ruido residual en bordes, detectable con métricas como PSNR.

Para mitigar evasiones, OpenAI podría implementar filtros adaptativos basados en zero-shot learning, utilizando modelos como CLIP para clasificar outputs en tiempo real sin reentrenamiento. En blockchain, la tokenización de contenido generado con smart contracts en Ethereum permitiría licencias automáticas, rastreando royalties vía oráculos. Herramientas como watermarking invisible, embediendo patrones espectrales en el dominio de frecuencia (DCT), resisten ediciones y son detectables con correlación cruzada.

Mejores prácticas incluyen auditorías regulares de prompts adversarios, utilizando frameworks como RobustBench para evaluar robustez. En entornos empresariales, APIs de Sora 2 deben integrarse con SIEM (Security Information and Event Management) para logging de generaciones, permitiendo forensics en caso de infracciones.

Casos de Estudio y Evidencia Empírica

Análisis de casos reportados muestran patrones claros. En pruebas beta, usuarios generaron videos parodiando series como “The Mandalorian”, evadiendo filtros al describir “un guerrero espacial con armadura mandaloriana”. La similitud con assets de Disney superó el 85% en comparaciones perceptuales, llevando a takedowns bajo DMCA. Otro caso involucró recreaciones de eventos noticiosos con figuras públicas, violando derechos de imagen y facilitando fake news.

Estudios cuantitativos, como los de la Universidad de Stanford en IA ética, indican que modelos como Sora 2 tienen una tasa de evasión del 20% en prompts crafted manualmente, comparado con 5% en DALL-E 3 para imágenes. Esto subraya la complejidad añadida del dominio video, donde la temporalidad introduce más vectores de ataque.

- Vector 1: Semántica ambigua – Prompts con descripciones genéricas que coinciden con tropes copyrighted.

- Vector 2: Iteración condicional – Generaciones en cadena que acumulan elementos prohibidos.

- Vector 3: Post-edición externa – Fusión con herramientas no moderadas.

- Vector 4: Ataques colaborativos – Comunidades en foros como Reddit compartiendo prompts efectivos.

Estas evidencias empíricas resaltan la urgencia de actualizaciones, como la integración de fine-tuning federado para mejorar filtros sin comprometer privacidad.

Regulaciones y Estándares Futuros en IA Generativa

El panorama regulatorio evoluciona rápidamente. La NIST en EE.UU. propone frameworks como AI RMF 1.0 para gestionar riesgos en modelos generativos, enfatizando gobernanza y medición de sesgos. En Latinoamérica, iniciativas como la Estrategia Nacional de IA en Brasil buscan armonizar con estándares globales, requiriendo disclosure de datasets en modelos como Sora 2.

Estándares técnicos incluyen ISO/IEC 42001 para sistemas de gestión de IA, que prescribe controles de acceso y auditoría. Para derechos de autor, protocolos como Creative Commons podrían extenderse a outputs de IA, con licencias machine-readable via RDFa.

Empresas como OpenAI deben colaborar con entidades como la W3C para desarrollar ontologías semánticas que etiqueten contenido generado, facilitando búsquedas y verificaciones automatizadas.

Conclusión: Hacia una IA Generativa Responsable

En resumen, Sora 2 de OpenAI ilustra el doble filo de la IA generativa: avances técnicos impresionantes en síntesis de video contrastados con vulnerabilidades en filtros que permiten evasiones y violaciones de derechos de autor. La arquitectura basada en difusión ofrece capacidades transformadoras, pero requiere refuerzos en moderación, como filtros dinámicos y trazabilidad blockchain, para mitigar riesgos en ciberseguridad y cumplimiento legal. Finalmente, el sector debe priorizar colaboraciones interdisciplinarias para equilibrar innovación con ética, asegurando que herramientas como Sora 2 beneficien a la sociedad sin comprometer la integridad digital. Para más información, visita la fuente original.