La Burbuja de la Inteligencia Artificial: Nvidia y OpenAI Ante la Posibilidad de Colapso y el Rol del Apoyo Estatal

La inteligencia artificial (IA) ha experimentado un crecimiento exponencial en los últimos años, impulsado por avances en hardware especializado y modelos de aprendizaje profundo. Sin embargo, este auge ha generado preocupaciones sobre la sostenibilidad económica del sector, con paralelismos evidentes a burbujas especulativas pasadas, como la de las puntocom en los años 90. Empresas líderes como Nvidia y OpenAI han reconocido públicamente los riesgos inherentes a esta expansión acelerada, proponiendo que el Estado asuma un rol pivotal en la mitigación de un potencial estallido. Este artículo analiza los fundamentos técnicos de la IA actual, los desafíos económicos asociados y las implicaciones de una intervención gubernamental, basándose en análisis de mercado y declaraciones de estos actores clave.

Antecedentes Técnicos de la Expansión en IA

La inteligencia artificial, particularmente en su rama de aprendizaje automático (machine learning), depende de grandes volúmenes de datos y poder computacional para entrenar modelos complejos. Los modelos de lenguaje grande (LLM, por sus siglas en inglés), como los desarrollados por OpenAI, requieren infraestructuras masivas para su procesamiento. Técnicamente, el entrenamiento de un LLM implica algoritmos de retropropagación y optimización estocástica del gradiente, que procesan terabytes de datos textuales para ajustar parámetros en redes neuronales con miles de millones de nodos. Este proceso no solo consume recursos energéticos equivalentes al de pequeñas naciones, sino que también demanda hardware especializado.

Nvidia, como proveedor dominante de unidades de procesamiento gráfico (GPU), ha capitalizado esta demanda. Sus chips, como la serie H100 basada en la arquitectura Hopper, están diseñados para operaciones de punto flotante de precisión mixta (FP8 y FP16), esenciales para acelerar cálculos en redes neuronales convolucionales (CNN) y transformadores. La arquitectura de transformadores, introducida en el paper “Attention is All You Need” de 2017, ha sido el pilar de modelos como GPT-4 de OpenAI, permitiendo el manejo de dependencias a largo plazo en secuencias de datos mediante mecanismos de atención auto-atentiva. Sin embargo, el costo de estas GPU ha escalado drásticamente: un solo clúster de entrenamiento para un modelo de vanguardia puede superar los cientos de millones de dólares, lo que genera una dependencia económica en inversiones de capital de riesgo y mercados bursátiles volátiles.

La burbuja potencial en IA se evidencia en las valoraciones de mercado. Nvidia, por ejemplo, vio su capitalización bursátil multiplicarse por más de 10 en los últimos dos años, alcanzando picos cercanos a los 3 billones de dólares. Esta valoración se basa en proyecciones de demanda futura para centros de datos de IA, pero ignora riesgos como la saturación del mercado o avances en eficiencia algorítmica que podrían reducir la necesidad de hardware. OpenAI, por su parte, opera bajo un modelo de suscripción y API que genera ingresos recurrentes, pero sus costos operativos, incluyendo el mantenimiento de servidores y la generación de contenido, superan los 7 mil millones de dólares anuales, según estimaciones recientes.

Reconocimiento de Riesgos por Parte de Nvidia y OpenAI

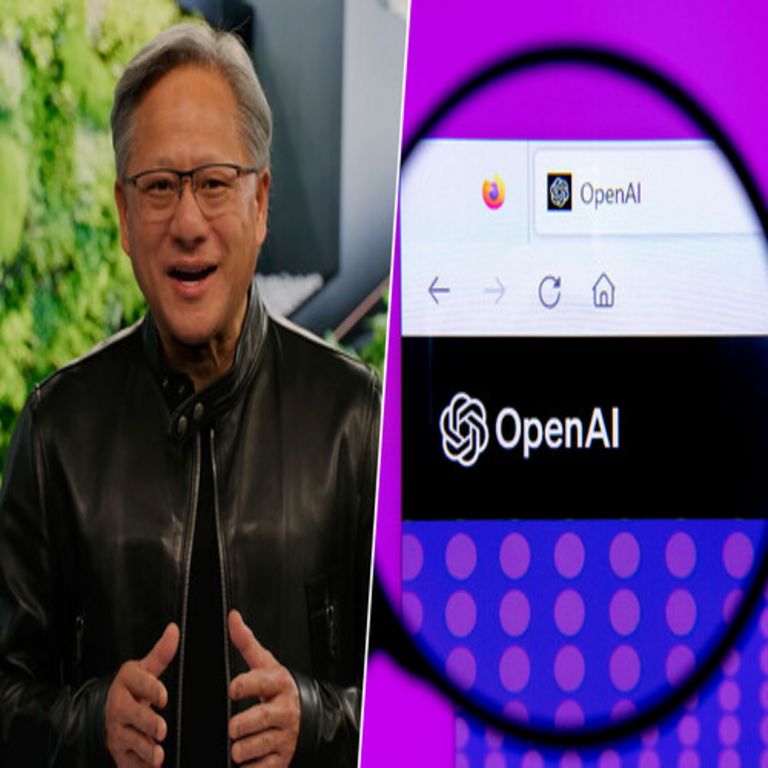

Executivos de Nvidia han expresado abiertamente la conciencia de una posible burbuja. Jensen Huang, CEO de la compañía, ha comparado el boom de la IA con el de internet en los 90, advirtiendo que no todas las aplicaciones de IA generarán retornos equivalentes a la inversión inicial. Técnicamente, esto se relaciona con la ley de rendimientos decrecientes en el escalado de modelos: aunque agregar más parámetros mejora el rendimiento hasta cierto punto, fenómenos como el sobreajuste (overfitting) y la ineficiencia en la inferencia limitan los beneficios marginales. Nvidia mitiga esto invirtiendo en software como CUDA, su plataforma de cómputo paralelo, que optimiza el uso de GPU para tareas de IA, permitiendo una mayor eficiencia en entornos como TensorRT para inferencia en tiempo real.

OpenAI, liderada por Sam Altman, ha ido más allá al abogar por una intervención estatal. Altman ha testificado ante el Congreso de Estados Unidos, destacando la necesidad de subsidios para infraestructuras de IA, argumentando que el sector privado no puede sostener el ritmo de innovación sin apoyo público. Desde una perspectiva técnica, OpenAI enfrenta desafíos en la escalabilidad de sus modelos: el entrenamiento de GPT-4 requirió aproximadamente 25,000 GPU A100 durante meses, consumiendo energía equivalente a 1,000 hogares promedio. La compañía propone que gobiernos financien supercomputadoras dedicadas a IA, similares al modelo de investigación financiada por el Departamento de Energía de EE.UU., para democratizar el acceso y evitar monopolios.

Estos reconocimientos no son aislados. La economía de la IA se asemeja a un modelo de red donde el valor aumenta con la adopción, pero colapsa si la confianza se erosiona. Indicadores como la volatilidad en acciones de empresas de semiconductores y la desaceleración en adopción empresarial de herramientas de IA (solo el 5% de compañías Fortune 500 usan IA generativa a escala, según encuestas de McKinsey) subrayan la fragilidad.

El Rol del Estado como Solución Propuesta

La propuesta de que “el papá Estado” pague implica un giro hacia políticas de subsidios y regulaciones que estabilicen el ecosistema de IA. En términos técnicos, esto podría traducirse en fondos para investigación en algoritmos de compresión de modelos, como la destilación de conocimiento o la cuantización post-entrenamiento, que reducen el tamaño de modelos sin perder precisión significativa. Por ejemplo, técnicas como la cuantización a 4 bits permiten desplegar LLMs en dispositivos edge con menor latencia, disminuyendo la dependencia de nubes centralizadas y sus costos asociados.

Precedentes existen en legislaciones como la CHIPS and Science Act de 2022 en EE.UU., que asigna 52 mil millones de dólares para manufactura de semiconductores, beneficiando directamente a Nvidia mediante incentivos fiscales para producción de chips en territorio nacional. OpenAI ha sugerido extensiones a esta ley para cubrir costos de energía en centros de datos, dado que el entrenamiento de IA genera emisiones de carbono equivalentes a las de la aviación global. En Europa, el AI Act de la Unión Europea busca equilibrar innovación con regulación, potencialmente financiando proyectos colaborativos entre empresas y universidades para mitigar riesgos éticos y económicos.

Desde una óptica operativa, el apoyo estatal podría involucrar estándares abiertos para IA, como los promovidos por el NIST en su marco de confianza en IA (AI RMF 1.0), que incluye directrices para gobernanza y medición de sesgos. Esto no solo reduce riesgos regulatorios para empresas como Nvidia, sino que fomenta interoperabilidad entre hardware y software, evitando lock-in propietario.

Implicaciones Económicas y Técnicas del Apoyo Gubernamental

Los beneficios de una intervención estatal son multifacéticos. Económicamente, subsidios podrían acelerar la transición a hardware de próxima generación, como las GPU Blackwell de Nvidia, que prometen un 4x de rendimiento en inferencia de IA mediante arquitecturas de memoria HBM3e y núcleos especializados en tensor floating point (TFP). Técnicamente, esto facilitaría avances en IA multimodal, integrando texto, imagen y video en modelos unificados, similar a cómo DALL-E de OpenAI combina generación de imágenes con procesamiento lingüístico.

Sin embargo, riesgos operativos persisten. Dependencia excesiva del Estado podría distorsionar mercados, fomentando ineficiencias como en el sector energético subsidiado. Además, implicaciones regulatorias incluyen mayor escrutinio en privacidad de datos: el entrenamiento de modelos IA procesa datasets masivos, potencialmente violando regulaciones como el GDPR en Europa, que exige anonimización y consentimiento. OpenAI ha enfrentado críticas por su uso de datos web scraped, lo que resalta la necesidad de marcos éticos financiados públicamente.

En blockchain y tecnologías emergentes, el apoyo estatal podría extenderse a integraciones híbridas, como usar IA para optimizar redes blockchain en validación de transacciones, reduciendo el consumo energético de proof-of-work. Nvidia ya explora esto con plataformas como Omniverse para simulaciones digitales, que podrían beneficiarse de fondos públicos para aplicaciones en ciberseguridad, detectando anomalías en redes mediante aprendizaje profundo.

Riesgos de la Burbuja y Estrategias de Mitigación

La burbuja de IA se caracteriza por sobrevaloración basada en hype más que en utilidades reales. Técnicamente, muchos despliegues de IA fallan en ROI debido a problemas de integración: por ejemplo, el 85% de proyectos de IA en empresas no superan la fase piloto, según Gartner, por desafíos en pipelines de datos y orquestación de modelos con herramientas como Kubernetes. Nvidia aborda esto con soluciones como DGX Cloud, que proporciona clústeres gestionados, pero el costo sigue siendo prohibitivo sin subsidios.

OpenAI propone diversificación: invertir en IA para el bien público, como en salud (diagnóstico asistido por modelos como Med-PaLM) o cambio climático (predicciones con redes neuronales recurrentes). Esto alinea con mejores prácticas del IEEE en ética de IA, enfatizando sostenibilidad. Regulaciones podrían incluir auditorías obligatorias de eficiencia energética, midiendo FLOPS por watt en hardware, para asegurar que subsidios promuevan innovación verde.

En ciberseguridad, la burbuja amplifica vulnerabilidades: modelos IA son susceptibles a ataques de envenenamiento de datos o adversariales, donde inputs perturbados alteran outputs. Apoyo estatal podría financiar defensas, como frameworks de verificación formal basados en lógica temporal, integrando IA con blockchain para trazabilidad inmutable de datasets.

Análisis Comparativo con Burbujas Históricas

La burbuja puntocom colapsó por exceso de infraestructura sin demanda; similarmente, la IA enfrenta sobreconstrucción de data centers. Nvidia reporta que la demanda de GPU supera la oferta en un 5:1, pero si la adopción se estanca, esto podría llevar a obsolescencia rápida. Técnicamente, ciclos de Moore para IA se acortan: cada 18 meses, el rendimiento duplica, pero costos no bajan proporcionalmente debido a escasez de materiales como silicio y cobalto.

OpenAI mitiga mediante partnerships, como con Microsoft, que invierte en Azure para hospedaje de modelos. Sin embargo, el rol estatal podría estandarizar benchmarks, como MLPerf, para medir rendimiento real y evitar inflaciones en claims de marketing. En Latinoamérica, donde el acceso a IA es limitado, subsidios podrían enfocarse en transferencia tecnológica, adaptando modelos a idiomas locales mediante fine-tuning con datasets regionales.

Perspectivas Futuras y Recomendaciones

El futuro de la IA depende de un equilibrio entre innovación privada y soporte público. Nvidia planea expandir a edge computing con chips Jetson, reduciendo latencia en aplicaciones IoT, mientras OpenAI explora AGI (inteligencia general artificial) con enfoques híbridos de reinforcement learning. Recomendaciones incluyen políticas de inversión en educación STEM para workforce calificada, y marcos regulatorios que incentiven open-source, como Hugging Face, para democratizar IA.

En resumen, aunque la burbuja de IA representa un riesgo significativo, el apoyo estatal propuesto por Nvidia y OpenAI ofrece un camino viable para sostenibilidad, fomentando avances técnicos responsables y equitativos.

Para más información, visita la fuente original.