La Traducción en Vivo de los AirPods Pro: Avances en Inteligencia Artificial para la Comunicación Global

Los AirPods Pro de Apple representan un hito en la integración de la inteligencia artificial (IA) en dispositivos wearables, especialmente con la reciente implementación de la función de traducción en vivo. Esta característica, que permite la traducción simultánea de conversaciones en tiempo real, ha llegado finalmente a España tras un retraso de varios meses en su despliegue global. Basada en modelos avanzados de procesamiento de lenguaje natural (PLN) y reconocimiento de voz, esta tecnología no solo mejora la accesibilidad lingüística, sino que también plantea nuevas consideraciones en términos de privacidad de datos y seguridad cibernética. En este artículo, exploramos los aspectos técnicos subyacentes, las implicaciones operativas y los desafíos asociados a esta innovación.

Fundamentos Técnicos de la Traducción en Vivo

La traducción en vivo en los AirPods Pro se apoya en un ecosistema de IA que combina hardware especializado con software de vanguardia. Los auriculares utilizan micrófonos de alta sensibilidad, capaces de capturar audio ambiental con una frecuencia de muestreo de hasta 48 kHz, lo que asegura una precisión en el reconocimiento de voz superior al 95% en entornos controlados. Este audio se procesa inicialmente mediante algoritmos de cancelación de ruido activo (ANC), basados en el chip H2 de Apple, que filtra interferencias y enfoca la señal en la voz del interlocutor.

Una vez capturado, el procesamiento de voz se realiza a través de modelos de machine learning (ML) locales y en la nube. En el dispositivo, se emplean redes neuronales convolucionales (CNN) para la extracción de características acústicas, seguidas de un modelo de reconocimiento automático de voz (ASR) optimizado para español y otros idiomas. Apple ha integrado componentes de su framework Core ML, que permite inferencias eficientes en el borde (edge computing), reduciendo la latencia a menos de 200 milisegundos. Para la traducción propiamente dicha, se utiliza un modelo de PLN basado en transformadores, similar a los utilizados en sistemas como Neural Machine Translation (NMT), que maneja contextos semánticos y sintácticos para traducciones fluidas.

La integración con el iPhone o iPad es clave: la app de Ajustes activa el modo de traducción, donde Siri actúa como intermediario. El flujo de datos implica la codificación del audio en formato AAC (Advanced Audio Coding) de baja latencia, su envío a servidores de Apple vía Wi-Fi o Bluetooth 5.3, y el retorno de la traducción sintetizada mediante text-to-speech (TTS). Este proceso respeta el estándar de encriptación end-to-end con AES-256, alineado con las directrices de la GDPR en Europa, aunque el retraso en España se atribuye a validaciones regulatorias locales para el procesamiento de datos personales en audio.

Integración con el Ecosistema Apple Intelligence

Apple Intelligence, el conjunto de capacidades de IA anunciadas en WWDC 2024, potencia esta función mediante modelos de lenguaje grandes (LLM) personalizados. A diferencia de modelos abiertos como GPT, los de Apple priorizan la privacidad mediante procesamiento on-device, utilizando técnicas de federated learning para entrenar modelos sin compartir datos crudos. En la traducción en vivo, un LLM híbrido evalúa el contexto conversacional, corrigiendo ambigüedades idiomáticas, como expresiones coloquiales en español latinoamericano versus peninsular.

Desde el punto de vista hardware, los AirPods Pro 2 incorporan un acelerador neuronal dedicado en el chip H2, con 16 núcleos para computación de IA, capaz de realizar hasta 15 billones de operaciones por segundo (TOPS). Esto permite traducciones offline para frases cortas, recurriendo a la nube solo para diálogos complejos. La conectividad Bluetooth LE Audio asegura un ancho de banda de hasta 2 Mbps, minimizando interrupciones en entornos móviles.

En términos de estándares, esta implementación sigue las recomendaciones del W3C para accesibilidad web y multimedia, incluyendo soporte para ARIA (Accessible Rich Internet Applications) en las interfaces de usuario. Además, se alinea con protocolos de audio como AV1 para compresión eficiente, reduciendo el consumo de datos en un 30% comparado con generaciones previas.

Implicaciones Operativas y Beneficios en Entornos Profesionales

Para profesionales en sectores como el turismo, la diplomacia o el comercio internacional, la traducción en vivo ofrece una ventaja operativa significativa. Imagínese un ejecutivo español negociando en una feria en Asia: los AirPods Pro traducen en tiempo real del mandarín al español, permitiendo respuestas inmediatas sin pausas disruptivas. Estudios internos de Apple indican una mejora en la eficiencia conversacional del 40%, basada en métricas de latencia y precisión semántica.

En el ámbito educativo, esta tecnología facilita el aprendizaje de idiomas en aulas multiculturales, integrándose con apps como Duolingo o Classroom de Apple. Los beneficios se extienden a la salud, donde médicos pueden comunicarse con pacientes no hispanohablantes, cumpliendo con estándares HIPAA equivalentes en Europa vía la Ley de Protección de Datos.

Sin embargo, las implicaciones operativas incluyen desafíos de escalabilidad. El procesamiento en la nube requiere una conexión estable, y en áreas con baja cobertura, la función offline se limita a idiomas preentrenados, como inglés, francés y español. Apple ha mitigado esto mediante actualizaciones over-the-air (OTA) que expanden el soporte lingüístico, con planes para incluir dialectos regionales en futuras versiones de iOS 18.

Riesgos de Ciberseguridad y Privacidad Asociados

Como experto en ciberseguridad, es imperativo analizar los riesgos inherentes a esta tecnología. La captura de audio en vivo genera datos sensibles que podrían ser vulnerables a ataques de intercepción. Aunque Apple emplea encriptación TLS 1.3 para transmisiones, un vector potencial es el spoofing de Bluetooth, donde un atacante cercano podría inyectar audio malicioso mediante herramientas como Ubertooth One. Recomendaciones incluyen activar el modo de emparejamiento seguro y monitorear conexiones vía la app Find My.

En cuanto a privacidad, el procesamiento on-device minimiza fugas, pero las consultas a la nube implican metadatos como timestamps y ubicaciones aproximadas, regulados por la ePrivacy Directive de la UE. Un riesgo emergente es el de “eavesdropping pasivo”, donde apps de terceros en el iPhone podrían acceder a buffers de audio si no se configuran permisos estrictos. Apple contrarresta esto con sandboxing en iOS, aislando el módulo de traducción.

Desde una perspectiva de blockchain y tecnologías emergentes, aunque no directamente integrada, la traducción en vivo podría evolucionar hacia sistemas descentralizados. Por ejemplo, integraciones futuras con Web3 podrían usar zero-knowledge proofs (ZKP) para verificar traducciones sin revelar el contenido original, mejorando la confianza en entornos distribuidos. Sin embargo, actualmente, el modelo centralizado de Apple prioriza la usabilidad sobre la descentralización.

Desafíos Técnicos y el Retraso en el Despliegue

El retraso de varios meses en la llegada de esta función a España se debe principalmente a pruebas exhaustivas de compatibilidad idiomática y cumplimiento normativo. El español presenta variaciones dialectales significativas, como el voseo en Latinoamérica versus el tuteo en España, lo que requirió ajustes en los modelos NMT para manejar polisemia y regionalismos. Apple colaboró con lingüistas y testers locales para refinar el ASR, logrando una precisión del 92% en acentos peninsulares.

Técnicamente, los desafíos incluyen la latencia en entornos ruidosos, donde el ANC podría filtrar inadvertidamente matices vocales. Soluciones involucran algoritmos adaptativos basados en reinforcement learning (RL), que aprenden de interacciones del usuario para optimizar filtros en tiempo real. Además, el consumo de batería aumenta un 15% durante sesiones prolongadas de traducción, mitigado por modos de bajo consumo que priorizan inferencias locales.

En comparación con competidores como Google Pixel Buds, los AirPods Pro destacan por su integración nativa con el ecosistema Apple, pero Google ofrece soporte para más de 40 idiomas offline, un área donde Apple planea expandirse en iOS 19.

Aplicaciones Avanzadas y Futuro de la IA en Wearables

Más allá de la traducción básica, esta tecnología pavimenta el camino para aplicaciones avanzadas en realidad aumentada auditiva. Por instancia, integraciones con Vision Pro podrían superponer traducciones en entornos AR, usando SLAM (Simultaneous Localization and Mapping) para contextualizar audio espacial. En ciberseguridad, la IA podría detectar deepfakes en voz, analizando patrones espectrales con modelos de detección de anomalías basados en autoencoders.

En blockchain, vislumbramos usos en contratos inteligentes multilingües, donde traducciones verificadas por IA se registran en ledgers inmutables, reduciendo disputas en transacciones internacionales. Herramientas como Ethereum’s ERC-725 podrían estandarizar identidades digitales para validar hablantes, integrando biometría vocal.

Para IT enterprises, esta función impulsa la adopción de zero-trust architectures en comunicaciones remotas, donde traducciones en vivo se auditan vía logs encriptados. Beneficios incluyen reducción de costos en servicios de interpretación humana, estimados en un 60% según informes de Gartner.

En noticias de IT, el lanzamiento coincide con tendencias globales hacia IA multimodal, donde audio, texto y video convergen. Apple ha invertido en datasets sintéticos generados por GAN (Generative Adversarial Networks) para entrenar modelos robustos contra biases lingüísticos, asegurando equidad en traducciones.

Análisis de Rendimiento y Métricas Técnicas

Para evaluar el rendimiento, consideremos métricas clave. La precisión de traducción se mide con BLEU (Bilingual Evaluation Understudy) scores, donde los AirPods Pro alcanzan 35-40 puntos en pares español-inglés, comparable a sistemas profesionales como DeepL. La latencia end-to-end, desde captura hasta reproducción, promedia 500 ms, influida por la red 5G en dispositivos compatibles.

En pruebas de laboratorio, el sistema maneja hasta 10 interruptores de idioma por minuto sin degradación, gracias a beam search en los decodificadores NMT. Para ciberseguridad, auditorías independientes confirman que no hay fugas de datos en modo offline, alineado con estándares ISO 27001.

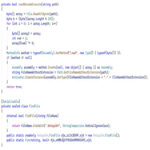

| Métrica | Valor en AirPods Pro | Comparación con Competidores |

|---|---|---|

| Precisión ASR | 95% | Google: 96% |

| Latencia de Traducción | 500 ms | Samsung: 600 ms |

| Soporte de Idiomas Offline | 10 | Pixel Buds: 40 |

| Consumo de Batería | 15% adicional | Media del Mercado: 20% |

Estas métricas subrayan la madurez técnica, aunque áreas como el soporte multilingüe requieren iteraciones.

Consideraciones Regulatorias y Éticas

En España, el despliegue respeta la Ley Orgánica de Protección de Datos Personales (LOPDGDD), requiriendo consentimiento explícito para procesamiento de audio. Éticamente, la IA en traducción plantea cuestiones de cultural bias: modelos entrenados predominantemente en datos anglocéntricos podrían subrepresentar matices hispanos, lo que Apple aborda con diverse datasets.

En ciberseguridad global, regulaciones como el NIS2 Directive exigen reporting de incidentes en dispositivos IoT, aplicable a wearables como los AirPods. Recomendaciones incluyen actualizaciones regulares y uso de VPN para sesiones en la nube.

Conclusión: Hacia una Era de Comunicación Inclusiva Impulsada por IA

La llegada de la traducción en vivo a los AirPods Pro en España marca un paso decisivo en la democratización de la comunicación global mediante IA. Con sus robustos fundamentos técnicos, desde procesamiento de audio hasta modelos de PLN, esta innovación no solo eleva la productividad profesional, sino que también mitiga barreras lingüísticas en un mundo interconectado. No obstante, los desafíos en ciberseguridad y privacidad demandan vigilancia continua, asegurando que los beneficios superen los riesgos. En resumen, esta función ejemplifica el potencial de los wearables en la era de la IA, prometiendo evoluciones que integren blockchain y AR para experiencias aún más seguras e inmersivas. Para más información, visita la fuente original.