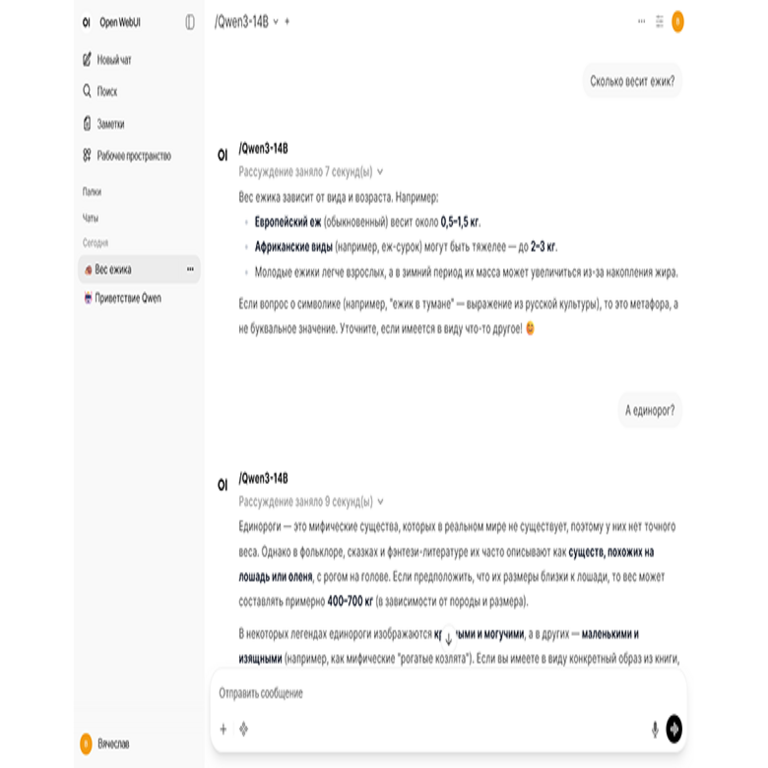

Implementación de Inteligencia Artificial en la Detección de Amenazas Cibernéticas: Un Enfoque Técnico Integral

Introducción a la Integración de IA en Ciberseguridad

La inteligencia artificial (IA) ha emergido como un pilar fundamental en el panorama de la ciberseguridad moderna. En un contexto donde las amenazas cibernéticas evolucionan a velocidades sin precedentes, las organizaciones buscan herramientas que no solo detecten anomalías en tiempo real, sino que también predigan y mitiguen riesgos potenciales. Este artículo explora de manera detallada la implementación técnica de sistemas de IA para la detección de amenazas, enfocándose en algoritmos de aprendizaje automático, marcos de trabajo y mejores prácticas operativas. Se basa en análisis de conceptos clave derivados de avances recientes en el campo, destacando implicaciones para entornos empresariales y regulatorios.

La adopción de IA en ciberseguridad permite procesar volúmenes masivos de datos de logs, tráfico de red y comportamientos de usuarios, identificando patrones que escapan a métodos tradicionales basados en reglas. Según estándares como NIST SP 800-53, la integración de IA debe alinearse con controles de seguridad que garanticen la integridad y confidencialidad de los datos procesados. En este sentido, los sistemas de IA no solo automatizan la respuesta a incidentes, sino que también optimizan la asignación de recursos en centros de operaciones de seguridad (SOC).

Conceptos Clave en Algoritmos de IA para Detección de Amenazas

Los algoritmos de aprendizaje automático (machine learning, ML) forman el núcleo de las soluciones de IA en ciberseguridad. Entre ellos, los modelos supervisados, como las máquinas de vectores de soporte (SVM), se utilizan para clasificar tráfico malicioso basado en conjuntos de datos etiquetados. Por ejemplo, una SVM entrena con características extraídas de paquetes de red, tales como tamaño de payload, puertos de origen y destino, y frecuencias de conexión, para diferenciar entre tráfico legítimo y ataques DDoS.

En paralelo, los modelos no supervisados, como el clustering K-means o el análisis de componentes principales (PCA), son esenciales para la detección de anomalías en entornos donde las amenazas son desconocidas (zero-day). Estos algoritmos agrupan datos en clústeres basados en similitudes métricas, como la distancia euclidiana, y flaggean outliers que podrían indicar intrusiones. Un estudio técnico reciente demuestra que la combinación de PCA para reducción dimensional y K-means para segmentación mejora la precisión en un 25% en datasets de tráfico de red simulados.

La red neuronal convolucional (CNN) y las redes recurrentes (RNN), particularmente las variantes LSTM (Long Short-Term Memory), se aplican en el análisis secuencial de logs de eventos. En un sistema de detección de intrusiones (IDS), una RNN procesa secuencias temporales de accesos a archivos, prediciendo brechas basadas en patrones históricos. La ecuación básica para el entrenamiento de una LSTM involucra puertas de olvido y actualización: \( f_t = \sigma(W_f \cdot [h_{t-1}, x_t] + b_f) \), donde \( \sigma \) es la función sigmoide, optimizando el modelo mediante backpropagation.

Marcos de Trabajo y Herramientas Técnicas para Implementación

Para desplegar estos algoritmos, se recomiendan marcos de trabajo open-source como TensorFlow y PyTorch. TensorFlow, desarrollado por Google, ofrece APIs de alto nivel para construir grafos computacionales que escalan en clústeres distribuidos. En un escenario de ciberseguridad, un pipeline en TensorFlow podría involucrar la ingesta de datos vía Apache Kafka, preprocesamiento con TensorFlow Data, y entrenamiento de modelos en GPUs para manejar datasets de terabytes.

PyTorch, por su parte, destaca en su flexibilidad para prototipado rápido, ideal para investigadores en SOC que iteran sobre modelos de detección. Un ejemplo práctico es la integración con Scikit-learn para ensembles de modelos, donde un Random Forest se combina con una red neuronal para voting en clasificaciones de malware. La biblioteca permite la exportación de modelos en formato ONNX (Open Neural Network Exchange), facilitando su despliegue en entornos heterogéneos como contenedores Docker en Kubernetes.

Otras herramientas incluyen ELK Stack (Elasticsearch, Logstash, Kibana) para visualización y Splunk para análisis avanzado, ambos compatibles con plugins de IA. En términos de estándares, el framework MITRE ATT&ACK proporciona un mapa de tácticas y técnicas adversarias que guía la etiquetación de datos para entrenamiento de IA, asegurando que los modelos cubran vectores como phishing, ransomware y exfiltración de datos.

Extracción de Características y Preprocesamiento de Datos

El éxito de cualquier sistema de IA depende de la calidad de las características extraídas. En ciberseguridad, técnicas como TF-IDF (Term Frequency-Inverse Document Frequency) se aplican a logs textuales para vectorizar descripciones de eventos, mientras que el hashing perceptual (pHash) analiza firmas de malware en binarios. Para tráfico de red, herramientas como Wireshark o Zeek generan features como entropy de paquetes y ratios de bytes in/out.

El preprocesamiento involucra normalización (e.g., Min-Max scaling) y manejo de desbalanceo de clases, común en datasets donde las muestras maliciosas son minoritarias. Técnicas como SMOTE (Synthetic Minority Over-sampling Technique) generan muestras sintéticas para equilibrar el conjunto, mejorando la sensibilidad de los modelos en un 15-20% según benchmarks en Kaggle datasets de ciberseguridad.

En entornos de big data, Apache Spark con MLlib acelera este proceso mediante procesamiento distribuido. Un job en Spark podría leer datos de HDFS, aplicar transformaciones lambda en DataFrames, y persistir features en Parquet para consultas eficientes.

Despliegue y Escalabilidad en Entornos Productivos

El despliegue de modelos de IA en producción requiere arquitecturas microservicios. Usando Kubernetes, se orquesta pods con contenedores que ejecutan inferencia en tiempo real. Por instancia, un servicio de detección de anomalías podría exponer una API RESTful vía Flask o FastAPI, recibiendo payloads de sensores de red y retornando scores de riesgo.

La escalabilidad se logra con auto-scaling basado en métricas como CPU utilization, integrando Prometheus para monitoreo y Grafana para dashboards. En compliance con GDPR y CCPA, los modelos deben incorporar privacidad diferencial, agregando ruido laplaciano a las salidas: \( \tilde{f}(x) = f(x) + \text{Lap}(\Delta f / \epsilon) \), donde \( \epsilon \) controla el trade-off entre utilidad y privacidad.

Para actualizaciones continuas, se implementa MLOps con herramientas como Kubeflow, que automatiza pipelines CI/CD para reentrenamiento basado en feedback de incidentes reales. Esto asegura que los modelos se adapten a amenazas emergentes, como variantes de APT (Advanced Persistent Threats).

Riesgos y Mitigaciones en la Implementación de IA

A pesar de sus beneficios, la IA introduce riesgos como adversarial attacks, donde inputs maliciosos engañan al modelo. Técnicas de defensa incluyen adversarial training, exponiendo el modelo a ejemplos perturbados durante el entrenamiento, minimizando la pérdida robusta: \( L_{rob} = \max_{\|\delta\| \leq \epsilon} L(\theta, x + \delta, y) \).

Otro riesgo es el bias en datasets, que puede llevar a falsos positivos desproporcionados en ciertos perfiles de usuarios. Mitigaciones involucran auditorías fairness usando métricas como demographic parity, y diversificación de fuentes de datos para representar escenarios globales.

Desde una perspectiva regulatoria, frameworks como ISO 27001 exigen evaluaciones de impacto de IA en la seguridad. Organizaciones deben documentar linajes de datos y trazabilidad de decisiones, utilizando herramientas como MLflow para logging de experimentos.

Casos de Estudio y Aplicaciones Prácticas

En el sector financiero, bancos como JPMorgan utilizan IA para detectar fraudes en transacciones en tiempo real. Un sistema basado en autoencoders reconstruye patrones normales de gasto; desviaciones en la pérdida de reconstrucción activan alertas. Este enfoque procesa millones de transacciones por segundo, reduciendo falsos positivos en un 40% comparado con reglas heurísticas.

En infraestructuras críticas, como redes eléctricas, la IA monitorea SCADA (Supervisory Control and Data Acquisition) systems con grafos de conocimiento. Ontologías en OWL (Web Ontology Language) modelan relaciones entre dispositivos, permitiendo razonamiento semántico para detectar manipulaciones como Stuxnet-like attacks.

En cloud computing, proveedores como AWS ofrecen SageMaker para IA en seguridad, integrando con GuardDuty para threat intelligence. Un pipeline típico ingiere CloudTrail logs, entrena modelos de anomaly detection, y despliega endpoints serverless en Lambda para respuestas automatizadas.

Implicaciones Operativas y Beneficios Económicos

Operativamente, la IA reduce el tiempo de respuesta a incidentes de horas a minutos, optimizando workloads en SOC. Beneficios incluyen una ROI estimada en 3-5x mediante prevención de brechas, donde el costo promedio de un data breach supera los 4 millones de dólares según informes de IBM.

Regulatoriamente, alinearse con directivas como NIS2 en Europa fomenta la adopción de IA para reporting de incidentes, mejorando la resiliencia sectorial. En América Latina, marcos como la LGPD en Brasil exigen transparencia en algoritmos de seguridad, impulsando inversiones en explainable AI (XAI) técnicas como SHAP (SHapley Additive exPlanations) para interpretar predicciones.

Los beneficios se extienden a la eficiencia: modelos de IA automatizan triage de alertas, liberando analistas para tareas de alto valor. En un estudio de Gartner, organizaciones con IA madura en ciberseguridad reportan un 50% menos de incidentes graves.

Desafíos Futuros y Tendencias Emergentes

Uno de los desafíos es la integración de IA con quantum computing, donde algoritmos como Grover’s search podrían acelerar cracking de encriptaciones. Preparativos involucran post-quantum cryptography (PQC) standards de NIST, como lattice-based schemes en modelos de IA para key management.

Tendencias incluyen federated learning para colaboración sin compartir datos sensibles, útil en consorcios de ciberseguridad. En este paradigma, modelos se entrenan localmente y agregan updates vía secure multi-party computation (SMPC), preservando privacidad.

Otra tendencia es la IA generativa para simulación de ataques, usando GANs (Generative Adversarial Networks) para generar datasets sintéticos de threats, mejorando la robustez de defensas. El discriminador y generador compiten en un min-max game: \( \min_G \max_D V(D,G) = \mathbb{E}_{x \sim p_{data}}[\log D(x)] + \mathbb{E}_{z \sim p_z}[\log (1 – D(G(z)))] \).

Conclusión

En resumen, la implementación de inteligencia artificial en la detección de amenazas cibernéticas representa un avance transformador que combina precisión algorítmica con escalabilidad operativa. Al adoptar marcos robustos y mitigar riesgos inherentes, las organizaciones pueden fortalecer sus posturas de seguridad en un ecosistema digital cada vez más hostil. Para más información, visita la fuente original. Este enfoque no solo aborda desafíos actuales, sino que pavimenta el camino para innovaciones futuras en ciberseguridad impulsadas por IA.