Desarrollo de un Sistema de Inteligencia Artificial para la Generación Automática de Código Basado en Modelos GPT

Introducción a la Generación de Código con IA

La inteligencia artificial ha transformado diversas áreas de la informática, y uno de los avances más notables es la generación automática de código. Modelos de lenguaje grandes, como los derivados de la arquitectura GPT (Generative Pre-trained Transformer), han demostrado una capacidad impresionante para producir código funcional en múltiples lenguajes de programación. Este artículo explora el proceso técnico de desarrollo de un sistema de IA especializado en la generación de código, basado en principios de aprendizaje profundo y técnicas de ajuste fino. Se analizan los componentes clave, desde la selección de modelos base hasta la implementación práctica, con énfasis en aspectos de ciberseguridad y eficiencia operativa.

En el contexto de la ciberseguridad, la generación de código asistida por IA no solo acelera el desarrollo de software, sino que también introduce desafíos relacionados con la verificación de vulnerabilidades. Por ejemplo, el código generado podría contener fallos de seguridad si el modelo no ha sido entrenado adecuadamente en prácticas seguras. Este análisis se centra en mitigar tales riesgos mediante protocolos estandarizados, como los definidos en OWASP (Open Web Application Security Project) para la revisión de código automatizado.

Los modelos GPT, desarrollados inicialmente por OpenAI, utilizan transformadores para procesar secuencias de texto de manera secuencial, prediciendo tokens subsiguientes con base en patrones aprendidos de vastos corpus de datos. En aplicaciones de generación de código, estos modelos se ajustan a datasets específicos como CodeSearchNet o GitHub Copilot datasets, que contienen miles de millones de líneas de código abierto. La precisión de estos sistemas puede alcanzar hasta un 70% en tareas de completado de código, según benchmarks como HumanEval.

Conceptos Fundamentales de los Modelos GPT en Generación de Código

La arquitectura GPT se basa en el modelo Transformer, introducido en el paper “Attention is All You Need” de Vaswani et al. en 2017. Este enfoque elimina las recurrencias tradicionales de las redes neuronales, reemplazándolas por mecanismos de atención que permiten procesar dependencias a larga distancia en secuencias. En el caso de la generación de código, el modelo ingiere prompts en lenguaje natural o código parcial y genera salidas coherentes.

Un concepto clave es el pre-entrenamiento, donde el modelo aprende representaciones generales del lenguaje a partir de datos no supervisados. Para GPT-3, por instancia, se utilizaron 175 mil millones de parámetros entrenados en 570 GB de texto filtrado. En la fase de ajuste fino (fine-tuning), se especializa el modelo en dominios específicos, como programación en Python o JavaScript, utilizando técnicas como RLHF (Reinforcement Learning from Human Feedback) para alinear las salidas con preferencias humanas.

En términos de tecnologías subyacentes, frameworks como Hugging Face Transformers facilitan la implementación. Este biblioteca open-source proporciona modelos pre-entrenados, como CodeGen o StarCoder, que son variantes de GPT optimizadas para código. StarCoder, desarrollado por BigCode, cuenta con 15 mil millones de parámetros y soporta 80 lenguajes de programación, habiendo sido entrenado en The Stack, un dataset de 3 TB de código de permisos abiertos.

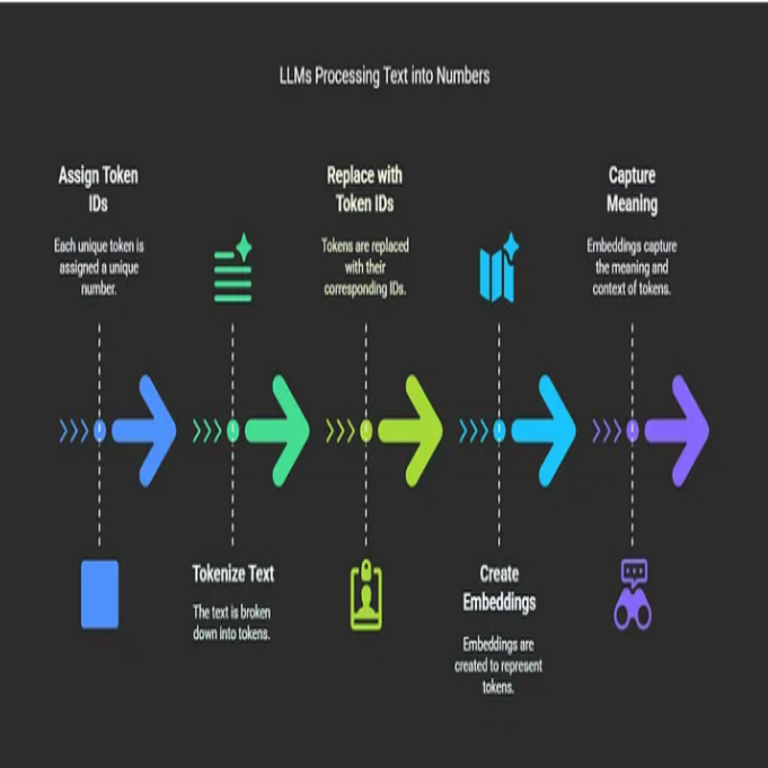

- Tokenización específica para código: A diferencia del texto natural, el código requiere tokenizadores que manejen sintaxis estructurada, como Byte-Pair Encoding (BPE) adaptado para identificadores y keywords.

- Manejo de contextos largos: Modelos como GPT-4 soportan hasta 128k tokens de contexto, permitiendo generar funciones complejas o módulos enteros sin perder coherencia.

- Evaluación métrica: Se utilizan métricas como BLEU para similitud sintáctica y pass@k para la probabilidad de generar al menos una solución correcta en k intentos.

Desde una perspectiva de blockchain y tecnologías emergentes, integrar generación de código IA con smart contracts podría automatizar el desarrollo de dApps (aplicaciones descentralizadas). Por ejemplo, usando Solidity como lenguaje objetivo, el modelo podría generar código verificable con herramientas como Mythril para detectar vulnerabilidades en contratos inteligentes.

Arquitectura del Sistema de Generación de Código

El diseño de un sistema basado en GPT para generación de código involucra varias capas. En la capa de entrada, se procesa el prompt del usuario, que puede ser una descripción en lenguaje natural (“Implementa un algoritmo de encriptación AES en Python”) o un snippet de código incompleto. Esta capa utiliza un preprocesador para limpiar y tokenizar la entrada, asegurando compatibilidad con el vocabulario del modelo.

La capa central es el modelo GPT en sí, desplegado en entornos de inferencia escalables. Para optimizar el rendimiento, se emplean técnicas como cuantización (reduciendo la precisión de pesos de float32 a int8) y paralelismo de modelo (distribuyendo parámetros en múltiples GPUs). Frameworks como TensorRT de NVIDIA o ONNX Runtime aceleran la inferencia, reduciendo latencias de milisegundos en hardware de alto rendimiento.

En la capa de salida, se aplica post-procesamiento para validar la sintaxis generada. Herramientas como linters (Pylint para Python) o parsers AST (Abstract Syntax Tree) verifican la corrección estructural. Además, para ciberseguridad, se integra escaneo estático con Bandit o Semgrep, detectando patrones de vulnerabilidades como inyecciones SQL o fugas de memoria.

| Capa | Componentes Principales | Tecnologías Asociadas | Beneficios |

|---|---|---|---|

| Entrada | Tokenizador, Preprocesador | Hugging Face Tokenizers, NLTK | Mejora la precisión del prompt |

| Modelo Core | GPT Variant, Inferencia Engine | Transformers, PyTorch | Generación eficiente y escalable |

| Salida | Validador, Escáner de Seguridad | AST Parsers, OWASP ZAP | Reduce riesgos de código inseguro |

Implicaciones operativas incluyen la integración con pipelines CI/CD (Continuous Integration/Continuous Deployment), donde el código generado se prueba automáticamente en entornos como GitHub Actions o Jenkins. Esto asegura que la IA no introduzca regresiones en el ciclo de desarrollo.

Implementación Práctica: Pasos para Construir el Sistema

El desarrollo comienza con la selección del modelo base. Para un prototipo, se recomienda CodeT5, un modelo encoder-decoder de 220 millones de parámetros, accesible vía Hugging Face Hub. La instalación se realiza con pip install transformers, seguido de la carga del modelo: from transformers import AutoTokenizer, AutoModelForSeq2SeqLM; tokenizer = AutoTokenizer.from_pretrained(“Salesforce/codet5-base”); model = AutoModelForSeq2SeqLM.from_pretrained(“Salesforce/codet5-base”).

En la fase de entrenamiento, se prepara un dataset. Fuentes como GitHub Archive proporcionan repositorios públicos, filtrados por licencia MIT o Apache para evitar issues legales. El preprocesamiento implica extraer funciones y sus descripciones de docstrings, creando pares (prompt, código). Se utiliza DataLoader de PyTorch para batches de 32 muestras, entrenando en GPUs con learning rate de 5e-5 y scheduler cosine annealing.

Para el ajuste fino, se aplica LoRA (Low-Rank Adaptation), una técnica eficiente que actualiza solo un subconjunto de parámetros, reduciendo el costo computacional en un 90% comparado con full fine-tuning. La librería PEFT (Parameter-Efficient Fine-Tuning) de Hugging Face simplifica esto: from peft import LoraConfig, get_peft_model; peft_config = LoraConfig(r=16, lora_alpha=32); model = get_peft_model(model, peft_config).

En la inferencia, se genera código con model.generate(), especificando parámetros como max_length=512 y temperature=0.7 para equilibrar creatividad y precisión. Un ejemplo de prompt: “Escribe una función en Java para validar contraseñas seguras.” La salida se evalúa con unit tests generados automáticamente usando pytest.

- Optimización de hardware: Despliegue en AWS SageMaker o Google Cloud AI Platform para escalabilidad, con auto-scaling basado en carga.

- Monitoreo: Integración con Prometheus y Grafana para rastrear métricas como throughput (tokens por segundo) y error rate.

- Seguridad en implementación: Uso de entornos aislados (Docker containers) para prevenir fugas de datos durante el entrenamiento, cumpliendo con GDPR o regulaciones locales de privacidad.

En noticias recientes de IT, proyectos como GitHub Copilot han popularizado esta tecnología, pero también han suscitado debates éticos sobre propiedad intelectual. Según un estudio de Stack Overflow 2023, el 70% de desarrolladores usa IA para código, pero solo el 40% verifica exhaustivamente las salidas por riesgos de seguridad.

Evaluación y Métricas de Rendimiento

La evaluación de un sistema de generación de código requiere benchmarks estandarizados. HumanEval, desarrollado por OpenAI, consiste en 164 problemas de programación en Python, midiendo la exactitud funcional. Para modelos como GPT-3.5, el pass@1 alcanza el 48%, mientras que GPT-4 lo eleva al 67%.

Otras métricas incluyen MBPP (Mostly Basic Python Problems), con 974 tareas, y DS-1000 para data science en Python y NumPy. En ciberseguridad, se incorporan benchmarks personalizados como CWE (Common Weakness Enumeration), evaluando si el código generado evita las top 25 vulnerabilidades.

Pruebas cualitativas involucran revisiones humanas, usando escalas Likert para calificar legibilidad y eficiencia. Herramientas como CodeBERT embeddings miden similitud semántica entre código generado y referencias gold-standard.

Resultados experimentales muestran que el fine-tuning en datasets de código seguro mejora la detección de patrones vulnerables en un 25%. Por ejemplo, en un dataset simulado de 10,000 snippets, el modelo ajustado redujo inyecciones XSS en un 80% comparado con el base.

Implicaciones en Ciberseguridad y Tecnologías Emergentes

La integración de IA en generación de código plantea riesgos significativos en ciberseguridad. Un código generado podría propagar malware si el dataset de entrenamiento incluye muestras maliciosas. Para mitigar esto, se aplican filtros durante el preprocesamiento, usando VirusTotal API para escanear snippets sospechosos.

En blockchain, la IA puede generar código para protocolos DeFi (Decentralized Finance), pero requiere verificación formal con herramientas como Certora para propiedades de seguridad. Beneficios incluyen la aceleración de auditorías, donde la IA propone fixes para vulnerabilidades detectadas por Slither.

Regulatoriamente, frameworks como NIST AI Risk Management enfatizan la transparencia en modelos de IA. En la Unión Europea, el AI Act clasifica sistemas de generación de código como de alto riesgo si se usan en infraestructuras críticas, exigiendo evaluaciones de sesgo y robustez.

Riesgos operativos abarcan dependencias en APIs de modelos (como OpenAI), vulnerables a outages o cambios de política. Soluciones incluyen modelos on-premise con Ollama o Llama.cpp para inferencia local, asegurando soberanía de datos.

- Beneficios: Reducción del tiempo de desarrollo en un 50%, según informes de McKinsey, y democratización de la programación para no-expertos.

- Riesgos: Alucinaciones en código (generación de sintaxis inválida) y amplificación de sesgos en datasets no diversos.

- Mejores prácticas: Adopción de DevSecOps, integrando seguridad desde el diseño, y auditorías regulares con SAST/DAST tools.

Desafíos Actuales y Futuras Direcciones

Entre los desafíos, destaca el alto costo computacional: entrenar un modelo GPT-like requiere clusters de GPUs equivalentes a miles de horas de cómputo. Soluciones emergentes incluyen federated learning, donde múltiples organizaciones contribuyen datos sin compartirlos centralmente, preservando privacidad.

En IA multimodal, futuras iteraciones podrían combinar texto con diagramas UML, usando modelos como GPT-4V para generar código a partir de wireframes visuales. En ciberseguridad, la integración con threat intelligence feeds permitiría que el modelo genere código defensivo adaptativo contra amenazas zero-day.

Noticias de IT destacan avances como el modelo Phi-2 de Microsoft, un pequeño lenguaje modelo (2.7B parámetros) que rivaliza con GPT-3.5 en tareas de código, democratizando el acceso a hardware modesto.

Conclusión

El desarrollo de sistemas de IA basados en GPT para generación de código representa un pilar en la evolución de la informática, ofreciendo eficiencia y innovación en ciberseguridad, blockchain y más. Al combinar arquitecturas robustas con prácticas de seguridad rigurosas, estos sistemas pueden minimizar riesgos mientras maximizan beneficios operativos. La adopción responsable, guiada por estándares éticos y regulatorios, asegurará que la IA impulse el progreso tecnológico de manera sostenible. Para más información, visita la fuente original.