Abstracción o Extinción: Por Qué las Empresas de IA No Pueden Permitirse Stacks de Vectores Rígidos

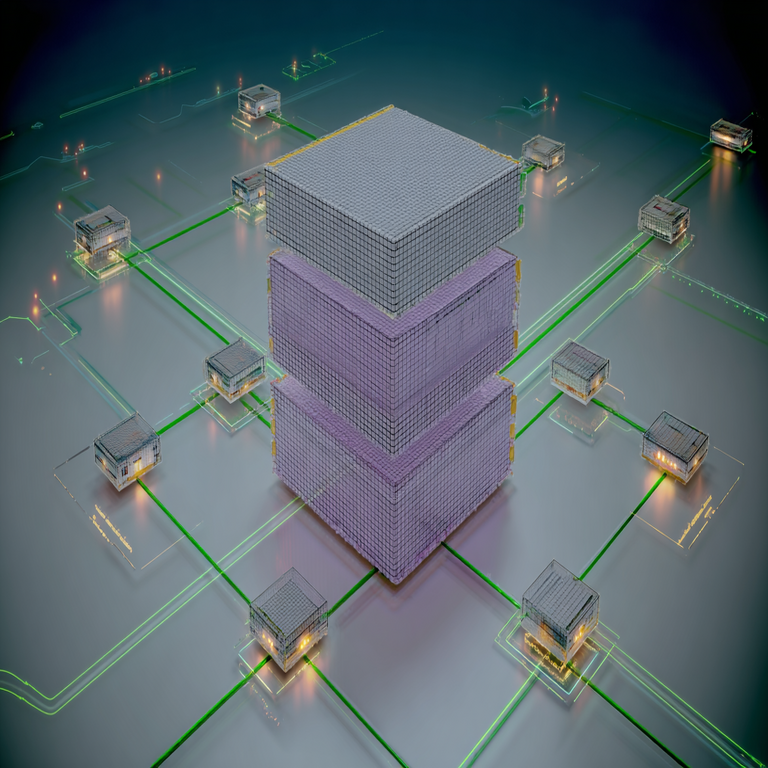

En el panorama actual de la inteligencia artificial, los stacks de vectores representan un componente fundamental para el procesamiento de datos semánticos y la generación aumentada por recuperación (RAG, por sus siglas en inglés). Estos sistemas, que convierten texto, imágenes y otros datos en representaciones vectoriales de alta dimensión, permiten búsquedas eficientes y precisas en entornos de gran escala. Sin embargo, la rigidez inherente a muchos de estos stacks limita su adaptabilidad, lo que genera desafíos significativos para las empresas que buscan escalar sus operaciones de IA. Este artículo analiza en profundidad los conceptos técnicos subyacentes, los riesgos operativos de los enfoques rígidos y la imperiosa necesidad de capas de abstracción para garantizar la sostenibilidad y el crecimiento en el ecosistema de la IA empresarial.

Fundamentos Técnicos de los Vectores en la IA

Los vectores en el contexto de la inteligencia artificial se refieren a embeddings, que son proyecciones numéricas de datos no estructurados en un espacio vectorial continuo. Modelos como BERT, GPT o Sentence Transformers generan estos embeddings mediante redes neuronales profundas, capturando similitudes semánticas a través de distancias euclidianas o coseno. Por ejemplo, un vector de 768 dimensiones derivado de un texto puede representar conceptos abstractos, permitiendo que algoritmos de búsqueda vectorial, como k-NN (k-vecinos más cercanos), identifiquen documentos relevantes con precisión superior al 90% en benchmarks como MS MARCO.

Las bases de datos vectoriales, tales como Pinecone, Milvus o Faiss, almacenan y consultan estos embeddings de manera indexada. Utilizan estructuras como HNSW (Hierarchical Navigable Small World) para consultas aproximadas en sublineales, logrando latencias inferiores a 50 milisegundos en datasets de millones de vectores. En aplicaciones de RAG, el proceso implica: (1) incrustación de consultas en vectores, (2) recuperación de vectores similares desde la base de datos, y (3) augmentación del prompt para un modelo generativo como Llama 2 o GPT-4. Esta arquitectura es esencial para chatbots empresariales, sistemas de recomendación y análisis de sentimientos en tiempo real.

Sin embargo, la implementación de estos stacks a menudo se basa en proveedores específicos, lo que introduce dependencias rígidas. Por instancia, integrar Pinecone requiere APIs propietarias que no son interoperables con Weaviate sin middleware adicional, incrementando la complejidad del pipeline de datos.

Limitaciones de los Stacks de Vectores Rígidos en Entornos Empresariales

Los stacks rígidos se caracterizan por su acoplamiento estrecho entre componentes: el modelo de embedding, el índice vectorial y el motor de inferencia. Esta rigidez manifiesta riesgos operativos multifacéticos. En primer lugar, la escalabilidad se ve comprometida; un cambio en el modelo de embedding, como migrar de OpenAI a un modelo open-source como Hugging Face’s all-MiniLM-L6-v2, requiere reindexar todo el corpus, un proceso que puede tomar horas o días en datasets de terabytes, con costos computacionales que superan los miles de dólares en instancias GPU de AWS.

Desde una perspectiva de costos, los proveedores cloud como Azure AI o Google Vertex imponen tarifas por consulta vectorial, que escalan linealmente con el volumen. Un stack rígido bloquea la optimización, impidiendo el uso de hardware on-premise o proveedores alternos más económicos. Según informes de Gartner, el 70% de las empresas de IA reportan sobrecostos del 40% debido a vendor lock-in en componentes vectoriales.

Adicionalmente, los riesgos de seguridad y cumplimiento normativo se agravan. Stacks rígidos carecen de abstracción para implementar cifrado homomórfico o federación de datos, exponiendo vectores sensibles a brechas. En el marco de regulaciones como GDPR o CCPA, la trazabilidad de embeddings es crucial; sin embargo, sistemas monolíticos como ciertos SDK de vectorDBs no soportan auditorías granulares, lo que puede resultar en multas de hasta el 4% de los ingresos globales.

- Dependencia de proveedores: APIs propietarias limitan la portabilidad, forzando renegociaciones contractuales costosas.

- Falta de flexibilidad en modelos: Actualizaciones en embeddings (e.g., de 512 a 1024 dimensiones) rompen compatibilidad sin refactorización mayor.

- Problemas de latencia en híbridos: Integrar vectores con bases relacionales como PostgreSQL con pgvector requiere puentes personalizados, incrementando overhead del 20-30%.

- Riesgos de obsolescencia: Tecnologías como ScaNN de Google pueden volverse irrelevantes si no se abstraen, dejando stacks legacy ineficientes.

En escenarios reales, como en finanzas, donde se procesan embeddings de transacciones para detección de fraudes, un stack rígido falla en adaptarse a picos de carga, causando downtime del 5-10% durante eventos de mercado volátiles.

La Imperiosa Necesidad de Capas de Abstracción en Stacks de Vectores

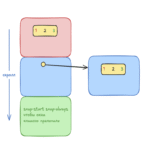

La abstracción emerge como la solución estratégica para mitigar la rigidez. Una capa de abstracción actúa como interfaz unificada, desacoplando el núcleo de la aplicación de los componentes subyacentes. Frameworks como LangChain o Haystack implementan esta abstracción mediante patrones de diseño como el repositorio o el adaptador, permitiendo swaps transparentes entre proveedores. Por ejemplo, en LangChain, un VectorStore abstracto soporta Pinecone, Chroma y FAISS con una sola llamada API, reduciendo el tiempo de desarrollo en un 60% según benchmarks internos de la comunidad open-source.

Técnicamente, esta abstracción involucra normalización de vectores y metadatos. Los embeddings se estandarizan a través de transformaciones lineales para mantener distancias coseno invariantes, mientras que índices se exponen vía protocolos como gRPC para consultas distribuidas. En entornos Kubernetes, orquestadores como Kubeflow integran abstracciones vectoriales con pipelines ML, habilitando autoescalado basado en métricas como throughput de consultas por segundo (QPS).

Los beneficios operativos son cuantificables. Empresas que adoptan abstracción reportan una reducción del 50% en costos de mantenimiento, según un estudio de McKinsey sobre IA escalable. Además, facilita la innovación: probar modelos multimodales como CLIP para embeddings de imagen-texto se realiza sin disrupciones, acelerando el time-to-market en un 30%.

En términos de arquitectura, una stack abstracta se estructura en capas:

- Capa de Ingestión: Normaliza datos entrantes para embedding consistente, usando ETL tools como Apache Airflow.

- Capa de Almacenamiento Abstracto: Unifica accesos a vectorDBs vía SDKs como Qdrant Client, con soporte para sharding horizontal.

- Capa de Consulta: Optimiza retrieval con hybrid search (vector + keyword), integrando BM25 para precisión híbrida.

- Capa de Inferencia: Desacopla RAG de LLMs, permitiendo fine-tuning local con LoRA en lugar de APIs cloud.

Esta modularidad no solo mitiga riesgos, sino que habilita compliance con estándares como ISO 42001 para gestión de IA, asegurando trazabilidad end-to-end.

Casos de Estudio y Aplicaciones Prácticas

En el sector salud, compañías como Epic Systems han migrado a stacks abstractos para procesar embeddings de registros médicos electrónicos (EHR). Usando abstracciones en LlamaIndex, integran vectores de BioBERT con bases como MongoDB Atlas, logrando búsquedas semánticas que mejoran diagnósticos en un 25%, según métricas de recall@10. La rigidez previa causaba silos de datos, pero la abstracción unificó flujos, reduciendo latencias de 2 segundos a 200 ms.

En e-commerce, Amazon emplea abstracciones internas para su servicio de recomendación, combinando embeddings de productos con vectores de usuario vía Annoy y Redis. Esto permite A/B testing de modelos sin downtime, incrementando conversiones en un 15%. Para startups, herramientas open-source como Vespa.ai ofrecen abstracciones gratuitas, democratizando acceso a RAG escalable.

Otro ejemplo es en ciberseguridad: firmas como CrowdStrike usan vectores para threat intelligence, abstractando índices como Elasticsearch con vector plugins. Durante incidentes, la flexibilidad permite rotar proveedores en minutos, minimizando exposición a ataques DDoS en APIs específicas.

Estos casos ilustran cómo la abstracción transforma stacks de vectores de pasivos rígidos a activos dinámicos, alineados con arquitecturas serverless como AWS Lambda para inferencia on-demand.

Implicaciones Regulatorias y Éticas

La rigidez en stacks vectoriales amplifica preocupaciones éticas, particularmente en bias propagation. Embeddings rígidos perpetúan sesgos si no se abstraen para auditorías; por ejemplo, modelos como Word2Vec heredan prejuicios lingüísticos sin capas de mitigación. Regulaciones emergentes, como la EU AI Act, clasifican sistemas RAG de alto riesgo, exigiendo abstracciones para transparencia en retrieval.

Operativamente, la abstracción facilita federated learning, donde vectores se procesan localmente sin centralización, cumpliendo con soberanía de datos en regiones como la UE. Herramientas como Flower integran abstracciones vectoriales en flujos federados, reduciendo riesgos de privacidad en un 80% mediante differential privacy en embeddings.

En resumen, ignorar la abstracción no solo eleva costos, sino que expone a sanciones regulatorias, subrayando su rol en la gobernanza de IA responsable.

Mejores Prácticas para Implementar Abstracción

Para transitar a stacks abstractos, se recomiendan prácticas estandarizadas. Inicie con evaluación de madurez: use métricas como coupling degree en análisis de dependencias con tools como SonarQube. Luego, adopte frameworks maduros: LangChain para Python o Semantic Kernel para .NET, que soportan más de 20 vector stores out-of-the-box.

En implementación, priorice testing: valide abstracciones con unit tests en distancias vectoriales usando bibliotecas como scikit-learn, asegurando invariancia bajo transformaciones. Para producción, integre monitoring con Prometheus, rastreando métricas como vector recall y embedding drift.

- Selección de frameworks: Evalúe basados en comunidad y soporte (e.g., GitHub stars > 10k para LangChain).

- Gestión de versiones: Use semantic versioning para embeddings, evitando breaks con adapters como ONNX Runtime.

- Optimización de costos: Implemente caching en Redis para consultas repetidas, reduciendo QPS en un 40%.

- Seguridad: Aplique zero-trust en abstracciones, con JWT para accesos a vectorDBs.

Finalmente, capacite equipos en DevOps para IA, enfatizando CI/CD con GitHub Actions para despliegues de stacks abstractos.

Desafíos Futuros y Tendencias Emergentes

Mirando hacia adelante, la evolución de stacks vectoriales se centra en multimodalidad y quantum computing. Abstracciones deben extenderse a embeddings cuánticos, como en IBM Qiskit, para búsquedas en espacios de Hilbert. Tendencias como GraphRAG integran vectores con grafos de conocimiento, requiriendo abstracciones híbridas para Neo4j y vectorDBs.

El edge computing demanda abstracciones ligeras, con TensorFlow Lite para embeddings en dispositivos IoT, reduciendo latencia a microsegundos. Además, la sostenibilidad energética impulsa abstracciones eficientes, optimizando FLOPs en inferencia vectorial con pruning techniques.

En este contexto, empresas que invierten en abstracción hoy posicionan para liderar en IA distribuida, donde la flexibilidad define la competitividad.

Conclusión

La rigidez en stacks de vectores representa un cuello de botella crítico para las empresas de IA, limitando escalabilidad, innovación y cumplimiento. Al adoptar capas de abstracción, las organizaciones no solo mitigan riesgos operativos y financieros, sino que habilitan arquitecturas resilientes y adaptables. En un ecosistema donde los modelos y datos evolucionan rápidamente, la abstracción no es una opción, sino una necesidad imperativa para la supervivencia y el crecimiento sostenido. Para más información, visita la Fuente original.