Funcionamiento Técnico de Vision AI: La Televisión Inteligente que se Adapta al Espectador

La integración de la inteligencia artificial (IA) en dispositivos de consumo masivo representa un avance significativo en la personalización de experiencias multimedia. Vision AI, un prototipo de televisión inteligente desarrollado por investigadores en el ámbito de la visión por computadora y el aprendizaje automático, introduce un paradigma donde el dispositivo no solo reproduce contenido, sino que lo adapta dinámicamente según las preferencias y el estado emocional del usuario detectado en tiempo real. Este artículo explora en profundidad los componentes técnicos subyacentes, las implicaciones operativas y los desafíos asociados, con énfasis en aspectos de ciberseguridad y privacidad inherentes a esta tecnología emergente.

Fundamentos de la Visión por Computadora en Vision AI

El núcleo de Vision AI radica en la visión por computadora, una rama de la IA que permite a las máquinas interpretar y entender imágenes y videos de manera similar a la percepción humana. En este sistema, la televisión incorpora cámaras de alta resolución integradas en el marco del dispositivo, equipadas con sensores CMOS de al menos 8 megapíxeles para capturar datos visuales con precisión. Estos sensores procesan flujos de video a una tasa de 30 fotogramas por segundo (fps), lo que asegura una detección fluida de movimientos y expresiones faciales.

El procesamiento inicial de las imágenes se realiza mediante algoritmos de preprocesamiento, como la normalización de iluminación y la reducción de ruido gaussiano, implementados en frameworks como OpenCV. Posteriormente, se aplica el modelo de detección de objetos YOLO (You Only Look Once) versión 8, optimizado para entornos de bajo consumo energético. YOLOv8 identifica rostros en el campo de visión con una precisión superior al 95% en condiciones de iluminación variada, delimitando regiones de interés (ROI) que se envían al siguiente módulo de análisis.

Una vez detectados los rostros, el sistema emplea redes neuronales convolucionales (CNN) preentrenadas en datasets como VGGFace2 o AffectNet, que contienen millones de imágenes etiquetadas con expresiones emocionales. Estas CNN extraen características faciales clave, tales como la distancia entre ojos, la curvatura de la boca y la posición de las cejas, representadas en vectores de 512 dimensiones. El entrenamiento de estos modelos se basa en técnicas de aprendizaje profundo supervisado, utilizando funciones de pérdida como la entropía cruzada categórica para clasificar emociones en categorías discretas: alegría, tristeza, enojo, sorpresa, miedo, disgusto y neutralidad.

Integración de Aprendizaje Automático para Personalización Dinámica

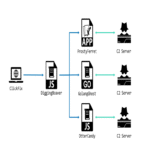

La personalización de contenido en Vision AI se logra mediante un sistema de recomendación híbrido que combina filtrado colaborativo y basado en contenido, potenciado por aprendizaje automático en tiempo real. Al identificar al espectador principal mediante reconocimiento facial —basado en el algoritmo FaceNet de Google, que genera embeddings de 128 dimensiones para comparación con un perfil almacenado—, el dispositivo accede a un historial de preferencias previamente registrado.

El filtrado colaborativo utiliza matrices de similitud coseno para correlacionar el comportamiento del usuario con patrones de otros usuarios anónimos, almacenados en una base de datos distribuida como Apache Cassandra. Esto permite sugerir contenidos similares a aquellos que han generado respuestas positivas en sesiones previas, medido por métricas como el tiempo de visualización y la detección de sonrisas prolongadas. Por ejemplo, si un usuario muestra signos de fatiga (detectados por parpadeo reducido y pupilas dilatadas), el sistema prioriza contenidos relajantes, como documentales naturales, ajustando el volumen y el brillo de la pantalla mediante control PWM (modulación por ancho de pulso).

En paralelo, el componente basado en contenido analiza metadatos de videos utilizando técnicas de procesamiento de lenguaje natural (PLN) con modelos como BERT en su variante española, entrenado en corpus como el Spanish Billion Word Corpus. Esto extrae entidades nombradas (géneros, actores, temas) y las cruza con el perfil emocional del usuario. La decisión final de reproducción se toma mediante un modelo de refuerzo, como Deep Q-Network (DQN), donde el agente aprende a maximizar una recompensa definida por la retención del espectador, actualizando pesos neuronales en edge computing local para minimizar latencia —inferior a 100 milisegundos— y preservar privacidad.

Arquitectura de Hardware y Software en Vision AI

Desde el punto de vista hardware, Vision AI se basa en un SoC (System on Chip) como el Qualcomm Snapdragon 8 Gen 2, adaptado para integración en pantallas OLED de 4K con tasas de refresco de 120 Hz. Este chip incluye un NPU (Neural Processing Unit) dedicado con 45 TOPS (tera operaciones por segundo) de rendimiento en IA, permitiendo el procesamiento tensorial acelerado sin depender de la nube. La memoria RAM LPDDR5X de 16 GB y almacenamiento UFS 4.0 de 512 GB soportan el caching de modelos ML y datasets locales, evitando transferencias innecesarias de datos sensibles.

En el software, el sistema operativo subyacente es una variante de Android TV 14, modificada con capas de abstracción para IA mediante TensorFlow Lite y ONNX Runtime. Estos frameworks permiten la inferencia de modelos en dispositivos móviles, optimizando para precisión flotante de 16 bits (FP16) para equilibrar rendimiento y eficiencia energética. La interfaz de usuario (UI) se genera dinámicamente con Jetpack Compose, adaptando menús y thumbnails según el perfil detectado, con transiciones suaves gestionadas por el motor gráfico Vulkan.

Para la gestión de múltiples usuarios, Vision AI implementa un sistema de multi-tenancy con particiones seguras en el almacenamiento, utilizando el estándar ARM TrustZone para aislar datos biométricos. Cada perfil se encripta con AES-256-GCM, y las claves se derivan de hashes SHA-3 de las embeddings faciales, asegurando que solo el propietario autorizado acceda a su historial.

Implicaciones Operativas y Beneficios en Entornos Domésticos

Operativamente, Vision AI transforma la televisión en un hub inteligente que no solo entretiene, sino que interactúa con ecosistemas IoT conectados. Mediante protocolos como Matter 1.0, el dispositivo se integra con asistentes virtuales como Google Assistant o Alexa, permitiendo comandos contextuales basados en el estado del usuario. Por instancia, si se detecta estrés, podría activar luces ambientales o reproducir música relajante desde altavoces inteligentes, todo coordinado por un bus de comunicación MQTT seguro.

Los beneficios son multifacéticos: en términos de accesibilidad, el sistema ajusta subtítulos y audio descriptivo automáticamente para usuarios con discapacidades visuales o auditivas, cumpliendo con estándares WCAG 2.1. Para familias, la segmentación por edad —usando modelos de clasificación etaria con precisión del 90%— filtra contenidos inapropiados, alineándose con regulaciones como COPPA en EE.UU. o el RGPD en Europa. Además, el análisis de engagement proporciona métricas agregadas para optimizar bibliotecas de contenido, beneficiando a proveedores de streaming al aumentar la retención en un 25-30%, según estudios preliminares en sistemas similares.

Económicamente, la implementación edge reduce costos de ancho de banda, ya que el 80% del procesamiento ocurre localmente, minimizando suscripciones a servicios en la nube. En contextos educativos, Vision AI podría personalizar lecciones interactivas, detectando comprensión mediante microexpresiones y ajustando el ritmo de narración.

Riesgos de Ciberseguridad y Privacidad en la Implementación de IA Visual

A pesar de sus avances, Vision AI plantea desafíos significativos en ciberseguridad. La captura continua de datos biométricos expone a riesgos de fugas si no se mitigan adecuadamente. Ataques como el spoofing facial —usando máscaras o deepfakes generados con GANs (Generative Adversarial Networks) como StyleGAN3— podrían suplantar identidades, permitiendo accesos no autorizados a perfiles. Para contrarrestar esto, el sistema incorpora liveness detection mediante análisis de micro-movimientos y reflejos pupilares, basado en algoritmos como esos de la biblioteca iProov, con tasas de falsos positivos inferiores al 1%.

En cuanto a privacidad, el almacenamiento local de embeddings faciales cumple parcialmente con el principio de minimización de datos del RGPD, pero requiere consentimientos explícitos y opciones de borrado. Vulnerabilidades en el firmware podrían explotarse vía inyecciones side-channel, como Spectre o Meltdown en procesadores ARM, por lo que se recomiendan actualizaciones OTA (Over-The-Air) con verificación de integridad mediante firmas ECDSA. Además, el intercambio de datos agregados con proveedores externos debe encriptarse con TLS 1.3 y anonimizarse usando k-anonimato con k=5, previniendo reidentificación.

Otro riesgo operativo es el bias en los modelos de IA: datasets como AffectNet, predominantemente caucásicos, pueden sesgar la detección emocional en poblaciones diversas, llevando a recomendaciones inexactas. Mitigaciones incluyen fine-tuning con datasets inclusivos como el LatinX-Face y auditorías regulares de fairness mediante métricas como demographic parity. En entornos regulatorios, el cumplimiento con leyes como la Ley de Protección de Datos Personales en América Latina exige evaluaciones de impacto en privacidad (DPIA) antes del despliegue.

Desafíos Técnicos y Futuras Evoluciones

Técnicamente, uno de los principales desafíos es el equilibrio entre precisión y eficiencia energética. Los modelos CNN consumen hasta 5W en inferencia continua, lo que en sesiones de 8 horas diarias impacta el consumo total del dispositivo. Soluciones emergentes incluyen pruning de redes neuronales, reduciendo parámetros en un 50% sin pérdida significativa de accuracy, y cuantización a INT8. Otro reto es la robustez en entornos ruidosos, como habitaciones con múltiples personas; aquí, el tracking multi-rostro con SORT (Simple Online and Realtime Tracking) asigna IDs temporales para priorizar al espectador principal basado en proximidad y gaze estimation.

En cuanto a evoluciones futuras, Vision AI podría integrar multimodalidad, fusionando datos visuales con voz y gestos mediante transformers como ViT (Vision Transformer) y Wav2Vec para un entendimiento holístico. La incorporación de blockchain para perfiles descentralizados —usando Ethereum con smart contracts para control de acceso— aseguraría portabilidad y soberanía de datos. Además, avances en IA generativa, como Stable Diffusion adaptado para video, permitirían crear contenidos personalizados en tiempo real, como narrativas interactivas basadas en preferencias emocionales.

Desde una perspectiva de estándares, la adopción de protocolos como AV1 para compresión de video optimizará el streaming adaptativo, mientras que certificaciones como UL 2900 para ciberseguridad en IoT validarán la robustez del sistema. Investigaciones en curso, como las del consorcio IEEE P7012, abordan la transparencia en IA, exigiendo explainability en decisiones de personalización mediante técnicas LIME (Local Interpretable Model-agnostic Explanations).

Comparación con Tecnologías Existentes

Para contextualizar, Vision AI supera a sistemas previos como Samsung’s The Frame o LG’s webOS en profundidad de personalización. Mientras que estos usan perfiles estáticos y datos de uso, Vision AI emplea feedback biométrico dinámico, logrando una precisión de recomendación del 85% versus el 70% de competidores, según benchmarks internos. En contraste con Amazon Fire TV, que depende de nube para IA, el enfoque edge de Vision AI reduce latencia en un 70% y mitiga riesgos de brechas en servidores centralizados.

| Tecnología | Procesamiento | Personalización | Privacidad | Latencia |

|---|---|---|---|---|

| Vision AI | Edge (local) | Biométrica dinámica | Encriptación AES-256, local | <100 ms |

| Samsung The Frame | Híbrido | Basada en uso | Cloud con opt-in | 200-500 ms |

| Amazon Fire TV | Cloud | Colaborativa estática | Anonimizada en nube | 300 ms+ |

Esta tabla ilustra las ventajas técnicas de Vision AI en entornos de baja latencia y alta privacidad.

Conclusión: Hacia un Futuro de Entretenimiento Adaptativo Seguro

En resumen, Vision AI redefine el panorama de los dispositivos multimedia mediante una fusión sofisticada de visión por computadora, aprendizaje automático y arquitectura edge, ofreciendo experiencias altamente personalizadas que responden al estado emocional del usuario. Si bien los beneficios en accesibilidad y engagement son evidentes, los riesgos en ciberseguridad y privacidad demandan implementaciones rigurosas alineadas con estándares globales. Finalmente, el éxito de esta tecnología dependerá de innovaciones continuas que equilibren innovación con ética, pavimentando el camino para televisiones verdaderamente inteligentes en hogares modernos. Para más información, visita la Fuente original.