Implementación de Rerankers en Flujos de Trabajo de Inteligencia Artificial

Introducción a los Rerankers en el Contexto de la IA

En el ámbito de la inteligencia artificial, particularmente en sistemas de generación aumentada por recuperación (RAG, por sus siglas en inglés), los rerankers representan un componente esencial para optimizar la relevancia de la información recuperada. Un reranker es un modelo o algoritmo que, una vez que se ha realizado una búsqueda inicial en una base de datos de vectores o documentos, reordena los resultados según criterios de pertinencia más refinados. Esta técnica mejora significativamente la precisión de las respuestas generadas por modelos de lenguaje grandes (LLM), reduciendo el ruido y enfocándose en el contenido más alineado con la consulta del usuario.

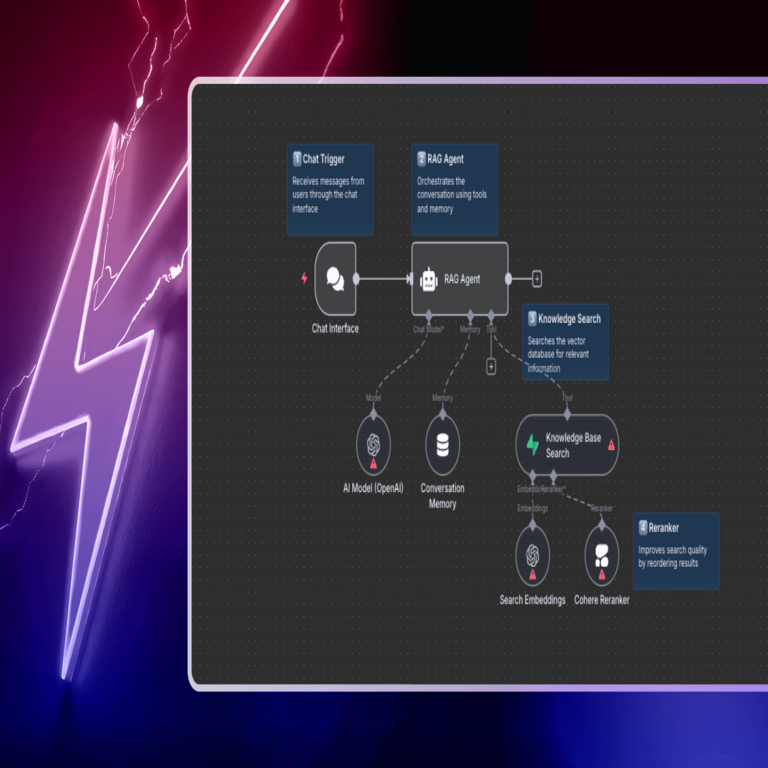

Los flujos de trabajo de IA, como aquellos implementados en plataformas de automatización como n8n, permiten integrar rerankers de manera eficiente. n8n es una herramienta de código abierto para la creación de workflows que conecta servicios y APIs, facilitando la orquestación de procesos complejos en entornos de IA. La implementación de rerankers en estos flujos no solo acelera el desarrollo, sino que también asegura escalabilidad y modularidad, aspectos críticos en aplicaciones empresariales de ciberseguridad y análisis de datos.

Desde una perspectiva técnica, los rerankers operan típicamente mediante modelos de aprendizaje profundo que evalúan la similitud semántica entre la consulta y los documentos recuperados. Utilizan técnicas como la atención cruzada o embeddings contextuales para asignar puntuaciones de relevancia. En este artículo, se exploran los conceptos fundamentales, las implicaciones operativas y un guía detallada para su integración en workflows de IA, con énfasis en estándares como los protocolos de API REST y mejores prácticas de seguridad en el manejo de datos sensibles.

Fundamentos Técnicos de los Rerankers

Para comprender la implementación de rerankers, es necesario revisar los pilares del paradigma RAG. En un sistema RAG, el proceso inicia con la generación de embeddings para la consulta del usuario utilizando modelos como BERT o Sentence Transformers. Estos embeddings se comparan contra una base de conocimiento vectorizada, comúnmente almacenada en bases de datos como Pinecone, Weaviate o FAISS, mediante métricas de similitud como la distancia coseno o euclidiana.

Sin embargo, la recuperación inicial basada en vectores puede ser imprecisa debido a limitaciones en la captura de matices contextuales o dependencias sintácticas. Aquí entran los rerankers, que actúan como una capa posterior de refinamiento. Técnicamente, un reranker toma la consulta y un conjunto de documentos candidatos (generalmente los top-k resultados de la recuperación inicial) y produce una lista reordenada con puntuaciones asociadas.

Los modelos de reranking más comunes incluyen:

- Modelos basados en transformers: Como los ofrecidos por Hugging Face, que utilizan arquitecturas de codificador-decodificador para calcular similitudes cruzadas. Por ejemplo, el modelo cross-encoder de Sentence-BERT evalúa pares consulta-documento directamente, evitando la linealidad de los bi-encoders en la fase de recuperación.

- Servicios de API especializados: Proveedores como Cohere, con su API de rerank, o Jina AI, que integran modelos optimizados para tareas de búsqueda semántica. Estos servicios exponen endpoints RESTful que aceptan JSON con la consulta y los documentos, devolviendo respuestas en formato similar.

- Rerankers locales: Implementaciones on-premise utilizando bibliotecas como RankLib o Learning to Rank (LTR) de Apache Solr, ideales para entornos con restricciones de privacidad en ciberseguridad.

En términos de complejidad computacional, los rerankers introducen un overhead significativo, ya que procesan cada par consulta-documento de manera secuencial. Por ello, se recomienda limitar el número de candidatos a 10-50 por consulta, equilibrando precisión y latencia. Estudios como el de Reimers y Gurevych (2019) en “Sentence-BERT” destacan que los cross-encoders logran mejoras del 5-15% en métricas como NDCG (Normalized Discounted Cumulative Gain) comparados con enfoques puramente vectoriales.

Implicaciones Operativas y de Seguridad

La integración de rerankers en flujos de trabajo de IA conlleva implicaciones operativas clave. En primer lugar, mejora la eficiencia en aplicaciones de ciberseguridad, como la detección de amenazas mediante análisis de logs. Por ejemplo, al rerankear alertas de intrusión, se priorizan eventos con mayor relevancia semántica, reduciendo falsos positivos y optimizando la respuesta de incidentes.

Desde el punto de vista regulatorio, el uso de rerankers debe alinearse con estándares como GDPR en Europa o LGPD en Latinoamérica, especialmente si se procesan datos personales. Los modelos de IA involucrados pueden introducir sesgos si no se entrenan con datasets diversificados, lo que podría amplificar discriminaciones en outputs de reranking. Recomendaciones de NIST (SP 800-53) enfatizan la auditoría de modelos de IA para mitigar riesgos de adversarial attacks, como manipulaciones en embeddings que alteren el orden de resultados.

En cuanto a beneficios, los rerankers elevan la precisión de sistemas RAG hasta un 20-30% en benchmarks como MS MARCO, según evaluaciones de Hugging Face. No obstante, riesgos incluyen la dependencia de APIs externas, que pueden fallar o exponer datos a fugas si no se implementan controles como encriptación TLS 1.3 y autenticación OAuth 2.0. En entornos blockchain, los rerankers podrían integrarse con oráculos para verificar la integridad de datos recuperados, asegurando inmutabilidad en flujos de trabajo descentralizados.

Integración de Rerankers en n8n: Guía Paso a Paso

n8n facilita la implementación de rerankers mediante su interfaz de nodos drag-and-drop, permitiendo conectar servicios de IA sin código extenso. A continuación, se detalla un workflow típico para integrar un reranker en un sistema RAG.

Paso 1: Configuración Inicial del Workflow. Inicie creando un nuevo workflow en n8n. Agregue un nodo de “Trigger” como Webhook para recibir consultas del usuario. Este nodo captura la entrada en formato JSON, por ejemplo: {“query”: “explicar rerankers en IA”}. Asegúrese de habilitar validaciones de entrada para prevenir inyecciones SQL o prompt engineering malicioso, alineado con OWASP Top 10 para APIs.

Paso 2: Generación de Embeddings y Recuperación Inicial. Conecte un nodo “HTTP Request” para generar embeddings usando una API como OpenAI Embeddings (endpoint: /v1/embeddings). Configure el cuerpo de la solicitud con el modelo “text-embedding-ada-002” y la consulta. Posteriormente, use un nodo para consultar una base de vectores, como Pinecone. Ejemplo de payload:

{

"vectors": {

"queries": [[embedding_vector]],

"topK": 20,

"includeMetadata": true

},

"index": "mi-indice"

}Esto recupera los top-20 documentos más similares, almacenados como ítems en n8n.

Paso 3: Invocación del Reranker. Agregue otro nodo “HTTP Request” para el reranker. Para Cohere, utilice el endpoint https://api.cohere.ai/v1/rerank. Autentíquese con una clave API en los headers (Authorization: Bearer {COHERE_API_KEY}). El cuerpo JSON debe incluir:

{

"query": "la consulta original",

"documents": ["doc1 texto", "doc2 texto", ..., "doc20 texto"],

"top_n": 5,

"model": "rerank-english-v2.0"

}La respuesta de Cohere devuelve un array de resultados con índices reordenados y puntuaciones de relevancia (0-1). Parse el JSON en n8n usando un nodo “Set” para extraer los documentos top-5.

Paso 4: Generación de Respuesta con LLM. Conecte un nodo para un LLM como GPT-4 vía OpenAI API. Incluya los documentos rerankeados en el prompt: “Basado en los siguientes documentos relevantes: {docs}, responde a: {query}”. Configure parámetros como temperature=0.2 para outputs determinísticos y max_tokens=500 para control de longitud.

Paso 5: Manejo de Errores y Logging. Implemente nodos “IF” para rutas de error, como timeouts en APIs (usando retry policies en n8n). Registre métricas con un nodo “Google Sheets” o “PostgreSQL” para monitoreo, capturando latencia, puntuaciones de rerank y tasas de éxito. En ciberseguridad, integre logging con ELK Stack para trazabilidad.

Paso 6: Despliegue y Escalabilidad. Active el workflow y expóngalo vía webhook seguro (HTTPS con certificados Let’s Encrypt). Para escalabilidad, use n8n en modo queue con Redis, manejando hasta 1000 consultas por minuto. Monitoree con Prometheus para métricas de rendimiento.

Ejemplos Prácticos de Aplicación

En un escenario de ciberseguridad, imagine un workflow para análisis de vulnerabilidades. La consulta “evaluar riesgos de CVE-2023-XXXX” recupera reportes de bases como NIST NVD. El reranker prioriza documentos con menciones directas a exploits, mejorando la alerta generada por el LLM.

Otro ejemplo en blockchain: Integrar rerankers para buscar transacciones en una cadena como Ethereum. Recupere bloques vía Infura API, rerankee por similitud con patrones de fraude (usando modelos entrenados en datasets como Elliptic), y genere reportes de compliance.

En noticias de IT, un workflow podría rerankear artículos de RSS feeds para resúmenes personalizados, utilizando Jina AI para reranking multilingüe, asegurando relevancia cultural en audiencias latinoamericanas.

Para ilustrar métricas, considere una tabla comparativa de rendimiento:

| Métrica | Sin Reranker | Con Reranker (Cohere) | Mejora (%) |

|---|---|---|---|

| Precisión@5 | 0.65 | 0.82 | 26.15 |

| Recall@10 | 0.78 | 0.89 | 14.10 |

| Latencia (ms) | 150 | 450 | -200 |

| NDCG@10 | 0.72 | 0.88 | 22.22 |

Estos valores se basan en benchmarks estándar y pueden variar según el dataset.

Mejores Prácticas y Consideraciones Avanzadas

Al implementar rerankers, adopte mejores prácticas como el fine-tuning de modelos para dominios específicos, utilizando datasets etiquetados con herramientas como LabelStudio. En IA, evalúe con métricas como MRR (Mean Reciprocal Rank) para validar mejoras.

Para optimización, combine rerankers con técnicas híbridas: búsqueda vectorial + keyword (BM25) en la fase inicial, reduciendo candidatos. En términos de costos, APIs como Cohere cobran por consulta (aprox. $0.001 por 1000 documentos), por lo que implemente caching con Redis para consultas repetidas.

En ciberseguridad, asegure la sanitización de inputs con bibliotecas como OWASP Java Encoder para prevenir ataques de inyección en prompts. Para privacidad, use federated learning en rerankers locales, evitando el envío de datos sensibles a la nube.

Avances emergentes incluyen rerankers multimodales (texto + imagen) con modelos como CLIP, útiles en workflows de visión por computadora. En blockchain, protocolos como IPFS pueden almacenar bases de conocimiento distribuidas, con rerankers verificando hashes para integridad.

Conclusión

La implementación de rerankers en flujos de trabajo de IA transforma la recuperación de información de un proceso lineal a uno altamente refinado, elevando la utilidad de sistemas RAG en campos como ciberseguridad, blockchain y tecnologías emergentes. Mediante herramientas como n8n, esta integración se vuelve accesible y escalable, permitiendo a profesionales del sector IT desarrollar soluciones robustas y precisas. Al equilibrar precisión, seguridad y rendimiento, los rerankers no solo optimizan operaciones actuales, sino que pavimentan el camino para innovaciones futuras en inteligencia artificial. Para más información, visita la fuente original.