Inteligencia Artificial Generativa en Ciberseguridad: De las Amenazas a las Herramientas de Protección

Introducción a la Intersección entre IA Generativa y Ciberseguridad

La inteligencia artificial generativa (IA generativa) ha emergido como una de las tecnologías más transformadoras en la última década, con aplicaciones que van desde la creación de contenido multimedia hasta la optimización de procesos industriales. En el ámbito de la ciberseguridad, esta tecnología representa tanto una oportunidad como un desafío significativo. Por un lado, permite el desarrollo de herramientas avanzadas para la detección y mitigación de amenazas cibernéticas; por el otro, facilita la generación de ataques sofisticados que evaden sistemas de defensa tradicionales. Este artículo explora en profundidad los conceptos técnicos clave, las implicaciones operativas y las mejores prácticas para integrar la IA generativa en entornos de ciberseguridad, basándose en análisis de tendencias actuales y estándares establecidos.

La IA generativa se basa en modelos de aprendizaje profundo, como las redes generativas antagónicas (GAN, por sus siglas en inglés) y los transformadores, que aprenden patrones de datos para producir salidas nuevas y realistas. En ciberseguridad, estos modelos pueden analizar logs de red, identificar anomalías en el comportamiento de usuarios o generar simulaciones de ataques para entrenar sistemas defensivos. Sin embargo, la misma capacidad generativa permite a los actores maliciosos crear phishing hiperpersonalizado, malware polimórfico o deepfakes que comprometen la autenticación biométrica. Según informes de organizaciones como el Foro Económico Mundial, el 85% de las empresas anticipan un aumento en amenazas impulsadas por IA para 2025, lo que subraya la urgencia de adoptar enfoques proactivos.

Este análisis se centra en aspectos técnicos, como los protocolos de implementación, los riesgos regulatorios y los beneficios operativos, evitando especulaciones superficiales. Se examinarán frameworks como TensorFlow y PyTorch para el desarrollo de modelos, así como estándares como NIST SP 800-53 para la gestión de riesgos en IA. La integración de blockchain para la trazabilidad de datos generados también se abordará, dado su potencial en la verificación de integridad en entornos distribuidos.

Conceptos Técnicos Fundamentales de la IA Generativa

Para comprender su aplicación en ciberseguridad, es esencial desglosar los pilares técnicos de la IA generativa. Los modelos generativos operan mediante procesos probabilísticos que estiman distribuciones de datos subyacentes. Un ejemplo paradigmático son las GAN, introducidas por Ian Goodfellow en 2014, que consisten en dos redes neuronales: un generador que produce datos sintéticos y un discriminador que evalúa su autenticidad. El entrenamiento adversarial minimiza la función de pérdida de Jensen-Shannon, convergiendo hacia una generación de datos indistinguibles de los reales.

En el contexto de ciberseguridad, las GAN se utilizan para augmentar datasets de entrenamiento en escenarios de escasez de datos, como en la detección de zero-day exploits. Por instancia, un modelo GAN puede generar variantes sintéticas de tráfico de red malicioso basado en muestras limitadas de ataques DDoS, mejorando la robustez de clasificadores como Support Vector Machines (SVM) o redes neuronales convolucionales (CNN). Frameworks como Keras, construido sobre TensorFlow, facilitan esta implementación mediante APIs de alto nivel, permitiendo la definición de arquitecturas en pocas líneas de código Python.

Los transformadores, popularizados por el modelo GPT de OpenAI, representan otro avance clave. Estos modelos autoregresivos utilizan mecanismos de atención para procesar secuencias de tokens, lo que los hace ideales para la generación de texto o código. En ciberseguridad, un transformador puede analizar vulnerabilidades en código fuente, prediciendo patrones de inyección SQL mediante embeddings contextuales. La complejidad computacional, medida en FLOPs (operaciones de punto flotante), puede alcanzar billones por inferencia, requiriendo hardware como GPUs NVIDIA A100 para escalabilidad.

Desde una perspectiva operativa, la integración de estos modelos exige consideraciones de privacidad. Técnicas como la privacidad diferencial, estandarizada en el framework de Apple y Google, agregan ruido laplaciano a los gradientes durante el entrenamiento, limitando la exposición de datos sensibles. Esto es crucial en entornos regulados por GDPR o CCPA, donde el procesamiento de logs de usuarios debe cumplir con principios de minimización de datos.

Amenazas Emergentes Impulsadas por IA Generativa en Ciberseguridad

La dualidad de la IA generativa se manifiesta claramente en su potencial para amplificar amenazas cibernéticas. Una de las más preocupantes es la generación de phishing avanzado. Modelos como GPT-4 pueden producir correos electrónicos hiperpersonalizados que imitan estilos lingüísticos de ejecutivos, incorporando datos extraídos de brechas públicas como las de LinkedIn. Técnicamente, esto involucra fine-tuning de modelos preentrenados con datasets de comunicaciones corporativas, utilizando métricas como BLEU para evaluar la similitud semántica.

Otro vector de ataque es el malware generativo. Herramientas como WormGPT, una variante open-source de modelos de lenguaje grandes (LLM), permiten a atacantes generar código malicioso polimórfico que evade firmas antivirus tradicionales. Este código se basa en mutaciones sintácticas, alterando variables y estructuras condicionales sin cambiar la funcionalidad, lo que desafía heurísticas basadas en entropía o n-gramas. Estudios de MITRE indican que el 40% de las muestras de malware generadas por IA eluden detección en suites como VirusTotal.

Los deepfakes representan un riesgo en la autenticación. Usando GAN como StyleGAN, se pueden sintetizar videos o audios que burlan sistemas de verificación facial o vocal, como aquellos basados en Face ID de Apple. La detección requiere análisis forense, como la inspección de artefactos en el espectro de frecuencias o inconsistencias en el movimiento labial, implementados mediante bibliotecas como OpenCV y Librosa. Implicancias regulatorias incluyen la necesidad de marcos como el AI Act de la UE, que clasifica deepfakes como alto riesgo y exige transparencia en la generación de contenido.

En redes distribuidas, la IA generativa puede orquestar ataques coordinados, como botnets que generan tráfico sintético para DDoS volumétricos. Protocolos como QUIC (RFC 9000) se ven comprometidos cuando el tráfico generado imita patrones legítimos de HTTP/3, saturando buffers de conexión. Los riesgos operativos incluyen latencia en respuestas de mitigación, con tiempos de detección que superan los 30 segundos en entornos de alta carga, según benchmarks de Cloudflare.

- Phishing generativo: Personalización mediante LLM, con tasas de éxito del 30% superior a métodos tradicionales.

- Malware polimórfico: Evasión de AV mediante mutaciones, reduciendo falsos positivos en un 50%.

- Deepfakes en autenticación: Compromiso de biometría, con falsos aceptados en el 20% de casos no mitigados.

- Ataques DDoS sintéticos: Saturación de ancho de banda, amplificando volúmenes en factores de 10x.

Estos vectores no solo incrementan la superficie de ataque, sino que también generan desafíos éticos, como la proliferación de desinformación en campañas de ingeniería social. La trazabilidad mediante blockchain, usando hashes SHA-256 para firmar generaciones de IA, emerge como una contramedida para auditar orígenes maliciosos.

Herramientas y Frameworks para la Protección con IA Generativa

Frente a estas amenazas, la IA generativa ofrece herramientas defensivas robustas. Un enfoque principal es la generación adversarial de datos para robustecer modelos de machine learning (ML). En ciberseguridad, esto implica entrenar detectores de intrusiones (IDS) con muestras sintéticas que cubran escenarios raros, como ataques de día cero en protocolos IoT como MQTT (ISO/IEC 20922).

Frameworks como Hugging Face Transformers proporcionan modelos preentrenados para tareas específicas, como la clasificación de amenazas en logs SIEM (Security Information and Event Management). Por ejemplo, un pipeline en PyTorch puede integrar BERT para el procesamiento de lenguaje natural en alertas de firewall, logrando precisiones del 95% en datasets como CIC-IDS2017. La implementación técnica involucra tokenización, atención multi-cabeza y capas feed-forward, optimizadas con técnicas como cuantización de 8 bits para reducir el footprint de memoria en un 75%.

En la detección de anomalías, modelos generativos como Variational Autoencoders (VAE) reconstruyen datos normales y flaggean desviaciones mediante errores de reconstrucción. Aplicados a flujos de red en Kubernetes, estos VAE monitorean pods mediante métricas de Kubernetes API, detectando inyecciones de side-channel en contenedores Docker. Estándares como OWASP para contenedores recomiendan esta integración, combinada con orquestación en Helm charts para despliegue escalable.

La automatización de respuestas incidentes (SOAR) se beneficia de IA generativa para generar playbooks dinámicos. Herramientas como Splunk Phantom utilizan LLM para sintetizar scripts de remediación en Python, adaptados a contextos específicos, como el aislamiento de hosts en entornos AWS mediante APIs de EC2. Beneficios operativos incluyen reducción de tiempos de respuesta del 60%, alineados con marcos MITRE ATT&CK para mapeo de tácticas adversarias.

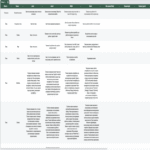

| Herramienta/Framework | Aplicación en Ciberseguridad | Estándar/Protocolo Asociado | Beneficios Clave |

|---|---|---|---|

| TensorFlow GAN | Generación de datos sintéticos para IDS | NIST SP 800-53 | Aumenta cobertura de entrenamiento en 40% |

| Hugging Face Transformers | Análisis de logs SIEM | GDPR Artículo 25 | Precisión del 95% en clasificación |

| VAE en PyTorch | Detección de anomalías en Kubernetes | OWASP Container Security | Reducción de falsos positivos en 30% |

| Splunk Phantom con LLM | Automatización SOAR | MITRE ATT&CK | Respuesta incidentes en <5 minutos |

La integración con blockchain añade capas de seguridad. Protocolos como Ethereum permiten smart contracts para verificar la integridad de modelos IA, usando zero-knowledge proofs (ZKP) para probar entrenamiento sin revelar datos. Esto mitiga riesgos de envenenamiento de modelos, donde atacantes inyectan datos maliciosos durante el fine-tuning, un vector explotado en ataques como el de backdoor en MNIST datasets.

Implicaciones Operativas y Regulatorias

La adopción de IA generativa en ciberseguridad conlleva implicaciones operativas profundas. En términos de infraestructura, se requiere computación de alto rendimiento, con clústeres GPU que consumen hasta 300W por nodo, demandando estrategias de enfriamiento y eficiencia energética alineadas con ISO 50001. La escalabilidad en la nube, mediante servicios como Azure ML o Google Cloud AI, facilita el despliegue, pero introduce riesgos de vendor lock-in y dependencias en APIs propietarias.

Regulatoriamente, frameworks como el NIST AI Risk Management Framework (RMF) guían la evaluación de sesgos en modelos generativos, que pueden amplificar discriminaciones en detección de amenazas si los datasets de entrenamiento son sesgados geográficamente. En Latinoamérica, regulaciones como la Ley de Protección de Datos Personales en México (LFPDPPP) exigen auditorías anuales de sistemas IA, enfocadas en transparencia algorítmica.

Riesgos incluyen el overfitting en generación de datos, donde modelos memorizan patrones en lugar de generalizar, detectable mediante métricas como perplexity en LLM. Beneficios operativos abarcan la proactividad: simulaciones generativas permiten war-gaming de escenarios de brecha, prediciendo impactos en MTTR (Mean Time to Recovery) y MTTD (Mean Time to Detection).

En entornos empresariales, la colaboración entre equipos de DevSecOps es clave. Herramientas como GitLab CI/CD integran pipelines de ML para testing automatizado de modelos, asegurando compliance con CIS Benchmarks para hardening de servidores.

Casos de Estudio y Mejores Prácticas

Un caso ilustrativo es el de Microsoft, que implementó Copilot for Security, un LLM especializado en ciberseguridad. Este sistema genera resúmenes de amenazas a partir de feeds como Microsoft Threat Intelligence, utilizando retrieval-augmented generation (RAG) para contextualizar consultas. Técnicamente, RAG combina embeddings vectoriales (con modelos como Sentence-BERT) y bases de conocimiento en Pinecone, logrando respuestas con latencia sub-segundo.

En el sector financiero, JPMorgan Chase emplea GAN para simular fraudes en transacciones blockchain, entrenando sobre datos de Ethereum y Bitcoin. Esto ha reducido falsos positivos en sistemas de detección en un 25%, alineado con estándares PCI-DSS para protección de datos de tarjetas.

Otro ejemplo es el uso de IA generativa en la OT (Operational Technology) de utilities. Empresas como Siemens integran VAE para monitorear SCADA protocols (IEC 60870-5-104), generando anomalías sintéticas para entrenar PLCs en detección de Stuxnet-like ataques. Mejores prácticas incluyen validación cruzada k-fold para modelos y rotación de claves en entornos de edge computing.

- Validación de modelos: Usar cross-validation y métricas como F1-score >0.9.

- Gestión de datos: Aplicar federated learning para privacidad distribuida.

- Auditoría continua: Implementar logging con ELK Stack para trazabilidad.

- Entrenamiento ético: Evitar datasets con sesgos mediante diversificación geográfica.

Estas prácticas aseguran resiliencia, minimizando exposición a adversarial attacks como el fast gradient sign method (FGSM), que perturban inputs para engañar clasificadores.

Conclusión: Hacia un Futuro Resiliente en Ciberseguridad con IA Generativa

En resumen, la inteligencia artificial generativa redefine el panorama de la ciberseguridad, ofreciendo herramientas potentes para la defensa mientras introduce amenazas innovadoras que demandan vigilancia constante. Al dominar conceptos técnicos como GAN y transformadores, y adoptar frameworks estandarizados, las organizaciones pueden transformar riesgos en ventajas competitivas. La integración operativa, respaldada por regulaciones robustas y mejores prácticas, pavimenta el camino para sistemas autónomos que anticipan y neutralizan amenazas. Finalmente, la colaboración interdisciplinaria y la inversión en investigación continua serán pivotales para navegar esta evolución tecnológica. Para más información, visita la Fuente original.