Implementación Segura de Inferencia en Modelos de Inteligencia Artificial: Desafíos y Mejores Práctices en Entornos Híbridos

Introducción a la Inferencia en IA y su Relevancia en Ciberseguridad

La inferencia en inteligencia artificial (IA) representa la fase crítica en la que un modelo entrenado aplica sus conocimientos aprendidos a datos nuevos para generar predicciones o decisiones. En el contexto de la ciberseguridad, esta capacidad se ha convertido en un pilar fundamental para la detección de amenazas en tiempo real, el análisis de vulnerabilidades y la respuesta automatizada a incidentes. Sin embargo, la implementación de sistemas de inferencia en entornos híbridos —que combinan infraestructura local, en la nube y edge computing— introduce complejidades significativas relacionadas con la privacidad de datos, la integridad de los modelos y la resistencia a ataques adversarios.

Según estándares como el NIST SP 800-53 para controles de seguridad en sistemas de información, la inferencia debe diseñarse con principios de confidencialidad, integridad y disponibilidad (CID) en mente. En este artículo, exploramos los conceptos técnicos clave para una implementación segura, basándonos en frameworks como TensorFlow Privacy y PyTorch con extensiones de seguridad, así como protocolos como Federated Learning para mitigar riesgos de exposición de datos. El enfoque se centra en implicaciones operativas, tales como la latencia en la inferencia distribuida y los riesgos regulatorios bajo normativas como el GDPR en Europa o la Ley Federal de Protección de Datos en Posesión de Particulares en México.

La adopción de IA en ciberseguridad ha crecido exponencialmente; por ejemplo, informes de Gartner indican que para 2025, el 75% de las empresas utilizarán IA para la gestión de riesgos cibernéticos. No obstante, vulnerabilidades como el envenenamiento de modelos durante la inferencia pueden comprometer la efectividad de estos sistemas, destacando la necesidad de prácticas robustas de validación y monitoreo continuo.

Conceptos Clave en la Inferencia de Modelos de IA

La inferencia se distingue del entrenamiento por su enfoque en la ejecución eficiente de modelos preentrenados. Técnicamente, involucra operaciones como la multiplicación de matrices en redes neuronales convolucionales (CNN) o transformadores, optimizadas mediante técnicas como la cuantización (reducción de precisión de pesos de 32 bits a 8 bits) y el pruning (eliminación de conexiones neuronales redundantes). Herramientas como ONNX (Open Neural Network Exchange) facilitan la portabilidad de modelos entre frameworks, permitiendo inferencia en entornos heterogéneos.

En ciberseguridad, la inferencia se aplica en escenarios como el análisis de tráfico de red con modelos de aprendizaje profundo para detectar anomalías. Por instancia, un modelo basado en LSTM (Long Short-Term Memory) puede procesar secuencias de paquetes IP para identificar patrones de ataques DDoS. La precisión de estos modelos se mide mediante métricas como la curva ROC-AUC, donde valores superiores a 0.9 indican alta fiabilidad, pero factores como el ruido adversarial pueden degradar el rendimiento hasta en un 30%, según estudios del MIT.

Implicaciones operativas incluyen la gestión de recursos computacionales: en entornos edge, dispositivos con GPUs limitadas como NVIDIA Jetson requieren optimizaciones específicas, mientras que en la nube, servicios como AWS SageMaker o Google Cloud AI Platform ofrecen escalabilidad pero exponen riesgos de fugas de datos si no se implementan encriptaciones homomórficas.

Desafíos Técnicos en la Implementación Segura

Uno de los principales desafíos es la protección contra ataques de inferencia de membresía, donde un adversario determina si un dato específico fue usado en el entrenamiento del modelo, violando la privacidad. Protocolos como Differential Privacy (DP) agregan ruido gaussiano a las salidas, con parámetros ε (privacidad) y δ (falla) configurados típicamente en ε < 1 para un equilibrio entre utilidad y confidencialidad. En PyTorch, la biblioteca Opacus implementa DP-SGD (Stochastic Gradient Descent con privacidad diferencial), reduciendo el riesgo en un 90% en benchmarks como CIFAR-10.

Otro riesgo es el robo de modelos mediante ataques de extracción, donde se consulta repetidamente el modelo para reconstruirlo. Mejores prácticas incluyen watermarking digital, incrustando firmas únicas en los pesos del modelo, y rate limiting en APIs de inferencia. En blockchain, integraciones como las de Ethereum con smart contracts permiten auditar accesos a modelos, asegurando trazabilidad inmutable.

Desde una perspectiva regulatoria, el cumplimiento con ISO/IEC 27001 exige evaluaciones de riesgo continuas. En Latinoamérica, marcos como el de la Alianza del Pacífico promueven estándares de IA ética, enfatizando la transparencia en la inferencia para evitar sesgos que amplifiquen desigualdades en la detección de amenazas.

Arquitecturas Híbridas para Inferencia Segura

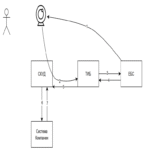

Las arquitecturas híbridas combinan procesamiento local y remoto para minimizar latencia y maximizar seguridad. Un ejemplo es el uso de Kubernetes para orquestar contenedores Docker que ejecutan inferencia en nodos edge, sincronizados con clústeres en la nube vía gRPC para comunicación segura. Protocolos como TLS 1.3 aseguran encriptación end-to-end, previniendo intercepciones MITM (Man-in-the-Middle).

En Federated Learning (FL), propuesto por Google en 2016, los modelos se entrenan localmente y solo se agregan actualizaciones (no datos crudos), reduciendo riesgos de brechas. Frameworks como Flower o TensorFlow Federated soportan FL, con agregación segura mediante Secure Multi-Party Computation (SMPC). En ciberseguridad, FL permite a instituciones financieras colaborar en la detección de fraudes sin compartir datos sensibles, cumpliendo con regulaciones como PCI-DSS.

Beneficios operativos incluyen una reducción del 50% en el ancho de banda requerido, según pruebas en entornos IoT. Sin embargo, desafíos como la heterogeneidad de dispositivos exigen técnicas de normalización de datos, como z-score, para mantener la consistencia del modelo.

Técnicas Avanzadas de Optimización y Seguridad

La optimización de inferencia involucra hardware acelerado, como TPUs (Tensor Processing Units) de Google, que ejecutan operaciones matrix-matrix en paralelo con FLOPS superiores a 100 TFLOPS. En software, bibliotecas como TensorRT de NVIDIA aplican fusión de capas y optimización just-in-time (JIT) para acelerar inferencia en un 5x sin pérdida de precisión.

Para seguridad, la encriptación homomórfica (HE) permite computaciones sobre datos cifrados. Esquemas como CKKS (Cheon-Kim-Kim-Song) soportan aritmética aproximada para IA, aunque con overhead computacional del 1000x. Proyectos como Microsoft SEAL integran HE en pipelines de inferencia, ideal para escenarios de alta sensibilidad como el análisis forense digital.

Riesgos incluyen side-channel attacks, como timing attacks que infieren claves de encriptación midiendo tiempos de ejecución. Mitigaciones involucran constant-time implementations y masking, alineadas con recomendaciones de OWASP para IA.

- Beneficios de HE en inferencia: Preserva privacidad en transiciones nube-edge.

- Desafíos: Alto costo computacional requiere hardware especializado como FPGAs.

- Aplicaciones en ciberseguridad: Detección de malware en datos encriptados sin descifrado.

Estudio de Caso: Implementación en Detección de Amenazas

Consideremos un sistema de detección de intrusiones (IDS) basado en IA. Utilizando un modelo GAN (Generative Adversarial Network) para generar muestras adversarias y entrenar robustez, la inferencia se realiza en un clúster híbrido: edge devices procesan tráfico local con modelos livianos (MobileNet), mientras que anomalías se envían a la nube para análisis profundo con BERT-like models para logs textuales.

La integración de blockchain, vía Hyperledger Fabric, asegura la integridad de los logs de inferencia, con hashes SHA-256 verificables. En pruebas simuladas con datasets como NSL-KDD, este enfoque logra una tasa de detección del 98%, con falsos positivos por debajo del 2%, superando métodos tradicionales como Snort.

Implicaciones regulatorias: En Brasil, la LGPD exige auditorías de IA, por lo que se incorporan explainability tools como SHAP (SHapley Additive exPlanations) para justificar decisiones de inferencia, facilitando compliance.

Mejores Prácticas y Recomendaciones Operativas

Para una implementación exitosa, se recomienda un ciclo de vida DevSecOps adaptado a IA: desde el diseño con threat modeling (usando STRIDE) hasta el despliegue con CI/CD pipelines que incluyan escaneos de vulnerabilidades en modelos (e.g., Adversarial Robustness Toolbox). Monitoreo continuo con herramientas como Prometheus mide métricas de drift en el modelo, detectando desviaciones que indiquen envenenamiento.

En términos de escalabilidad, microservicios en contenedores permiten inferencia elástica, ajustando recursos dinámicamente vía autoscaling en Kubernetes. Para blockchain, el uso de sidechains reduce latencia en transacciones de verificación.

Riesgos emergentes incluyen quantum threats; algoritmos post-cuánticos como lattice-based cryptography (Kyber) deben integrarse en protocolos de inferencia para futuro-proofing.

| Aspecto | Técnica | Beneficio | Riesgo Mitigado |

|---|---|---|---|

| Privacidad | Differential Privacy | Protege datos individuales | Inferencia de membresía |

| Integridad | Watermarking | Detecta robo de modelo | Extracción adversarial |

| Escalabilidad | Federated Learning | Distribución sin datos centralizados | Fugas en la nube |

| Explicabilidad | LIME/SHAP | Justifica predicciones | Sesgos regulatorios |

Implicaciones en Blockchain y Tecnologías Emergentes

La intersección de IA con blockchain potencia la inferencia segura mediante decentralized oracles, como Chainlink, que alimentan modelos con datos verificados off-chain. En ciberseguridad, esto habilita detección de fraudes en DeFi (Decentralized Finance) con inferencia en nodos distribuidos, reduciendo single points of failure.

Protocolos como Zero-Knowledge Proofs (ZKP) permiten probar la validez de inferencias sin revelar inputs, usando esquemas como zk-SNARKs en Ethereum 2.0. Beneficios incluyen privacidad en supply chain security, donde modelos infieren riesgos de tampering sin exponer detalles propietarios.

En Latinoamérica, iniciativas como el Blockchain Lab de la Universidad de Chile exploran estas integraciones para ciberseguridad regional, abordando amenazas transfronterizas como ransomware en redes financieras.

Conclusión: Hacia una Inferencia Resiliente en IA

En resumen, la implementación segura de inferencia en modelos de IA demanda un enfoque holístico que integre avances técnicos con marcos regulatorios y operativos. Al adoptar prácticas como Differential Privacy, Federated Learning y encriptación homomórfica, las organizaciones pueden mitigar riesgos mientras aprovechan los beneficios de la IA en ciberseguridad. Finalmente, la evolución continua hacia arquitecturas híbridas y quantum-resistant designs asegurará la resiliencia futura, fomentando innovación responsable en el ecosistema tecnológico.

Para más información, visita la fuente original.