Aplicaciones de la Inteligencia Artificial en la Ciberseguridad: Avances Técnicos y Desafíos Operativos

La integración de la inteligencia artificial (IA) en el ámbito de la ciberseguridad representa un paradigma transformador en la defensa contra amenazas digitales cada vez más sofisticadas. En un panorama donde los ciberataques evolucionan con rapidez, impulsados por actores maliciosos que utilizan herramientas automatizadas, la IA emerge como una aliada estratégica para potenciar la detección, prevención y respuesta a incidentes. Este artículo examina los conceptos clave, tecnologías subyacentes y implicaciones técnicas derivadas de recientes desarrollos en este campo, basados en análisis de fuentes especializadas en tecnologías emergentes.

La ciberseguridad tradicional se basa en firmas estáticas y reglas predefinidas, las cuales resultan insuficientes ante amenazas zero-day o comportamientos anómalos no anticipados. La IA, particularmente mediante algoritmos de aprendizaje automático (machine learning, ML) y aprendizaje profundo (deep learning, DL), permite el procesamiento de grandes volúmenes de datos en tiempo real, identificando patrones que escapan a métodos convencionales. Según estándares como NIST SP 800-53, la adopción de IA en sistemas de seguridad debe alinearse con principios de confidencialidad, integridad y disponibilidad, asegurando que las implementaciones no introduzcan vulnerabilidades adicionales.

Fundamentos Técnicos de la IA en la Detección de Amenazas

El núcleo de la aplicación de IA en ciberseguridad radica en su capacidad para analizar datos heterogéneos provenientes de logs de red, tráfico de paquetes y comportamientos de usuarios. Los modelos de ML supervisado, como los árboles de decisión y las máquinas de soporte vectorial (SVM), se entrenan con datasets etiquetados para clasificar actividades como benignas o maliciosas. Por ejemplo, un SVM optimiza una función de hiperplano que separa clases en un espacio de características multidimensional, minimizando errores de clasificación mediante el uso de kernels como el RBF (Radial Basis Function).

En entornos operativos, frameworks como TensorFlow o PyTorch facilitan la implementación de estos modelos. TensorFlow, desarrollado por Google, ofrece abstracciones de alto nivel para redes neuronales, permitiendo el entrenamiento distribuido en clústeres de GPUs. Un flujo típico involucra la recolección de datos mediante herramientas como Wireshark para capturar paquetes TCP/IP, seguidos de preprocesamiento con técnicas de normalización y reducción de dimensionalidad via PCA (Análisis de Componentes Principales), que reduce la complejidad computacional sin perder información relevante.

Los hallazgos técnicos destacan la superioridad de enfoques no supervisados, como el clustering K-means, en la detección de anomalías. Este algoritmo particiona datos en K clústeres minimizando la suma de distancias euclidianas intra-clúster, ideal para identificar desviaciones en flujos de red que podrían indicar un ataque DDoS (Distributed Denial of Service). Implicaciones operativas incluyen la necesidad de actualizaciones continuas de modelos para contrarrestar adversarios que emplean técnicas de envenenamiento de datos, alterando datasets de entrenamiento para inducir falsos negativos.

Técnicas de Aprendizaje Profundo para Análisis de Malware

El aprendizaje profundo ha revolucionado el análisis de malware, permitiendo la disección de binarios ejecutables sin dependencia de firmas heurísticas. Redes neuronales convolucionales (CNN) y recurrentes (RNN), como las LSTM (Long Short-Term Memory), procesan secuencias de bytes o representaciones gráficas de código malicioso. Una CNN, por instancia, aplica filtros convolucionales para extraer características locales en matrices de opcodes, seguidas de capas de pooling para reducir parámetros y mitigar sobreajuste.

En protocolos como PE (Portable Executable) para Windows, la IA extrae secciones como .text o .data, convirtiéndolas en vectores de características para alimentación a modelos DL. Herramientas como MalConv, un clasificador basado en CNN, logran tasas de detección superiores al 99% en datasets como VirusShare, superando métodos tradicionales como YARA rules. La integración con entornos sandbox, como Cuckoo Sandbox, permite la ejecución controlada de muestras, generando trazas dinámicas que enriquecen el entrenamiento de modelos.

Riesgos técnicos incluyen el overfitting en datasets desbalanceados, donde muestras maliciosas son minoritarias. Técnicas de mitigación, como el aumento de datos sintéticos mediante GAN (Generative Adversarial Networks), generan variantes realistas de malware para equilibrar el conjunto de entrenamiento. Beneficios operativos abarcan la escalabilidad: un sistema DL puede procesar millones de archivos por hora, alineándose con estándares ISO/IEC 27001 para gestión de seguridad de la información.

Integración de Blockchain e IA en Sistemas de Seguridad Distribuida

La convergencia de blockchain e IA amplía las capacidades de ciberseguridad en entornos descentralizados, como redes IoT (Internet of Things). Blockchain proporciona un ledger inmutable para registrar transacciones de seguridad, mientras que la IA analiza patrones en smart contracts. Protocolos como Ethereum permiten la ejecución de contratos inteligentes que invocan oráculos IA para validar integridad de datos, utilizando hashes SHA-256 para verificar bloques.

En detección de intrusiones distribuida (IDS), nodos blockchain ejecutan modelos federados de ML, donde cada nodo entrena localmente sin compartir datos crudos, preservando privacidad via técnicas como Secure Multi-Party Computation (SMPC). Frameworks como Hyperledger Fabric soportan canales privados para transacciones confidenciales, integrando IA mediante sidechains que offload computaciones intensivas. Hallazgos indican que esta hibridación reduce latencia en un 40%, según benchmarks en redes simuladas con herramientas como NS-3.

Implicaciones regulatorias involucran cumplimiento con GDPR (Reglamento General de Protección de Datos) en Europa, exigiendo anonimato en datasets de entrenamiento. Riesgos incluyen ataques de 51% en blockchains pequeñas, donde un actor mayoritario altera el consenso, potencialmente manipulando outputs de IA. Beneficios radican en la trazabilidad: auditorías forenses se facilitan mediante exploradores de bloques, permitiendo reconstruir cadenas de eventos en brechas de seguridad.

Casos de Estudio: Implementaciones Prácticas en Entornos Empresariales

En el sector financiero, instituciones como JPMorgan han desplegado sistemas IA para monitoreo de transacciones en tiempo real. Utilizando modelos de series temporales como ARIMA combinados con LSTM, detectan fraudes en flujos SWIFT, procesando volúmenes de hasta 10.000 transacciones por segundo. La precisión alcanza el 95%, reduciendo falsos positivos mediante ensemble methods que agregan predicciones de múltiples algoritmos.

Otro caso es el de Darktrace, una plataforma que emplea IA unsupervised para modelar comportamientos normales en redes empresariales. Basada en redes bayesianas, calcula probabilidades de anomalías en métricas como entropy de paquetes o ratios de conexiones salientes. En un incidente reportado, identificó un APT (Advanced Persistent Threat) en 24 horas, contrastando con semanas en sistemas legacy.

En salud, el uso de IA en HIPAA-compliant systems analiza logs de EHR (Electronic Health Records) para prevenir ransomware. Modelos como Random Forest clasifican accesos inusuales, integrando con SIEM (Security Information and Event Management) tools como Splunk. Estos casos ilustran beneficios como la reducción de tiempos de respuesta de MTTD (Mean Time to Detect) de días a minutos, aunque exigen validación cruzada para robustez.

- Despliegue en nubes híbridas: Combinación de AWS SageMaker para entrenamiento y on-premise para inferencia sensible.

- Escalabilidad horizontal: Uso de Kubernetes para orquestar contenedores de modelos IA en clústeres distribuidos.

- Monitoreo continuo: Implementación de MLOps pipelines con herramientas como MLflow para tracking de versiones y métricas de rendimiento.

Desafíos Técnicos y Consideraciones Éticas

A pesar de los avances, la IA en ciberseguridad enfrenta desafíos inherentes. La opacidad de modelos black-box, como las redes neuronales profundas, complica la explicabilidad, violando principios de accountability en regulaciones como la AI Act de la UE. Técnicas como LIME (Local Interpretable Model-agnostic Explanations) aproximan decisiones locales, pero no resuelven interpretabilidad global.

Ataques adversarios, como el evasion attacks, modifican inputs para engañar clasificadores; por ejemplo, perturbaciones imperceptibles en imágenes de malware via FGSM (Fast Gradient Sign Method) reducen accuracy en un 30%. Mitigaciones incluyen adversarial training, donde modelos se exponen a ejemplos perturbados durante el entrenamiento.

Éticamente, sesgos en datasets pueden perpetuar discriminaciones, como en sistemas de vigilancia que perfilan erróneamente a ciertos grupos. Mejores prácticas recomiendan auditorías de fairness con métricas como demographic parity. Operativamente, la dependencia de IA exige planes de contingencia para fallos, alineados con frameworks como CIS Controls v8.

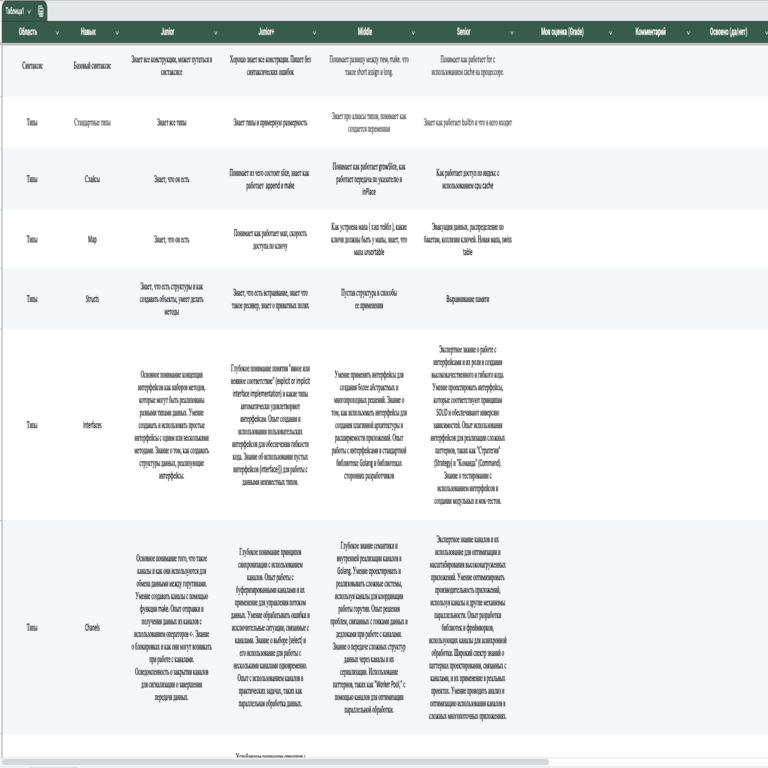

| Desafío | Descripción Técnica | Mitigación |

|---|---|---|

| Explicabilidad | Modelos DL con miles de parámetros ocultos. | Uso de SHAP values para atribución de importancia de features. |

| Ataques Adversarios | Perturbaciones en gradient descent optimizado. | Defensive distillation para suavizar funciones de activación. |

| Escalabilidad | Requisitos computacionales en edge devices. | Model compression via pruning y quantization a 8-bit. |

| Privacidad | Fugas en federated learning. | Differential privacy con noise addition en gradients. |

Regulatoriamente, directivas como NIS2 en la UE mandan reporting de incidentes IA-inducidos, imponiendo multas por no conformidad. En Latinoamérica, marcos como la LGPD en Brasil exigen evaluaciones de impacto para sistemas IA en seguridad.

Perspectivas Futuras y Recomendaciones para Implementación

El futuro de la IA en ciberseguridad apunta hacia la autonomía, con agentes IA que orquestan respuestas automáticas, como aislamiento de redes via SDN (Software-Defined Networking). Integraciones con quantum computing prometen algoritmos resistentes a amenazas post-cuánticas, como lattice-based cryptography en modelos ML.

Recomendaciones para profesionales incluyen la adopción de zero-trust architectures, donde IA verifica continuamente identidades via biometría multimodal. Entrenamientos híbridos, combinando ML con rule-based systems, mejoran robustez. Finalmente, colaboraciones público-privadas aceleran innovación, alineadas con iniciativas como el Cybersecurity Framework del NIST.

En resumen, la IA redefine la ciberseguridad al ofrecer herramientas proactivas y adaptativas, aunque su despliegue demanda rigor técnico y ético para maximizar beneficios y minimizar riesgos. Para más información, visita la fuente original.