Entrenamiento de Modelos de Inteligencia Artificial para la Detección de Deepfakes

Introducción a los Deepfakes y su Impacto en la Ciberseguridad

Los deepfakes representan una de las amenazas más emergentes en el ámbito de la ciberseguridad y la inteligencia artificial. Estos contenidos multimedia falsos, generados mediante técnicas de aprendizaje profundo, permiten la manipulación realista de videos e imágenes, lo que plantea desafíos significativos en la verificación de la información auténtica. En un contexto donde la desinformación puede influir en procesos electorales, fraudes financieros y daños a la reputación personal, el desarrollo de modelos de IA para su detección se ha convertido en una prioridad técnica.

El entrenamiento de tales modelos implica el uso de redes neuronales convolucionales (CNN, por sus siglas en inglés) y técnicas de aprendizaje supervisado, adaptadas a datasets especializados que incluyen muestras tanto reales como manipuladas. Este artículo explora en profundidad el proceso técnico de entrenamiento, desde la preparación de datos hasta la evaluación de rendimiento, destacando las implicaciones operativas y regulatorias en entornos profesionales de TI y ciberseguridad.

La relevancia de este tema radica en su intersección con estándares como el GDPR en Europa o regulaciones emergentes en EE.UU. sobre manipulación de medios digitales, donde la detección precisa no solo mitiga riesgos, sino que también cumple con obligaciones de diligencia en plataformas de contenido. A continuación, se detalla el marco conceptual y práctico para implementar soluciones robustas.

Conceptos Fundamentales de los Deepfakes

Los deepfakes se basan en algoritmos generativos antagónicos (GAN, por sus siglas en inglés), que consisten en dos redes neuronales: un generador que crea contenido falso y un discriminador que intenta distinguirlo del real. Esta arquitectura, propuesta originalmente por Ian Goodfellow en 2014, ha evolucionado para producir manipulaciones faciales hiperrealistas utilizando encoders-decoders como autoencoders variacionales.

Técnicamente, un deepfake típico implica la extracción de características faciales mediante landmarks detection (por ejemplo, con bibliotecas como dlib o MediaPipe), seguidas de la síntesis de frames interpolados. Los métodos comunes incluyen FaceSwap y DeepFaceLab, que operan sobre resoluciones de 256×256 píxeles o superiores, incorporando ruido gaussiano para mejorar la robustez. Sin embargo, estas técnicas dejan artefactos detectables, como inconsistencias en el parpadeo ocular, iluminación irregular o artefactos en los bordes faciales, que sirven como señales para modelos de detección.

En términos de ciberseguridad, los deepfakes facilitan ataques como el spoofing en sistemas biométricos o la suplantación en videollamadas de verificación de identidad. Según informes de la NIST (National Institute of Standards and Technology), la tasa de éxito de deepfakes en evadir controles básicos supera el 90% en escenarios no protegidos, subrayando la necesidad de contramedidas basadas en IA.

Datasets y Preparación de Datos para el Entrenamiento

La calidad de los datasets es crucial para el éxito del entrenamiento. Uno de los más utilizados es FaceForensics++, un repositorio que contiene más de 1.000 videos originales manipulados con cuatro métodos: Deepfakes, Face2Face, FaceSwap y NeuralTextures. Este dataset incluye versiones a baja, media y alta calidad (compresión H.264 a tasas de 0.5, 2.5 y 5.0 CRF), totalizando aproximadamente 1.8 millones de frames etiquetados como reales o falsos.

Otros datasets relevantes incluyen Celeb-DF, con 5.900 videos de celebridades manipulados, y FF++-Mobile, optimizado para dispositivos edge. La preparación de datos involucra preprocesamiento como alineación facial mediante MTCNN (Multi-task Cascaded Convolutional Networks), normalización de píxeles a rangos [0,1] y aumento de datos con técnicas como rotaciones, flips horizontales y ajustes de brillo para mitigar overfitting.

En la práctica, se divide el dataset en conjuntos de entrenamiento (70%), validación (15%) y prueba (15%), asegurando estratificación por método de manipulación para evitar sesgos. Herramientas como OpenCV para extracción de frames y TensorFlow Datasets para carga eficiente facilitan este proceso. Además, se deben considerar implicaciones éticas, como el consentimiento en datasets públicos, alineadas con directrices de la IEEE sobre IA responsable.

- Extracción de regiones de interés (ROI): Enfocarse en la cara para reducir dimensionalidad, utilizando bounding boxes de 224×224 píxeles.

- Balanceo de clases: Aplicar undersampling en muestras reales o SMOTE para falsos, manteniendo una ratio 1:1.

- Filtrado de ruido: Remover frames con baja confianza de detección facial (<0.9) para mejorar la integridad de los datos.

Esta preparación no solo optimiza el rendimiento computacional, sino que también aborda riesgos operativos como la propagación de sesgos en modelos desplegados en producción.

Arquitecturas de Modelos para Detección de Deepfakes

Las CNNs son el pilar de los modelos de detección, gracias a su capacidad para extraer características espaciales jerárquicas. Una arquitectura base es MesoNet, diseñada específicamente para deepfakes, con capas convolucionales de 3×3 kernels y activaciones ReLU, seguida de una capa de salida sigmoide para clasificación binaria.

Sin embargo, modelos preentrenados como Xception, basado en Inception con depthwise separable convolutions, ofrecen superior rendimiento mediante transfer learning. Xception, con 71 capas y más de 20 millones de parámetros, se inicializa con pesos de ImageNet y se fine-tunea en datasets de deepfakes, alcanzando accuracies superiores al 95% en FaceForensics++.

Otras opciones incluyen EfficientNet, que optimiza la eficiencia computacional mediante compound scaling, o Vision Transformers (ViT), que procesan secuencias de parches faciales con mecanismos de atención self-attention. En implementaciones híbridas, se combinan CNNs con RNNs (como LSTMs) para analizar secuencias temporales, detectando inconsistencias en el movimiento labial o expresiones faciales a lo largo de frames consecutivos.

Desde una perspectiva técnica, el entrenamiento utiliza optimizadores como Adam con learning rate de 1e-4, batch sizes de 32 y early stopping basado en pérdida de validación. Frameworks como Keras sobre TensorFlow permiten la definición de modelos en pocas líneas, incorporando callbacks para reducción de learning rate en plateau.

| Arquitectura | Parámetros Principales | Accuracy en FaceForensics++ (Alta Calidad) | Complejidad Computacional (FLOPs) |

|---|---|---|---|

| MesoNet | 8 capas convolucionales, 1 FC | 92% | ~1.2 GFLOPs |

| Xception | 71 capas, depthwise conv | 98% | ~8.4 GFLOPs |

| EfficientNet-B0 | Compound scaling, MBConv | 96% | ~0.39 GFLOPs |

| ViT-Base | 12 capas transformer, 86M params | 97% | ~17.6 GFLOPs |

Esta tabla ilustra el trade-off entre precisión y eficiencia, esencial para despliegues en entornos de baja latencia como navegadores web o apps móviles.

Proceso de Entrenamiento y Optimización

El entrenamiento inicia con la carga del dataset en formato TFRecord para eficiencia I/O. Se define una función de pérdida binaria cross-entropy, adecuada para clasificación desbalanceada, complementada con métricas como precisión, recall y F1-score. Para manejar la variabilidad de manipulaciones, se emplea ensemble learning, combinando predicciones de múltiples modelos mediante votación mayoritaria o promedios de logits.

La optimización involucra regularización L2 (peso 1e-4) para prevenir overfitting, y dropout (tasa 0.5) en capas densas. En escenarios avanzados, se integra aprendizaje semi-supervisado con técnicas como MixMatch, utilizando datos no etiquetados de videos públicos para mejorar generalización.

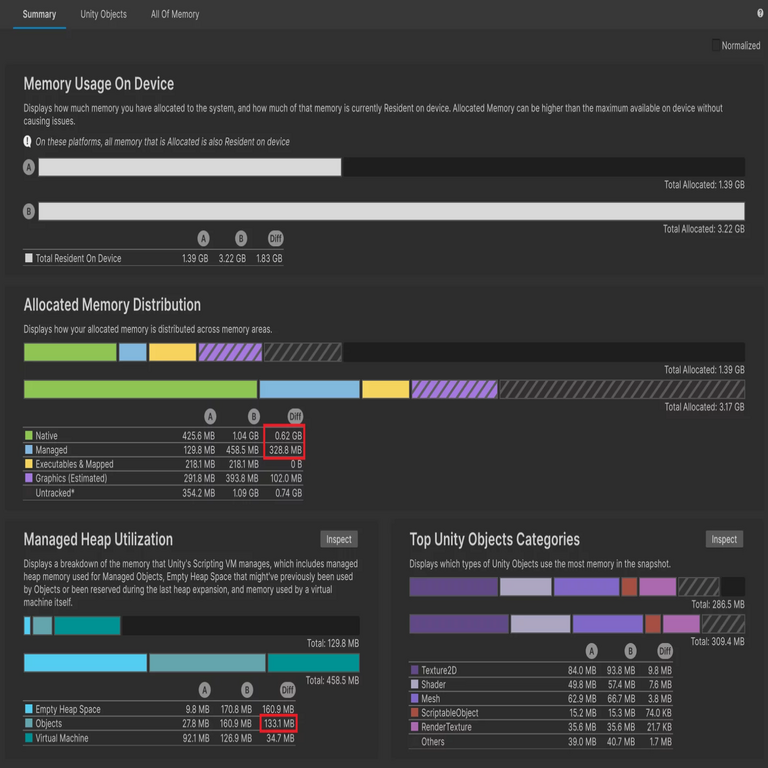

Desde el punto de vista operativo, el entrenamiento requiere hardware como GPUs NVIDIA con CUDA 11+, consumiendo hasta 16 GB de VRAM para batches grandes. Plataformas cloud como Google Colab o AWS SageMaker facilitan escalabilidad, con costos estimados en 0.5-2 USD por hora de entrenamiento. Monitoreo con TensorBoard permite visualizar curvas de aprendizaje, detectando divergencias tempranas.

Implicaciones regulatorias incluyen el cumplimiento de estándares como ISO/IEC 42001 para gestión de IA, asegurando trazabilidad en el pipeline de entrenamiento. Riesgos como adversarial attacks, donde se perturban inputs con FGSM (Fast Gradient Sign Method), deben mitigarse mediante adversarial training, agregando muestras perturbadas al dataset.

- Hiperparámetros clave: Epochs: 50-100; Learning rate scheduler: Cosine annealing; Batch normalization: Activado en todas las capas convolucionales.

- Validación cruzada: K-fold con k=5 para robustez estadística.

- Post-entrenamiento: Cuantización a 8 bits para inferencia eficiente en edge devices.

Estos pasos garantizan modelos deployables en pipelines de ciberseguridad, como integraciones con API de verificación de video en plataformas como YouTube o Zoom.

Evaluación de Modelos y Métricas de Rendimiento

La evaluación se centra en métricas que capturan tanto la precisión global como la sensibilidad a falsos positivos. La accuracy mide la proporción correcta de clasificaciones, pero para datasets desbalanceados, el AUC-ROC (Area Under the Curve – Receiver Operating Characteristic) es preferible, con valores >0.95 indicando alto rendimiento.

Otras métricas incluyen precision (TP/(TP+FP)), recall (TP/(TP+FN)) y specificity (TN/(TN+FP)), donde TP son verdaderos positivos (deepfakes detectados), etc. En FaceForensics++, Xception logra AUC de 0.99 en alta calidad, pero cae a 0.85 en baja calidad debido a artefactos de compresión que enmascaran manipulaciones.

Pruebas en escenarios reales involucran cross-dataset evaluation, probando modelos entrenados en FF++ contra Celeb-DF para medir generalización. Herramientas como scikit-learn facilitan el cómputo de estas métricas, mientras que visualizaciones de saliency maps (con Grad-CAM) revelan qué regiones faciales (ojos, boca) contribuyen más a las decisiones.

Beneficios operativos incluyen reducción de tiempos de respuesta en sistemas de moderación de contenido, con latencias <100 ms por frame en hardware estándar. Riesgos persisten en zero-day deepfakes, donde modelos obsoletos fallan, requiriendo actualizaciones continuas vía MLOps pipelines con CI/CD.

Desafíos Técnicos y Avances Emergentes

Uno de los principales desafíos es la evolución rápida de técnicas de generación de deepfakes, como StyleGAN3 o diffusion models (e.g., Stable Diffusion adaptado a video), que producen artefactos mínimos. Esto demanda modelos adaptativos, posiblemente con aprendizaje por refuerzo para detección en tiempo real.

En ciberseguridad, la integración con blockchain para verificación inmutable de videos (e.g., usando hashes SHA-256 en metadatos) complementa la IA, alineándose con estándares como W3C Verifiable Credentials. Avances incluyen multimodal detection, fusionando audio (análisis de spectrogramas con Wav2Vec) y video para detectar desincronizaciones labiales.

Regulatoriamente, iniciativas como la AI Act de la UE clasifican detectores de deepfakes como sistemas de alto riesgo, exigiendo auditorías y transparencia en datasets. En Latinoamérica, marcos como la Ley de Protección de Datos en México enfatizan la prevención de daños por desinformación.

Investigaciones recientes, como el uso de federated learning para entrenar modelos distribuidos sin compartir datos sensibles, abordan preocupaciones de privacidad. Frameworks como Flower o TensorFlow Federated permiten colaboración entre entidades sin centralización, reduciendo riesgos de brechas.

- Escalabilidad: Despliegue en Kubernetes para procesamiento paralelo de streams de video.

- Ética: Implementación de fairness checks con AIF360 para detectar sesgos raciales o de género en detección facial.

- Futuro: Integración con quantum computing para optimización de hiperparámetros, aunque aún en etapas experimentales.

Estos avances posicionan la detección de deepfakes como un campo dinámico, con potencial para mitigar amenazas globales en TI.

Implicaciones Operativas y Mejores Prácticas

En entornos empresariales, el despliegue de estos modelos requiere integración con sistemas existentes, como SIEM (Security Information and Event Management) para alertas automáticas. Mejores prácticas incluyen versioning de modelos con MLflow, monitoreo de drift de datos y rotación periódica de claves en APIs de inferencia.

Beneficios incluyen fortalecimiento de la confianza en comunicaciones digitales, con ROI estimado en reducción de fraudes por un 40-60% según estudios de Deloitte. Riesgos como falsos negativos en detección crítica demandan capas de defensa en profundidad, combinando IA con revisión humana.

Para implementación, se recomienda comenzar con prototipos en Jupyter Notebooks, escalando a producción con Docker containers. Capacitación en herramientas como PyTorch Lightning acelera el desarrollo, asegurando reproducibilidad mediante seeds aleatorios fijos.

Conclusión

El entrenamiento de modelos de IA para detectar deepfakes no solo aborda desafíos técnicos inmediatos, sino que fortalece la resiliencia cibernética en un ecosistema digital interconectado. Mediante datasets robustos, arquitecturas avanzadas y evaluaciones rigurosas, estas soluciones ofrecen precisión y eficiencia, mitigando riesgos de desinformación y fraude. Finalmente, la adopción continua de innovaciones en aprendizaje profundo, junto con marcos regulatorios sólidos, asegurará un equilibrio entre innovación y seguridad en el sector de tecnologías emergentes.

Para más información, visita la Fuente original.