Inteligencia Artificial en la Detección de Amenazas Cibernéticas: Avances y Aplicaciones Prácticas

La inteligencia artificial (IA) ha transformado radicalmente el panorama de la ciberseguridad, permitiendo la identificación y mitigación de amenazas en tiempo real con una precisión y velocidad inalcanzables para los métodos tradicionales. En un contexto donde los ciberataques evolucionan constantemente, integrando técnicas sofisticadas como el aprendizaje automático y el procesamiento de lenguaje natural, las organizaciones dependen cada vez más de algoritmos de IA para fortalecer sus defensas. Este artículo explora los conceptos clave, frameworks y protocolos involucrados en la implementación de sistemas de detección de intrusiones basados en IA, destacando implicaciones operativas, riesgos y beneficios para profesionales del sector.

Fundamentos Técnicos de la IA en Ciberseguridad

La IA en ciberseguridad se basa principalmente en subcampos como el aprendizaje automático (machine learning, ML) y el aprendizaje profundo (deep learning, DL). El ML permite a los sistemas aprender patrones de comportamiento a partir de datos históricos sin programación explícita, mientras que el DL utiliza redes neuronales multicapa para procesar grandes volúmenes de datos no estructurados, como logs de red o tráfico de paquetes. Por ejemplo, algoritmos supervisados como las máquinas de vectores de soporte (SVM) clasifican amenazas conocidas, mientras que los no supervisados, como el clustering K-means, detectan anomalías en entornos dinámicos.

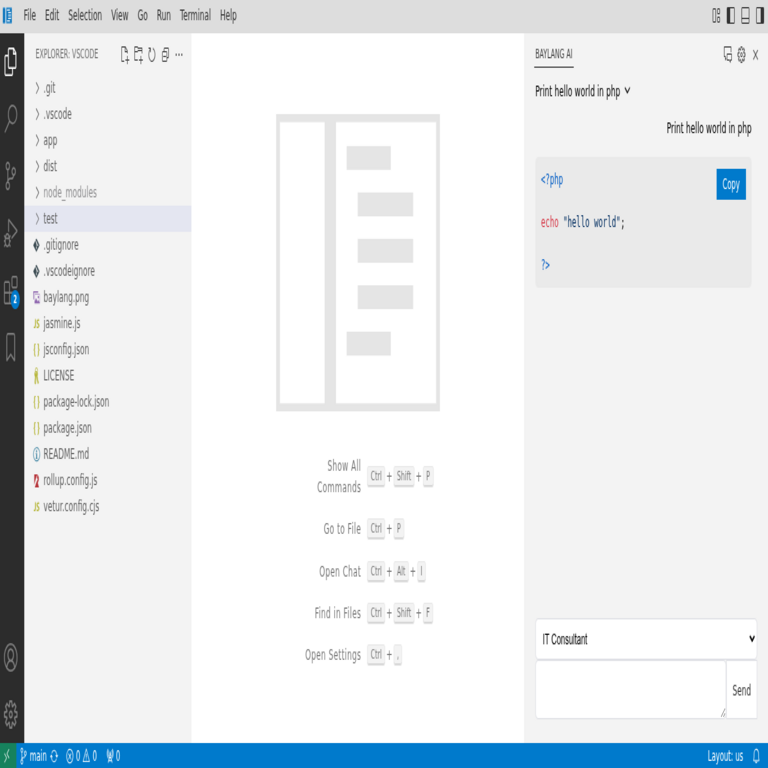

En términos de protocolos, la integración de IA con estándares como SNMP (Simple Network Management Protocol) o Syslog facilita la recolección de datos en redes IP. Frameworks populares incluyen TensorFlow y PyTorch para el desarrollo de modelos, y Scikit-learn para prototipado rápido. Estos herramientas permiten el entrenamiento de modelos sobre datasets como el NSL-KDD o CICIDS2017, que simulan escenarios reales de intrusiones como DDoS o inyecciones SQL.

Las implicaciones operativas son significativas: la IA reduce el tiempo de respuesta a incidentes de horas a segundos, pero requiere una infraestructura robusta para manejar el procesamiento de big data, a menudo mediante clústeres distribuidos con Apache Spark o Hadoop. Regulaciones como el GDPR en Europa o la Ley de Protección de Datos en Latinoamérica exigen que los modelos de IA incorporen privacidad diferencial para evitar fugas de información sensible durante el entrenamiento.

Modelos de Detección de Intrusiones Basados en Aprendizaje Automático

Los sistemas de detección de intrusiones (IDS) tradicionales, como Snort o Suricata, operan bajo reglas estáticas definidas por expertos, lo que los hace vulnerables a ataques zero-day. La IA introduce enfoques dinámicos, donde modelos como las redes neuronales recurrentes (RNN) analizan secuencias temporales de tráfico para predecir patrones maliciosos. Por instancia, una RNN puede procesar flujos de paquetes TCP/IP para identificar intentos de explotación de vulnerabilidades CVE-2023-XXXX, comunes en aplicaciones web.

En la práctica, un IDS basado en IA se implementa en capas: la capa de extracción de características utiliza técnicas como PCA (Análisis de Componentes Principales) para reducir dimensionalidad en datasets de alta cardinalidad, seguida de un clasificador como Random Forest, que ofrece robustez contra overfitting mediante ensemble learning. Estudios técnicos muestran que estos modelos alcanzan tasas de precisión superiores al 95% en entornos controlados, superando a los heurísticos en un 30% para detección de malware polimórfico.

Los riesgos incluyen falsos positivos, que pueden sobrecargar a los analistas de seguridad, y ataques adversarios donde los atacantes envenenan datasets de entrenamiento con datos manipulados. Para mitigar esto, se aplican técnicas de robustez como el adversarial training, incorporando muestras perturbadas durante el fine-tuning del modelo.

Aplicaciones en Blockchain y Tecnologías Descentralizadas

La intersección de IA y blockchain amplía las capacidades de ciberseguridad en entornos distribuidos. En redes como Ethereum o Bitcoin, la IA detecta fraudes en transacciones inteligentes mediante análisis de grafos, utilizando algoritmos como Graph Neural Networks (GNN) para identificar patrones de lavado de dinero o ataques Sybil. Protocolos como IPFS (InterPlanetary File System) se benefician de IA para verificar integridad de datos almacenados, previniendo manipulaciones en nodos distribuidos.

Operativamente, herramientas como Chainalysis integran ML para rastrear flujos de criptoactivos, cumpliendo con estándares AML (Anti-Money Laundering) de la FATF. Beneficios incluyen la escalabilidad: un modelo de IA puede procesar miles de transacciones por segundo en un blockchain de capa 2 como Polygon, reduciendo costos computacionales en comparación con auditorías manuales. Sin embargo, riesgos regulatorios surgen en jurisdicciones latinoamericanas, donde leyes como la de Colombia sobre activos virtuales demandan transparencia en los modelos de IA para evitar sesgos en la detección.

En implementación, se recomienda el uso de bibliotecas como NetworkX para modelado de grafos y Hyperledger Fabric para pruebas en entornos permissioned, asegurando compatibilidad con estándares IEEE 802.15.4 para IoT integrado en blockchain.

Inteligencia Artificial y Análisis de Vulnerabilidades

El escaneo de vulnerabilidades automatizado se potencia con IA mediante fuzzing inteligente, donde algoritmos genéticos generan inputs mutados para probar software en busca de fallos como buffer overflows. Herramientas como AFL (American Fuzzy Lop) evolucionan con ML para priorizar paths de ejecución basados en cobertura de código, alineándose con estándares OWASP para pruebas de seguridad en aplicaciones web.

Conceptualmente, un modelo de IA para vulnerabilidades emplea reinforcement learning (RL), donde un agente aprende a maximizar recompensas al descubrir exploits en entornos simulados como QEMU. Datos de fuentes como el National Vulnerability Database (NVD) alimentan el entrenamiento, permitiendo predicciones de CVSS scores con precisión del 85%. Implicaciones operativas involucran integración con CI/CD pipelines, usando Jenkins o GitLab para escaneos continuos, lo que reduce el MTTR (Mean Time To Repair) en un 40% según benchmarks de Gartner.

Riesgos éticos incluyen el potencial mal uso de estas herramientas para generar exploits, por lo que se enfatiza el cumplimiento de marcos como NIST SP 800-53 para controles de acceso en sistemas de IA. En Latinoamérica, regulaciones como la LGPD en Brasil promueven auditorías independientes de modelos para mitigar sesgos en datasets regionales.

Procesamiento de Lenguaje Natural en la Respuesta a Incidentes

El NLP (Natural Language Processing) de IA analiza reportes de incidentes, tickets de helpdesk y logs textuales para automatizar la triaje. Modelos como BERT o GPT adaptados procesan descripciones en español o portugués, extrayendo entidades nombradas (e.g., IP maliciosas) y clasificando severidad según marcos MITRE ATT&CK.

Técnicamente, se implementa mediante tokenización con Hugging Face Transformers, seguido de fine-tuning en datasets como el de incidentes de SANS Institute. Beneficios operativos: reducción de carga en SOC (Security Operations Centers) al priorizar alertas, con tasas de automatización del 70%. Protocolos como STIX/TAXII facilitan el intercambio de inteligencia de amenazas enriquecida con NLP, mejorando la colaboración entre organizaciones.

Desafíos incluyen el manejo de lenguajes no ingleses; en regiones latinoamericanas, modelos multilingües como mBERT resuelven variaciones dialectales, pero requieren datasets locales para evitar sesgos culturales. Riesgos regulatorios abarcan la privacidad de datos en procesamiento, alineado con ISO 27001 para gestión de seguridad de la información.

Integración de IA en Sistemas de Defensa Perimetral

En firewalls de nueva generación (NGFW), la IA optimiza reglas dinámicas mediante análisis de comportamiento de usuarios (UBA). Frameworks como Zeek combinados con ML detectan insider threats al modelar baselines de acceso, utilizando algoritmos de detección de outliers como Isolation Forest.

La arquitectura típica involucra edge computing para procesamiento en tiempo real, con Kubernetes orquestando contenedores de modelos de IA. Estándares como PCI-DSS para entornos de pago se benefician, ya que la IA reduce falsos negativos en detección de fraudes de tarjetas. Operativamente, esto implica monitoreo continuo con métricas como AUC-ROC para evaluar rendimiento del modelo, asegurando adaptabilidad a amenazas emergentes como ransomware en la nube.

Beneficios cuantificables: según informes de Forrester, la adopción de IA en perímetros reduce brechas de seguridad en un 50%, pero riesgos como la dependencia de vendors (e.g., Palo Alto o Cisco) demandan estrategias de multi-sourcing para evitar lock-in.

Ética y Gobernanza en Despliegues de IA para Ciberseguridad

La gobernanza de IA exige frameworks como el de la UE AI Act, adaptables a Latinoamérica mediante directrices de la OEA. Aspectos clave incluyen explainability (XAI) con técnicas como SHAP para interpretar decisiones de modelos black-box, crucial en auditorías forenses.

En blockchain, la IA ética previene discriminación en scoring de riesgos, utilizando fairness metrics como demographic parity. Implicaciones regulatorias: en México, la Ley Federal de Protección de Datos obliga a impact assessments para sistemas de IA en seguridad. Beneficios: mayor confianza organizacional; riesgos: sanciones por incumplimiento, hasta multas del 4% de ingresos globales bajo GDPR-equivalentes.

Mejores prácticas involucran comités éticos internos y certificaciones como ISO/IEC 42001 para gestión de IA, integrando revisiones periódicas de modelos para drift detection.

Casos de Estudio y Mejores Prácticas

En un caso de estudio de una entidad financiera latinoamericana, la implementación de un IDS basado en DL detectó un ataque APT en 15 minutos, previniendo pérdidas de millones. El modelo, entrenado con datos locales de tráfico, utilizó LSTM para secuencias de comandos maliciosos, integrándose con SIEM como Splunk.

Otra aplicación en IoT: IA en redes 5G usa federated learning para privacidad, entrenando modelos distribuidos sin centralizar datos, alineado con estándares 3GPP. Mejores prácticas: comenzar con proofs-of-concept en entornos sandbox, escalar con A/B testing y monitorear con dashboards en Grafana.

- Selección de datasets: Priorizar fuentes diversificadas para robustez.

- Entrenamiento: Usar GPU acceleration con CUDA para eficiencia.

- Despliegue: Contenerizar con Docker para portabilidad.

- Evaluación: Métricas como F1-score para balance de precision/recall.

Desafíos Futuros y Tendencias Emergentes

Los desafíos incluyen la escalabilidad cuántica, donde algoritmos post-cuánticos como lattice-based cryptography protegen modelos de IA contra amenazas de computación cuántica. Tendencias: IA generativa para simulación de ataques, usando GANs (Generative Adversarial Networks) para generar datasets sintéticos, reduciendo dependencia de datos reales sensibles.

En Latinoamérica, la adopción crece con iniciativas como el Plan Nacional de IA en Chile, enfocándose en ciberseguridad regional. Operativamente, la integración con zero-trust architectures amplifica beneficios, minimizando superficies de ataque.

En resumen, la IA redefine la ciberseguridad al ofrecer herramientas proactivas y adaptativas, aunque requiere un equilibrio entre innovación y gobernanza. Para más información, visita la Fuente original.