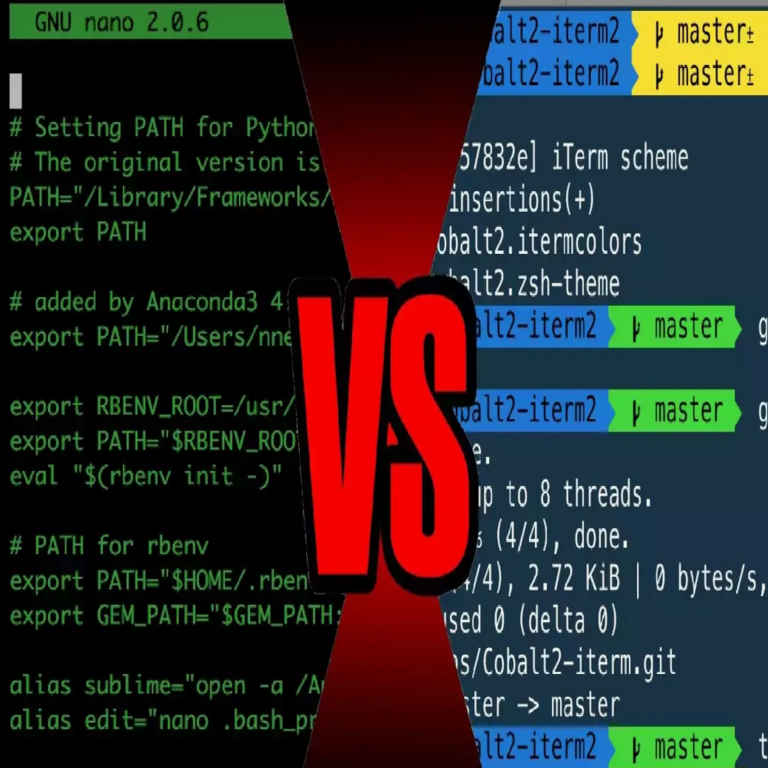

Inteligencia Artificial en Ciberseguridad: Amenazas Emergentes y Oportunidades Estratégicas

La integración de la inteligencia artificial (IA) en el ámbito de la ciberseguridad representa un avance significativo en la evolución tecnológica, pero también introduce desafíos complejos que demandan un análisis profundo. En un panorama donde los ciberataques se vuelven cada vez más sofisticados, la IA no solo actúa como herramienta defensiva, sino que también se emplea por parte de los adversarios para potenciar sus estrategias ofensivas. Este artículo examina los conceptos clave derivados de análisis recientes sobre el uso de IA generativa en ciberseguridad, destacando las tecnologías involucradas, los riesgos operativos y las implicaciones regulatorias. Se basa en hallazgos técnicos que subrayan la necesidad de enfoques proactivos para mitigar amenazas mientras se aprovechan las oportunidades de innovación.

Conceptos Fundamentales de la IA en Ciberseguridad

La inteligencia artificial, particularmente los modelos de aprendizaje automático y profundo, ha transformado la detección de anomalías en redes y sistemas. En esencia, la IA procesa grandes volúmenes de datos en tiempo real para identificar patrones que indican posibles brechas de seguridad. Por ejemplo, algoritmos de machine learning como las redes neuronales convolucionales (CNN) y las recurrentes (RNN) se utilizan para analizar flujos de tráfico de red, prediciendo ataques basados en comportamientos históricos. Un concepto clave es el aprendizaje supervisado, donde modelos como el Support Vector Machine (SVM) clasifican eventos como benignos o maliciosos mediante entrenamiento con datasets etiquetados, tales como el NSL-KDD o el CICIDS2017, que simulan escenarios de intrusión reales.

En el contexto de la IA generativa, tecnologías como los modelos Generative Adversarial Networks (GAN) y los transformers, base de sistemas como GPT, permiten la creación de datos sintéticos para simular ataques. Estos modelos operan mediante un generador que produce muestras falsas y un discriminador que evalúa su autenticidad, logrando un equilibrio que mejora la robustez de las defensas. Sin embargo, esta dualidad genera preocupaciones: mientras las empresas implementan IA para fortalecer firewalls y sistemas de detección de intrusiones (IDS), los atacantes utilizan herramientas similares para evadir detecciones, como en el caso de deepfakes aplicados a phishing o ingeniería social avanzada.

Desde una perspectiva operativa, la implementación de IA en ciberseguridad implica la integración con estándares como el NIST Cybersecurity Framework, que enfatiza la identificación, protección, detección, respuesta y recuperación. La precisión de estos sistemas se mide mediante métricas como la tasa de falsos positivos (FPR) y la precisión (precision), donde un FPR bajo es crucial para evitar alertas innecesarias que sobrecarguen a los equipos de seguridad. Estudios recientes indican que la IA reduce el tiempo de respuesta a incidentes en un 40-60%, según benchmarks de organizaciones como Gartner.

Tecnologías Clave y su Aplicación Práctica

Entre las tecnologías destacadas, los sistemas de IA basados en procesamiento de lenguaje natural (NLP) juegan un rol pivotal en la análisis de logs y correos electrónicos sospechosos. Modelos como BERT o RoBERTa, preentrenados en corpus masivos, permiten la extracción de entidades y el análisis de sentimientos para detectar campañas de spear-phishing. En entornos empresariales, herramientas como IBM Watson o Splunk con extensiones de IA integran estas capacidades, utilizando APIs RESTful para interoperabilidad con infraestructuras existentes.

En el ámbito de la blockchain y su intersección con IA, protocolos como Ethereum con smart contracts inteligentes incorporan modelos de IA para auditorías automatizadas de transacciones, previniendo fraudes en finanzas descentralizadas (DeFi). La combinación de IA con blockchain asegura la inmutabilidad de datos de entrenamiento, mitigando riesgos de envenenamiento de modelos (data poisoning), donde adversarios inyectan datos maliciosos para sesgar predicciones. Frameworks como TensorFlow Federated permiten el entrenamiento distribuido sin comprometer la privacidad, alineándose con regulaciones como el RGPD en Europa.

Para la detección de malware, la IA emplea técnicas de visión por computadora en análisis estático y dinámico. Por instancia, el uso de CNN en el escaneo de binarios identifica firmas de código malicioso con una precisión superior al 95%, superando métodos heurísticos tradicionales. Herramientas open-source como MalConv, basadas en aprendizaje profundo, procesan archivos PE (Portable Executable) directamente, extrayendo características como imports y secciones de código sin necesidad de desensamblado manual.

- Análisis de comportamiento de usuarios (UBA): Modelos de clustering como K-means agrupan actividades para detectar desviaciones, integrando datos de SIEM (Security Information and Event Management) systems.

- Respuesta automatizada: Plataformas como SOAR (Security Orchestration, Automation and Response) utilizan IA para ejecutar playbooks, como el aislamiento de hosts infectados mediante scripts en Python con bibliotecas como Scapy para manipulación de paquetes.

- Predicción de amenazas: Algoritmos de series temporales, como LSTM (Long Short-Term Memory), pronostican brotes de ransomware basados en tendencias globales de threat intelligence.

En términos de hardware, el despliegue de IA en edge computing, con dispositivos como NVIDIA Jetson, acelera el procesamiento local, reduciendo latencia en IoT environments donde la ciberseguridad es crítica, como en redes 5G.

Amenazas Emergentes Derivadas de la IA Generativa

La IA generativa introduce amenazas noveles que desafían paradigmas tradicionales de ciberseguridad. Un ejemplo prominente es la generación de código malicioso automatizado, donde modelos como CodeBERT crean exploits personalizados para vulnerabilidades zero-day, evadiendo antivirus basados en firmas. Investigaciones de firmas como Mandiant revelan que el 30% de los ataques recientes involucran IA para ofuscación de payloads, utilizando técnicas de polimorfismo impulsadas por GAN para mutar malware en runtime.

Otra amenaza es el adversarial machine learning, donde inputs perturbados (adversarial examples) engañan modelos de clasificación. Por ejemplo, en sistemas de reconocimiento facial para autenticación, un ataque de evasión puede alterar píxeles imperceptibles para burlar detecciones, con tasas de éxito del 90% en benchmarks como ImageNet. Esto implica riesgos operativos en sectores como banca y salud, donde la integridad de la IA es vital.

En el plano de la desinformación, deepfakes generados por IA facilitan ataques de ingeniería social, como videos falsos de ejecutivos autorizando transferencias fraudulentas. La detección requiere modelos multimodales que analicen inconsistencias audio-visuales, empleando métricas como PSNR (Peak Signal-to-Noise Ratio) para cuantificar artefactos. Regulatoriamente, marcos como la Directiva NIS2 de la UE exigen disclosure de uso de IA en sistemas críticos, imponiendo multas por no mitigar riesgos sesgados en algoritmos.

Los beneficios contrarrestan estas amenazas: la IA acelera la threat hunting mediante graph analytics en bases de conocimiento como STIX/TAXII, identificando cadenas de ataque en graphs de conocimiento ontológicos. En simulaciones, herramientas como MITRE ATT&CK con IA evalúan posturas de seguridad, prediciendo impactos de tácticas adversarias.

Implicaciones Operativas y Regulatorias

Operativamente, la adopción de IA en ciberseguridad demanda upskilling en equipos, con énfasis en DevSecOps pipelines que integran escaneos de IA desde el desarrollo. Frameworks como OWASP para IA destacan vulnerabilidades como model inversion attacks, donde atacantes reconstruyen datos sensibles de queries. La mitigación involucra técnicas de privacidad diferencial, agregando ruido gaussiano a gradientes durante entrenamiento, preservando utilidad mientras limita fugas de información.

Regulatoriamente, en Latinoamérica, normativas como la LGPD en Brasil y la Ley Federal de Protección de Datos en México alinean con estándares globales, requiriendo evaluaciones de impacto en privacidad (DPIA) para sistemas de IA. En ciberseguridad, esto implica auditorías regulares de modelos para bias, utilizando métricas como disparate impact para asegurar equidad en detecciones.

Riesgos incluyen la dependencia de datasets no representativos, leading a vulnerabilidades en entornos multiculturales. Beneficios operativos abarcan la escalabilidad: un sistema de IA puede monitorear millones de endpoints simultáneamente, optimizando costos en comparación con monitoreo manual. Casos de estudio, como el despliegue de Darktrace en enterprises, demuestran reducciones del 50% en brechas exitosas mediante aprendizaje no supervisado.

| Tecnología | Aplicación en Ciberseguridad | Riesgos Asociados | Mitigaciones |

|---|---|---|---|

| GAN | Generación de datos sintéticos para entrenamiento | Creación de malware polimórfico | Entrenamiento adversarial robusto |

| NLP (BERT) | Análisis de phishing | Generación de textos engañosos | Modelos de verificación de hechos |

| LSTM | Predicción de series temporales | Sobreajuste a datos históricos | Regularización dropout |

| Blockchain + IA | Auditoría distribuida | Envenenamiento de cadena | Consenso Byzantine fault-tolerant |

Esta tabla resume tecnologías clave, ilustrando su dualidad en ciberseguridad.

Mejores Prácticas y Estrategias de Implementación

Para maximizar beneficios, las organizaciones deben adoptar un enfoque zero-trust, integrando IA en arquitecturas segmentadas. Mejores prácticas incluyen el uso de explainable AI (XAI), como SHAP (SHapley Additive exPlanations) para interpretar decisiones de modelos black-box, facilitando compliance con regulaciones. En implementación, contenedores Docker con Kubernetes orquestan despliegues de IA, asegurando escalabilidad y aislamiento.

En noticias recientes de IT, avances en quantum-resistant cryptography, como lattice-based schemes en IA, preparan defensas contra amenazas post-cuánticas. Protocolos como Kyber, estandarizados por NIST, protegen claves de encriptación en comunicaciones seguras impulsadas por IA.

La colaboración internacional es esencial: iniciativas como el Cyber Threat Alliance comparten inteligencia enriquecida con IA, utilizando formatos como STIX 2.1 para estandarización. En Latinoamérica, foros como el Foro de Ciberseguridad de la OEA promueven adopción ética de IA, abordando brechas digitales en regiones emergentes.

Conclusión: Hacia un Futuro Resiliente

En resumen, la intersección de IA y ciberseguridad ofrece un equilibrio delicado entre innovación y riesgo, donde las organizaciones deben priorizar inversiones en tecnologías robustas y marcos regulatorios adaptativos. Al extraer lecciones de análisis técnicos actuales, se evidencia que la proactividad en la detección y respuesta no solo mitiga amenazas, sino que fortalece la resiliencia global. Finalmente, el avance continuo en esta área promete transformar la ciberseguridad en un ecosistema más inteligente y seguro, siempre que se aborden sus desafíos inherentes con rigor y foresight estratégico.

Para más información, visita la fuente original.