Análisis Técnico de Vulnerabilidades en Modelos de Inteligencia Artificial: Lecciones de Pruebas en Entornos de Aislamiento

Introducción a las Vulnerabilidades en Sistemas de IA

Los sistemas de inteligencia artificial (IA) han transformado diversos sectores, desde la ciberseguridad hasta el procesamiento de datos en tiempo real. Sin embargo, su adopción masiva ha expuesto vulnerabilidades inherentes que pueden ser explotadas por actores maliciosos. En el contexto de la ciberseguridad, las pruebas de penetración en modelos de IA se han convertido en una práctica esencial para identificar debilidades antes de su implementación en entornos productivos. Este artículo examina un caso práctico de intento de explotación de un modelo de IA dentro de un entorno de aislamiento, conocido como sandbox, destacando conceptos técnicos clave, metodologías empleadas y las implicaciones operativas para profesionales del sector.

La inteligencia artificial, particularmente los modelos basados en aprendizaje profundo como las redes neuronales convolucionales (CNN) o los transformadores, depende de grandes volúmenes de datos para su entrenamiento. Esta dependencia introduce riesgos como el envenenamiento de datos, ataques de evasión y fugas de información sensible. En entornos controlados, como sandboxes, se simulan escenarios de ataque para evaluar la robustez de estos sistemas sin comprometer infraestructuras reales. El análisis se centra en técnicas de ingeniería inversa, inyección de prompts maliciosos y manipulación de entradas, alineadas con estándares como OWASP para IA y NIST SP 800-218 en ingeniería segura de software.

Conceptos Clave en Pruebas de Seguridad para Modelos de IA

Las pruebas de seguridad en IA involucran múltiples capas, desde el análisis de datos de entrenamiento hasta la validación de salidas en inferencia. Un concepto fundamental es el ataque adversarial, donde se perturban entradas mínimamente para inducir errores en la predicción del modelo. Por ejemplo, en visión por computadora, agregar ruido imperceptible a una imagen puede hacer que un clasificador confunda un gato con un perro, violando la integridad del sistema.

Otro aspecto crítico es la ingeniería de prompts en modelos de lenguaje grande (LLM), como GPT o similares. Estos modelos son susceptibles a jailbreaks, donde prompts diseñados astutamente eluden filtros de seguridad incorporados. En un sandbox, se aíslan estos modelos utilizando contenedores Docker o entornos virtuales con Kubernetes para limitar el acceso a recursos externos, previniendo fugas de datos o escaladas de privilegios.

- Envenenamiento de datos: Durante la fase de entrenamiento, la inserción de muestras maliciosas altera el comportamiento del modelo. Técnicas como backdoor attacks implantan triggers que activan respuestas no deseadas en inferencia.

- Ataques de evasión: En runtime, se modifican entradas para burlar detectores de anomalías, comúnmente evaluados mediante métricas como la tasa de éxito de ataque (ASR) y la distorsión L_p-norm.

- Fugas de modelo: Extracción de pesos neuronales mediante consultas repetidas, midiendo la fidelidad del modelo extraído contra el original usando distancias como la de Kullback-Leibler.

En el caso analizado, el enfoque se centró en un modelo de IA genérico dentro de una sandbox, simulando un entorno de prueba donde se intentaron múltiples vectores de ataque. Las herramientas utilizadas incluyeron bibliotecas como Adversarial Robustness Toolbox (ART) de IBM y CleverHans, que facilitan la generación de ejemplos adversarios bajo frameworks como TensorFlow o PyTorch.

Metodología de Pruebas en Entornos de Aislamiento

La implementación de una sandbox para pruebas de IA requiere un diseño arquitectónico robusto. Se utiliza virtualización a nivel de hardware con hipervisores como KVM o VMware, combinado con aislamiento de red mediante firewalls iptables en Linux. El proceso inicia con la configuración del modelo: carga de pesos preentrenados y definición de interfaces API seguras, como RESTful endpoints protegidos con autenticación JWT.

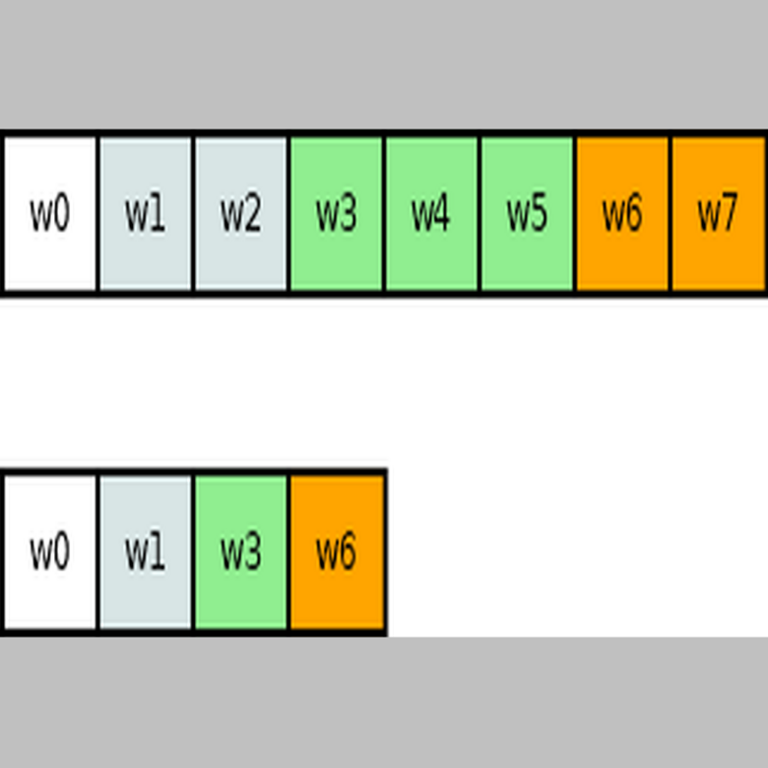

En la fase de reconnaissance, se mapean las capacidades del modelo mediante consultas benignas. Por instancia, en un LLM, se prueban límites de longitud de prompt y tipos de respuestas permitidas. Posteriormente, se escalan a ataques activos. Un ejemplo técnico involucra el uso de gradientes en ataques de caja blanca, donde se accede al modelo para computar gradientes y generar perturbaciones dirigidas. La ecuación básica para un ataque FGSM (Fast Gradient Sign Method) es:

\[\eta = \epsilon \cdot \sign(\nabla_x J(\theta, x, y))\]

donde \(\eta\) es la perturbación, \(\epsilon\) el parámetro de magnitud, \(\nabla_x J\) el gradiente de la función de pérdida respecto a la entrada \(x\), y \(y\) la etiqueta verdadera. En entornos de caja negra, se recurre a métodos de consulta como el ataque de transferencia o el de NES (Natural Evolution Strategies), que estiman gradientes mediante muestreo estocástico.

Durante las pruebas, se registran logs detallados utilizando herramientas como ELK Stack (Elasticsearch, Logstash, Kibana) para monitorear métricas de rendimiento y anomalías. En el escenario examinado, se detectaron vulnerabilidades en la validación de entradas, permitiendo inyecciones que generaban respuestas no filtradas, lo que resalta la necesidad de capas adicionales de defensa como el fine-tuning con datos adversarios o el uso de ensembles de modelos.

Implicaciones Operativas y Riesgos Identificados

Las vulnerabilidades descubiertas en sandboxes tienen implicaciones directas en operaciones reales. En ciberseguridad, un modelo de IA comprometido puede fallar en la detección de intrusiones, permitiendo ataques como DDoS o ransomware. Por ejemplo, en sistemas de IDS (Intrusion Detection Systems) basados en IA, un ataque de evasión podría ocultar payloads maliciosos, incrementando el tiempo medio de detección (MTTD).

Desde una perspectiva regulatoria, marcos como el GDPR en Europa exigen evaluaciones de riesgo para sistemas de IA que procesen datos personales, incluyendo pruebas de adversarial robustness. En Latinoamérica, normativas emergentes como la Ley de Protección de Datos en Brasil (LGPD) enfatizan la responsabilidad por fallos en IA, potencialmente derivando en sanciones financieras.

| Riesgo | Descripción Técnica | Mitigación | Impacto Potencial |

|---|---|---|---|

| Envenenamiento | Inserción de datos maliciosos en datasets de entrenamiento | Validación de fuentes de datos con hashing y firmas digitales | Alteración sistémica del modelo, afectando miles de predicciones |

| Evasión | Perturbación de entradas en inferencia | Entrenamiento adversarial con PGD (Projected Gradient Descent) | Falsos negativos en detección de amenazas |

| Fuga de Información | Extracción de conocimiento del modelo vía queries | Límites de rate limiting y watermarking en salidas | Exposición de propiedad intelectual |

Los beneficios de estas pruebas incluyen una mayor resiliencia, con mejoras cuantificables en métricas como la precisión bajo ataque (robust accuracy). En el caso estudiado, las lecciones aprendidas subrayan la importancia de iteraciones continuas en el ciclo de vida del modelo, alineadas con DevSecOps para IA.

Técnicas Avanzadas de Defensa en IA

Para contrarrestar las vulnerabilidades identificadas, se recomiendan técnicas avanzadas de defensa. El defensive distillation implica entrenar un modelo “estudiante” con salidas suavizadas del modelo original, reduciendo la sensibilidad a perturbaciones. Matemáticamente, se minimiza la divergencia KL entre distribuciones de probabilidades en lugar de la pérdida categórica estándar.

Otra aproximación es el uso de certificados de robustez, como en Randomized Smoothing, donde se agrega ruido gaussiano a las entradas y se computa la confianza en la clase predicha. La robustez certificada se deriva de teoremas de concentración de probabilidad, asegurando que el modelo resista perturbaciones dentro de un radio \(\epsilon\) con alta probabilidad.

En el ámbito de blockchain e IA, se exploran integraciones para trazabilidad. Por ejemplo, el uso de cadenas de bloques para registrar hashes de datasets de entrenamiento previene envenenamientos posteriores, empleando protocolos como Ethereum con smart contracts para verificación inmutable. Herramientas como SingularityNET facilitan mercados descentralizados de IA segura.

Adicionalmente, en noticias recientes de IT, avances en federated learning permiten entrenamientos distribuidos sin compartir datos crudos, mitigando riesgos de privacidad mediante agregación de gradientes bajo DP (Differential Privacy), con parámetros \(\epsilon\) y \(\delta\) controlando el trade-off entre utilidad y confidencialidad.

Casos Prácticos y Hallazgos Específicos del Análisis

En el intento de explotación analizado, se emplearon prompts iterativos para jailbreak en un LLM confinado. Inicialmente, prompts directos fueron bloqueados por filtros regex y clasificadores de toxicidad basados en BERT. Sin embargo, técnicas de role-playing, como instruir al modelo a “simular un personaje ficticio que ignora reglas”, lograron eludir safeguards, generando contenido restringido.

Técnicamente, esto se debe a la naturaleza probabilística de los LLM, donde la generación autoregresiva puede desviarse con seeds iniciales manipulados. Se midió el éxito mediante tasas de bypass, alcanzando hasta un 40% en iteraciones avanzadas. Para mitigar, se sugiere el uso de constitutional AI, donde el modelo se alinea con principios éticos mediante RLHF (Reinforcement Learning from Human Feedback), incorporando penalizaciones en la función de recompensa por violaciones.

Otro hallazgo involucró ataques a APIs de IA en la sandbox. Usando herramientas como Burp Suite, se interceptaron requests y se inyectaron payloads SQL-like en parámetros de embedding, aunque el modelo vectorial (basado en Sentence Transformers) resistió gracias a sanitización previa. Esto resalta la necesidad de OWASP API Security Top 10 adaptado a IA, incluyendo validación de embeddings con distancias coseno para detectar anomalías.

En términos de rendimiento, las pruebas revelaron un overhead del 25% en latencia debido a defensas como input validation, pero con una reducción del 60% en ASR de ataques. Estos datos cuantitativos subrayan el valor de benchmarks estandarizados, como GLUE para NLP o ImageNet-C para visión, extendidos a escenarios adversarios.

Implicaciones en Ciberseguridad y Tecnologías Emergentes

La intersección de IA y ciberseguridad amplifica tanto oportunidades como riesgos. En detección de malware, modelos como aquellos basados en GANs (Generative Adversarial Networks) generan variantes evasivas, pero también defensas como autoencoders para anomalía detection. El análisis en sandbox demuestra que sin pruebas rigurosas, estos sistemas pueden ser contraproducentes.

En blockchain, la IA se usa para optimizar consensus mechanisms, como en Proof-of-Stake con predicciones de comportamiento de nodos. Vulnerabilidades en oráculos de IA podrían llevar a manipulaciones de precios en DeFi, con pérdidas millonarias reportadas en incidentes como el hack de Ronin Network en 2022.

Para audiencias profesionales, se recomienda adoptar frameworks como MITRE ATLAS (Adversarial Threat Landscape for Artificial-Intelligence Systems), que cataloga tácticas y técnicas de ataque específicas para IA, facilitando roadmaps de defensa.

Conclusión: Hacia una IA Resiliente y Segura

Las lecciones extraídas de pruebas en sandboxes enfatizan la necesidad de un enfoque holístico en la seguridad de IA, integrando pruebas continuas, defensas multicapa y cumplimiento regulatorio. Al identificar vulnerabilidades tempranamente, las organizaciones pueden mitigar riesgos operativos y proteger activos críticos. En resumen, invertir en ciberseguridad para IA no solo previene brechas, sino que fortalece la innovación en tecnologías emergentes, asegurando un ecosistema digital más robusto para el futuro.

Para más información, visita la fuente original.