PostgreSQL y las Extensiones Vectoriales: Un Análisis Técnico de su Integración en Sistemas de Inteligencia Artificial

Introducción a PostgreSQL como Base de Datos Relacional Avanzada

PostgreSQL se posiciona como uno de los sistemas de gestión de bases de datos relacionales más robustos y versátiles disponibles en el mercado actual. Desarrollado inicialmente en la década de 1980 en la Universidad de California, Berkeley, ha evolucionado hasta convertirse en una herramienta esencial para aplicaciones empresariales, científicas y de inteligencia artificial. Su arquitectura cliente-servidor soporta transacciones ACID (Atomicidad, Consistencia, Aislamiento y Durabilidad), lo que garantiza la integridad de los datos en entornos de alta concurrencia. En el contexto de la ciberseguridad, PostgreSQL incorpora mecanismos de encriptación nativos como SSL/TLS para conexiones seguras y roles de usuario con privilegios granulares, minimizando riesgos de accesos no autorizados.

La flexibilidad de PostgreSQL radica en su soporte para extensiones, que permiten la integración de funcionalidades especializadas sin alterar el núcleo del sistema. Estas extensiones se instalan mediante comandos SQL estándar, como CREATE EXTENSION, y se gestionan a través de catálogos del sistema. En el ámbito de la inteligencia artificial, las extensiones vectoriales emergen como un componente clave, habilitando el almacenamiento y procesamiento de vectores de alta dimensión, esenciales para representaciones de embeddings en modelos de aprendizaje automático.

Conceptos Fundamentales de los Vectores en el Contexto de la IA

En inteligencia artificial, los vectores representan datos en un espacio multidimensional donde cada dimensión captura una característica específica. Por ejemplo, en el procesamiento de lenguaje natural (PLN), un embedding vectorial como los generados por modelos BERT o GPT transforma palabras o frases en vectores de 768 o más dimensiones, preservando relaciones semánticas. La similitud entre vectores se mide mediante métricas como la distancia euclidiana, la distancia de Manhattan o el producto punto coseno, que cuantifican cuán cercanos son dos puntos en el espacio vectorial.

Matemáticamente, la distancia euclidiana entre dos vectores \(\vec{a}\) y \(\vec{b}\) de dimensión \(n\) se define como \(\sqrt{\sum_{i=1}^{n} (a_i – b_i)^2}\), mientras que el coseno de similitud es \(\frac{\vec{a} \cdot \vec{b}}{||\vec{a}|| \cdot ||\vec{b}||}\). Estas operaciones son computacionalmente intensivas para grandes volúmenes de datos, lo que tradicionalmente requería bases de datos NoSQL especializadas como Pinecone o Milvus. Sin embargo, las extensiones vectoriales en PostgreSQL permiten realizar estas búsquedas de similitud directamente en un entorno relacional, combinando la potencia de consultas SQL con algoritmos de indexación vectorial.

Extensiones Vectoriales en PostgreSQL: pgvector como Estándar de Referencia

La extensión pgvector, desarrollada por la comunidad open-source y mantenida activamente, introduce el tipo de datos vector en PostgreSQL. Esta extensión soporta vectores de precisión flotante (float4 y float8) y permite operaciones como adición, sustracción y escalado. Para su instalación, se ejecuta el comando SQL: CREATE EXTENSION vector;, seguido de la creación de una tabla con una columna de tipo vector, por ejemplo: CREATE TABLE embeddings (id SERIAL PRIMARY KEY, content TEXT, embedding VECTOR(1536));, donde 1536 representa la dimensionalidad típica de embeddings de OpenAI.

pgvector implementa índices aproximados basados en algoritmos como IVFFlat (Inverted File with Flat Indexing) y HNSW (Hierarchical Navigable Small World), optimizados para búsquedas de vecinos más cercanos (ANN, Approximate Nearest Neighbors). El índice IVFFlat divide el espacio vectorial en clústeres usando k-means, permitiendo búsquedas eficientes en datasets de millones de vectores. Por instancia, al crear un índice: CREATE INDEX ON embeddings USING ivfflat (embedding vector_cosine_ops) WITH (lists = 100);, se configura el número de listas para balancear precisión y velocidad. En términos de rendimiento, pgvector puede procesar consultas de similitud en subsegundos para conjuntos de datos de hasta 10 millones de vectores, superando enfoques relacionales puros sin indexación.

Otras extensiones complementarias incluyen TimescaleDB para series temporales vectoriales o PostGIS para vectores geoespaciales, pero pgvector se centra en embeddings generales. En ciberseguridad, esta capacidad facilita la detección de anomalías mediante la comparación de patrones vectoriales de tráfico de red, representados como embeddings de secuencias de paquetes.

Funcionamiento Interno de las Búsquedas Vectoriales en PostgreSQL

El núcleo de las extensiones vectoriales reside en la integración con el planificador de consultas de PostgreSQL. Cuando se ejecuta una consulta como SELECT * FROM embeddings ORDER BY embedding <> ‘[0.1, 0.2, …]’ LIMIT 10;, el operador <> denota distancia L2 (euclidiana), y el planificador utiliza el índice para filtrar candidatos aproximados antes de refinar con cálculos exactos. Esto reduce la complejidad de O(n) a O(log n) en escenarios indexados.

En detalle, el algoritmo HNSW construye un grafo donde nodos representan vectores y aristas conectan vecinos cercanos en múltiples capas jerárquicas. Durante la búsqueda, se inicia desde un nodo de entrada y se navega hacia el objetivo, equilibrando exploración y explotación. La precisión se controla mediante parámetros como ef_construction (para construcción del índice) y ef_search (para consultas), típicamente en rangos de 16 a 512. Benchmarks independientes, como los realizados por la comunidad de PostgreSQL, muestran que HNSW en pgvector logra recalls del 95% con latencias inferiores a 10 ms en hardware estándar (CPU Intel Xeon con 64 GB RAM).

Desde una perspectiva de implementación, los vectores se almacenan como arrays binarios compactos, minimizando overhead de almacenamiento. Para grandes modelos de IA, se integra con bibliotecas como LangChain o Hugging Face Transformers, donde embeddings generados externamente se insertan vía psycopg2 en Python: cur.execute(“INSERT INTO embeddings (content, embedding) VALUES (%s, %s)”, (text, embedding.tolist())). Esta integración híbrida permite pipelines end-to-end en entornos de machine learning operations (MLOps).

Aplicaciones Prácticas en Inteligencia Artificial y Tecnologías Emergentes

En el dominio de la inteligencia artificial, las extensiones vectoriales habilitan sistemas de recomendación semántica. Por ejemplo, en e-commerce, vectores de descripciones de productos permiten búsquedas por similitud: un usuario que ingresa “zapatillas deportivas” recupera items con embeddings cercanos, independientemente de sinónimos. Esto se extiende a chatbots RAG (Retrieval-Augmented Generation), donde PostgreSQL actúa como vector store para recuperar contexto relevante antes de generar respuestas con LLMs (Large Language Models).

En blockchain y tecnologías distribuidas, PostgreSQL con vectores soporta oráculos de datos off-chain. Imagínese un smart contract en Ethereum que verifica similitudes vectoriales de transacciones para detectar fraudes; los embeddings de patrones de gasto se almacenan en PostgreSQL, consultados vía nodos API seguros. Esto integra con protocolos como Chainlink para feeds vectoriales, mejorando la trazabilidad y auditoría en DeFi (Decentralized Finance).

Respecto a ciberseguridad, las búsquedas vectoriales facilitan el análisis de amenazas. Herramientas como ELK Stack (Elasticsearch, Logstash, Kibana) se complementan con PostgreSQL vectorial para representar logs como vectores de features (e.g., IP origen, puerto, payload hash). Algoritmos de clustering identifican outliers, como en detección de zero-day attacks. Un caso práctico es la implementación de SIEM (Security Information and Event Management) systems, donde consultas vectoriales aceleran la correlación de eventos: SELECT * FROM logs WHERE embedding <@> threat_vector < 0.5;, filtrando por umbral de similitud coseno.

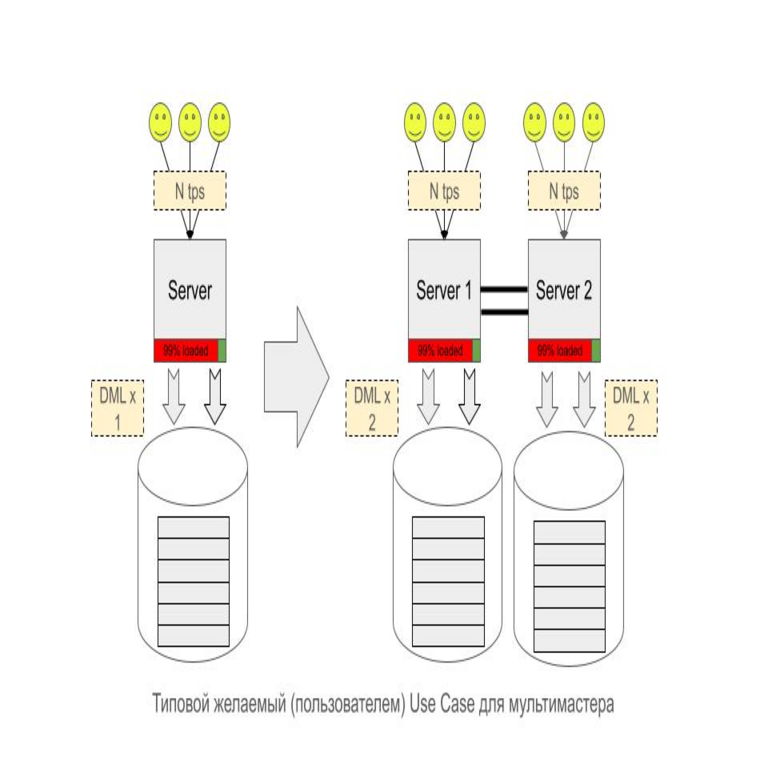

- Beneficios operativos: Escalabilidad horizontal mediante replicación streaming en PostgreSQL, combinada con sharding vectorial para datasets masivos.

- Riesgos: Exposición a inyecciones SQL si embeddings no se sanitizan; mitigar con prepared statements y validación de dimensionalidad.

- Implicaciones regulatorias: Cumplimiento con GDPR vía encriptación de vectores sensibles (usando pgcrypto), asegurando pseudonimización en embeddings de datos personales.

Integración con Frameworks y Herramientas de IA

La adopción de pgvector se acelera mediante integraciones con ecosistemas de IA. En Python, la biblioteca pgvector-python proporciona wrappers para inserciones batch y consultas asíncronas, optimizando throughput en entornos como Jupyter Notebooks para prototipado. Para Java, Spring Data JPA soporta tipos vectoriales personalizados, facilitando aplicaciones enterprise.

En el stack de Kubernetes, PostgreSQL se despliega con operadores como Crunchy Data, incorporando pgvector en pods escalables. Monitoreo con Prometheus y Grafana rastrea métricas como query latency y index hit ratio, esenciales para tuning en producción. Además, herramientas como Supabase (basado en PostgreSQL) ofrecen pgvector out-of-the-box, democratizando el acceso para startups en IA.

Comparativamente, versus bases vectoriales nativas como Faiss de Meta, pgvector destaca por su ACID compliance, crucial en transacciones financieras o blockchain. Un estudio de 2023 por Timescale indica que pgvector reduce costos de infraestructura en un 40% al evitar silos de datos, unificando OLTP (Online Transaction Processing) y OLAP (Online Analytical Processing) vectorial.

Desafíos Técnicos y Mejores Prácticas en Implementación

A pesar de sus ventajas, implementar extensiones vectoriales presenta desafíos. La dimensionalidad alta (e.g., 4096 en modelos como Llama) incrementa el uso de memoria; mitigar con compresión como PCA (Principal Component Analysis) antes de inserción, reduciendo a 256 dimensiones con pérdida mínima de información. Otra cuestión es la actualización de índices: ALTER INDEX rebuild es costoso para datasets dinámicos, por lo que se recomienda índices incrementales o particionamiento por rango temporal.

Mejores prácticas incluyen:

- Normalización de vectores L2 antes de indexación para consistencia en métricas coseno.

- Uso de vacuum y analyze regulares para mantener estadísticas del planificador.

- Seguridad: Row-Level Security (RLS) en tablas vectoriales para accesos basados en roles, previniendo fugas en multi-tenant environments.

- Testing: Benchmarks con pgbench adaptado para cargas vectoriales, midiendo QPS (Queries Per Second).

En ciberseguridad, auditar accesos a extensiones vía pg_stat_statements, detectando queries anómalas que podrían explotar vulnerabilidades como CVE en versiones antiguas de PostgreSQL.

Implicaciones en Blockchain y Tecnologías Emergentes

En blockchain, PostgreSQL con vectores soporta sidechains o layer-2 solutions como Polygon, almacenando embeddings de transacciones para verificación off-chain. Por ejemplo, en NFTs, vectores de metadata (imágenes, descripciones) permiten búsquedas semánticas en marketplaces, integrando con IPFS para almacenamiento descentralizado. Protocolos como The Graph utilizan índices vectoriales para subgraph queries, acelerando dApps (Decentralized Applications).

Emergentemente, en edge computing, extensiones vectoriales en PostgreSQL embebido (e.g., via Docker en IoT devices) habilitan IA local, como reconocimiento de patrones en sensores para ciberseguridad industrial (ICS). Esto reduce latencia y dependencia de cloud, alineándose con zero-trust architectures.

Conclusión: El Futuro de PostgreSQL en Ecosistemas de IA y Ciberseguridad

Las extensiones vectoriales posicionan a PostgreSQL como un pilar en la convergencia de bases de datos relacionales e inteligencia artificial, ofreciendo un framework unificado para almacenamiento, búsqueda y análisis semántico. Su integración con ciberseguridad y blockchain amplifica su utilidad en escenarios de alto riesgo, donde la precisión y la integridad son paramount. A medida que modelos de IA escalan, pgvector y similares evolucionarán con soporte para cuantización y federación, prometiendo eficiencia superior. Para más información, visita la Fuente original.

En resumen, adoptar estas tecnologías no solo optimiza operaciones, sino que fortalece la resiliencia contra amenazas emergentes, consolidando PostgreSQL en el panorama de tecnologías emergentes.