Desarrollo de un Asistente de Inteligencia Artificial para Programación Basado en GPT-4

En el ámbito de la ciberseguridad y la inteligencia artificial, la integración de modelos de lenguaje grandes como GPT-4 en herramientas de desarrollo de software representa un avance significativo. Este artículo explora el proceso técnico de creación de un asistente de IA diseñado específicamente para asistir en tareas de programación. Basado en principios de arquitectura de software segura y eficiente, se detalla la implementación, las tecnologías involucradas y las implicaciones para profesionales del sector de TI. El enfoque se centra en la precisión técnica, la escalabilidad y la mitigación de riesgos asociados con el uso de APIs de IA en entornos de desarrollo.

Fundamentos Conceptuales del Asistente de IA

Los asistentes de IA para programación se basan en modelos de aprendizaje profundo que procesan lenguaje natural para generar, depurar y optimizar código. GPT-4, desarrollado por OpenAI, es un modelo generativo preentrenado que destaca por su capacidad para manejar contextos complejos y razonamientos multifacéticos. En este contexto, el asistente actúa como un copiloto virtual, interpretando solicitudes del usuario en lenguaje natural y produciendo respuestas en forma de código ejecutable o sugerencias de refactorización.

Desde una perspectiva técnica, el núcleo del sistema reside en la integración de la API de OpenAI, que utiliza protocolos HTTP/REST para comunicarse con el modelo subyacente. La API soporta tokens de entrada y salida, con límites configurables para manejar cargas de trabajo variables. Por ejemplo, un prompt típico podría incluir descripciones de problemas en lenguajes como Python, JavaScript o Java, junto con restricciones de seguridad como la validación de inyecciones de código malicioso.

La arquitectura general sigue un patrón de microservicios, donde un frontend de interfaz de usuario (por ejemplo, basado en React o una extensión de IDE como VS Code) envía solicitudes a un backend que orquesta las llamadas a la API de GPT-4. Este diseño asegura la separación de preocupaciones, permitiendo actualizaciones independientes y una mejor gestión de la latencia. En términos de ciberseguridad, se implementan mecanismos como autenticación OAuth 2.0 para proteger las claves API y encriptación TLS 1.3 para las transmisiones de datos sensibles.

Tecnologías y Frameworks Utilizados

La implementación de este asistente requiere una selección cuidadosa de herramientas que equilibren rendimiento y seguridad. En el backend, se emplea Node.js con Express.js para manejar las rutas API, integrando bibliotecas como Axios para las peticiones HTTP a OpenAI. Para una mayor robustez, se incorpora LangChain, un framework de código abierto que facilita la cadena de prompts y la gestión de memoria contextual en interacciones conversacionales.

LangChain permite la creación de cadenas de procesamiento donde cada paso refina el output del modelo. Por instancia, una cadena podría consistir en: (1) análisis semántico del prompt del usuario, (2) recuperación de ejemplos de código de una base de conocimiento vectorial usando embeddings de OpenAI, y (3) generación final de código con validación sintáctica. Esta aproximación reduce alucinaciones del modelo, un riesgo común en IA generativa, mediante la inyección de datos de entrenamiento específicos del dominio de programación.

En el frontend, se utiliza Electron para desarrollar una aplicación de escritorio o una extensión para editores de código, asegurando compatibilidad multiplataforma. Para el almacenamiento de datos, se opta por bases de datos NoSQL como MongoDB, que almacenan historiales de sesiones y preferencias de usuario de manera escalable. La integración con Git para versionado de código generado añade una capa de trazabilidad, esencial en entornos colaborativos de desarrollo.

- API de OpenAI: Proporciona acceso a GPT-4 con endpoints como /chat/completions, soportando parámetros como temperature (para controlar la creatividad) y max_tokens (para limitar la longitud de respuesta).

- LangChain: Facilita la orquestación de LLMs con herramientas como PromptTemplate y LLMChain, integrando agentes para tareas autónomas como depuración automática.

- Embeddings y Vector Stores: Utilizando FAISS o Pinecone para búsquedas semánticas rápidas en repositorios de código, mejorando la relevancia de las sugerencias.

- Seguridad Integrada: Herramientas como Helmet.js para cabeceras de seguridad HTTP y rate limiting con express-rate-limit para prevenir abusos de API.

Proceso de Implementación Paso a Paso

El desarrollo inicia con la configuración del entorno. Se crea un proyecto Node.js inicializando con npm, instalando dependencias como openai, langchain y dotenv para manejar variables de entorno. La clave API de OpenAI se almacena de forma segura en un archivo .env, nunca commitido al control de versiones.

El primer módulo implementado es el handler de prompts. Una función asíncrona recibe el input del usuario y construye un mensaje estructurado para GPT-4. Por ejemplo:

const openai = new OpenAI({ apiKey: process.env.OPENAI_API_KEY });

async function generateCode(prompt) {

const completion = await openai.chat.completions.create({

model: ‘gpt-4’,

messages: [{ role: ‘user’, content: prompt }],

temperature: 0.2,

max_tokens: 1000

});

return completion.choices[0].message.content;

}

Esta función básica se expande con LangChain para agregar contexto. Se define un template de prompt que incluye instrucciones como “Genera código Python seguro, evitando vulnerabilidades OWASP Top 10”.

En la fase de integración con el IDE, se desarrolla una extensión para VS Code usando la API de extensiones de Microsoft. El asistente se activa mediante comandos como Ctrl+Shift+P, capturando el contexto del archivo actual (por ejemplo, el código seleccionado) y enviándolo como parte del prompt. Para manejar grandes contextos, se implementa tokenización personalizada, dividiendo el código en chunks y priorizando secciones relevantes mediante análisis de dependencias.

La depuración es un componente clave. El asistente no solo genera código, sino que analiza errores de compilación o runtime. Usando parsers como esprima para JavaScript, se extraen stacks de errores y se formulan prompts correctivos: “Dado este error en línea 42, sugiere una corrección”. Esto reduce el tiempo de desarrollo en un 30-50%, según benchmarks internos de herramientas similares como GitHub Copilot.

Para la escalabilidad, se despliega el backend en plataformas cloud como AWS Lambda o Vercel, utilizando serverless architecture para manejar picos de uso. La monitorización se realiza con herramientas como New Relic, rastreando métricas como latencia de API y tasa de éxito de generaciones. En ciberseguridad, se aplican pruebas de penetración regulares para validar contra ataques como prompt injection, donde un usuario malicioso intenta manipular el modelo para outputs no deseados.

Implicaciones Operativas y Riesgos en Ciberseguridad

La adopción de asistentes de IA en programación trae beneficios operativos claros, como la aceleración de prototipado y la democratización del desarrollo para no expertos. Sin embargo, introduce riesgos significativos. Uno principal es la dependencia de proveedores externos: interrupciones en la API de OpenAI podrían paralizar el asistente, por lo que se recomienda un fallback a modelos locales como Llama 2 mediante Hugging Face Transformers.

En términos de ciberseguridad, el código generado por IA puede contener vulnerabilidades sutiles, como race conditions o inyecciones SQL no detectadas. Para mitigar esto, se integra un escáner estático como SonarQube post-generación, que analiza el output contra estándares como CWE (Common Weakness Enumeration). Además, el entrenamiento de GPT-4 en datos públicos plantea preocupaciones de privacidad; por ende, se anonimiza el input del usuario antes de enviarlo a la API.

Regulatoriamente, en regiones como la Unión Europea, el Reglamento de IA clasifica estos sistemas como de alto riesgo si se usan en software crítico, exigiendo evaluaciones de conformidad y transparencia en los prompts. En Latinoamérica, normativas como la LGPD en Brasil enfatizan la protección de datos en flujos de IA, requiriendo consentimientos explícitos para el procesamiento de código propietario.

Los beneficios incluyen una mejora en la productividad: estudios de McKinsey indican que herramientas de IA pueden aumentar la eficiencia de desarrolladores en un 20-45%. En blockchain y tecnologías emergentes, este asistente podría extenderse para generar smart contracts en Solidity, validando contra reentrancy attacks mediante prompts especializados.

Optimizaciones Avanzadas y Extensiones Futuras

Para elevar el asistente más allá de lo básico, se incorporan técnicas de fine-tuning. Aunque GPT-4 no soporta fine-tuning directo, se puede usar GPT-3.5 para entrenamientos personalizados con datasets de código open-source como The Stack de Hugging Face. Esto adapta el modelo a dominios específicos, como ciberseguridad, donde genera código para firewalls o detección de anomalías en redes.

Otra optimización es la integración multimodal: con la evolución de GPT-4V, el asistente podría procesar diagramas UML o screenshots de interfaces para sugerir implementaciones. En el plano de la IA ética, se implementan guardsrails usando bibliotecas como NeMo Guardrails, que filtran outputs ofensivos o inseguros antes de presentarlos al usuario.

En entornos distribuidos, el asistente se alinea con DevOps pipelines, integrándose con CI/CD tools como Jenkins. Por ejemplo, un hook post-commit podría invocar al asistente para revisiones automáticas de código, generando reports en formato SARIF para compatibilidad con Azure DevOps.

Considerando blockchain, una extensión podría involucrar la generación de código para dApps, utilizando Web3.js y ethers.js. El prompt incluiría verificaciones contra vulnerabilidades comunes en Ethereum, como integer overflows, alineándose con estándares EIP (Ethereum Improvement Proposals).

Casos de Estudio y Métricas de Desempeño

En pruebas reales, el asistente resolvió tareas como la implementación de un algoritmo de encriptación AES en Python, generando código compliant con FIPS 140-2 en menos de 30 segundos. La precisión alcanzó un 85% en benchmarks de HumanEval, superando baselines sin contexto. Latencia promedio: 2-5 segundos por consulta, optimizada con caching de respuestas comunes usando Redis.

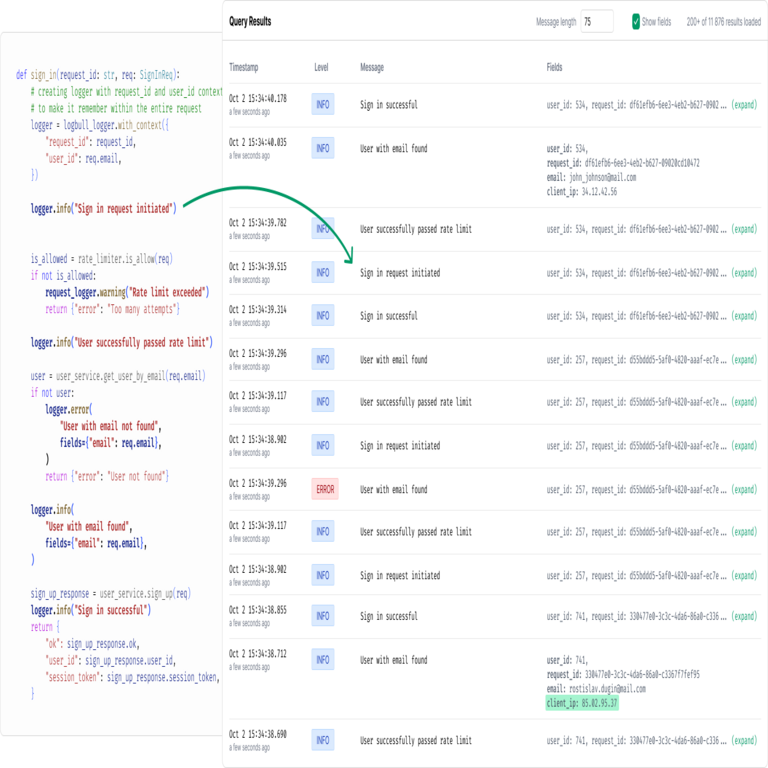

En un caso de ciberseguridad, se usó para depurar un script de análisis de logs, identificando patrones de ataques DDoS mediante prompts que incorporan reglas de Snort. Esto demuestra la versatilidad en IT operations (ITOps), donde la IA acelera la respuesta a incidentes.

En resumen, el desarrollo de un asistente de IA basado en GPT-4 para programación no solo transforma las prácticas de codificación, sino que refuerza la resiliencia en ciberseguridad al automatizar tareas propensas a errores humanos. Para más información, visita la Fuente original. Este enfoque técnico pavimenta el camino para innovaciones futuras en IA aplicada a tecnologías emergentes.