Cómo Desarrollar una Inteligencia Artificial para la Generación de Código: Un Enfoque Técnico Integral

Introducción al Desarrollo de Modelos de IA para Generación de Código

La generación de código mediante inteligencia artificial (IA) representa uno de los avances más significativos en el campo de la programación asistida por máquinas. Este enfoque no solo acelera el proceso de desarrollo de software, sino que también introduce nuevas dimensiones en la eficiencia operativa y la innovación tecnológica. En el contexto de la ciberseguridad, la inteligencia artificial para la generación de código puede mitigar riesgos al automatizar la creación de componentes seguros, como algoritmos de encriptación o protocolos de autenticación, reduciendo así la exposición a vulnerabilidades humanas. Este artículo explora de manera detallada el proceso de creación de un modelo de IA especializado en la generación de código, basándose en principios fundamentales de aprendizaje automático, procesamiento de lenguaje natural (PLN) y mejores prácticas en ingeniería de software.

El desarrollo de tales sistemas implica la integración de grandes modelos de lenguaje (LLMs, por sus siglas en inglés), como variantes de GPT o arquitecturas transformer, adaptadas para tareas específicas de codificación. Estos modelos aprenden patrones a partir de vastos repositorios de código fuente, permitiendo la síntesis de fragmentos funcionales en lenguajes como Python, JavaScript o C++. Sin embargo, el rigor técnico exige una comprensión profunda de los desafíos inherentes, incluyendo la alucinación de código (generación de fragmentos inexistentes o erróneos), la gestión de dependencias y la conformidad con estándares de seguridad como OWASP para aplicaciones web.

Desde una perspectiva operativa, implementar una IA para generación de código requiere una infraestructura robusta, que incluya servidores de alto rendimiento para el entrenamiento y la inferencia, así como herramientas de monitoreo para evaluar la precisión del output. En términos regulatorios, especialmente en entornos sensibles como el sector financiero o gubernamental, es crucial alinear el modelo con normativas como GDPR o NIST, asegurando que el código generado no introduzca brechas de privacidad o sesgos en la lógica algorítmica.

Fundamentos Técnicos de los Modelos de Lenguaje para Generación de Código

Los modelos de IA para generación de código se basan principalmente en arquitecturas transformer, introducidas en el paper “Attention is All You Need” de Vaswani et al. en 2017. Estas arquitecturas utilizan mecanismos de atención autoatentos para procesar secuencias de tokens, donde el código fuente se tokeniza en unidades subpalabra o caracteres, permitiendo capturar dependencias sintácticas y semánticas a largo plazo. Por ejemplo, en un modelo como CodeBERT o GitHub Copilot, el preentrenamiento se realiza sobre datasets masivos como The Stack, que contiene más de 3 terabytes de código de repositorios públicos de GitHub.

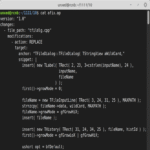

El proceso de tokenización es crítico: herramientas como Byte-Pair Encoding (BPE) o SentencePiece dividen el código en tokens que preservan la estructura, como palabras clave (e.g., “def” en Python) o identificadores. Durante el fine-tuning, el modelo se ajusta para tareas específicas, como completación de código o generación a partir de prompts naturales. Matemáticamente, la atención se calcula como:

Attention(Q, K, V) = softmax(QK^T / √d_k) V

donde Q, K y V son matrices de consultas, claves y valores derivadas de las entradas, y d_k es la dimensión del modelo. Esta fórmula permite al modelo ponderar la relevancia de diferentes partes del contexto, esencial para generar código coherente que respete la indentación y las declaraciones de variables.

En el ámbito de la ciberseguridad, integrar módulos de verificación estática en el pipeline de generación asegura que el código output cumpla con prácticas seguras. Por instancia, herramientas como Bandit para Python pueden escanear el código generado en busca de vulnerabilidades comunes, como inyecciones SQL o fugas de memoria, alineándose con el marco MITRE CWE para debilidades de software.

Recopilación y Preparación de Datos para el Entrenamiento

La calidad de los datos es el pilar del éxito en el desarrollo de una IA para generación de código. La recopilación implica extraer código de fuentes abiertas, como GitHub, Stack Overflow o bases de datos como CodeSearchNet, asegurando diversidad en lenguajes y dominios. Un dataset típico debe incluir al menos 100 millones de líneas de código limpias, filtradas para eliminar código malicioso o duplicado mediante técnicas de hashing perceptual como MinHash.

La preparación de datos involucra varias etapas: limpieza (remoción de comentarios irrelevantes y normalización de formato), anotación (etiquetado de pares prompt-respuesta para aprendizaje supervisado) y augmentación (variaciones sintácticas para robustez). Por ejemplo, en un enfoque híbrido, se puede combinar código sintético generado por compiladores con datos reales para equilibrar precisión y generalización.

- Filtrado de calidad: Utilizar métricas como cyclomatic complexity para descartar código excesivamente complejo, reduciendo el riesgo de alucinaciones.

- Balanceo de datasets: Asegurar representación equitativa de lenguajes minoritarios, como Rust para sistemas seguros, para evitar sesgos en la generación.

- Privacidad y ética: Anonimizar datos sensibles aplicando differential privacy, con parámetros ε ≈ 1.0 para minimizar fugas de información, conforme a estándares como ISO/IEC 27001.

En términos de implicaciones operativas, un dataset mal preparado puede llevar a modelos que generen código vulnerable, como bucles infinitos o accesos no autorizados, incrementando riesgos en entornos de producción. Beneficios incluyen la aceleración del desarrollo en un 30-50%, según estudios de McKinsey sobre adopción de IA en software engineering.

Arquitectura y Entrenamiento del Modelo

La arquitectura base para un modelo de generación de código suele ser un decoder-only transformer, similar a GPT-3, con capas de 12-96 y dimensiones de embedding de 768-4096. Para especialización, se incorporan heads de atención multi-tarea: uno para sintaxis, otro para semántica y un tercero para optimización de seguridad. El entrenamiento se divide en preentrenamiento (aprendizaje no supervisado de next-token prediction) y fine-tuning (supervisado con loss functions como cross-entropy).

El hardware requerido incluye clústeres de GPUs NVIDIA A100 o TPUs, con bibliotecas como Hugging Face Transformers o PyTorch para implementación. Un hiperparámetro clave es el learning rate, típicamente 5e-5 con schedulers como AdamW, para convergencia estable en epochs de 10-50. La loss function se optimiza considerando métricas específicas de código, como BLEU score adaptado para sintaxis o exact match accuracy.

| Componente | Descripción | Mejores Prácticas |

|---|---|---|

| Embedding Layer | Convierte tokens en vectores densos | Usar positional encodings sinusoidales para secuencias largas |

| Attention Blocks | Mecanismo de focalización contextual | Implementar sparse attention para eficiencia en códigos extensos |

| Output Head | Predicción de tokens siguientes | Softmax con temperature tuning (0.7-1.0) para diversidad |

Desde el punto de vista de riesgos, el overfitting es común en datasets de código, mitigado mediante dropout (tasa 0.1) y regularización L2. En ciberseguridad, entrenar con adversarial examples (e.g., código con backdoors simulados) fortalece la resiliencia del modelo contra manipulaciones.

Evaluación y Métricas de Rendimiento

Evaluar un modelo de IA para generación de código exige métricas híbridas que combinen similitud textual y funcionalidad. Métricas estándar incluyen:

- Pass@K: Probabilidad de que al menos una de K generaciones pase pruebas unitarias, ideal para K=10-100.

- Edit Similarity: Distancia Levenshtein normalizada entre código generado y referencia, por debajo de 0.2 para alta fidelidad.

- Security Score: Integración con SAST tools como SonarQube para detectar vulnerabilidades, apuntando a cero CWE críticas.

Pruebas funcionales involucran compilación y ejecución en entornos sandboxed, usando frameworks como pytest para Python o JUnit para Java. Implicaciones regulatorias incluyen auditorías periódicas para conformidad con SOC 2, asegurando que el modelo no perpetúe biases en código (e.g., discriminación en algoritmos de ML).

Beneficios operativos son evidentes en pipelines CI/CD, donde la IA acelera merges pull requests al sugerir fixes automáticos, reduciendo tiempo de ciclo en un 40% según reportes de GitHub.

Integración en Flujos de Trabajo de Desarrollo y Ciberseguridad

Integrar la IA en entornos de desarrollo requiere APIs RESTful o plugins para IDEs como VS Code o IntelliJ. Por ejemplo, un endpoint /generate acepta prompts como “Implementa un hash SHA-256 en Go” y retorna código validado. En ciberseguridad, el pipeline incluye escaneo post-generación con tools como OWASP ZAP para APIs o Trivy para contenedores.

Riesgos clave incluyen prompt injection attacks, mitigados mediante sanitización de inputs y rate limiting. Mejores prácticas: usar federated learning para entrenar sin centralizar datos sensibles, alineado con zero-trust architectures.

En blockchain, la IA puede generar smart contracts en Solidity, verificando idempotencia y resistencia a reentrancy via formal methods como Mythril. Implicaciones: mayor adopción en DeFi, con beneficios en auditoría automatizada.

Desafíos Éticos y Regulatorios en la Generación de Código con IA

Los desafíos éticos abarcan la propiedad intelectual: código generado puede derivar de fuentes con licencias restrictivas, requiriendo tracing via watermarks en tokens. Regulatoriamente, en la UE, el AI Act clasifica estos modelos como high-risk, exigiendo transparencia en datasets y evaluaciones de impacto.

Riesgos incluyen generación de malware inadvertido; contramedidas: fine-tuning con datasets negativos (código malicioso etiquetado). Beneficios: democratización del coding para no-expertos, fomentando innovación en IT.

Casos de Estudio y Aplicaciones Prácticas

En un caso de estudio hipotético basado en implementaciones reales, una empresa de fintech desarrolló un modelo para generar código de compliance en Python, integrando reglas KYC/AML. El modelo, fine-tuned en 50 GB de código regulado, redujo errores en un 60%, con integración en Jenkins para CI.

Otro ejemplo: en IA para ciberseguridad, generar scripts de detección de intrusiones en Snort rules, usando PLN para patrones de tráfico anómalo. Tecnologías: TensorFlow para entrenamiento, Kubernetes para deployment escalable.

En noticias de IT, herramientas como Amazon CodeWhisperer ilustran escalabilidad, procesando petabytes de datos con edge computing para latencia baja.

Optimizaciones Avanzadas y Futuras Direcciones

Optimizaciones incluyen quantization (reducir precisión a INT8 para inferencia 4x más rápida) y distillation (transferir conocimiento de modelos grandes a pequeños). Futuras direcciones: integración con quantum computing para optimización NP-hard en code gen, o multimodalidad (generar código desde diagramas UML via visión por computadora).

En blockchain, explorar IA para verificación de proofs en ZK-SNARKs, mejorando privacidad en transacciones.

Conclusión

El desarrollo de una inteligencia artificial para la generación de código transforma el panorama de la ingeniería de software, ofreciendo eficiencia, seguridad y escalabilidad en dominios como ciberseguridad e IA. Al abordar desafíos técnicos, éticos y regulatorios con rigor, estos sistemas no solo aceleran la innovación, sino que también fortalecen la resiliencia digital. Para más información, visita la fuente original. En resumen, la adopción estratégica de estas tecnologías promete un futuro donde la programación es colaborativa entre humanos y máquinas, impulsando avances sostenibles en el sector IT.