Detección de Deepfakes mediante Inteligencia Artificial en el Contexto de Ciberseguridad

Los deepfakes representan una de las amenazas más emergentes en el ámbito de la ciberseguridad, impulsadas por avances en inteligencia artificial que permiten la generación de contenidos audiovisuales falsos con un realismo perturbador. Estos artefactos digitales, creados mediante técnicas de aprendizaje profundo, pueden manipular videos, audios e imágenes para suplantar identidades, difundir desinformación o facilitar fraudes sofisticados. En este artículo, se analiza el panorama técnico de los deepfakes, sus implicaciones en la seguridad informática y las metodologías basadas en IA para su detección, con énfasis en protocolos, herramientas y mejores prácticas operativas.

Conceptos Fundamentales de los Deepfakes

Los deepfakes se originan en el uso de redes neuronales generativas antagónicas (GAN, por sus siglas en inglés: Generative Adversarial Networks), un marco propuesto por Ian Goodfellow en 2014. Este enfoque consiste en dos componentes principales: un generador que produce datos sintéticos y un discriminador que evalúa su autenticidad. A través de un entrenamiento iterativo, el generador mejora su capacidad para crear contenidos indistinguibles de los reales, mientras el discriminador afina su detección de anomalías.

En términos técnicos, las GAN se implementan comúnmente con arquitecturas como las redes convolucionales (CNN) para procesar imágenes y videos. Por ejemplo, el modelo Autoencoder, utilizado en herramientas como DeepFaceLab, emplea codificadores y decodificadores para mapear rostros de una persona fuente a un video objetivo. La ecuación básica del entrenamiento de una GAN se describe como un juego minimax: min_G max_D V(D,G) = E_{x~p_data(x)}[log D(x)] + E_{z~p_z(z)}[log(1 – D(G(z)))], donde G(z) representa la salida generada y D evalúa su verosimilitud.

Las implicaciones operativas de los deepfakes en ciberseguridad incluyen riesgos como el spoofing de identidad en videoconferencias, donde un atacante puede impersonar a un ejecutivo para autorizar transacciones fraudulentas. Según informes de la Agencia de Ciberseguridad de la Unión Europea (ENISA), los deepfakes han contribuido a un aumento del 300% en incidentes de ingeniería social entre 2020 y 2023. Además, en entornos regulatorios, normativas como el Reglamento General de Protección de Datos (GDPR) exigen mecanismos de verificación para mitigar daños a la privacidad.

Tecnologías Subyacentes en la Generación de Deepfakes

La generación de deepfakes depende de bibliotecas de código abierto como TensorFlow y PyTorch, que facilitan el entrenamiento de modelos en hardware con unidades de procesamiento gráfico (GPU). Un flujo típico involucra preprocesamiento de datos, donde se extraen landmarks faciales usando bibliotecas como Dlib o MediaPipe, seguidas de alineación y warping para superponer rasgos faciales.

En el audio, técnicas como WaveNet o Tacotron 2 permiten sintetizar voces con entonación natural, integrando espectrogramas mel y vocoders para reconstruir ondas sonoras. Por instancia, el modelo SV2TTS (Speaker Verification to Text-to-Speech) de Respeecher utiliza embeddings de voz para clonar patrones vocales con precisión superior al 95% en pruebas controladas.

Los riesgos asociados incluyen vulnerabilidades en sistemas de autenticación biométrica. En blockchain, donde la verificación de identidad es crítica, deepfakes podrían comprometer protocolos como los de KYC (Know Your Customer) en exchanges de criptomonedas, potencialmente facilitando lavado de dinero. Beneficios, por otro lado, radican en aplicaciones legítimas como la restauración de archivos históricos o la simulación en entrenamiento médico, siempre que se implementen salvaguardas éticas.

Metodologías de Detección Basadas en IA

La detección de deepfakes requiere enfoques multifacéticos que combinen análisis forense digital con modelos de machine learning. Una estrategia principal es la inspección de artefactos visuales, como inconsistencias en el parpadeo ocular o irregularidades en la iluminación, detectadas mediante CNN entrenadas en datasets como FaceForensics++ o DFDC (DeepFake Detection Challenge).

En detalle, modelos como MesoNet, desarrollado por investigadores de la Universidad de Albany, clasifican frames de video analizando patrones mesoscópicos en la piel y texturas. Su arquitectura incluye capas convolucionales con activaciones ReLU y pooling máximo, logrando tasas de precisión del 98% en conjuntos de prueba. La fórmula de pérdida comúnmente usada es la entropía cruzada binaria: L = -[y log(p) + (1-y) log(1-p)], donde y es la etiqueta real y p la predicción probabilística.

Otra aproximación involucra análisis de frecuencia. Los deepfakes a menudo introducen ruido de alta frecuencia debido a la compresión durante la generación. Herramientas como F3-Net (Frequency Forgery Network) aplican transformadas de Fourier para identificar discrepancias espectrales, con umbrales adaptativos basados en umbrales de ruido de fondo. En implementaciones prácticas, se integra con OpenCV para extracción de frames y scikit-learn para validación cruzada.

- Análisis Biométrico: Monitoreo de microexpresiones y patrones de respiración, utilizando modelos de visión por computadora como OpenPose para segmentación corporal.

- Detección de Audio: Empleo de espectrogramas y redes recurrentes (RNN) como LSTM para detectar discontinuidades en el flujo de voz, con herramientas como Librosa para procesamiento de señales.

- Enfoques Híbridos: Combinación de IA con blockchain para timestamps inmutables, asegurando trazabilidad en videos verificados mediante hashes SHA-256.

En entornos empresariales, soluciones como las de InfoWatch integran estas metodologías en plataformas DLP (Data Loss Prevention), escaneando flujos de datos en tiempo real. Por ejemplo, un sistema podría emplear APIs de Microsoft Azure Face API para verificación inicial, seguida de un modelo personalizado entrenado con transfer learning desde ResNet-50.

Implicaciones Operativas y Regulatorias

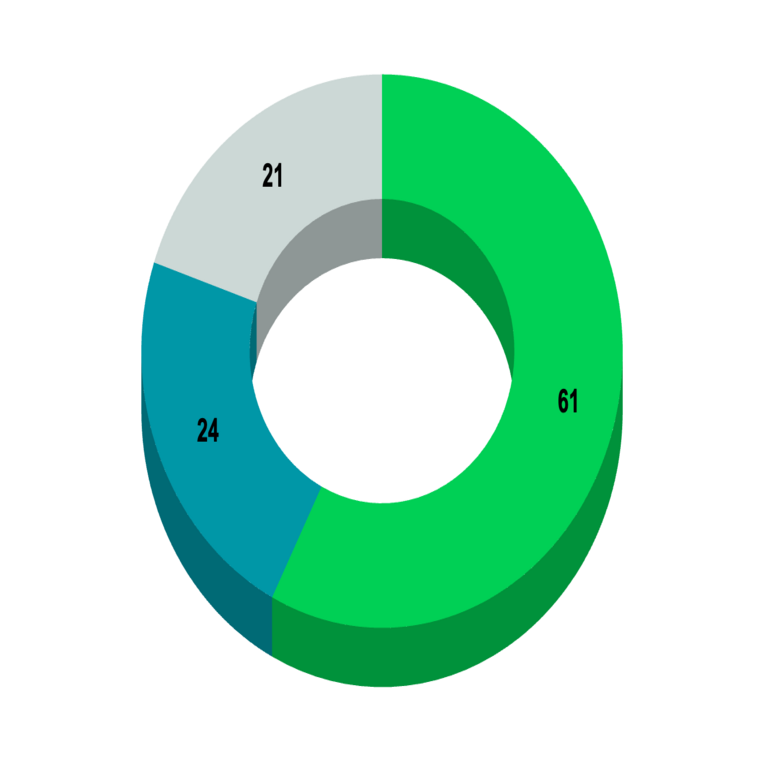

Desde una perspectiva operativa, la implementación de detectores de deepfakes exige infraestructura robusta, incluyendo clústeres de cómputo en la nube con soporte para paralelismo distribuido via frameworks como Horovod. Los costos computacionales son significativos; un entrenamiento típico en una GPU NVIDIA A100 puede requerir hasta 100 horas para datasets de 10,000 muestras.

Regulatoriamente, la directiva NIS2 de la UE (Network and Information Systems Directive) obliga a operadores críticos a desplegar herramientas de detección contra manipulaciones digitales. En América Latina, marcos como la Ley de Protección de Datos Personales en México (LFPDPPP) enfatizan la responsabilidad en la verificación de contenidos biométricos. Riesgos incluyen falsos positivos, que podrían bloquear comunicaciones legítimas, mitigados mediante calibración de umbrales con métricas como AUC-ROC (Area Under the Curve – Receiver Operating Characteristic).

Beneficios operativos abarcan la mejora en la resiliencia cibernética. En sectores como el financiero, la detección temprana previene pérdidas estimadas en miles de millones, según un estudio de Deloitte que proyecta un impacto global de 250 mil millones de dólares anuales por deepfakes para 2027.

Herramientas y Frameworks Prácticos para Detección

Entre las herramientas disponibles, Deepware Scanner ofrece una interfaz web para análisis automatizado, utilizando modelos preentrenados en PyTorch. Su pipeline incluye extracción de features con VGG16 y clasificación con SVM (Support Vector Machines), con soporte para batch processing en entornos de alto volumen.

En código abierto, el repositorio de GitHub para FakeSpotter implementa detección basada en atención, empleando transformers como ViT (Vision Transformer) para capturar dependencias globales en frames. La integración con Docker permite despliegues escalables, con comandos como docker run -v /local/data:/app/data fakespotter:latest para procesamiento offline.

Para audio, herramientas como Adobe’s Content Authenticity Initiative (CAI) incorporan metadatos C2PA (Content Provenance and Authenticity), un estándar que embebe firmas digitales en archivos multimedia, verificables mediante APIs RESTful. En blockchain, plataformas como Verasity utilizan NFTs para certificar autenticidad, con smart contracts en Ethereum que validan hashes contra bases de datos distribuidas.

| Herramienta | Tecnología Base | Precisión Reportada | Aplicación Principal |

|---|---|---|---|

| MesoNet | CNN | 98% | Detección Visual |

| F3-Net | Análisis de Frecuencia | 95% | Identificación de Artefactos |

| SV2TTS Detector | RNN/LSTM | 92% | Análisis de Audio |

| Deepware Scanner | PyTorch + SVM | 96% | Escaneo Automatizado |

Estas herramientas deben integrarse en pipelines CI/CD (Continuous Integration/Continuous Deployment) para actualizaciones continuas, utilizando datasets actualizados como Celeb-DF para contrarrestar evoluciones en generadores de deepfakes.

Desafíos Técnicos y Estrategias de Mitigación

Uno de los principales desafíos es la adversarialidad: generadores de deepfakes pueden entrenarse para evadir detectores, utilizando técnicas como Fast Gradient Sign Method (FGSM) para perturbaciones imperceptibles. La ecuación de FGSM es x_adv = x + ε * sign(∇_x J(θ, x, y)), donde ε controla la magnitud de la perturbación y J es la función de pérdida.

Para mitigar esto, se recomiendan enfoques de robustez como el entrenamiento adversario, donde detectores se exponen a muestras perturbadas durante el fine-tuning. Otro reto es la escalabilidad; en redes sociales, procesar millones de videos diarios