Implementación de Microservicios en Sistemas Monolíticos: Un Enfoque Técnico Detallado

Introducción a la Arquitectura de Microservicios

La transición de arquitecturas monolíticas a modelos basados en microservicios representa uno de los paradigmas más significativos en el desarrollo de software moderno. En un sistema monolítico tradicional, todas las componentes de una aplicación se integran en un único ejecutable, lo que facilita el desarrollo inicial pero genera desafíos en escalabilidad, mantenimiento y despliegue a medida que el sistema crece. Los microservicios, por el contrario, descomponen la aplicación en servicios independientes y autónomos que se comunican a través de interfaces bien definidas, típicamente APIs RESTful o protocolos de mensajería asíncrona.

Este enfoque permite una mayor modularidad, donde cada microservicio puede ser desarrollado, desplegado y escalado de manera independiente. Tecnologías como contenedores Docker y orquestadores como Kubernetes han facilitado esta migración, permitiendo entornos de despliegue consistentes y automatizados. En el contexto de la ciberseguridad, esta arquitectura introduce consideraciones adicionales, como la segmentación de redes para mitigar riesgos de propagación de vulnerabilidades y la implementación de autenticación distribuida mediante protocolos como OAuth 2.0 o JWT (JSON Web Tokens).

El análisis de implementaciones reales revela que la adopción de microservicios no es un proceso binario, sino gradual. Muchas organizaciones comienzan con un monolito y evolucionan hacia microservicios mediante estrategias como el “strangler pattern”, que implica envolver el monolito existente con nuevos servicios que gradualmente lo reemplazan. Este método minimiza interrupciones en el servicio y permite una evaluación continua de los beneficios operativos.

Conceptos Clave en la Migración de Monolitos a Microservicios

La extracción de conceptos clave de experiencias prácticas en la implementación de microservicios destaca la importancia de definir límites de servicio claros. Un microservicio ideal debe adherirse al principio de responsabilidad única, enfocándose en un dominio de negocio específico. Por ejemplo, en un sistema de e-commerce, un microservicio podría manejar el catálogo de productos, mientras que otro gestiona el procesamiento de pagos, utilizando bases de datos independientes para evitar acoplamientos.

Desde el punto de vista técnico, la comunicación entre microservicios requiere patrones robustos. El uso de API Gateway, como Kong o AWS API Gateway, actúa como punto de entrada único, manejando enrutamiento, rate limiting y autenticación. En términos de persistencia de datos, se recomienda el patrón de base de datos por servicio, donde cada microservicio posee su propia base de datos, posiblemente utilizando tecnologías como PostgreSQL para transaccionales o MongoDB para NoSQL, asegurando aislamiento y consistencia eventual mediante sagas o patrones de compensación para transacciones distribuidas.

La observabilidad es crucial en entornos de microservicios. Herramientas como Prometheus para métricas, Grafana para visualización y ELK Stack (Elasticsearch, Logstash, Kibana) para logging permiten monitorear el rendimiento y detectar anomalías. En ciberseguridad, la integración de herramientas como Falco para detección de comportamientos anómalos en contenedores añade una capa de protección contra amenazas internas y externas.

- Desacoplamiento de componentes: Cada servicio opera de forma independiente, reduciendo el impacto de fallos locales mediante circuit breakers implementados con bibliotecas como Hystrix o Resilience4j.

- Escalabilidad horizontal: Servicios individuales pueden escalarse según demanda, utilizando Kubernetes para autoescalado basado en métricas de CPU o memoria.

- Despliegue continuo: CI/CD pipelines con Jenkins o GitLab CI facilitan actualizaciones frecuentes sin downtime, empleando estrategias de blue-green deployment.

Desafíos Técnicos en la Implementación

Uno de los principales desafíos en la migración es la complejidad operativa. En un monolito, las dependencias son centralizadas, pero en microservicios, la gestión de configuraciones distribuidas requiere herramientas como Consul o etcd para discovery de servicios y configuración dinámica. La latencia introducida por la comunicación en red puede degradar el rendimiento, por lo que optimizaciones como gRPC para RPC binarios o caching con Redis son esenciales.

En el ámbito de la inteligencia artificial, la integración de microservicios con modelos de IA añade capas de complejidad. Por instancia, un microservicio dedicado a inferencia de machine learning podría utilizar TensorFlow Serving o ONNX Runtime para desplegar modelos, comunicándose con otros servicios vía Kafka para flujos de datos en tiempo real. Esto exige consideraciones de seguridad, como el cifrado de datos en tránsito con TLS 1.3 y la validación de integridad mediante hashes SHA-256.

Los riesgos regulatorios también emergen, especialmente en industrias como finanzas o salud, donde normativas como GDPR o HIPAA demandan trazabilidad y privacidad. La implementación de microservicios debe incorporar principios de zero-trust architecture, verificando cada solicitud independientemente, y auditorías regulares para cumplir con estándares como ISO 27001.

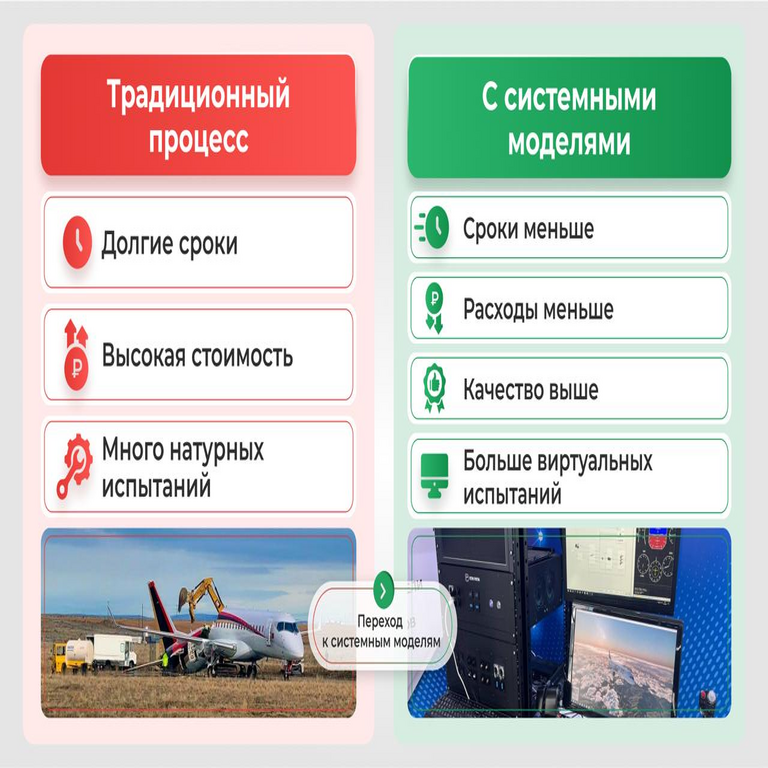

Tabla de comparación entre arquitecturas monolíticas y de microservicios:

| Aspecto | Monolítico | Microservicios |

|---|---|---|

| Escalabilidad | Vertical, limitada por hardware único | Horizontal, por servicio independiente |

| Mantenimiento | Despliegues globales riesgosos | Actualizaciones locales, menor riesgo |

| Complejidad | Baja inicial, alta en crecimiento | Alta inicial, optimizada en madurez |

| Seguridad | Punto único de fallo | Segmentación, pero más superficies de ataque |

Implicaciones Operativas y de Riesgos

Operativamente, la adopción de microservicios impacta en la organización del equipo. El modelo de Conway sugiere que la estructura del equipo debe alinear con los límites de servicios, fomentando equipos autónomos que posean el ciclo de vida completo de un microservicio. Esto reduce bottlenecks en desarrollo, pero requiere madurez en DevOps para manejar operaciones distribuidas.

En términos de riesgos, la proliferación de servicios aumenta la superficie de ataque. Vulnerabilidades como inyecciones SQL en un servicio pueden propagarse si no se aíslan adecuadamente. Mitigaciones incluyen firewalls de aplicación web (WAF) como ModSecurity y escaneo continuo de vulnerabilidades con herramientas como OWASP ZAP o Trivy para contenedores. Además, el manejo de datos sensibles exige anonimización y tokenización en microservicios que procesan información personal.

Beneficios notables incluyen la resiliencia mejorada mediante patrones como bulkheads, que limitan recursos por servicio para prevenir cascadas de fallos, y la facilitación de innovación, permitiendo experimentación con tecnologías emergentes como blockchain para integridad de datos en servicios distribuidos. Por ejemplo, la integración de Hyperledger Fabric en un microservicio de transacciones asegura inmutabilidad y trazabilidad sin comprometer la performance general.

En el contexto de IA, microservicios permiten la escalabilidad de workloads computacionales intensivos. Un servicio de entrenamiento de modelos podría utilizar GPU clusters en Kubernetes, mientras que la inferencia se distribuye en edge computing para latencia baja, alineándose con estándares como NVIDIA Triton Inference Server.

Estrategias Prácticas de Implementación

Para una implementación exitosa, se recomienda un enfoque iterativo. Inicie con la identificación de módulos candidatos para extracción del monolito, utilizando métricas como acoplamiento y cohesión para priorizar. Herramientas como Structure101 ayudan a visualizar dependencias y refactorizar código legacy.

El despliegue inicial puede involucrar sidecar patterns en Istio para service mesh, manejando tráfico, seguridad y observabilidad de manera declarativa. Para testing, adopte pruebas de contrato con Pact para asegurar compatibilidad entre servicios, complementadas con chaos engineering usando Gremlin para simular fallos y validar resiliencia.

En blockchain, si se integra, microservicios pueden interactuar con nodos via SDKs como Web3.js para Ethereum, permitiendo smart contracts que gestionen accesos descentralizados, reduciendo reliance en autoridades centrales y mejorando ciberseguridad mediante criptografía asimétrica.

- Planificación: Mapear dependencias y definir APIs con OpenAPI Specification para documentación estandarizada.

- Desarrollo: Usar lenguajes poliglota, como Java para servicios transaccionales y Node.js para I/O intensivo.

- Seguridad: Implementar RBAC (Role-Based Access Control) y mTLS (mutual TLS) para comunicaciones internas.

- Monitoreo: Integrar tracing distribuido con Jaeger para correlacionar requests across servicios.

Casos de Estudio y Lecciones Aprendidas

Experiencias reales demuestran que la migración puede reducir tiempos de despliegue de semanas a horas. En un caso hipotético basado en prácticas industriales, una empresa de telecomunicaciones extrajo servicios de billing del monolito principal, resultando en un 40% de mejora en escalabilidad durante picos de tráfico. Lecciones incluyen la necesidad de invertir en capacitación para equipos en conceptos distribuidos y la evitación de “nanoservicios” que fragmentan excesivamente, incrementando overhead de red.

En IA, un microservicio para recomendación personalizada utilizando algoritmos de deep learning como BERT puede procesar datos en streaming con Apache Flink, asegurando privacidad mediante federated learning para entrenar modelos sin centralizar datos sensibles.

Respecto a noticias de IT, tendencias recientes destacan la convergencia con serverless computing, donde microservicios se despliegan en AWS Lambda o Azure Functions, eliminando gestión de infraestructura y optimizando costos bajo pago por uso.

Conclusión

La implementación de microservicios en sistemas monolíticos ofrece un camino hacia arquitecturas más ágiles y resilientes, con beneficios significativos en escalabilidad, mantenimiento y seguridad. Sin embargo, exige una planificación meticulosa para mitigar complejidades inherentes. Al adoptar mejores prácticas y herramientas estándar, las organizaciones pueden navegar esta transición efectivamente, impulsando innovación en ciberseguridad, IA y tecnologías emergentes. En resumen, este paradigma no solo resuelve limitaciones de monolitos sino que posiciona a las empresas para futuros desafíos tecnológicos.

Para más información, visita la fuente original.