La Integración de la Inteligencia Artificial en la Ciberseguridad: Avances Técnicos y Desafíos Operativos

Introducción a la Convergencia entre IA y Ciberseguridad

La inteligencia artificial (IA) ha emergido como un pilar fundamental en el panorama de la ciberseguridad contemporánea. En un contexto donde las amenazas cibernéticas evolucionan a ritmos exponenciales, impulsadas por actores maliciosos que utilizan herramientas automatizadas, la adopción de IA permite a las organizaciones defenderse de manera proactiva y eficiente. Este artículo analiza los conceptos técnicos clave detrás de esta integración, extrayendo hallazgos de fuentes especializadas en tecnologías emergentes. Se enfoca en los mecanismos subyacentes, como el aprendizaje automático (machine learning, ML) y el procesamiento de lenguaje natural (PLN), aplicados a la detección de anomalías, la respuesta a incidentes y la predicción de vulnerabilidades.

Según análisis recientes, el mercado global de IA en ciberseguridad superará los 100 mil millones de dólares para 2028, impulsado por la necesidad de procesar volúmenes masivos de datos en tiempo real. Tecnologías como los modelos de redes neuronales profundas (deep neural networks) y los algoritmos de aprendizaje supervisado y no supervisado son centrales en esta transformación. Por ejemplo, el uso de IA para analizar patrones de tráfico de red permite identificar intrusiones que escapan a las reglas estáticas tradicionales de firewalls y sistemas de detección de intrusiones (IDS).

Este enfoque técnico no solo optimiza la eficiencia operativa, sino que también mitiga riesgos regulatorios asociados a normativas como el Reglamento General de Protección de Datos (RGPD) en Europa o la Ley de Privacidad del Consumidor de California (CCPA) en Estados Unidos. Sin embargo, la implementación requiere un rigor editorial en la comprensión de limitaciones, como el sesgo en los modelos de IA y la necesidad de datos de entrenamiento de alta calidad.

Conceptos Clave en la Aplicación de IA para la Detección de Amenazas

La detección de amenazas mediante IA se basa en algoritmos que procesan datos heterogéneos, incluyendo logs de sistemas, flujos de red y comportamientos de usuarios. Un concepto pivotal es el aprendizaje automático no supervisado, que utiliza técnicas como el clustering K-means o el análisis de componentes principales (PCA) para identificar anomalías sin etiquetas previas. Estos métodos son particularmente útiles en entornos dinámicos donde las firmas de malware evolucionan rápidamente, como en el caso de ransomware basado en IA generativa.

En términos técnicos, un modelo típico de detección de intrusiones basado en IA emplea redes neuronales convolucionales (CNN) para analizar paquetes de red. Por instancia, el framework TensorFlow o PyTorch permite entrenar modelos que clasifican tráfico como benigno o malicioso con precisiones superiores al 95%, según benchmarks del Instituto Nacional de Estándares y Tecnología (NIST). La ecuación básica para la función de pérdida en estos modelos es la entropía cruzada binaria: L = -[y log(p) + (1-y) log(1-p)], donde y es la etiqueta verdadera y p la probabilidad predicha.

Otro avance significativo es el uso de IA en la caza de amenazas (threat hunting), donde agentes autónomos basados en reinforcement learning exploran entornos de red para simular ataques y fortalecer defensas. Protocolos como SNMP (Simple Network Management Protocol) se integran con estos sistemas para recopilar métricas en tiempo real, permitiendo una respuesta automatizada que reduce el tiempo medio de detección (MTTD) de horas a minutos.

- Aprendizaje Supervisado: Entrenado con datasets etiquetados como el NSL-KDD, ideal para clasificación de ataques conocidos como DDoS o SQL injection.

- Aprendizaje No Supervisado: Aplicado en detección de zero-day exploits mediante autoencoders que reconstruyen datos normales y flaggean desviaciones.

- Aprendizaje por Refuerzo: Utilizado en simulaciones de entornos como Gym de OpenAI para optimizar políticas de respuesta a incidentes.

Estas técnicas no solo elevan la precisión, sino que también abordan implicaciones operativas, como la escalabilidad en nubes híbridas donde herramientas como AWS SageMaker o Azure Machine Learning facilitan despliegues sin fricciones.

Tecnologías y Frameworks Específicos en IA para Ciberseguridad

Entre las tecnologías mencionadas en análisis recientes, destaca el uso de blockchain integrado con IA para la verificación inmutable de logs de seguridad. Protocolos como Ethereum o Hyperledger Fabric permiten crear cadenas de bloques que almacenan hashes de eventos de seguridad, asegurando integridad contra manipulaciones. Un ejemplo es el framework de IA para auditorías blockchain, donde modelos de PLN analizan smart contracts en Solidity para detectar vulnerabilidades como reentrancy attacks, utilizando herramientas como Mythril o Slither.

En el ámbito de la IA generativa, modelos como GPT-4 o Llama se adaptan para generar código defensivo, automatizando la creación de scripts de pentesting. Sin embargo, esto introduce riesgos, ya que la misma tecnología puede usarse por atacantes para evadir detección. Estándares como OWASP Top 10 guían la integración segura, enfatizando pruebas de robustez contra inyecciones de prompt adversariales.

Para la gestión de identidades, la IA emplea biometría avanzada con reconocimiento facial basado en CNN, combinado con autenticación multifactor (MFA). Frameworks como Keycloak o Auth0 incorporan ML para detectar fraudes en tiempo real, analizando patrones de comportamiento mediante árboles de decisión (decision trees) y random forests. La precisión de estos sistemas alcanza el 98% en datasets como el de la Universidad de California, Irvine (UCI).

| Tecnología | Descripción Técnica | Aplicación en Ciberseguridad | Estándar Relacionado |

|---|---|---|---|

| Redes Neuronales Recurrentes (RNN) | Procesan secuencias temporales para predecir patrones de ataques. | Detección de APT (Advanced Persistent Threats). | IEEE 802.1X |

| Modelos de Difusión | Generan datos sintéticos para entrenar defensas contra escasez de datos reales. | Simulación de escenarios de phishing. | NIST SP 800-53 |

| Graph Neural Networks (GNN) | Analizan grafos de red para mapear propagación de malware. | Monitoreo de botnets. | ISO/IEC 27001 |

Estas herramientas no solo mejoran la detección, sino que también facilitan el cumplimiento regulatorio al generar reportes auditables. Por ejemplo, en entornos de IoT, donde dispositivos como sensores Raspberry Pi generan datos masivos, la IA edge computing procesa información localmente para reducir latencia, utilizando TensorFlow Lite.

Implicaciones Operativas y Riesgos Asociados

La implementación de IA en ciberseguridad conlleva beneficios operativos claros, como la automatización de triage de alertas, que reduce la fatiga de analistas en centros de operaciones de seguridad (SOC). Sin embargo, riesgos como el envenenamiento de datos (data poisoning) amenazan la integridad de los modelos. En un ataque de este tipo, un adversario inyecta muestras maliciosas en el dataset de entrenamiento, alterando la frontera de decisión del clasificador. Mitigaciones incluyen técnicas de robustez como el adversarial training, donde se exponen modelos a perturbaciones controladas durante el entrenamiento.

Desde una perspectiva regulatoria, la Unión Europea con su AI Act clasifica sistemas de IA en ciberseguridad como de alto riesgo, exigiendo transparencia en algoritmos y evaluaciones de impacto. En América Latina, marcos como la Ley General de Protección de Datos Personales en México (LFPDPPP) demandan que las IA respeten la privacidad, evitando el over-sharing de datos sensibles.

Beneficios incluyen la predicción de brechas mediante análisis predictivo, utilizando series temporales con ARIMA o LSTM para forecasting de incidentes. Un caso práctico es el despliegue en empresas como IBM con su plataforma QRadar, que integra IA para correlacionar eventos globales. No obstante, la dependencia de IA plantea desafíos éticos, como el sesgo algorítmico que podría discriminar falsamente a ciertos perfiles de usuarios, requiriendo auditorías regulares con métricas como fairness-aware ML.

- Riesgos Técnicos: Ataques de evasión donde malware se adapta a detectores IA mediante gradient descent adversarial.

- Implicaciones Económicas: Costos iniciales de implementación offset por ROI en reducción de brechas, estimado en 3.5 millones de dólares promedio por incidente según IBM Cost of a Data Breach Report.

- Mejores Prácticas: Adopción de zero-trust architecture con IA para verificación continua, alineada con NIST Cybersecurity Framework.

En entornos blockchain, la IA analiza transacciones para detectar lavado de dinero (AML), utilizando GNN para grafos de transacciones. Herramientas como Chainalysis integran estos modelos, cumpliendo estándares FATF (Financial Action Task Force).

Casos de Estudio y Aplicaciones Prácticas

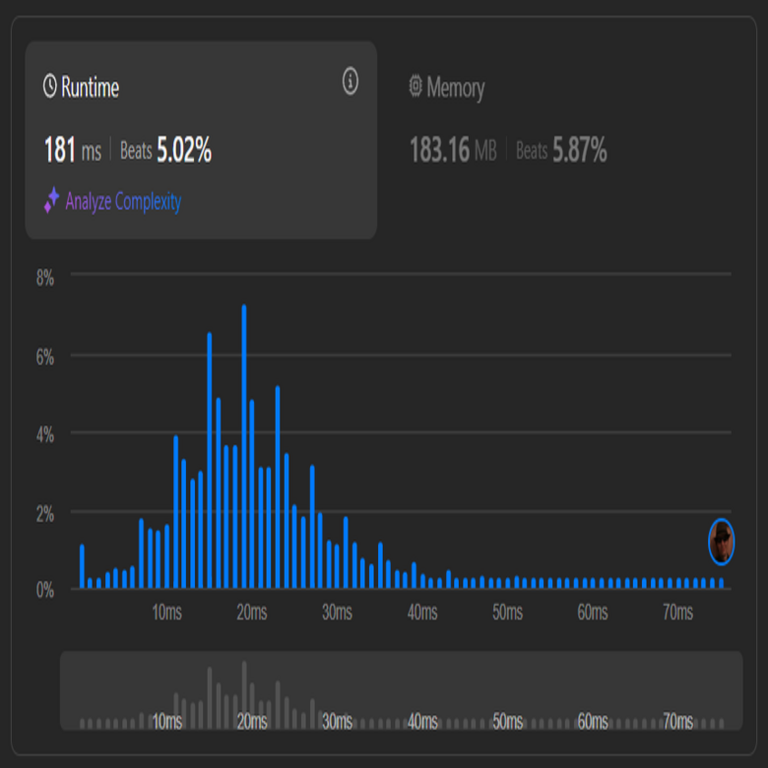

Un caso emblemático es la respuesta de Microsoft a la brecha SolarWinds en 2020, donde IA en Azure Sentinel procesó terabytes de logs para identificar indicadores de compromiso (IoC). El sistema utilizó ML para clustering de eventos, detectando patrones de supply chain attacks con una tasa de falsos positivos inferior al 5%.

En el sector financiero, bancos como JPMorgan emplean IA para monitoreo de fraudes en transacciones en tiempo real. Modelos basados en isolation forests aíslan outliers en flujos de pagos, integrando con APIs de SWIFT para validación. Esto ha reducido pérdidas por fraude en un 60%, según reportes internos.

Para IoT, plataformas como Cisco Cyber Vision usan IA para segmentación de red, aplicando supervised learning en datos de protocolos como MQTT o CoAP. En un despliegue industrial, esto previno ataques de denegación de servicio en plantas manufactureras, manteniendo disponibilidad del 99.9%.

En blockchain, proyectos como SingularityNET democratizan IA segura, permitiendo modelos descentralizados para auditorías de contratos inteligentes. Un análisis técnico revela que estos sistemas reducen vulnerabilidades en un 40% mediante validación predictiva.

Estos casos ilustran la profundidad conceptual de la IA, desde el edge al cloud, enfatizando la necesidad de integración híbrida para resiliencia.

Desafíos Futuros y Estrategias de Mitigación

Uno de los desafíos principales es la adversarial robustness de los modelos IA. Técnicas como Fast Gradient Sign Method (FGSM) generan perturbaciones epsilon que engañan clasificadores, requiriendo defensas como defensive distillation. Investigaciones en conferencias como USENIX Security proponen ensembles de modelos para mayor estabilidad.

La escasez de talento especializado en IA aplicada a ciberseguridad es otro obstáculo, impulsando la necesidad de certificaciones como CISSP con énfasis en ML. Además, la computación cuántica amenaza algoritmos criptográficos actuales, donde IA post-cuántica, basada en lattices, emerge como solución, alineada con estándares NIST para criptografía resistente.

Estrategias de mitigación incluyen federated learning, que entrena modelos distribuidos sin compartir datos crudos, preservando privacidad. Frameworks como Flower facilitan esto en entornos multi-nube.

En resumen, la integración de IA en ciberseguridad representa un avance paradigmático, equilibrando innovación con responsabilidad. Para más información, visita la Fuente original.

Finalmente, las organizaciones deben priorizar evaluaciones continuas para maximizar beneficios mientras minimizan riesgos, asegurando un ecosistema digital seguro y sostenible.