Implementación de un Sistema de Recomendación Basado en Inteligencia Artificial

Los sistemas de recomendación representan un componente fundamental en las aplicaciones modernas de software, especialmente en plataformas de comercio electrónico, streaming de contenidos y redes sociales. Estos sistemas utilizan algoritmos de inteligencia artificial (IA) para analizar patrones de comportamiento de los usuarios y sugerir ítems relevantes, mejorando la experiencia del usuario y optimizando las métricas de engagement. En este artículo, se explora la implementación técnica de un sistema de recomendación basado en IA, enfocándonos en enfoques como el filtrado colaborativo, el filtrado basado en contenido y modelos híbridos que incorporan aprendizaje profundo. Se detalla el proceso paso a paso, incluyendo la preparación de datos, selección de algoritmos, entrenamiento de modelos y evaluación de rendimiento, con énfasis en prácticas recomendadas para entornos de producción.

Conceptos Fundamentales de los Sistemas de Recomendación

Los sistemas de recomendación se clasifican principalmente en tres categorías: filtrado colaborativo, filtrado basado en contenido y enfoques híbridos. El filtrado colaborativo opera bajo el principio de que usuarios con preferencias similares en el pasado tenderán a tener gustos similares en el futuro. Este método no requiere conocimiento explícito sobre los ítems o usuarios, sino que se basa en la matriz de interacciones usuario-ítem, comúnmente representada como una matriz dispersa donde las filas corresponden a usuarios, las columnas a ítems y los valores a calificaciones o interacciones implícitas, como clics o vistas.

En contraste, el filtrado basado en contenido construye perfiles de ítems utilizando características descriptivas, como metadatos (género, autor, etiquetas) o representaciones vectoriales derivadas de técnicas de procesamiento de lenguaje natural (PLN). Para un usuario, se recomienda ítems similares a aquellos que ha interactuado positivamente, midiendo similitud mediante métricas como la distancia coseno o la similitud de Jaccard.

Los modelos híbridos combinan ambos enfoques para mitigar limitaciones inherentes, como el problema de arranque en frío (cold start), donde usuarios o ítems nuevos carecen de datos históricos. La integración de aprendizaje profundo, mediante redes neuronales como autoencoders o grafos neuronales, permite capturar interacciones no lineales y representaciones latentes más ricas, mejorando la precisión en datasets grandes y complejos.

Preparación y Procesamiento de Datos

El primer paso en la implementación es la adquisición y preprocesamiento de datos. Se requiere un dataset que incluya interacciones usuario-ítem, como el conjunto MovieLens, que contiene calificaciones de películas por usuarios, o datasets personalizados de logs de aplicaciones. En Python, bibliotecas como Pandas facilitan la carga y manipulación de datos. Por ejemplo, se carga un archivo CSV con columnas ‘user_id’, ‘item_id’ y ‘rating’, y se filtra para eliminar outliers o valores nulos.

La matriz de interacciones se construye utilizando SciPy para manejar su dispersidad, ya que en escenarios reales, la mayoría de las entradas son cero. Técnicas de imputación, como el llenado con la media global de calificaciones, ayudan a densificar la matriz sin introducir sesgos significativos. Además, se aplican transformaciones como la codificación one-hot para características categóricas o la normalización Min-Max para escalar ratings entre 0 y 1, preparando los datos para algoritmos de machine learning.

Para datasets grandes, se implementa particionamiento en entrenamiento y prueba, típicamente en una proporción 80/20, utilizando validación cruzada temporal si las interacciones tienen un orden cronológico. Esto asegura que el modelo generalice bien y evite el sobreajuste (overfitting), evaluando métricas como el error cuadrático medio (RMSE) o la precisión en top-K recomendaciones.

Implementación del Filtrado Colaborativo

El filtrado colaborativo se implementa mediante factorización de matrices, descomponiendo la matriz de interacciones en factores latentes de usuarios y ítems. El algoritmo de Factorización de Matrices (MF) minimiza la función de pérdida, como el error cuadrático, utilizando gradiente descendente estocástico (SGD). En bibliotecas como Surprise, un wrapper para scikit-learn, se configura un modelo SVD (Singular Value Decomposition) con hiperparámetros como el número de factores latentes (k=50) y la tasa de aprendizaje (lr=0.005).

El código básico en Python involucra la creación de un Dataset de Surprise, el entrenamiento con fit() y la generación de predicciones con predict(). Para similitud basada en vecinos, se usa KNN (K-Nearest Neighbors), calculando distancias entre vectores de usuarios o ítems. La similitud de Pearson se prefiere para calificaciones centradas, mientras que la similitud coseno es robusta para datos binarios.

En términos de complejidad computacional, MF tiene una complejidad O(n * m * k * i), donde n es el número de usuarios, m de ítems, k factores y i iteraciones. Para escalabilidad, se emplean aproximaciones como ALS (Alternating Least Squares) en frameworks distribuidos como Apache Spark MLlib, permitiendo procesamiento en clústeres Hadoop.

- Selección de k: Valores entre 20 y 100 equilibran precisión y tiempo de cómputo.

- Regularización: Parámetros lambda (0.02) previenen overfitting al penalizar normas L2 de factores.

- Evaluación: RMSE inferior a 0.9 indica buen rendimiento en datasets como MovieLens 100K.

Filtrado Basado en Contenido con Representaciones Vectoriales

Este enfoque requiere extraer características de ítems. Para textos descriptivos, se aplica TF-IDF (Term Frequency-Inverse Document Frequency) con scikit-learn’s TfidfVectorizer, generando vectores dispersos que capturan la importancia relativa de términos. La similitud se computa eficientemente con sklearn.metrics.pairwise.cosine_similarity, produciendo una matriz de similitudes para recomendaciones rápidas.

Para mejorar la representación, se integran embeddings de palabras como Word2Vec o BERT, preentrenados en corpus grandes. BERT, basado en transformers, genera contextualizaciones semánticas profundas, permitiendo similitudes más precisas en dominios como recomendaciones de noticias o productos. La implementación involucra la tokenización del texto, el paso por el modelo Hugging Face Transformers y la agregación de embeddings por pooling (media o máxima).

En el lado del usuario, se construye un perfil como la suma ponderada de embeddings de ítems interactuados, normalizado por frecuencia. Recomendaciones se generan seleccionando ítems con mayor similitud coseno al perfil del usuario, filtrando por interacciones previas para evitar repeticiones.

Modelos Híbridos e Integración de Aprendizaje Profundo

Los modelos híbridos fusionan señales de filtrado colaborativo y basado en contenido. Un enfoque común es el modelo de Wide & Deep de Google, que combina una red lineal (wide) para memorización de interacciones pasadas con una red profunda (deep) para generalización. En TensorFlow o PyTorch, se define una arquitectura con capas densas para el componente deep y concatenación de features para el wide, optimizando con Adam y pérdida MSE.

Para capturar dependencias secuenciales, se emplean redes neuronales recurrentes (RNN) como LSTM, modelando secuencias de interacciones pasadas para predecir la siguiente. En bibliotecas como Keras, se configura un modelo Sequential con capas LSTM (unidades=128) seguidas de Dense para salida de probabilidad sobre ítems. La pérdida categórica cruzada entropía se usa para recomendaciones top-K.

Otro avance es el uso de grafos de conocimiento, representando usuarios e ítems como nodos y interacciones como aristas. Modelos como Graph Neural Networks (GNN) con PyTorch Geometric propagan información a través de capas de convolución gráfica, aprendiendo embeddings que incorporan estructura relacional. Esto es particularmente efectivo en e-commerce, donde relaciones como “producto similar” enriquecen las recomendaciones.

| Modelo | Ventajas | Desventajas | Herramientas |

|---|---|---|---|

| Filtrado Colaborativo (MF) | Alta precisión en usuarios activos; no requiere features de ítems | Sensible a cold start; escalabilidad limitada en datasets muy grandes | Surprise, scikit-learn |

| Filtrado Basado en Contenido | Robusto a cold start para ítems nuevos; interpretable | Requiere features de calidad; ignora preferencias colaborativas | scikit-learn, Gensim |

| Híbrido con Deep Learning | Mejor generalización; maneja no linealidades | Alto costo computacional; black-box | TensorFlow, PyTorch |

Evaluación y Métricas de Rendimiento

La evaluación de sistemas de recomendación va más allá de métricas de regresión. Para rankings, se usa Precision@K, que mide la fracción de recomendaciones top-K que son relevantes (e.g., rating > 4), y Recall@K, la cobertura de ítems relevantes en el top-K. La métrica NDCG (Normalized Discounted Cumulative Gain) pondera posiciones más altas, ideal para listas ordenadas.

En escenarios offline, se simula con splits de datos; en online, se mide mediante A/B testing, comparando tasas de clics (CTR) o conversiones entre variantes. Herramientas como MLflow o TensorBoard facilitan el logging de métricas durante experimentación hiperparamétrica con GridSearchCV.

Consideraciones éticas incluyen la diversidad de recomendaciones para evitar sesgos, midiendo con métricas como Intra-List Diversity (ILD), que calcula la variabilidad semántica en el top-K. Regularización en la pérdida puede promover exploración sobre explotación.

Despliegue y Escalabilidad en Producción

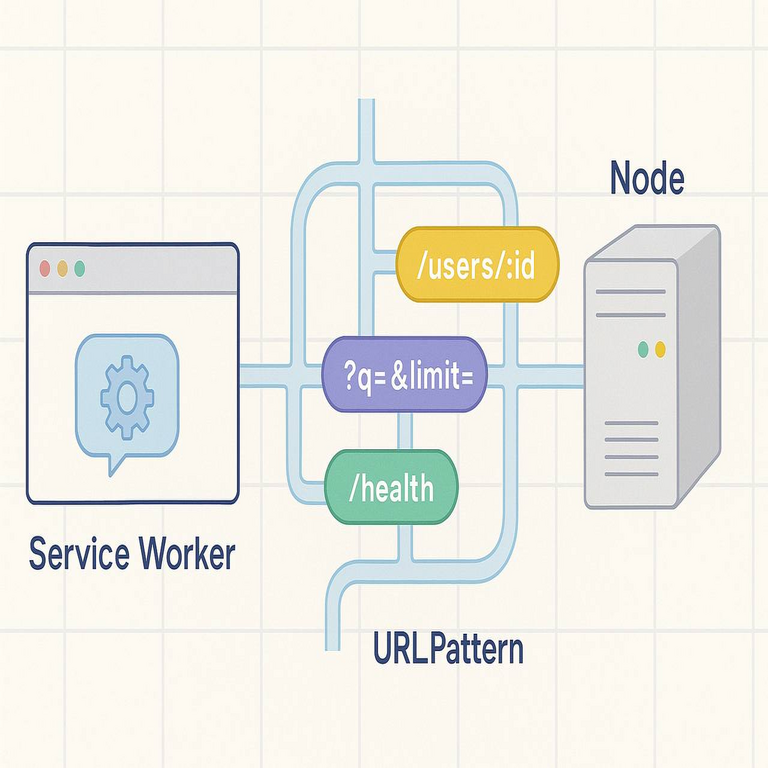

Para despliegue, se empaqueta el modelo en contenedores Docker, sirviéndolo vía API con Flask o FastAPI. Predicciones en tiempo real se manejan con embeddings precomputados almacenados en bases de datos vectoriales como FAISS o Pinecone, permitiendo búsquedas aproximadas de similitud en milisegundos.

En arquitecturas distribuidas, se usa Kubernetes para orquestación, con pipelines de datos en Apache Kafka para ingesta en streaming. Actualizaciones incrementales del modelo se realizan con técnicas como online learning, reentrenando periódicamente con nuevos datos sin downtime.

Seguridad es crítica: se implementan autenticación JWT para APIs y encriptación de datos sensibles. Cumplimiento con regulaciones como GDPR requiere anonimización de user_ids y opt-in para tracking de interacciones.

Implicaciones Operativas y Riesgos

Operativamente, estos sistemas impulsan ingresos mediante upselling, pero demandan recursos computacionales significativos; un modelo deep learning en GPU puede costar miles en cloud. Riesgos incluyen el echo chamber effect, donde recomendaciones refuerzan sesgos, mitigado con diversificación algorítmica.

En ciberseguridad, ataques como shilling (inyecciones falsas de ratings) se contrarrestan con detección de anomalías usando isolation forests. Beneficios regulatorios involucran transparencia, documentando decisiones con SHAP para explicabilidad.

Conclusión

La implementación de sistemas de recomendación basados en IA transforma la interacción usuario-plataforma, ofreciendo personalización a escala. Al combinar técnicas tradicionales con avances en aprendizaje profundo, se logran modelos robustos y eficientes. Futuras direcciones incluyen integración multimodal (texto, imagen, video) y federated learning para privacidad. Para más información, visita la fuente original.