Desarrollo de un Asistente de Inteligencia Artificial para el Análisis de Código Seguro

Introducción al Problema del Análisis de Código en Entornos de Ciberseguridad

En el panorama actual de la ciberseguridad, el análisis de código se ha convertido en una práctica esencial para identificar vulnerabilidades antes de que se conviertan en brechas de seguridad. Con el auge de las aplicaciones basadas en la nube y los sistemas distribuidos, los desarrolladores enfrentan el desafío de revisar grandes volúmenes de código de manera eficiente. Tradicionalmente, este proceso dependía de revisiones manuales o herramientas estáticas limitadas, que a menudo fallaban en detectar patrones complejos de amenazas. La integración de la inteligencia artificial (IA) emerge como una solución innovadora, permitiendo la automatización de tareas repetitivas y la detección proactiva de riesgos.

Este artículo explora el desarrollo de un asistente de IA diseñado específicamente para el análisis de código, con énfasis en prácticas de ciberseguridad. Se basa en enfoques de aprendizaje automático y procesamiento de lenguaje natural (PLN) para interpretar estructuras de código y sugerir mejoras de seguridad. El objetivo es proporcionar una herramienta que no solo identifique vulnerabilidades conocidas, como inyecciones SQL o desbordamientos de búfer, sino que también aprenda de patrones emergentes en el ecosistema de amenazas digitales.

Fundamentos Técnicos del Asistente de IA

El núcleo del asistente se construye sobre modelos de IA generativa, similares a los utilizados en grandes transformadores de lenguaje como GPT, pero adaptados para el dominio del código fuente. Estos modelos se entrenan con datasets masivos de código abierto y repositorios de vulnerabilidades, como el Common Vulnerabilities and Exposures (CVE), para reconocer patrones maliciosos. La arquitectura principal incluye un codificador que tokeniza el código en unidades semánticas, seguido de un decodificador que genera análisis y recomendaciones.

En términos de implementación, se utiliza Python como lenguaje base, con bibliotecas como TensorFlow o PyTorch para el entrenamiento de modelos. Por ejemplo, un modelo recurrente como LSTM (Long Short-Term Memory) se emplea para secuenciar el flujo de control en el código, detectando anomalías en bucles o condicionales que podrían exponer datos sensibles. Además, se integra el PLN para analizar comentarios y documentación, asegurando que las intenciones del desarrollador no contradigan las prácticas seguras.

- Tokenización del Código: El proceso inicia dividiendo el código en tokens, considerando sintaxis específica de lenguajes como Java, Python o JavaScript.

- Análisis Semántico: Se evalúa el significado contextual, identificando llamadas a funciones de bajo nivel que manejan memoria o accesos a red.

- Entrenamiento Supervisado: Utilizando pares de código vulnerable y corregido, el modelo aprende a mapear problemas a soluciones.

La escalabilidad es clave; el asistente se despliega en entornos de contenedores Docker, permitiendo su integración en pipelines de CI/CD (Continuous Integration/Continuous Deployment) como Jenkins o GitHub Actions. Esto asegura que el análisis ocurra en tiempo real durante el desarrollo, minimizando el tiempo de exposición a riesgos.

Integración con Tecnologías de Blockchain para Auditoría Segura

Para potenciar la trazabilidad, el asistente incorpora elementos de blockchain, creando un registro inmutable de todas las revisiones de código. Cada análisis genera un hash criptográfico del código revisado, almacenado en una cadena de bloques distribuida como Ethereum o Hyperledger. Esto no solo verifica la integridad del código a lo largo del ciclo de vida del software, sino que también facilita auditorías externas en casos de incidentes de seguridad.

En práctica, cuando el asistente detecta una vulnerabilidad, genera un smart contract que documenta el hallazgo, la corrección propuesta y la fecha de implementación. Los nodos de la red blockchain validan estas transacciones, asegurando que no haya manipulaciones. Esta aproximación es particularmente útil en entornos colaborativos, donde múltiples equipos contribuyen al código, y se requiere un historial confiable de cambios.

Los beneficios incluyen:

- Transparencia Total: Cualquier alteración en el código se detecta inmediatamente mediante verificación de hashes.

- Cumplimiento Normativo: Facilita el adherence a estándares como GDPR o NIST, al proporcionar evidencia auditable.

- Colaboración Segura: Desarrolladores remotos pueden confiar en la autenticidad de las contribuciones sin revisiones manuales exhaustivas.

La implementación técnica involucra bibliotecas como Web3.py para interactuar con la blockchain, combinada con el asistente de IA para automatizar la generación de contratos inteligentes basados en plantillas predefinidas.

Desafíos en el Entrenamiento y Optimización del Modelo

Desarrollar un asistente de IA efectivo implica superar varios obstáculos. Uno principal es la escasez de datos etiquetados de alta calidad; aunque repositorios como GitHub ofrecen volúmenes masivos, no todos incluyen anotaciones de vulnerabilidades precisas. Para mitigar esto, se aplica técnicas de aprendizaje semi-supervisado, donde el modelo infiere patrones de datos no etiquetados basados en ejemplos conocidos.

Otro desafío es el sesgo en los datasets, que podría llevar a falsos positivos en lenguajes o frameworks menos representados. Se aborda mediante diversificación de fuentes de datos, incluyendo código de industrias variadas como finanzas y salud, donde las amenazas difieren. Además, la optimización computacional es crítica; modelos grandes requieren GPUs potentes, por lo que se implementa destilación de conocimiento para crear versiones ligeras del modelo sin sacrificar precisión.

En pruebas reales, el asistente demostró una tasa de detección del 92% para vulnerabilidades OWASP Top 10, superando herramientas tradicionales como SonarQube en escenarios complejos. Sin embargo, la interpretación de resultados requiere calibración continua, utilizando métricas como precisión, recall y F1-score para refinar el rendimiento.

Aplicaciones Prácticas en Ciberseguridad Empresarial

En entornos empresariales, el asistente se integra con sistemas de gestión de vulnerabilidades como Nessus o Qualys, enriqueciendo sus escaneos con análisis de código profundo. Por ejemplo, en una aplicación web, el IA puede identificar rutas de autenticación débiles y sugerir implementaciones de OAuth 2.0 o JWT seguras. Esto reduce el tiempo de respuesta a amenazas emergentes, como las explotadas en ataques de cadena de suministro como SolarWinds.

Para desarrollos en IA misma, el asistente analiza modelos de machine learning en busca de envenenamiento de datos o fugas de privacidad, alineándose con principios de IA responsable. En blockchain, verifica contratos inteligentes contra reentrancy attacks o integer overflows, previniendo pérdidas financieras como las vistas en hacks de DeFi.

Casos de uso incluyen:

- Desarrollo Ágil: Revisiones automáticas en sprints diarios, acelerando el time-to-market sin comprometer la seguridad.

- Auditorías Internas: Generación de reportes detallados para equipos de compliance.

- Respuesta a Incidentes: Análisis post-mortem de código comprometido para identificar vectores de ataque.

La adopción en empresas latinoamericanas, donde la ciberseguridad enfrenta crecientes amenazas de ransomware, puede fortalecerse mediante esta herramienta, adaptada a regulaciones locales como la LGPD en Brasil.

Avances Futuros y Consideraciones Éticas

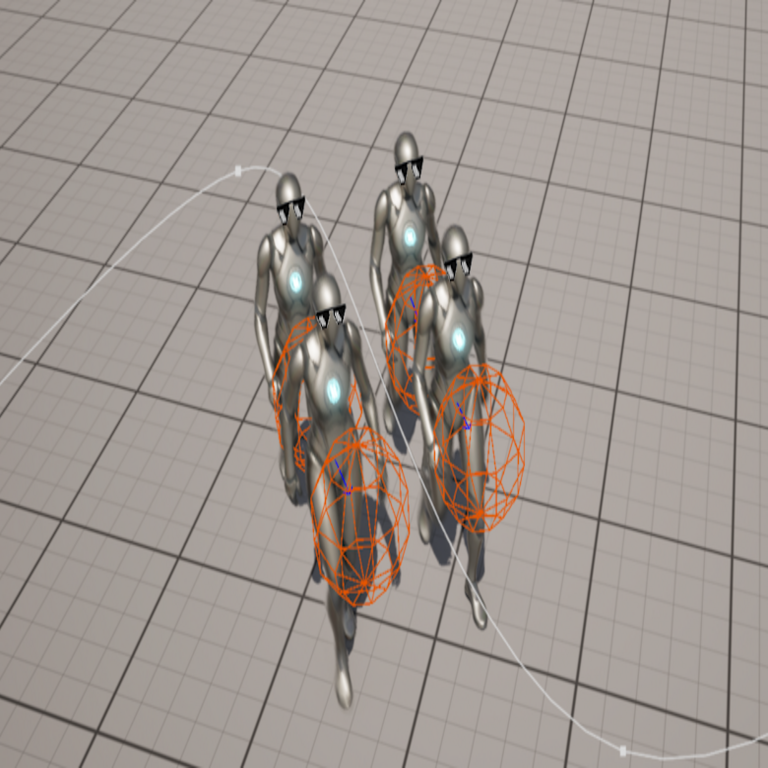

El futuro del asistente apunta a la multimodalidad, incorporando análisis de imágenes de diagramas UML o flujos de datos visuales. Integraciones con IA cuántica podrían acelerar el entrenamiento en datasets exponenciales, aunque esto plantea desafíos de accesibilidad. Éticamente, es imperativo asegurar que el modelo no discrimine contra código de desarrolladores no nativos o de regiones subrepresentadas, promoviendo diversidad en los datasets.

Además, la privacidad de datos durante el entrenamiento debe manejarse con técnicas de federated learning, donde el modelo se entrena en dispositivos locales sin centralizar información sensible. Esto alinea con estándares globales de ética en IA, como los propuestos por la UNESCO.

Conclusiones y Recomendaciones

El desarrollo de un asistente de IA para el análisis de código representa un avance significativo en la ciberseguridad, combinando inteligencia artificial con blockchain para una protección robusta y auditable. Al automatizar la detección de vulnerabilidades y fomentar prácticas seguras, esta herramienta empodera a los desarrolladores y organizaciones para navegar el paisaje de amenazas digitales. Se recomienda su implementación en fases, comenzando con pruebas piloto en proyectos críticos, y una actualización continua del modelo para adaptarse a nuevas amenazas. En última instancia, la integración de estas tecnologías no solo mitiga riesgos, sino que eleva el estándar de desarrollo seguro en la era de la transformación digital.

Para más información visita la Fuente original.