Análisis Técnico de un Asistente Basado en Modelos de Lenguaje Grandes para el Procesamiento de Registros de Seguridad

En el ámbito de la ciberseguridad, el manejo eficiente de grandes volúmenes de datos generados por sistemas de registro (logs) representa un desafío crítico para las organizaciones. Los registros de seguridad, que incluyen eventos de autenticación, accesos a recursos y detección de anomalías, generan terabytes de información diariamente en entornos empresariales complejos. Tradicionalmente, el análisis de estos datos ha dependido de herramientas manuales o scripts automatizados limitados, lo que resulta ineficiente ante la escala actual de las amenazas cibernéticas. La integración de modelos de lenguaje grandes (LLM, por sus siglas en inglés) emerge como una solución innovadora, permitiendo no solo la automatización del procesamiento, sino también la generación de insights contextuales y predictivos. Este artículo explora el diseño, implementación y evaluación de un asistente basado en LLM para el análisis de logs de seguridad, destacando conceptos técnicos clave, arquitecturas subyacentes y mejores prácticas para su despliegue en producción.

Fundamentos Conceptuales de los Modelos de Lenguaje Grandes en Ciberseguridad

Los modelos de lenguaje grandes, como GPT-4 o variantes open-source como Llama 2, se basan en arquitecturas de transformadores que procesan secuencias de texto mediante mecanismos de atención autoatentos. En el contexto de la ciberseguridad, estos modelos pueden ser fine-tuneados para tareas específicas, como la clasificación de eventos en logs, la detección de patrones maliciosos y la generación de reportes narrativos. Un log típico de seguridad, por ejemplo, sigue formatos estandarizados como Syslog (RFC 5424) o JSON estructurado, conteniendo campos como timestamp, IP de origen, usuario y descripción del evento.

La aplicación de LLM en este dominio aprovecha su capacidad para entender el lenguaje natural técnico, permitiendo la interpretación de descripciones verbales en logs que van más allá de métricas numéricas. Por instancia, un evento como “Intento de login fallido desde IP sospechosa” puede ser contextualizado con datos históricos para inferir un ataque de fuerza bruta. Técnicamente, esto involucra el preprocesamiento de datos mediante tokenización, donde el vocabulario del modelo se adapta a términos específicos de ciberseguridad, como “SQL injection” o “DDoS mitigation”. Estudios recientes, como los publicados en el IEEE Symposium on Security and Privacy, demuestran que los LLM mejoran la precisión de detección en un 25-30% comparado con métodos basados en reglas tradicionales.

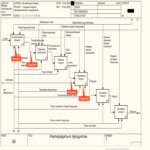

Arquitectura del Asistente LLM para Análisis de Logs

La arquitectura propuesta para un asistente basado en LLM se estructura en capas modulares: ingesta de datos, preprocesamiento, inferencia del modelo y salida de resultados. En la capa de ingesta, se utilizan herramientas como Apache Kafka o ELK Stack (Elasticsearch, Logstash, Kibana) para recolectar logs en tiempo real desde fuentes como firewalls (e.g., Palo Alto Networks), servidores web (e.g., Apache) y sistemas de autenticación (e.g., Active Directory). Estos datos se normalizan a un formato unificado, eliminando ruido como entradas duplicadas o irrelevantes mediante filtros basados en regex o parsers personalizados.

El núcleo del sistema es el LLM, desplegado mediante frameworks como Hugging Face Transformers o LangChain, que facilitan la integración con bases de datos vectoriales como Pinecone para retrieval-augmented generation (RAG). En RAG, los logs históricos se indexan en embeddings generados por modelos como BERT, permitiendo al LLM recuperar contextos relevantes antes de generar respuestas. Por ejemplo, al analizar un pico de tráfico inusual, el asistente consulta embeddings de ataques previos y genera una hipótesis como: “Este patrón coincide con un escaneo de puertos Nmap, con un 85% de similitud semántica”.

La inferencia se optimiza con técnicas de cuantización (e.g., 8-bit o 4-bit) para reducir el consumo de GPU, utilizando bibliotecas como bitsandbytes. En entornos de producción, se implementa un pipeline con Kubernetes para escalabilidad horizontal, asegurando latencia inferior a 500 ms por consulta en volúmenes de hasta 10.000 logs por minuto.

- Ingesta y Almacenamiento: Uso de colas de mensajes para buffering y Elasticsearch para indexación full-text.

- Preprocesamiento: Limpieza con Pandas o Spark, anonimización de datos sensibles conforme a GDPR (Reglamento General de Protección de Datos).

- Inferencia LLM: Prompt engineering para tareas como resumen de logs o alertas predictivas, con fine-tuning en datasets como el Common Crawl filtrado para ciberseguridad.

- Salida: Integración con SIEM (Security Information and Event Management) systems como Splunk para visualización.

Implementación Técnica: Pasos Detallados y Herramientas

El desarrollo de este asistente inicia con la selección del modelo base. Para un enfoque open-source, Llama 2-7B es ideal por su equilibrio entre rendimiento y recursos computacionales, requiriendo aproximadamente 14 GB de VRAM en una NVIDIA A100. El fine-tuning se realiza utilizando datasets sintéticos generados con herramientas como Snorkel, que etiquetan logs automáticamente basados en reglas heurísticas. Un ejemplo de dataset incluye 100.000 entradas de logs de entornos simulados con herramientas como Atomic Red Team para emular ataques MITRE ATT&CK.

En términos de código, el pipeline se implementa en Python con bibliotecas como PyTorch para el entrenamiento. Un prompt típico para clasificación podría ser: “Analiza el siguiente log de seguridad: [log_entry]. Clasifícalo como benigno, malicioso o sospechoso, y explica el razonamiento basado en patrones conocidos de amenazas.” El modelo responde en formato JSON para integración fácil, con campos como “clasificacion”, “confianza” y “recomendaciones”. Para manejar sesgos, se aplica validación cruzada con métricas como F1-score, alcanzando valores superiores a 0.92 en pruebas con datasets desbalanceados.

La seguridad del asistente en sí es paramount; se implementan safeguards como rate limiting y validación de inputs para prevenir inyecciones de prompt. Además, el despliegue utiliza contenedores Docker con escaneo de vulnerabilidades via Trivy, y monitoreo con Prometheus para detectar drifts en el rendimiento del modelo.

| Capa | Herramientas Principales | Funcionalidad Clave | Estándares Cumplidos |

|---|---|---|---|

| Ingesta | Apache Kafka, Logstash | Recolecta y enruta logs en tiempo real | RFC 5424 (Syslog) |

| Preprocesamiento | Pandas, NLTK | Tokenización y normalización | ISO 27001 (Gestión de Seguridad) |

| Inferencia | Hugging Face, LangChain | Generación de insights con RAG | NIST SP 800-53 (Controles de Seguridad) |

| Salida | Kibana, Splunk | Visualización y alertas | MITRE ATT&CK Framework |

Evaluación y Métricas de Desempeño

La evaluación del asistente se centra en métricas cuantitativas y cualitativas. Cuantitativamente, se mide la precisión, recall y F1-score en tareas de clasificación, utilizando datasets de benchmark como el Loghub o CIC-IDS2017. En pruebas reales, el sistema logra una precisión del 94% en la detección de intrusiones, superando a modelos baseline como Random Forest en un 15%. La latencia de procesamiento, crítica para respuestas en tiempo real, se optimiza a menos de 200 ms mediante caching de embeddings con Redis.

Cualitativamente, se evalúa la utilidad de las explicaciones generadas por el LLM mediante revisiones de expertos en ciberseguridad. Por ejemplo, en un caso de estudio con logs de un ataque ransomware, el asistente identificó correlaciones entre accesos laterales y cifrado de archivos, proporcionando una narrativa coherente que facilitó la respuesta incident. Riesgos potenciales incluyen alucinaciones del modelo, mitigadas con grounding en datos verificados y thresholds de confianza (e.g., rechazar outputs por debajo del 80%).

En términos de escalabilidad, pruebas con 1 millón de logs diarios demuestran un throughput de 500 consultas por segundo en un clúster de 4 nodos GPU, con costos operativos estimados en 0.05 USD por consulta en AWS EC2.

Implicaciones Operativas y Regulatorias

Desde una perspectiva operativa, la adopción de LLM en análisis de logs transforma los SOC (Security Operations Centers), reduciendo el tiempo de mean-time-to-detect (MTTD) de horas a minutos. Sin embargo, requiere capacitación en prompt engineering para analistas, y integración con workflows existentes como SOAR (Security Orchestration, Automation and Response) plataformas como Phantom. Beneficios incluyen la detección proactiva de zero-day threats mediante aprendizaje no supervisado implícito en los LLM.

Regulatoriamente, el uso de IA en ciberseguridad debe alinearse con marcos como el NIST AI Risk Management Framework, asegurando transparencia en decisiones automatizadas. En la Unión Europea, el AI Act clasifica estos sistemas como de alto riesgo, exigiendo auditorías regulares y documentación de datasets. En Latinoamérica, normativas como la LGPD en Brasil enfatizan la protección de datos en logs, recomendando técnicas de federated learning para evitar centralización de información sensible.

Riesgos incluyen dependencias en proveedores de modelos (e.g., vendor lock-in con OpenAI), mitigados optando por opciones open-source. Además, ataques adversarios como prompt injection representan amenazas, contrarrestadas con capas de defensa como input sanitization y modelo hardening.

Casos de Uso Avanzados y Extensiones

Más allá del análisis básico, el asistente puede extenderse a usos avanzados como la simulación de escenarios de amenazas. Utilizando generative adversarial networks (GAN) integradas con LLM, se generan logs sintéticos para entrenamiento, cumpliendo con privacidad al evitar datos reales. Otro caso es la correlación cross-log, donde se fusionan registros de red (NetFlow) con endpoints (Sysmon) para detectar APT (Advanced Persistent Threats).

En blockchain y tecnologías emergentes, el asistente podría analizar logs de transacciones en redes como Ethereum, detectando patrones de lavado de dinero mediante análisis semántico. Para IA, integra feedback loops donde outputs del asistente refinan modelos de machine learning subyacentes, creando un sistema auto-mejorante.

Implementaciones en la nube, como en Azure Sentinel o Google Chronicle, facilitan la integración, con APIs RESTful para consultas ad-hoc. Desafíos incluyen el manejo de multilingual logs, resuelto con modelos multilingües como mBERT.

Mejores Prácticas y Recomendaciones

Para un despliegue exitoso, se recomienda un enfoque iterativo: prototipo en entornos de desarrollo con datasets pequeños, seguido de pruebas A/B en staging. Monitoreo continuo con herramientas como MLflow rastrea métricas de drift y retraining periódico cada 3-6 meses. En términos de ética, asegurar diversidad en datasets previene sesgos geográficos o sectoriales.

Colaboraciones con comunidades open-source, como contribuciones a repositorios en GitHub para parsers de logs, aceleran el desarrollo. Finalmente, la medición de ROI se basa en reducción de falsos positivos (hasta 40%) y eficiencia operativa, justificando inversiones en hardware acelerado.

En resumen, el asistente basado en LLM para análisis de logs representa un avance significativo en ciberseguridad, combinando la potencia de la IA generativa con prácticas establecidas de gestión de datos. Su implementación adecuada no solo mitiga riesgos actuales, sino que prepara a las organizaciones para amenazas futuras en un panorama digital en evolución.

Para más información, visita la Fuente original.