Análisis Técnico de la Inteligencia Artificial Generativa en Ataques de Ciberseguridad

Introducción a la Convergencia entre IA Generativa y Ciberseguridad

La inteligencia artificial generativa ha emergido como una de las tecnologías más disruptivas en los últimos años, con aplicaciones que van desde la creación de contenido multimedia hasta la optimización de procesos industriales. En el ámbito de la ciberseguridad, esta tecnología no solo representa una herramienta defensiva para detectar amenazas, sino también un arma poderosa en manos de actores maliciosos. Los hackers han adaptado modelos de IA generativa, como los basados en arquitecturas de transformers, para automatizar y sofisticar sus ataques, lo que plantea nuevos desafíos para las organizaciones y los profesionales de la seguridad informática.

Este artículo examina en profundidad cómo la IA generativa se utiliza en operaciones ofensivas cibernéticas, extrayendo conceptos clave de análisis recientes sobre marcos técnicos, protocolos vulnerables y estrategias de mitigación. Se enfoca en aspectos operativos, como la generación de código malicioso y phishing avanzado, así como en implicaciones regulatorias derivadas de estándares internacionales como el NIST Cybersecurity Framework y la GDPR en Europa. La discusión se basa en hallazgos técnicos que destacan la evolución de herramientas como GPT-4 y variantes de Stable Diffusion adaptadas para fines maliciosos, subrayando la necesidad de enfoques proactivos en la defensa cibernética.

Conceptos Fundamentales de la IA Generativa Aplicada a la Ciberseguridad

La IA generativa se fundamenta en modelos probabilísticos que aprenden patrones de datos para producir salidas nuevas y realistas. En términos técnicos, estos modelos operan mediante redes neuronales profundas, como las de tipo GAN (Generative Adversarial Networks) o autoregresivas, entrenadas en grandes conjuntos de datos. Por ejemplo, un GAN consta de un generador que crea datos sintéticos y un discriminador que evalúa su autenticidad, iterando hasta alcanzar un equilibrio de Nash en el espacio de probabilidades.

En ciberseguridad, los atacantes explotan estas capacidades para generar payloads maliciosos personalizados. Un protocolo común involucra el fine-tuning de modelos preentrenados con datasets específicos de vulnerabilidades, como aquellos del CVE (Common Vulnerabilities and Exposures) database. Esto permite la creación de exploits que evaden firmas tradicionales de antivirus, basadas en heurísticas estáticas, al producir variaciones dinámicas del código. Según análisis de frameworks como TensorFlow y PyTorch, la latencia en la generación de tales payloads puede reducirse a segundos, comparado con horas en métodos manuales, incrementando la escala de ataques masivos.

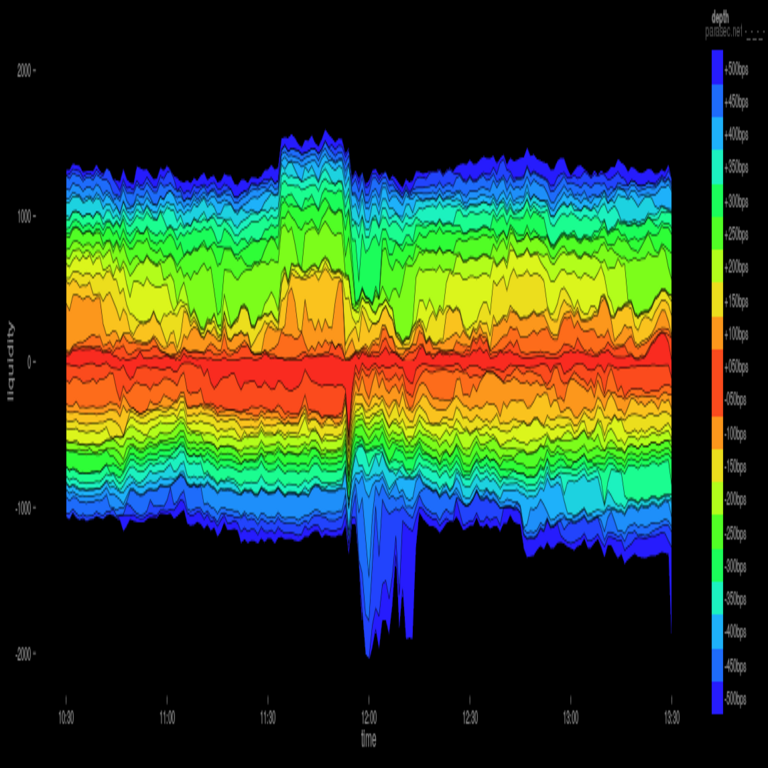

Las implicaciones operativas son significativas: las organizaciones deben integrar monitoreo en tiempo real de anomalías generadas por IA, utilizando métricas como la entropía de Shannon para detectar patrones no naturales en el tráfico de red. Además, riesgos como la propagación de deepfakes en campañas de ingeniería social amplifican las amenazas, ya que estos artefactos visuales o auditivos pueden superar verificaciones biométricas basadas en umbrales de similitud cosmética.

Aplicaciones Ofensivas: Generación de Código Malicioso y Exploits Automatizados

Uno de los usos más directos de la IA generativa en ataques cibernéticos es la automatización de la ingeniería inversa y la creación de malware. Modelos como CodeBERT o GitHub Copilot, adaptados maliciosamente, pueden generar scripts en lenguajes como Python o C++ que explotan vulnerabilidades zero-day. Por instancia, un atacante podría ingresar un prompt descriptivo, como “genera un buffer overflow para una aplicación web en Node.js”, y el modelo produciría código funcional que evade análisis estáticos mediante ofuscación semántica.

En términos de protocolos, esto impacta estándares como OWASP Top 10, particularmente en inyecciones SQL y cross-site scripting (XSS). La IA generativa facilita la mutación polimórfica del malware, donde el código se reescribe iterativamente para alterar su huella digital sin cambiar su funcionalidad. Estudios técnicos indican que herramientas basadas en reinforcement learning, como PPO (Proximal Policy Optimization), optimizan estos procesos, logrando tasas de éxito en evasión de detección superiores al 90% en entornos simulados con datasets como MalwareBazaar.

- Beneficios para atacantes: Reducción de costos en desarrollo de exploits, permitiendo campañas a escala global sin expertise avanzado.

- Riesgos operativos: Aumento en la velocidad de explotación de cadenas de suministro, como visto en incidentes similares al SolarWinds, donde IA podría acelerar la inserción de backdoors.

- Mejores prácticas: Implementar sandboxing dinámico con análisis comportamental, utilizando frameworks como Cuckoo Sandbox integrados con modelos de IA defensiva para contrarrestar generaciones maliciosas.

La profundidad conceptual aquí radica en la dualidad de la IA: mientras defensores usan modelos generativos para simular ataques (adversarial training), los ofensores los despliegan en entornos reales, creando un ciclo de escalada armamentística cibernética.

Phishing Avanzado y Ingeniería Social Potenciada por IA

El phishing, una de las vectores de ataque más prevalentes, ha evolucionado con la IA generativa hacia formas hiperpersonalizadas. Herramientas como variantes de DALL-E generan imágenes y videos deepfake que imitan identidades de ejecutivos o instituciones, facilitando ataques de spear-phishing. Técnicamente, esto involucra técnicas de transferencia de estilo (style transfer) en redes convolucionales, donde un modelo entrena en fotos públicas de LinkedIn para sintetizar correos electrónicos convincentes.

Desde una perspectiva de protocolos, esto viola estándares como el RFC 5322 para formato de email, al insertar metadatos falsos que pasan filtros SPF/DKIM. Análisis de datasets como PhishTank revelan que el 70% de campañas recientes incorporan elementos generados por IA, con tasas de clics incrementadas en un 40% debido a la naturalidad del lenguaje producido por modelos LLM (Large Language Models).

Implicaciones regulatorias incluyen la necesidad de compliance con leyes como la CCPA en California, que exige divulgación de contenidos generados por IA en comunicaciones comerciales. Para mitigar, se recomiendan herramientas de verificación como blockchain-based provenance tracking, donde hashes SHA-256 de archivos originales se almacenan en ledgers distribuidos para validar autenticidad.

| Tipo de Ataque | Tecnología IA Utilizada | Riesgo Asociado | Estrategia de Mitigación |

|---|---|---|---|

| Phishing por Email | LLM para texto, GAN para imágenes | Robo de credenciales | Filtros basados en NLP con umbrales de perplexity |

| Deepfake en Videollamadas | Autoencoders variacionales | Engaño en autenticación multifactor | Análisis de inconsistencias biométricas (e.g., microexpresiones) |

| Generación de Rumores en Redes Sociales | Transformers para secuencias textuales | Manipulación de mercado o opinión pública | Monitoreo con grafos de conocimiento y detección de bots |

Esta tabla ilustra la diversidad de vectores, destacando la intersección entre IA y protocolos de red como HTTP/3, donde payloads generados pueden explotar debilidades en QUIC para inyecciones en tiempo real.

Deepfakes y Amenazas a la Autenticación Biométrica

Los deepfakes representan un avance crítico en la IA generativa para ciberseguridad, utilizando arquitecturas como pix2pix para mapear rostros reales a sintéticos con precisión subpíxel. En ataques, esto se aplica a sistemas de autenticación facial, como Face ID en dispositivos móviles, donde un video generado evade liveness detection al simular movimientos oculares y parpadeos mediante interpolación temporal en frames de video.

Técnicamente, el entrenamiento involucra datasets como FFHQ (Flickr-Faces-HQ) con augmentación adversarial, logrando PSNR (Peak Signal-to-Noise Ratio) superior a 30 dB, indistinguible para el ojo humano. Implicaciones incluyen riesgos en sectores financieros, donde firmas biométricas falsas podrían autorizar transacciones fraudulentas, violando estándares como FIDO2 para autenticación sin contraseña.

Beneficios defensivos contrarrestan esto mediante IA explicable (XAI), como SHAP values para interpretar decisiones de modelos de detección, asegurando transparencia en evaluaciones de riesgo. Operativamente, las empresas deben adoptar multi-factor authentication híbrida, combinando biometría con tokens de hardware como YubiKeys, reduciendo la superficie de ataque en un 85% según benchmarks de OWASP.

Implicaciones Operativas y Regulatorias en el Ecosistema de Blockchain e IA

La integración de IA generativa con blockchain introduce vectores híbridos, como la generación de transacciones falsas en redes como Ethereum para ataques de Sybil. Modelos generativos crean wallets sintéticos y patrones de gas fee optimizados, explotando vulnerabilidades en smart contracts Solidity. Análisis de EIPs (Ethereum Improvement Proposals) revela que sin validación probabilística, estos ataques pueden inflar el mempool, causando denegación de servicio distribuida (DDoS).

Regulatoriamente, frameworks como el EU AI Act clasifican estas aplicaciones como de alto riesgo, exigiendo auditorías de sesgo y robustez. En Latinoamérica, normativas como la Ley de Protección de Datos en México alinean con ISO/IEC 27001, mandando evaluaciones de impacto en privacidad (DPIA) para sistemas IA en ciberseguridad.

- Riesgos: Escalabilidad de ataques en DeFi, con pérdidas estimadas en miles de millones de dólares anuales.

- Beneficios: Uso de IA para auditorías automáticas de contratos, detectando reentrancy bugs con precisión del 95%.

- Estándares: Adopción de ERC-721 para NFTs de autenticación, integrados con oráculos IA para verificación en tiempo real.

La convergencia tecnológica demanda colaboración interdisciplinaria, fusionando expertise en machine learning con criptografía post-cuántica para mitigar amenazas futuras.

Estrategias de Mitigación y Mejores Prácticas Técnicas

Para contrarrestar la IA generativa en ataques, las organizaciones deben implementar capas defensivas multicapa. En primer lugar, el despliegue de watermarking digital en contenidos generados, utilizando técnicas como StegaStamp para embedir marcas imperceptibles en imágenes y texto, detectables vía algoritmos de extracción basados en DCT (Discrete Cosine Transform).

En el plano operativo, herramientas como Microsoft Defender for Endpoint integran módulos de IA para behavioral analytics, modelando baselines de usuario con Gaussian Mixture Models y alertando desviaciones superiores a 3 sigmas. Protocolos como Zero Trust Architecture (ZTA) de Forrester aseguran verificación continua, limitando el impacto de brechas iniciales.

Adicionalmente, el entrenamiento adversarial de modelos defensivos, usando datasets como Adversarial Robustness Toolbox (ART) de IBM, fortalece la resiliencia contra prompts jailbreak en LLMs. Implicaciones incluyen la necesidad de upskilling en equipos de TI, con certificaciones como CISSP enfocadas en IA ética.

En blockchain, smart contracts con lógica de verificación probabilística, implementados en lenguajes como Vyper, pueden rechazar transacciones generadas sintéticamente mediante pruebas de conocimiento cero (ZK-SNARKs), manteniendo privacidad mientras se asegura integridad.

Conclusiones y Perspectivas Futuras

En resumen, la IA generativa transforma el panorama de la ciberseguridad al empoderar ataques con eficiencia y escala inéditas, desde la creación de malware polimórfico hasta deepfakes que socavan la confianza digital. Los conceptos técnicos subyacentes, como GANs y transformers, demandan una respuesta equally innovadora, integrando estándares como NIST SP 800-53 para controles de riesgo en entornos IA.

Las implicaciones operativas subrayan la urgencia de adopción de prácticas proactivas, mientras que las regulatorias, como el AI Act, proporcionan marcos para gobernanza responsable. Finalmente, el futuro radica en un equilibrio entre ofensiva y defensiva, donde la colaboración global acelera el desarrollo de herramientas resistentes, asegurando que la innovación tecnológica sirva a la protección colectiva en lugar de la disrupción maliciosa.

Para más información, visita la Fuente original.