Desarrollo de un Generador de Código Basado en Modelos de Lenguaje Grandes: Del Concepto al Producto Mínimo Viable

Introducción a los Modelos de Lenguaje Grandes en la Generación de Código

Los modelos de lenguaje grandes (LLM, por sus siglas en inglés) han transformado el panorama de la inteligencia artificial aplicada al desarrollo de software. Estos modelos, entrenados en vastos conjuntos de datos que incluyen código fuente de múltiples lenguajes de programación, exhiben capacidades notables para generar, completar y depurar código de manera autónoma. En el contexto de la ciberseguridad y las tecnologías emergentes, la integración de LLM en herramientas de generación de código representa una oportunidad para optimizar procesos de desarrollo, pero también introduce desafíos relacionados con la precisión, la seguridad y la escalabilidad.

Este artículo explora el proceso técnico de creación de un generador de código basado en LLM, desde la conceptualización hasta la implementación de un producto mínimo viable (MVP). Se basa en un análisis detallado de prácticas actuales, frameworks disponibles y consideraciones operativas, con énfasis en aspectos como la selección de modelos, el manejo de prompts y la evaluación de outputs. La relevancia de esta tecnología radica en su potencial para acelerar el ciclo de vida del software, reduciendo el tiempo dedicado a tareas repetitivas y permitiendo a los desarrolladores enfocarse en lógica de alto nivel y resolución de problemas complejos.

En términos técnicos, un LLM como GPT-4 o Llama 2 opera mediante arquitecturas de transformadores, que procesan secuencias de tokens para predecir el siguiente elemento en una cadena. Para la generación de código, estos modelos se afinan con datasets específicos como The Stack o CodeParrot, que contienen miles de millones de líneas de código abierto. Sin embargo, su aplicación práctica requiere una ingeniería de prompts meticulosa para mitigar problemas como las alucinaciones, donde el modelo genera código sintácticamente correcto pero funcionalmente erróneo.

Conceptos Clave en la Arquitectura de un Generador de Código

La arquitectura de un generador de código basado en LLM se compone de varios componentes interconectados. En primer lugar, el núcleo es el modelo subyacente, que puede ser un LLM preentrenado accesible a través de APIs como la de OpenAI o Hugging Face. Estos modelos soportan contextos de hasta 128k tokens en versiones avanzadas, lo que permite manejar descripciones detalladas de requisitos funcionales y generar bloques de código extensos.

El segundo componente es el sistema de prompts, que actúa como interfaz entre el usuario y el modelo. Un prompt efectivo incluye instrucciones claras, ejemplos few-shot (pocos ejemplos) y restricciones contextuales. Por ejemplo, para generar una función en Python que implemente un algoritmo de encriptación AES, el prompt podría especificar: “Escribe una función en Python que utilice la biblioteca cryptography para encriptar un mensaje con AES-256 en modo CBC, incluyendo manejo de claves y vectores de inicialización. Asegura que el código sea seguro contra ataques de padding oracle.”

Adicionalmente, se integra un mecanismo de post-procesamiento para validar el código generado. Herramientas como pylint para Python o ESLint para JavaScript analizan el output en busca de vulnerabilidades comunes, tales como inyecciones SQL o fugas de memoria. En el ámbito de la ciberseguridad, este paso es crucial para detectar patrones de código inseguro, como el uso de funciones obsoletas como strcpy en C, que son propensas a desbordamientos de búfer.

Los frameworks facilitan esta integración. LangChain, por instancia, proporciona cadenas de procesamiento que combinan LLM con herramientas externas, como bases de conocimiento vectoriales (usando embeddings de Sentence Transformers) para recuperar snippets de código relevantes. Otro framework relevante es Haystack, que soporta pipelines de búsqueda y generación híbrida, ideal para entornos donde se requiere contextualizar el código con documentación técnica o estándares como OWASP para aplicaciones web seguras.

- Selección de Modelo: Optar por modelos open-source como CodeLlama reduce costos y mejora la privacidad, ya que el procesamiento se realiza localmente con bibliotecas como Transformers de Hugging Face.

- Manejo de Contexto: Implementar técnicas de RAG (Retrieval-Augmented Generation) para enriquecer prompts con datos recuperados de repositorios como GitHub, minimizando alucinaciones.

- Escalabilidad: Utilizar contenedores Docker para desplegar el generador en entornos cloud como AWS SageMaker, asegurando aislamiento y replicabilidad.

Implementación Técnica: Del Diseño al MVP

El desarrollo de un MVP inicia con la definición de requisitos funcionales. Supongamos un generador enfocado en lenguajes como Python, JavaScript y Go, con soporte para tareas comunes en ciberseguridad, como la implementación de APIs REST seguras o scripts de análisis de logs. La fase de diseño involucra la modelación de flujos: el usuario ingresa una descripción natural language, el sistema procesa el prompt, genera código y lo valida iterativamente.

En la implementación, se utiliza Python como lenguaje base debido a su ecosistema rico en IA. La biblioteca openai permite llamadas API sencillas: un script inicial podría ser:

from openai import OpenAI

client = OpenAI(api_key=’tu-clave’)

response = client.chat.completions.create(model=”gpt-4″, messages=[{“role”: “user”, “content”: “Genera código Python para un firewall básico usando Scapy.”}])

print(response.choices[0].message.content)

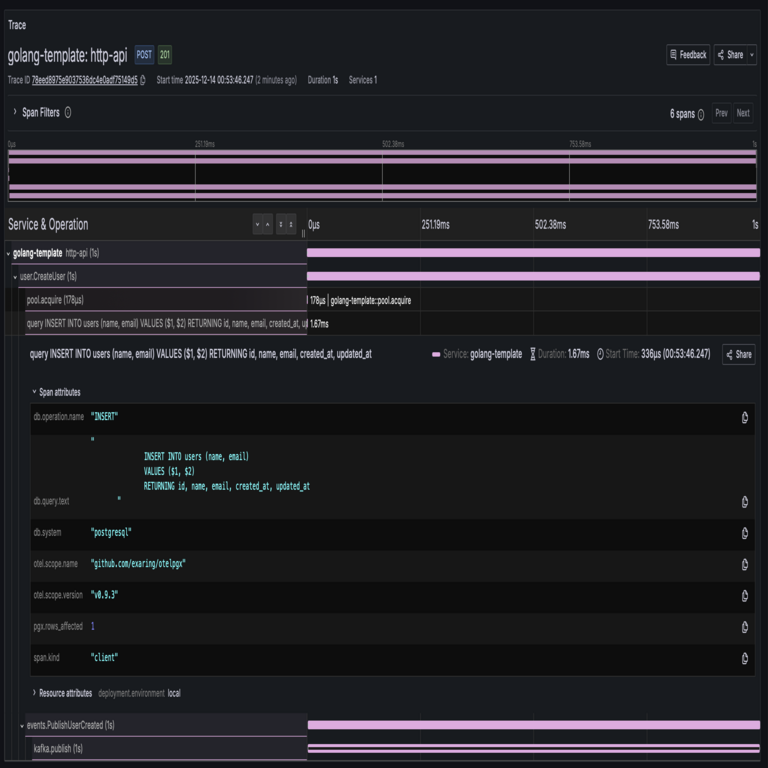

Este enfoque básico evoluciona hacia un MVP con una interfaz web construida en Streamlit o FastAPI. En FastAPI, se define un endpoint POST que recibe JSON con el prompt y retorna el código generado, junto con métricas de confianza calculadas mediante probabilidades de tokens del modelo.

Para la validación, se integra un sandbox de ejecución, como Pyodide para Python en el navegador o Docker para entornos aislados. Esto previene riesgos de seguridad al probar código generado, especialmente en escenarios de IA generativa donde el output podría contener malware inadvertido. Estándares como NIST SP 800-53 guían la implementación de controles de acceso, asegurando que solo código verificado se ejecute.

En términos de blockchain y tecnologías emergentes, el generador podría extenderse para producir smart contracts en Solidity. Aquí, el prompt incluiría verificaciones contra reentrancy attacks, comunes en Ethereum, utilizando patrones de OpenZeppelin. La evaluación del MVP involucra métricas como BLEU score para similitud semántica y tasas de éxito en unit tests automáticos generados con pytest.

Implicaciones Operativas y Riesgos en Ciberseguridad

La adopción de generadores de código basados en LLM trae implicaciones operativas significativas. En entornos empresariales, acelera el desarrollo DevOps, integrándose con CI/CD pipelines en Jenkins o GitHub Actions. Por ejemplo, un hook post-commit podría invocar el generador para sugerir refactorizaciones, mejorando la eficiencia en un 30-50% según estudios de GitHub Copilot.

Sin embargo, los riesgos son prominentes. Las alucinaciones pueden introducir vulnerabilidades, como exposición de credenciales en código generado. Para mitigar esto, se recomienda fine-tuning del modelo con datasets curados, como los de OWASP Benchmark, que incluyen ejemplos de código vulnerable y seguro. Además, el sesgo en los datos de entrenamiento podría perpetuar prácticas obsoletas, como el uso de MD5 para hashing en lugar de SHA-256.

Desde una perspectiva regulatoria, frameworks como GDPR en Europa exigen trazabilidad en el uso de IA, lo que implica logging de prompts y outputs para auditorías. En ciberseguridad, el cumplimiento con ISO 27001 requiere evaluar el impacto de LLM en la cadena de suministro de software, donde código generado podría heredarse en aplicaciones críticas.

Beneficios incluyen la democratización del desarrollo: desarrolladores junior pueden generar código boilerplate seguro, mientras expertos validan outputs. En IA, esto fomenta la creación de agentes autónomos que iteran sobre código mediante reinforcement learning from human feedback (RLHF), similar a técnicas usadas en InstructGPT.

- Riesgos de Privacidad: Evitar enviar código propietario a APIs de terceros mediante modelos on-premise con Ollama.

- Escalabilidad y Costos: Monitorear tokens consumidos para optimizar prompts, usando técnicas de compresión como quantization en modelos como GPTQ.

- Integración con Herramientas: Conectar con IDEs como VS Code vía extensiones, permitiendo generación en tiempo real.

Evaluación y Mejoras Iterativas del MVP

La evaluación del MVP se realiza mediante pruebas controladas. Se define un conjunto de benchmarks, como HumanEval, que mide la capacidad del generador para resolver problemas de programación con pass@k metrics (porcentaje de problemas resueltos en k intentos). Para un MVP enfocado en ciberseguridad, se crea un dataset personalizado con tareas como “Implementa un detector de anomalías en redes usando Snort rules generadas dinámicamente.”

Las mejoras iterativas involucran feedback loops: usuarios califican el código generado, y este data se usa para refinar prompts o fine-tunear el modelo con LoRA (Low-Rank Adaptation), una técnica eficiente que ajusta solo un subconjunto de parámetros. En blockchain, se podría integrar verificación formal con herramientas como Mythril para smart contracts generados, asegurando ausencia de vulnerabilidades lógicas.

Desafíos técnicos incluyen el manejo de lenguajes de bajo nivel como Rust, donde el modelo debe generar código que respete ownership y borrowing rules para prevenir race conditions. Soluciones involucran prompts multi-etapa: primero generar pseudocódigo, luego traducirlo a Rust con validación estática usando cargo check.

En noticias de IT recientes, herramientas como GitHub Copilot X y Amazon CodeWhisperer han demostrado tasas de adopción del 40% en equipos de desarrollo, destacando la madurez de esta tecnología. Para organizaciones, el ROI se mide en reducción de tiempo de codificación, con proyecciones de hasta 55% según informes de McKinsey.

Estándares y Mejores Prácticas en la Implementación

Adherirse a estándares es esencial. Para IA en software, el framework de IEEE Ethically Aligned Design proporciona guías para transparencia y accountability. En ciberseguridad, el MITRE ATT&CK framework ayuda a mapear vulnerabilidades potenciales en código generado, como tácticas de ejecución remota.

Mejores prácticas incluyen:

- Versionado de prompts con Git para trazabilidad.

- Uso de differential privacy en fine-tuning para proteger datos sensibles.

- Integración de explainability tools como SHAP para interpretar decisiones del modelo en generación de código.

En términos de hardware, desplegar en GPUs NVIDIA con CUDA acelera inferencia, con optimizaciones como TensorRT para latencia baja en producción.

Conclusión: Perspectivas Futuras en Generación de Código con LLM

El desarrollo de un generador de código basado en LLM marca un hito en la evolución de las herramientas de desarrollo asistido por IA. Al transitar del concepto a un MVP funcional, se evidencia el potencial para transformar prácticas en ciberseguridad, blockchain y tecnologías emergentes, siempre que se aborden rigurosamente los riesgos inherentes. La combinación de modelos avanzados, frameworks robustos y validaciones estrictas pavimenta el camino hacia sistemas más autónomos y seguros.

En resumen, esta aproximación no solo optimiza la productividad sino que eleva el estándar de calidad en el software producido, fomentando innovación en un ecosistema IT cada vez más interconectado. Para más información, visita la Fuente original.