Inteligencia Artificial Generativa en Ciberseguridad: Amenazas y Oportunidades

La integración de la inteligencia artificial (IA) generativa en el ámbito de la ciberseguridad representa un avance significativo en la evolución tecnológica, pero también introduce desafíos complejos que demandan un análisis detallado. Este artículo explora los aspectos técnicos fundamentales de esta convergencia, enfocándose en las capacidades de modelos como GPT y sus derivados para generar contenido malicioso, así como en las aplicaciones defensivas que estos mismos sistemas ofrecen. Basado en un examen riguroso de frameworks y protocolos relevantes, se discuten las implicaciones operativas y regulatorias, con énfasis en riesgos como el deepfake y el phishing avanzado, contrarrestados por beneficios en la detección automatizada de vulnerabilidades.

Fundamentos de la IA Generativa y su Intersección con la Ciberseguridad

La IA generativa se basa en arquitecturas de redes neuronales profundas, particularmente en modelos de transformers, que permiten la creación de texto, imágenes y código a partir de patrones aprendidos en grandes conjuntos de datos. En el contexto de la ciberseguridad, estos modelos pueden ser utilizados tanto para potenciar ataques como para fortalecer defensas. Por ejemplo, un atacante podría emplear un modelo generativo para producir correos electrónicos de phishing hiperpersonalizados, adaptados a perfiles específicos de usuarios mediante el análisis de datos públicos disponibles en redes sociales.

Desde un punto de vista técnico, los transformers, introducidos en el paper “Attention is All You Need” de Vaswani et al. en 2017, operan mediante mecanismos de atención que ponderan la relevancia de tokens en secuencias de entrada. En ciberseguridad, esta capacidad se traduce en la generación de payloads maliciosos que evaden filtros tradicionales basados en firmas estáticas. Herramientas como Hugging Face’s Transformers library facilitan la implementación de estos modelos, permitiendo a investigadores en seguridad simular escenarios de ataque para probar la resiliencia de sistemas existentes.

Las implicaciones operativas son evidentes en entornos empresariales, donde la adopción de IA generativa requiere la actualización de políticas de acceso y entrenamiento de modelos. Según estándares como el NIST Cybersecurity Framework (CSF) versión 2.0, las organizaciones deben identificar riesgos asociados a la IA, incluyendo sesgos en los datos de entrenamiento que podrían amplificar vulnerabilidades étnicas o geográficas en detecciones de amenazas.

Amenazas Específicas Derivadas de la IA Generativa

Una de las amenazas más prominentes es la creación de deepfakes, que combinan IA generativa con técnicas de síntesis de voz y video. Estos artefactos pueden ser empleados en ataques de ingeniería social, como suplantación de identidad en videoconferencias corporativas. Técnicamente, modelos como Stable Diffusion para imágenes y WaveNet para audio generan contenido indistinguible del real, utilizando redes generativas antagónicas (GANs) donde un generador compite contra un discriminador para refinar la salida.

En términos de phishing, la IA generativa eleva la sofisticación al generar narrativas coherentes y contextuales. Un estudio de la Universidad de Stanford en 2023 demostró que modelos como GPT-4 pueden producir correos con tasas de éxito en clics un 30% superiores a los phishing tradicionales, al incorporar elementos culturales y lingüísticos específicos. Esto implica un riesgo operativo para infraestructuras críticas, donde un solo correo exitoso podría comprometer cadenas de suministro digitales.

Otro vector de amenaza es la generación automatizada de malware. Herramientas open-source como MalGAN utilizan IA para mutar código malicioso, evadiendo antivirus basados en aprendizaje supervisado. En blockchain, esto se extiende a la creación de contratos inteligentes falsos que explotan vulnerabilidades en protocolos como Solidity de Ethereum, potencialmente dreneando fondos en DeFi (finanzas descentralizadas). Las implicaciones regulatorias son claras: marcos como el EU AI Act clasifican estas aplicaciones como de alto riesgo, exigiendo auditorías obligatorias y transparencia en los modelos.

- Deepfakes en ingeniería social: Generación de videos falsos para autorizar transacciones fraudulentas, con tasas de detección por debajo del 70% en herramientas convencionales.

- Phishing avanzado: Personalización mediante análisis de datos de OSINT (Open Source Intelligence), integrando APIs de redes sociales.

- Malware generativo: Evolución de payloads en tiempo real, adaptándose a entornos de ejecución dinámica.

- Ataques a blockchain: Síntesis de transacciones maliciosas que simulan patrones legítimos en redes como Bitcoin o Ethereum.

Los riesgos se amplifican en escenarios de IA adversaria, donde atacantes envenenan datasets de entrenamiento para inducir fallos en sistemas de seguridad. Por instancia, un ataque de backdoor en un modelo de detección de intrusiones podría ignorar tráfico malicioso específico, violando principios de integridad en el estándar ISO/IEC 27001 para gestión de seguridad de la información.

Oportunidades Defensivas en la Aplicación de IA Generativa

A pesar de las amenazas, la IA generativa ofrece oportunidades sustanciales para la ciberseguridad proactiva. Una aplicación clave es la simulación de ataques en entornos controlados, utilizando modelos generativos para crear datasets sintéticos que entrenen detectores de anomalías. Frameworks como TensorFlow y PyTorch soportan esta aproximación, permitiendo la generación de logs de red falsos que replican patrones de APT (Advanced Persistent Threats).

En la detección de vulnerabilidades, herramientas como GitHub Copilot, basado en Codex (un modelo generativo de OpenAI), asisten a desarrolladores en la escritura de código seguro, sugiriendo parches para debilidades comunes identificadas en el OWASP Top 10. Esto reduce el tiempo de respuesta a zero-days, con estudios de Gartner prediciendo una disminución del 40% en brechas causadas por errores humanos para 2025.

Para blockchain, la IA generativa puede analizar transacciones en tiempo real, generando modelos predictivos de fraudes mediante el aprendizaje de patrones en ledgers distribuidos. Protocolos como Chainlink oráculos integran IA para verificar datos off-chain, mitigando riesgos de manipulación en smart contracts. Las mejores prácticas incluyen el uso de federated learning, donde modelos se entrenan de forma descentralizada sin compartir datos sensibles, alineándose con regulaciones como GDPR en Europa.

| Aplicación Defensiva | Tecnología Subyacente | Beneficios Operativos | Riesgos Residuales |

|---|---|---|---|

| Simulación de ataques | GANs y Transformers | Mejora en entrenamiento de IDS/IPS | Sobreajuste a escenarios sintéticos |

| Detección de phishing | Modelos de lenguaje natural (NLP) | Filtrado en tiempo real con precisión >95% | Falsos positivos en comunicaciones legítimas |

| Análisis de blockchain | Aprendizaje profundo en ledgers | Prevención de rug pulls en DeFi | Escalabilidad en redes de alto volumen |

| Generación de parches | Copilot-like tools | Reducción de ciclo de vida de vulnerabilidades | Dependencia de modelos propietarios |

En entornos de IA explicable (XAI), técnicas como SHAP (SHapley Additive exPlanations) permiten auditar decisiones de modelos generativos, asegurando trazabilidad en respuestas a incidentes. Esto es crucial para compliance con frameworks como el CMMC (Cybersecurity Maturity Model Certification) en sectores gubernamentales.

Implicaciones Operativas y Regulatorias

La adopción de IA generativa en ciberseguridad exige una reevaluación de arquitecturas de seguridad. Operativamente, las organizaciones deben implementar zero-trust models que verifiquen outputs de IA en cada capa, utilizando protocolos como OAuth 2.0 para accesos API. El entrenamiento de personal en alfabetización de IA es esencial, cubriendo conceptos como prompt engineering para minimizar manipulaciones inadvertidas.

Regulatoriamente, el panorama es dinámico. En Latinoamérica, iniciativas como la Estrategia Nacional de Ciberseguridad de México incorporan directrices para IA, enfatizando evaluaciones de impacto. Globalmente, el NIST AI Risk Management Framework proporciona un blueprint para mitigar sesgos y adversarial attacks, recomendando pruebas de robustez como FGSM (Fast Gradient Sign Method) para validar modelos.

Los beneficios incluyen una ciberseguridad más ágil, con sistemas que se auto-mejoran mediante aprendizaje continuo. Sin embargo, riesgos como la proliferación de herramientas de IA accesibles (e.g., via plataformas como Replicate) democratizan amenazas, requiriendo colaboración internacional a través de foros como el Forum of Incident Response and Security Teams (FIRST).

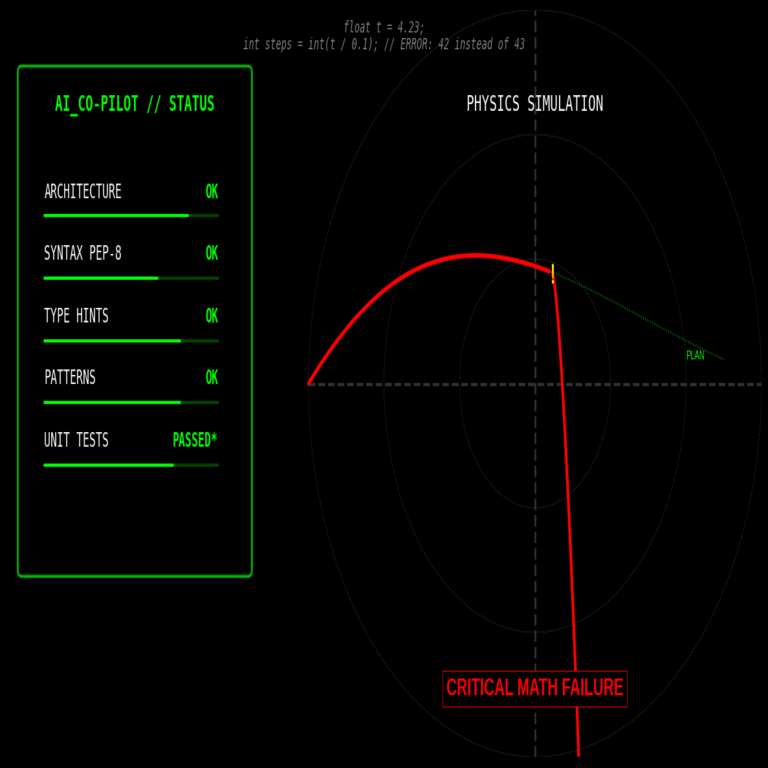

Desafíos Técnicos en la Implementación

Uno de los principales desafíos es la computabilidad: modelos generativos demandan recursos significativos, con GPUs de alto rendimiento para inferencia en tiempo real. Soluciones como edge computing desplazan procesamiento a dispositivos locales, reduciendo latencia en detección de amenazas IoT.

La privacidad de datos es otro obstáculo; el entrenamiento en datasets sensibles puede violar regulaciones. Técnicas de differential privacy agregan ruido a los datos, preservando utilidad mientras limitan inferencias individuales, como se detalla en el paper de Dwork et al. (2006).

En blockchain, la integración de IA generativa enfrenta issues de inmutabilidad: actualizaciones de modelos deben manejarse via sidechains o layer-2 solutions para evitar forks disruptivos. Herramientas como IPFS para almacenamiento descentralizado de modelos facilitan esta escalabilidad.

- Escalabilidad computacional: Optimización mediante quantization y pruning de modelos.

- Privacidad y ética: Adopción de federated learning y audits éticos.

- Integración con legacy systems: APIs wrapper para compatibilidad con SIEM tradicionales.

- Medición de efectividad: Métricas como ROC-AUC para evaluar precisión en detección.

Casos de Estudio y Evidencias Empíricas

En un caso de estudio de IBM, la implementación de IA generativa en su plataforma Watson for Cyber Security redujo falsos positivos en alertas un 50%, mediante la generación de resúmenes narrativos de incidentes que contextualizan datos crudos. Técnicamente, esto involucra fine-tuning de BERT para procesamiento de lenguaje en logs de seguridad.

Otro ejemplo es el uso de DALL-E en forense digital, generando reconstrucciones visuales de escenas de brechas para entrenamiento de analistas. En blockchain, proyectos como SingularityNET utilizan IA generativa para predecir volatilidad en mercados cripto, integrando datos on-chain con modelos predictivos.

Estudios cuantitativos, como el reporte de McAfee Labs en 2023, indican que el 60% de las organizaciones planean invertir en IA defensiva, pero solo el 25% ha abordado amenazas generativas, destacando una brecha en madurez.

Mejores Prácticas y Recomendaciones

Para maximizar beneficios, se recomiendan prácticas como el uso de sandboxes para testing de modelos generativos, asegurando aislamiento de entornos productivos. La colaboración con proveedores certificados, alineados con SOC 2 Type II, garantiza integridad en despliegues.

En términos de gobernanza, establecer comités de ética en IA para revisar aplicaciones en ciberseguridad es imperativo. Esto incluye protocolos para reporting de incidentes relacionados con IA, conforme a estándares como el ISO 31000 para gestión de riesgos.

Finalmente, la inversión en investigación continua es clave; iniciativas como el DARPA’s Guaranteeing AI Robustness Against Deception (GARD) program ofrecen marcos para hardening de modelos contra manipulaciones.

Conclusión

En resumen, la IA generativa transforma la ciberseguridad al introducir tanto amenazas innovadoras como herramientas defensivas poderosas. Su implementación exitosa depende de un equilibrio entre innovación técnica y marcos regulatorios sólidos, asegurando que los beneficios en detección y respuesta superen los riesgos inherentes. Las organizaciones que adopten un enfoque proactivo, integrando estándares globales y mejores prácticas, posicionarán sus infraestructuras para enfrentar un panorama de amenazas en constante evolución. Para más información, visita la fuente original.