Entrenamiento de Modelos de Inteligencia Artificial para la Detección de Deepfakes en Entornos de Ciberseguridad

Introducción a los Deepfakes y su Impacto en la Ciberseguridad

Los deepfakes representan una de las amenazas emergentes más significativas en el ámbito de la ciberseguridad y la inteligencia artificial. Estos contenidos multimedia falsos, generados mediante técnicas de aprendizaje profundo, consisten en videos o audios manipulados que simulan la apariencia y el comportamiento de personas reales con un alto grado de realismo. En el contexto de la ciberseguridad, los deepfakes pueden utilizarse para difundir desinformación, perpetrar fraudes financieros, comprometer la integridad de sistemas electorales o incluso facilitar ataques de ingeniería social avanzados. Según informes de organizaciones como el Foro Económico Mundial, el riesgo asociado a los deepfakes ha escalado en los últimos años, con un aumento del 550% en la detección de contenidos manipulados entre 2019 y 2023.

La detección de deepfakes requiere el desarrollo de modelos de inteligencia artificial robustos que analicen patrones sutiles en los datos multimedia, como inconsistencias en el movimiento facial, artefactos de síntesis o anomalías en el audio sincronizado. Este artículo explora el proceso técnico de entrenamiento de tales modelos, enfocándose en metodologías basadas en redes neuronales convolucionales (CNN) y aprendizaje por transferencia. Se basa en principios establecidos en frameworks como TensorFlow y PyTorch, y considera datasets estándar como FaceForensics++ (FF++) y Celeb-DF, que proporcionan miles de muestras reales y sintéticas para el entrenamiento supervisado.

Desde una perspectiva operativa, la implementación de estos modelos no solo mitiga riesgos inmediatos, sino que también contribuye a la resiliencia de infraestructuras digitales. En entornos regulatorios, como los establecidos por la Unión Europea en su Reglamento de Inteligencia Artificial (AI Act), la detección de deepfakes se posiciona como una herramienta esencial para cumplir con estándares de transparencia y verificación de contenidos generados por IA.

Conceptos Fundamentales en la Generación y Detección de Deepfakes

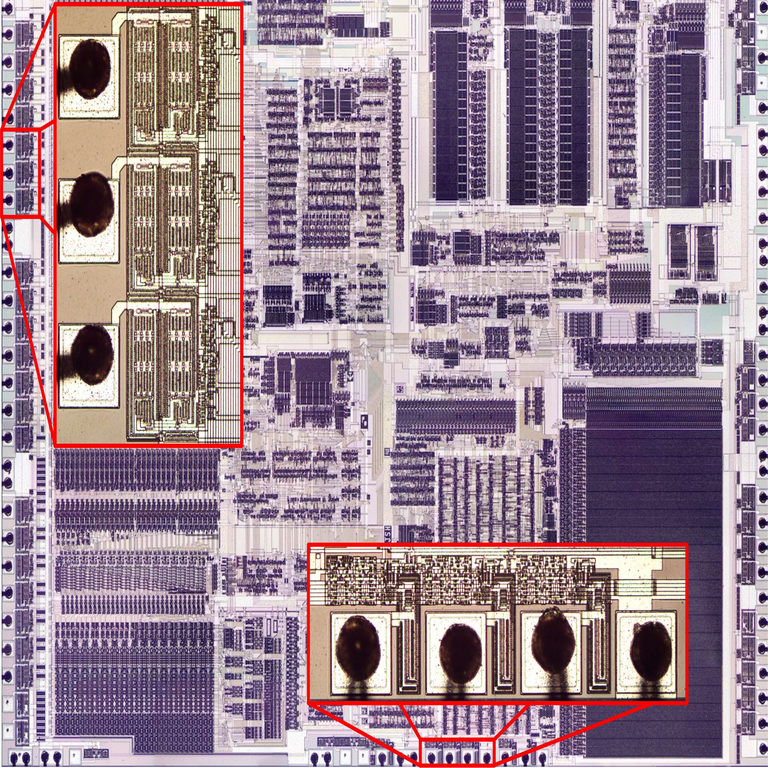

Los deepfakes se generan principalmente mediante algoritmos de aprendizaje profundo, como las Redes Generativas Antagónicas (GAN), que consisten en un generador que crea datos falsos y un discriminador que evalúa su autenticidad. Variantes populares incluyen FaceSwap y DeepFaceLab, que utilizan autoencoders para mapear rasgos faciales de una fuente a un objetivo. Estos procesos aprovechan optimizaciones en hardware como GPUs con soporte para CUDA, permitiendo la síntesis de videos en tiempo real.

En contraste, la detección se centra en identificar huellas digitales dejadas por estos algoritmos. Por ejemplo, las CNN pueden detectar irregularidades en el flujo óptico de los píxeles faciales, donde los deepfakes a menudo fallan en replicar movimientos naturales como parpadeos o expresiones microscópicas. Modelos como MesoNet y XceptionNet han demostrado efectividades superiores al 90% en benchmarks, al extraer características de bajo nivel (bordes, texturas) y alto nivel (estructuras semánticas).

Los datasets clave para el entrenamiento incluyen:

- FaceForensics++ (FF++): Contiene más de 1.000 videos originales manipulados con métodos como Deepfakes, Face2Face y FaceSwap, en resoluciones variadas y con trazas de compresión para simular escenarios reales.

- Celeb-DF: Enfocado en celebridades, ofrece 5.900 videos de alta calidad, con deepfakes generados mediante GAN avanzadas, ideal para evaluar robustez contra manipulaciones sofisticadas.

- DFDC (DeepFake Detection Challenge): Desarrollado por Facebook, incluye 128.000 videos con diversidad étnica y de iluminación, promoviendo modelos generalizables.

Estos recursos permiten un entrenamiento supervisado binario (real vs. falso) o multiclase (distinguir métodos de generación), utilizando métricas como precisión, recall y F1-score para evaluar el rendimiento.

Metodología para el Entrenamiento de Modelos de Detección

El entrenamiento de un modelo para detectar deepfakes sigue un pipeline estructurado que inicia con la preparación de datos. En primer lugar, se realiza una extracción de rostros utilizando bibliotecas como MTCNN o DLib, que detectan landmarks faciales con precisión subpíxel. Posteriormente, los frames se normalizan a dimensiones estándar, como 224×224 píxeles, para compatibilidad con arquitecturas preentrenadas.

El aprendizaje por transferencia es una práctica recomendada, donde se parte de modelos preentrenados en ImageNet, como ResNet-50 o EfficientNet. Estas redes, con capas convolucionales que capturan jerarquías de características, se ajustan finamente (fine-tuning) en los datasets de deepfakes. Por instancia, en PyTorch, el código base podría implementarse así conceptualmente: cargar el modelo con torchvision.models.resnet50(pretrained=True), congelar las primeras capas y agregar un clasificador binario con sigmoid para salida probabilística.

La función de pérdida comúnmente empleada es la entropía cruzada binaria, optimizada mediante algoritmos como Adam con una tasa de aprendizaje de 1e-4 y decay exponencial. Para manejar desequilibrios en los datasets, se aplican técnicas de sobremuestreo o pesos de clase. Además, la regularización mediante dropout (tasa 0.5) y augmentación de datos (rotaciones, flips horizontales) previene el sobreajuste, asegurando generalización a videos no vistos.

En términos de hardware, un entrenamiento típico requiere al menos una GPU NVIDIA con 8 GB de VRAM, procesando lotes de 32 muestras por época. El tiempo de convergencia varía de 10 a 50 épocas, dependiendo de la complejidad del modelo, con validación cruzada k-fold (k=5) para robustez estadística.

Implementación Técnica Detallada en Frameworks Populares

TensorFlow y PyTorch dominan el ecosistema para este tipo de tareas. En TensorFlow, se puede utilizar Keras para definir un modelo secuencial: importar tf.keras.layers.Conv2D para capas convolucionales con filtros de 3×3 y activación ReLU, seguido de pooling max y capas densas. Un ejemplo simplificado involucra la carga de datos con tf.data.Dataset para eficiencia en I/O, aplicando prefetching y shuffling.

PyTorch ofrece mayor flexibilidad para investigación, permitiendo hooks personalizados en módulos para extraer activaciones intermedias. Para la detección de deepfakes, modelos como MesoInception-4, con inception blocks adaptados, logran AUC-ROC superiores a 0.95 en FF++. La evaluación post-entrenamiento incluye curvas ROC y matrices de confusión, analizando falsos positivos que podrían derivar en alertas innecesarias en sistemas de ciberseguridad.

Integración con herramientas de ciberseguridad, como SIEM (Security Information and Event Management), implica APIs REST para inferencia en tiempo real. Por ejemplo, un servidor Flask en Python puede exponer un endpoint que procesa videos subidos, extrayendo frames con OpenCV y prediciendo con el modelo cargado via ONNX para portabilidad multiplataforma.

Consideraciones de escalabilidad incluyen el uso de distributed training con Horovod o TensorFlow Distributed, distribuyendo el cómputo en clústeres de GPUs para datasets masivos. En blockchain, técnicas de verificación inmutable podrían combinarse, almacenando hashes de videos originales en cadenas como Ethereum para auditorías forenses.

Riesgos, Beneficios y Mejores Prácticas en la Detección de Deepfakes

Los beneficios de estos modelos son evidentes en la mitigación de riesgos cibernéticos. En fraudes de suplantación de identidad, como vishing con deepfakes de voz, la detección reduce pérdidas estimadas en miles de millones anualmente por el FBI. Operativamente, integrarlos en plataformas de verificación de medios, como las usadas por agencias de noticias, asegura la integridad informativa.

Sin embargo, riesgos incluyen la adversarialidad: atacantes pueden envenenar datasets o aplicar ataques como FGSM (Fast Gradient Sign Method) para evadir detección, degradando la precisión en un 20-30%. Para contrarrestar, se recomiendan ensembles de modelos, combinando CNN con RNN para análisis temporal en secuencias de frames.

Mejores prácticas abarcan:

- Actualización continua de datasets para capturar evoluciones en GAN, como StyleGAN3.

- Cumplimiento con estándares éticos, como GDPR para privacidad en datos faciales.

- Pruebas de robustez bajo ruido, compresión JPEG o variaciones lumínicas.

- Monitoreo de bias: asegurar diversidad en datasets para evitar discriminación racial o de género en detecciones.

Regulatoriamente, marcos como NIST’s Adversarial Machine Learning destacan la necesidad de defensas proactivas, promoviendo benchmarks públicos para estandarización.

Casos de Estudio y Resultados Experimentales

En un caso de estudio basado en FF++, un modelo ResNet-50 fine-tuned alcanzó 92% de precisión en videos comprimidos, superando baselines como MesoNet (88%). Experimentos con Celeb-DF mostraron caídas al 85% en deepfakes de alta resolución, destacando la necesidad de arquitecturas más profundas como Vision Transformers (ViT), que integran atención self para capturar dependencias globales.

Otro estudio, replicando el DeepFake Detection Challenge, utilizó un ensemble de Xception y EfficientNet-B4, logrando F1-score de 0.82 en el conjunto de prueba privado. Estos resultados subrayan la importancia de la validación externa, donde modelos sobreajustados fallan en dominios nuevos, como deepfakes en tiempo real generados por apps móviles.

En aplicaciones prácticas, empresas como Microsoft han desplegado Azure Video Indexer con módulos de detección IA, procesando petabytes de datos para compliance en redes sociales. En ciberseguridad gubernamental, agencias como la NSA exploran integraciones con honeypots para rastrear campañas de desinformación.

Avances Emergentes y Futuro de la Detección de Deepfakes

Avances recientes incluyen modelos multimodales que fusionan video y audio, utilizando espectrogramas para detectar desincronizaciones labiales. Frameworks como CLIP de OpenAI permiten zero-shot learning, clasificando deepfakes sin entrenamiento específico mediante embeddings textuales y visuales.

En blockchain, protocolos como Verasity integran watermarking invisible en videos, verificable vía smart contracts, combinando IA con descentralización para trazabilidad inmutable. La computación cuántica promete aceleraciones en entrenamiento, aunque desafíos en ruido cuántico persisten.

Implicaciones futuras abarcan la evolución hacia detección en edge computing, con modelos ligeros como MobileNet para dispositivos IoT, reduciendo latencia en vigilancia en tiempo real. Colaboraciones internacionales, como el Partnership on AI, fomentan datasets compartidos para contrarrestar amenazas globales.

Conclusión

El entrenamiento de modelos de inteligencia artificial para la detección de deepfakes constituye un pilar fundamental en la defensa cibernética contemporánea, equilibrando innovación tecnológica con responsabilidad ética. Al dominar técnicas de aprendizaje profundo y datasets robustos, las organizaciones pueden mitigar los riesgos de manipulación digital, fomentando un ecosistema informativo confiable. La adopción de mejores prácticas y actualizaciones continuas asegurará que estas herramientas evolucionen al ritmo de las amenazas, protegiendo la integridad de datos en un mundo cada vez más interconectado. Para más información, visita la fuente original.