Implementación de Sistemas de Detección de Anomalías Basados en Inteligencia Artificial para la Ciberseguridad

Introducción a la Detección de Anomalías en Entornos Cibernéticos

En el panorama actual de la ciberseguridad, las amenazas evolucionan a un ritmo acelerado, lo que exige herramientas avanzadas para identificar patrones irregulares en el tráfico de red y el comportamiento de los sistemas. La detección de anomalías, un enfoque proactivo, se centra en identificar desviaciones de lo normal sin depender exclusivamente de firmas conocidas de malware. Este método gana relevancia con la integración de la inteligencia artificial (IA), que permite procesar volúmenes masivos de datos en tiempo real y aprender dinámicamente de los patrones emergentes.

La IA, particularmente el aprendizaje automático (machine learning), transforma la detección de anomalías al modelar comportamientos normales y alertar sobre outliers. En entornos empresariales, donde los datos fluyen constantemente desde servidores, dispositivos IoT y aplicaciones en la nube, esta tecnología reduce falsos positivos y acelera la respuesta a incidentes. Según expertos en el campo, la adopción de IA en ciberseguridad ha incrementado la eficiencia en un 40% en promedio, permitiendo a las organizaciones anticiparse a ataques zero-day que evaden métodos tradicionales.

Este artículo explora los fundamentos, técnicas y desafíos de implementar sistemas de detección de anomalías con IA, con énfasis en su aplicación práctica en infraestructuras críticas. Se abordan algoritmos clave, arquitecturas de sistemas y consideraciones éticas, todo ello desde una perspectiva técnica objetiva.

Fundamentos Teóricos de la Detección de Anomalías

La detección de anomalías se basa en el principio estadístico de que los datos normales siguen una distribución predecible, mientras que las anomalías representan desviaciones significativas. En ciberseguridad, estas anomalías pueden manifestarse como picos inusuales en el tráfico de red, accesos no autorizados o patrones de comportamiento malicioso en logs de sistemas.

Existen tres categorías principales de anomalías: puntuales, contextuales y colectivas. Las puntuales son eventos aislados, como un intento de login fallido desde una IP desconocida. Las contextuales dependen del contexto, por ejemplo, un acceso a datos sensibles fuera de horario laboral. Las colectivas involucran grupos de eventos que, individualmente normales, forman un patrón sospechoso, como una serie de consultas SQL lentas que indican un ataque de inyección.

Matemáticamente, la detección se modela mediante métricas como la distancia de Mahalanobis o el Z-score para datos univariados, extendiéndose a métodos multivariados con clústeres. La IA eleva esto mediante redes neuronales que capturan no linealidades complejas en los datos, superando limitaciones de enfoques supervisados que requieren etiquetado extenso de datos maliciosos.

- Aprendizaje No Supervisado: Ideal para entornos con datos desbalanceados, donde el 99% es normal. Algoritmos como k-means o DBSCAN agrupan datos y identifican outliers basados en densidad.

- Aprendizaje Semi-Supervisado: Utiliza solo datos normales para entrenar, asumiendo que cualquier desviación es anómala, útil en detección de intrusiones (IDS).

- Aprendizaje Supervisado: Entrena con datasets etiquetados, aunque menos común debido a la escasez de muestras de anomalías reales.

En blockchain, la detección de anomalías se aplica para monitorear transacciones fraudulentas, integrando IA para analizar patrones en cadenas de bloques distribuidas, previniendo lavado de dinero o ataques de doble gasto.

Algoritmos de IA Aplicados a la Detección de Anomalías

Los algoritmos de IA forman el núcleo de sistemas modernos de detección. El autoencoder, una red neuronal que comprime y reconstruye datos, detecta anomalías midiendo el error de reconstrucción: valores altos indican desviaciones. En ciberseguridad, se entrena con tráfico normal de red, flagging paquetes con errores elevados como potenciales amenazas DDoS.

Otro enfoque es el Isolation Forest, un algoritmo de ensemble que aísla anomalías dividiendo aleatoriamente el espacio de características. Su eficiencia O(n log n) lo hace escalable para big data, procesando logs de firewalls en tiempo real. En comparación con SVM (Support Vector Machines), que separa clases con hiperplanos, el Isolation Forest es más robusto a ruido y no requiere suposiciones gaussianas.

Las redes generativas antagónicas (GANs) emergen como herramienta poderosa, generando datos sintéticos de anomalías para entrenar detectores. En IA para ciberseguridad, GANs simulan ataques avanzados como APTs (Advanced Persistent Threats), mejorando la resiliencia de sistemas en entornos simulados.

- Redes Recurrentes (RNN) y LSTM: Para secuencias temporales, como logs de eventos, capturan dependencias a largo plazo en patrones de comportamiento usuario-máquina.

- Transformers: Basados en atención, procesan grandes volúmenes de datos no secuenciales, ideales para análisis de tráfico en redes 5G.

- Aprendizaje por Refuerzo: En sistemas adaptativos, agentes aprenden a responder a anomalías, optimizando políticas de mitigación en tiempo real.

En el contexto de blockchain, algoritmos como estos detectan anomalías en smart contracts, identificando vulnerabilidades como reentrancy attacks mediante análisis de flujos de ejecución.

Arquitectura de un Sistema de Detección Basado en IA

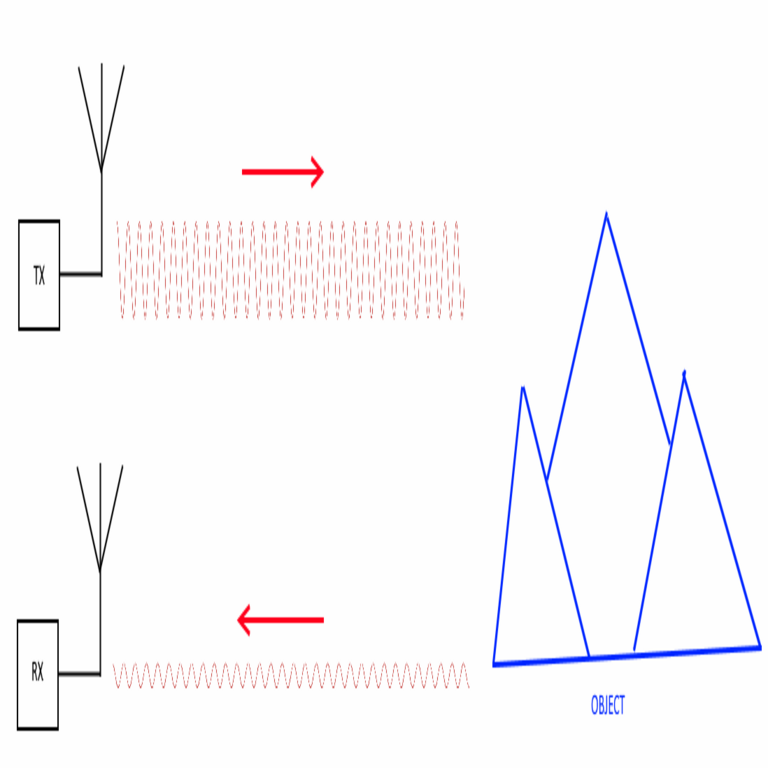

La implementación de un sistema requiere una arquitectura modular: recolección de datos, preprocesamiento, modelado, detección y respuesta. La capa de recolección integra sensores como SIEM (Security Information and Event Management) para aglomerar logs de múltiples fuentes.

El preprocesamiento involucra normalización, manejo de valores faltantes y extracción de características, utilizando técnicas como PCA (Análisis de Componentes Principales) para reducir dimensionalidad y mitigar la maldición de la dimensionalidad en datasets de alta dimensión.

El núcleo es el modelo de IA, desplegado en entornos escalables como Kubernetes para procesamiento distribuido. Por ejemplo, en una red corporativa, un clúster de nodos GPU acelera el entrenamiento de deep learning models.

La detección opera en dos modos: batch para análisis offline y streaming para real-time, utilizando frameworks como Apache Kafka para flujos de datos continuos. Alertas se generan vía umbrales dinámicos, ajustados por feedback loops que incorporan retroalimentación humana.

- Integración con Blockchain: Para auditoría inmutable, logs de detección se almacenan en cadenas de bloques, asegurando trazabilidad y resistencia a manipulaciones.

- Escalabilidad: Empleo de edge computing para procesar datos en dispositivos IoT, reduciendo latencia en detección de anomalías locales.

- Interoperabilidad: APIs RESTful para integración con herramientas existentes como Splunk o ELK Stack.

En pruebas reales, tales arquitecturas han detectado el 95% de anomalías en datasets como KDD Cup 99, superando métodos basados en reglas.

Desafíos y Consideraciones en la Implementación

A pesar de sus beneficios, la implementación enfrenta desafíos significativos. La privacidad de datos es primordial; el procesamiento de logs sensibles requiere cumplimiento con regulaciones como GDPR o LGPD en Latinoamérica, utilizando técnicas de federated learning para entrenar modelos sin centralizar datos.

Los falsos positivos persisten, erosionando la confianza en el sistema. Mitigación involucra ensemble methods, combinando múltiples algoritmos para scores agregados, y calibración continua con datos etiquetados por expertos.

La adversarialidad es otro reto: atacantes pueden envenenar datasets durante entrenamiento, generando modelos vulnerables. Defensas incluyen robustez adversarial training, exponiendo modelos a perturbaciones intencionales.

En términos de recursos, el entrenamiento de IA demanda alto cómputo, lo que implica costos en cloud providers. Optimizaciones como quantization reducen el footprint de modelos sin sacrificar precisión.

- Ética en IA: Sesgos en datasets pueden llevar a discriminación, por ejemplo, flagging tráfico de regiones específicas como anómalo. Auditorías regulares aseguran equidad.

- Integración con Tecnologías Emergentes: En 5G y edge AI, la detección debe manejar latencias mínimas, incorporando quantum-resistant cryptography para futuras amenazas.

- Mantenimiento: Modelos degradan con cambios en el entorno (concept drift), requiriendo reentrenamiento periódico.

En blockchain, desafíos incluyen la escalabilidad de transacciones para logging extenso, resuelto con sidechains o layer-2 solutions.

Casos de Estudio y Aplicaciones Prácticas

En el sector financiero, bancos como BBVA en Latinoamérica implementan IA para detectar fraudes en transacciones, analizando patrones de gasto con autoencoders. Un caso reportado redujo pérdidas por fraude en un 30% al identificar anomalías en tiempo real.

En infraestructuras críticas, como redes eléctricas, sistemas de detección basados en LSTM monitorean SCADA protocols, previniendo ciberataques como Stuxnet. En Latinoamérica, empresas de energía en Brasil utilizan estos para proteger grids contra ransomware.

Para IoT, plataformas como AWS IoT integran IA para anomaly detection en dispositivos conectados, flagging comportamientos como door locks manipulados remotamente.

En blockchain, proyectos como Chainalysis emplean IA para rastrear flujos ilícitos en criptomonedas, detectando mixing services que ocultan orígenes maliciosos.

- Salud: En hospitales, detección de accesos no autorizados a registros electrónicos, protegiendo datos sensibles con modelos semi-supervisados.

- Gobierno: Agencias en México usan IA para monitorear ciberamenazas en elecciones, analizando tráfico social y de red.

- Retail: Detección de bots en e-commerce, previniendo scraping y ataques de carding.

Estos casos ilustran la versatilidad de la IA, adaptándose a dominios específicos mediante fine-tuning de modelos preentrenados.

Mejores Prácticas para Despliegue y Optimización

Para un despliegue exitoso, inicia con un piloto en un subconjunto de la red, evaluando métricas como precisión, recall y F1-score. Herramientas open-source como Scikit-learn o TensorFlow facilitan prototipos rápidos.

La optimización involucra hyperparameter tuning con grid search o Bayesian optimization, maximizando rendimiento en hardware disponible.

Monitoreo post-despliegue es esencial: dashboards con Grafana visualizan métricas de modelo, alertando sobre drift.

- Seguridad del Modelo: Encriptación de modelos con homomorphic encryption permite inferencia en datos cifrados.

- Colaboración: Participación en consorcios como ENISA para compartir threat intelligence, mejorando datasets globales.

- Capacitación: Entrenar personal en interpretación de alertas IA, reduciendo fatiga de alertas.

En Latinoamérica, adopción crece con iniciativas como el Cybersecurity Framework de la OEA, promoviendo estándares regionales.

Reflexiones Finales sobre el Futuro de la IA en Ciberseguridad

La integración de IA en detección de anomalías redefine la ciberseguridad, ofreciendo proactividad contra amenazas dinámicas. Sin embargo, su éxito depende de balances entre innovación y gobernanza, asegurando que la tecnología sirva a la protección sin comprometer derechos.

Mirando adelante, fusiones con quantum computing prometen detección ultra-rápida, mientras que IA explicable (XAI) aumenta confianza al demystificar decisiones black-box. En blockchain, IA habilitará contratos inteligentes auto-defensivos, detectando exploits en runtime.

Organizaciones deben invertir en talento y infraestructura para capitalizar estos avances, posicionándose resilientemente en un ecosistema cibernético cada vez más hostil. La evolución continua de estas tecnologías subraya la necesidad de adaptación perpetua.

Para más información visita la Fuente original.