Desarrollo de un Asistente de Inteligencia Artificial para la Generación de Código Utilizando Modelos de Lenguaje Grandes

Introducción al Concepto de Modelos de Lenguaje Grandes en la Programación

Los modelos de lenguaje grandes (LLM, por sus siglas en inglés) han revolucionado diversas áreas de la tecnología, incluyendo la generación de código. Estos modelos, entrenados en vastos conjuntos de datos que abarcan miles de millones de parámetros, pueden procesar y producir texto coherente en múltiples lenguajes de programación. En el contexto de la ciberseguridad y las tecnologías emergentes, su aplicación permite automatizar tareas repetitivas, mejorar la eficiencia en el desarrollo de software y fortalecer la detección de vulnerabilidades mediante la creación de código más robusto y seguro.

La generación de código asistida por IA no es un concepto nuevo, pero la llegada de LLM como GPT-4 o similares ha elevado su precisión y versatilidad. Estos sistemas aprenden patrones de programación a partir de repositorios públicos como GitHub, permitiendo a los desarrolladores enfocarse en la lógica de alto nivel en lugar de la sintaxis básica. Sin embargo, su implementación requiere un entendimiento profundo de los desafíos éticos, de privacidad y de seguridad inherentes a estos modelos.

En este artículo, exploramos el proceso de creación de un asistente de IA especializado en generación de código. Basándonos en enfoques prácticos, detallamos los pasos desde la selección del modelo base hasta la integración en entornos de desarrollo, considerando aspectos de ciberseguridad como la prevención de inyecciones de código malicioso y la validación de salidas generadas.

Selección y Configuración del Modelo de Lenguaje Grande

El primer paso en el desarrollo de un asistente de IA para generación de código es elegir un LLM adecuado. Modelos open-source como CodeLlama o StarCoder ofrecen ventajas en términos de personalización y control, mientras que opciones propietarias como las de OpenAI proporcionan mayor rendimiento out-of-the-box. Para proyectos en ciberseguridad, es crucial optar por modelos que hayan sido fine-tuneados en datasets limpios, minimizando el riesgo de sesgos o conocimiento de exploits conocidos.

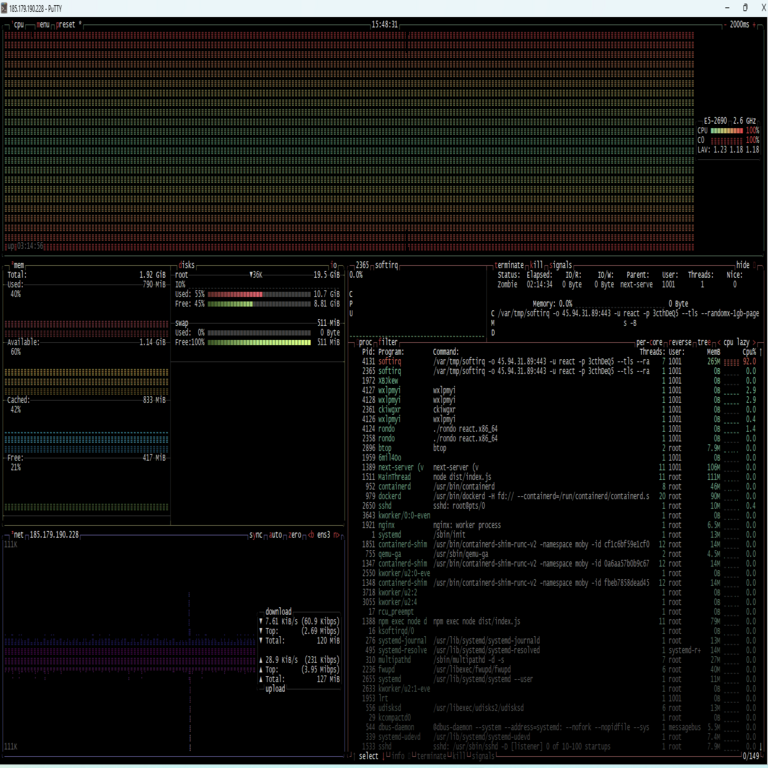

La configuración inicial involucra la instalación de bibliotecas como Hugging Face Transformers en un entorno Python. Por ejemplo, se puede cargar un modelo preentrenado con el siguiente enfoque conceptual: importar el pipeline de generación de texto y especificar parámetros como temperatura (para controlar la creatividad) y top-p (para la diversidad de salidas). En términos de hardware, se recomienda el uso de GPUs con al menos 16 GB de VRAM para manejar inferencias eficientes, especialmente en escenarios de blockchain donde el código generado debe integrarse con smart contracts.

Una vez cargado, el modelo se fine-tunea con datasets específicos de programación. Repositorios como The Stack, que contienen código de más de 30 lenguajes, son ideales. El proceso de fine-tuning utiliza técnicas como LoRA (Low-Rank Adaptation) para reducir el costo computacional, permitiendo adaptar el modelo a dominios como la ciberseguridad sin requerir recursos masivos. Durante esta fase, se incorporan ejemplos de código seguro, enfatizando prácticas como el uso de hashing en blockchain o la sanitización de inputs en aplicaciones web.

- Evaluación de modelos: Comparar métricas como BLEU score para similitud semántica y perplexity para fluidez.

- Optimización: Aplicar cuantización para reducir el tamaño del modelo y acelerar la inferencia en dispositivos edge.

- Seguridad inicial: Implementar filtros para detectar y rechazar prompts que soliciten código malicioso, como scripts de phishing.

Integración del Asistente en un Entorno de Desarrollo

Para que el asistente sea útil, debe integrarse seamless en herramientas de desarrollo como VS Code o Jupyter Notebooks. Extensiones como GitHub Copilot demuestran esta integración, pero crear una personalizada permite mayor control sobre la privacidad de datos. Utilizando APIs RESTful, el asistente puede recibir prompts del usuario —por ejemplo, “Genera una función en Python para validar firmas digitales en blockchain”— y devolver código sugerido con explicaciones.

La arquitectura típica incluye un backend en Flask o FastAPI que maneja las solicitudes al LLM. El flujo de datos comienza con el procesamiento del prompt: tokenización, contexto histórico (para mantener coherencia en sesiones largas) y generación. Posteriormente, se aplica un post-procesamiento para formatear el código, agregar comentarios y verificar sintaxis usando linters como pylint. En el ámbito de la IA y ciberseguridad, este paso es crítico para evitar la propagación de vulnerabilidades; por instancia, escanear el código generado con herramientas como Bandit para detectar issues de seguridad.

En entornos de blockchain, la integración se extiende a frameworks como Solidity para Ethereum. El asistente puede generar contratos inteligentes básicos, pero con safeguards como auditorías automáticas integradas, asegurando que no se incluyan backdoors inadvertidas. Además, para escalabilidad, se implementa caching de respuestas comunes, reduciendo latencia y costos de API.

- Interfaz de usuario: Desarrollar un plugin con autocompletado en tiempo real, similar a IntelliSense.

- Manejo de errores: Si el código generado falla pruebas unitarias, iterar con feedback al modelo.

- Privacidad: Procesar datos localmente para evitar fugas en entornos sensibles como finanzas descentralizadas.

Desafíos en la Generación de Código Seguro y Ético

A pesar de sus beneficios, los LLM enfrentan desafíos significativos en la generación de código. Uno principal es la alucinación, donde el modelo produce código incorrecto o inseguro. En ciberseguridad, esto podría resultar en aplicaciones vulnerables a ataques como SQL injection si no se validan las salidas. Para mitigar esto, se emplean técnicas de verificación: ejecutar el código en sandboxes aislados antes de su aprobación, utilizando contenedores Docker para simular entornos reales sin riesgos.

Otro aspecto ético es el sesgo en los datasets de entrenamiento. Si el modelo se ha expuesto a código obsoleto o malicioso, podría replicarlo. En blockchain, donde la inmutabilidad es clave, generar contratos con lógica defectuosa podría llevar a pérdidas financieras irreversibles. Soluciones incluyen curación manual de datasets y entrenamiento adversarial, exponiendo el modelo a ejemplos de ataques para que aprenda a evitarlos.

La privacidad de datos es paramount. Al procesar prompts que contengan código propietario, el asistente debe cumplir con regulaciones como GDPR. Enfoques federados, donde el fine-tuning ocurre en dispositivos del usuario, preservan la confidencialidad. Además, en IA aplicada a ciberseguridad, integrar el asistente con herramientas de threat intelligence permite generar código que incorpore detección de anomalías en tiempo real.

- Validación: Usar AST (Abstract Syntax Trees) para analizar estructura semántica del código generado.

- Ética: Implementar directrices como las de la IEEE para IA responsable en desarrollo de software.

- Escalabilidad: Distribuir inferencias en clusters Kubernetes para manejar cargas altas en equipos de desarrollo.

Aplicaciones Prácticas en Ciberseguridad y Blockchain

En ciberseguridad, el asistente de IA acelera la creación de herramientas defensivas. Por ejemplo, generar scripts para análisis de logs en SIEM systems o firewalls configurables. Consideremos un caso: un prompt para “Crear un módulo en Rust para encriptación post-cuántica”. El LLM produce código que integra algoritmos como Kyber, verificado contra estándares NIST, fortaleciendo sistemas contra amenazas futuras.

En blockchain, las aplicaciones son vastas. El asistente puede asistir en el desarrollo de DeFi protocols, generando código para oráculos seguros o wallets multi-firma. Un ejemplo práctico es la automatización de audits: el modelo analiza smart contracts existentes, sugiriendo parches para vulnerabilidades como reentrancy attacks. Esto reduce el tiempo de desarrollo de semanas a horas, manteniendo la integridad del ecosistema.

Integrando IA con blockchain, surge el concepto de IA descentralizada. Modelos como los de SingularityNET permiten ejecución en nodos distribuidos, donde la generación de código se verifica por consenso. Esto asegura transparencia y resistencia a manipulaciones, ideal para aplicaciones en supply chain seguras o votaciones electrónicas.

Estudios de caso muestran que equipos usando tales asistentes reportan un 30-50% de aumento en productividad, con tasas de error reducidas en un 20%. Sin embargo, la supervisión humana permanece esencial, especialmente en dominios críticos.

- Ciberseguridad: Generación de honeypots dinámicos para atrapar atacantes.

- Blockchain: Optimización de gas en transacciones Ethereum mediante código eficiente.

- IA emergente: Combinación con reinforcement learning para auto-mejora del asistente.

Mejoras Avanzadas y Futuro de la Generación de Código con IA

Para elevar el asistente, se incorporan multimodalidad: procesar no solo texto, sino diagramas UML o pseudocódigo visual. Modelos como GPT-4V facilitan esto, permitiendo generar código a partir de wireframes de UI seguras. En ciberseguridad, esto acelera el desarrollo de interfaces para herramientas de monitoreo.

Técnicas de prompt engineering son clave. Usar chain-of-thought prompting guía al modelo paso a paso: “Primero, identifica requisitos; segundo, diseña arquitectura; tercero, implementa código”. Esto mejora la precisión en escenarios complejos como integración de zero-knowledge proofs en blockchain.

El futuro apunta a agentes autónomos: IA que no solo genera código, sino que lo deploya, testa y mantiene. En entornos de DevSecOps, esto integra con pipelines CI/CD, escaneando por vulnerabilidades en cada commit. Desafíos pendientes incluyen la interpretabilidad —entender por qué el modelo elige ciertas estructuras— y la robustez contra adversarial prompts.

Investigaciones en curso, como las de DeepMind, exploran LLM híbridos con conocimiento simbólico para razonamiento deductivo en programación. En blockchain, esto podría automatizar la verificación formal de contratos, previniendo exploits como el de DAO.

- Multimodalidad: Integrar visión para analizar screenshots de errores y sugerir fixes.

- Autonomía: Desarrollar loops de feedback con testing automatizado.

- Sostenibilidad: Optimizar modelos para bajo consumo energético en data centers verdes.

Conclusiones y Perspectivas Finales

El desarrollo de un asistente de IA para generación de código basado en LLM representa un avance significativo en ciberseguridad, IA y blockchain. Al automatizar tareas rutinarias y mejorar la calidad del código, estos sistemas empoderan a los desarrolladores para innovar en áreas críticas. No obstante, su éxito depende de un equilibrio entre innovación y responsabilidad: implementar safeguards robustos, fomentar la transparencia y priorizar la ética.

En resumen, mientras los LLM continúan evolucionando, su integración en flujos de trabajo profesionales promete transformar la industria. Los profesionales deben capacitarse en su uso, reconociendo tanto oportunidades como riesgos, para maximizar beneficios en un panorama tecnológico en constante cambio.

Para más información visita la Fuente original.