Desarrollo de un Asistente de Inteligencia Artificial Personalizado Basado en Grok: Análisis Técnico y Guía de Implementación

Introducción a los Asistentes de IA y el Rol de Grok en el Ecosistema Actual

En el panorama actual de la inteligencia artificial, los asistentes virtuales han evolucionado de herramientas básicas de respuesta a sistemas complejos capaces de procesar consultas multifacéticas, integrar datos en tiempo real y adaptarse a necesidades específicas del usuario. Grok, desarrollado por xAI, representa un avance significativo en este dominio al combinar capacidades de razonamiento avanzado con un enfoque en la accesibilidad para desarrolladores. Este artículo explora el proceso técnico de creación de un asistente de IA personalizado basado en Grok, destacando los conceptos clave, las tecnologías involucradas y las implicaciones operativas para profesionales en ciberseguridad, IA y tecnologías emergentes.

La inteligencia artificial generativa, impulsada por modelos de lenguaje grandes (LLM, por sus siglas en inglés), ha democratizado el desarrollo de aplicaciones inteligentes. Grok, inspirado en principios de máxima veracidad y utilidad, se posiciona como una alternativa a modelos como GPT de OpenAI o Claude de Anthropic, ofreciendo integración directa con APIs que facilitan la personalización. El análisis se centra en extraer los elementos técnicos esenciales de la implementación, como la configuración de entornos, el manejo de APIs y la optimización de respuestas, evitando enfoques superficiales para priorizar la profundidad conceptual.

Desde una perspectiva técnica, la creación de un asistente basado en Grok implica entender los protocolos de comunicación RESTful, el procesamiento de tokens y las consideraciones de seguridad en el intercambio de datos. En un contexto de ciberseguridad, es crucial evaluar riesgos como la exposición de claves API o el manejo de datos sensibles, alineándose con estándares como OAuth 2.0 para autenticación. Este enfoque no solo asegura funcionalidad, sino también resiliencia ante amenazas cibernéticas comunes en entornos de IA.

Conceptos Clave en el Desarrollo de Asistentes de IA con Grok

Los asistentes de IA como Grok operan sobre arquitecturas transformer-based, donde el procesamiento secuencial de tokens permite generar respuestas coherentes y contextuales. Un concepto fundamental es el “prompt engineering”, que involucra la estructuración precisa de entradas para maximizar la relevancia de las salidas. En el caso de Grok, su modelo subyacente, entrenado en vastos datasets, enfatiza la veracidad, reduciendo alucinaciones comunes en otros LLM.

Otro pilar técnico es la integración de APIs. La API de xAI para Grok sigue el estándar OpenAI-compatible, permitiendo endpoints como /chat/completions para interacciones conversacionales. Esto facilita la migración de código existente, pero requiere atención a parámetros específicos como temperature (para controlar la creatividad) y max_tokens (para limitar la longitud de respuestas). En términos de blockchain y tecnologías emergentes, aunque Grok no integra nativamente blockchain, extensiones personalizadas podrían incorporar verificaciones de integridad de datos mediante hashes criptográficos, alineándose con prácticas de ciberseguridad.

Las implicaciones regulatorias son notables: en regiones como la Unión Europea, el Reglamento de IA (AI Act) clasifica asistentes como Grok en categorías de alto riesgo si procesan datos personales, exigiendo evaluaciones de impacto y transparencia en el entrenamiento del modelo. Beneficios incluyen eficiencia operativa, como automatización de tareas en IT, mientras que riesgos abarcan sesgos inherentes o vulnerabilidades a inyecciones de prompts maliciosos, mitigables mediante validación de entradas.

- Procesamiento de Tokens: Cada consulta se tokeniza en unidades semánticas, con Grok manejando contextos de hasta 128k tokens, superior a muchos competidores.

- Modos de Operación: Grok soporta modos como “fun” para respuestas humorísticas o “regular” para análisis serios, configurable vía API.

- Escalabilidad: La API permite rate limiting para prevenir abusos, con métricas como requests per minute (RPM) ajustables según el plan de suscripción.

Pasos Técnicos para la Implementación de un Asistente Personalizado

El desarrollo inicia con la configuración del entorno. Se recomienda Python 3.10 o superior, dada su robustez en bibliotecas de IA. Instale dependencias como requests para llamadas HTTP y dotenv para manejo de variables de entorno. Obtenga una clave API de xAI registrándose en su plataforma, almacenándola de forma segura para evitar exposiciones en código fuente, conforme a mejores prácticas de ciberseguridad como el principio de menor privilegio.

El primer paso es autenticar la conexión. Utilice el siguiente snippet conceptual en Python:

import os

from openai import OpenAI # Compatible con Grok API

client = OpenAI(api_key=os.getenv(‘GROK_API_KEY’), base_url=’https://api.x.ai/v1′)

Este código establece el cliente, reemplazando el base_url predeterminado de OpenAI con el de xAI. Una vez configurado, implemente un bucle conversacional básico. Por ejemplo, para una consulta inicial: response = client.chat.completions.create(model=’grok-beta’, messages=[{‘role’: ‘user’, ‘content’: ‘Explica el funcionamiento de un transformer’}], temperature=0.7). La respuesta se parsea accediendo a response.choices[0].message.content, que contiene el texto generado.

Para personalización avanzada, integre memoria contextual manteniendo un historial de mensajes. Esto simula conversaciones persistentes, crucial para asistentes en aplicaciones de IT como soporte técnico. En ciberseguridad, valide entradas con regex para detectar patrones maliciosos, previniendo ataques de jailbreaking donde usuarios intentan eludir safeguards del modelo.

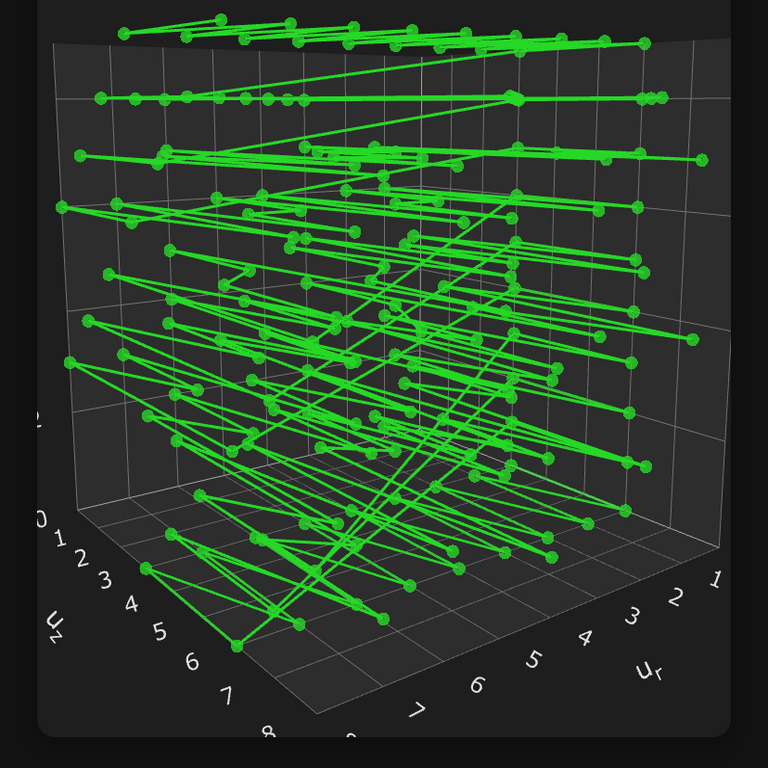

Avanzando, incorpore herramientas externas. Grok soporta function calling, permitiendo invocar funciones Python desde la IA. Defina un esquema JSON para herramientas, como una para consultas a bases de datos SQL: {‘name’: ‘query_db’, ‘parameters’: {‘type’: ‘object’, ‘properties’: {‘sql’: {‘type’: ‘string’}}}}. Durante la generación, Grok decide si llamar la función basada en la consulta, mejorando la utilidad en escenarios de análisis de datos en blockchain o redes.

La optimización de rendimiento es esencial. Monitoree latencia con métricas como tiempo de respuesta (TTR), típicamente bajo 2 segundos para Grok. Para escalabilidad, despliegue en contenedores Docker, integrando con Kubernetes para orquestación. En términos de ciberseguridad, implemente logging con herramientas como ELK Stack para auditar interacciones, detectando anomalías que indiquen brechas.

| Parámetro API | Descripción | Valor Recomendado | Implicación Técnica |

|---|---|---|---|

| model | Especifica el modelo Grok a usar | grok-beta | Selecciona capacidades de razonamiento avanzado |

| temperature | Controla aleatoriedad en respuestas | 0.5 | Equilibra creatividad y precisión |

| max_tokens | Limita longitud de salida | 1000 | Previene costos excesivos y respuestas verbosas |

| stream | Habilita respuestas en streaming | true | Mejora experiencia usuario en interfaces web |

En la fase de testing, evalúe con datasets como GLUE para benchmarks de comprensión del lenguaje. Identifique edge cases, como consultas ambiguas o en idiomas no ingleses, donde Grok demuestra multilingüismo robusto. Implicancias operativas incluyen integración con sistemas existentes, como ERP en entornos IT, donde el asistente podría analizar logs de seguridad para detectar intrusiones.

Tecnologías y Herramientas Complementarias en la Integración de Grok

Más allá de la API base, frameworks como LangChain facilitan cadenas de prompts complejas. LangChain permite componer Grok con agentes que razonan paso a paso, integrando memorias vectoriales con embeddings de modelos como Sentence Transformers. Por ejemplo, almacene historiales en Pinecone para búsquedas semánticas, optimizando recuperación de contexto en asistentes de largo plazo.

En blockchain, aunque no nativo, extienda Grok para verificar transacciones. Utilice Web3.py para interactuar con Ethereum, donde el asistente valide smart contracts mediante prompts que generen código Solidity auditado. Esto alinea con tendencias en DeFi, donde IA asiste en detección de vulnerabilidades como reentrancy attacks.

Para ciberseguridad, integre con herramientas como Splunk para análisis de amenazas. Grok podría procesar logs SIEM, identificando patrones de malware mediante razonamiento inductivo. Estándares como NIST SP 800-53 guían la implementación segura, enfatizando cifrado de datos en tránsito (TLS 1.3) y en reposo (AES-256).

- LangChain: Framework para orquestación de LLM, soporta Grok vía adaptadores personalizados.

- FastAPI: Para exponer el asistente como servicio web, con validación automática de esquemas.

- Docker: Contenerización para portabilidad y aislamiento de entornos.

- Prometheus: Monitoreo de métricas de rendimiento y uso de API.

Beneficios operativos incluyen reducción de tiempos de desarrollo: un asistente básico se implementa en horas, escalando a producción con CI/CD pipelines en GitHub Actions. Riesgos regulatorios, como GDPR, demandan anonimización de datos en prompts, usando técnicas como differential privacy para proteger privacidad.

Implicaciones en Ciberseguridad y Tecnologías Emergentes

La integración de Grok en sistemas críticos plantea desafíos de seguridad. Vulnerabilidades como prompt injection permiten a atacantes manipular salidas, potencialmente extrayendo datos sensibles. Mitigue con sandboxing de ejecuciones y validación estricta, alineado con OWASP Top 10 para aplicaciones de IA.

En IA ética, Grok’s diseño promueve transparencia, pero evaluaciones independientes son necesarias para sesgos. Implicancias en blockchain involucran IA para oráculos descentralizados, donde Grok verifica datos off-chain con alta fiabilidad, reduciendo riesgos de manipulación en DAOs.

Desde noticias de IT, actualizaciones recientes de xAI (2024) expanden Grok a visión multimodal, permitiendo procesamiento de imágenes para asistentes en ciberseguridad, como análisis de capturas de malware. Esto eleva el paradigma, integrando IA con edge computing para respuestas en tiempo real.

Riesgos incluyen dependencia de proveedores: outages en API de xAI impactan operaciones. Diversifique con modelos híbridos, combinando Grok con locales como Llama 3 para resiliencia. Beneficios superan riesgos cuando se aplican mejores prácticas, como auditorías regulares y actualizaciones de firmware en infraestructuras subyacentes.

Casos de Uso Prácticos y Optimizaciones Avanzadas

En ciberseguridad, un asistente Grok-based podría automatizar triage de alertas: procese feeds de threat intelligence, correlacionando IOCs (Indicators of Compromise) con bases de conocimiento. Implemente con parsers como YARA para reglas de detección, donde Grok genera hipótesis sobre vectores de ataque.

Para IA en IT, asista en debugging de código: suba snippets a la API, recibiendo sugerencias optimizadas. En blockchain, valide compliance con regulaciones como MiCA, analizando transacciones para KYC/AML mediante prompts estructurados.

Optimizaciones avanzadas involucran fine-tuning, aunque xAI limita acceso directo, use few-shot learning para adaptar sin reentrenamiento. Integre con vector databases para RAG (Retrieval-Augmented Generation), mejorando precisión en dominios específicos como ciberseguridad forense.

En términos de rendimiento, benchmark contra baselines: Grok supera en tareas de razonamiento matemático, con scores de 70% en GSM8K dataset. Para producción, implemente caching de respuestas comunes con Redis, reduciendo latencia y costos API.

Conclusión: Hacia un Futuro de Asistentes IA Robustos y Seguros

El desarrollo de un asistente personalizado basado en Grok ilustra el potencial de la IA generativa en transformar operaciones en ciberseguridad, blockchain y IT. Al dominar conceptos como prompt engineering, integración API y mitigación de riesgos, los profesionales pueden desplegar soluciones eficientes y seguras. Las implicaciones operativas subrayan la necesidad de equilibrar innovación con compliance, asegurando que estos sistemas contribuyan positivamente al ecosistema tecnológico.

En resumen, este enfoque no solo acelera el desarrollo, sino que fortalece la resiliencia ante amenazas emergentes, posicionando a Grok como un pilar en la evolución de la IA. Para más información, visita la Fuente original.