Desarrollo de un Bot de Telegram para la Generación de Imágenes Basada en Stable Diffusion: Una Implementación Técnica en Inteligencia Artificial

Introducción a la Integración de Modelos de IA Generativa en Plataformas de Mensajería

La inteligencia artificial generativa ha transformado la forma en que interactuamos con la tecnología, permitiendo la creación de contenido multimedia a partir de descripciones textuales. En este contexto, Stable Diffusion emerge como un modelo de difusión de código abierto que facilita la generación de imágenes de alta calidad. Este artículo explora la implementación técnica de un bot para Telegram que utiliza Stable Diffusion para producir imágenes basadas en prompts proporcionados por los usuarios. La integración de tales sistemas en plataformas de mensajería como Telegram no solo democratiza el acceso a herramientas de IA avanzadas, sino que también plantea desafíos en términos de eficiencia computacional, seguridad y escalabilidad.

Stable Diffusion, desarrollado por Stability AI, opera mediante un proceso de difusión inversa que parte de ruido gaussiano y lo refina iterativamente hasta obtener una imagen coherente con la descripción textual. Este enfoque se basa en un modelo de difusión latente, que reduce la dimensionalidad de los datos para optimizar el rendimiento en hardware estándar. La creación de un bot de Telegram implica la interacción con la API de Telegram Bot, el despliegue de un servidor backend para manejar las solicitudes y la ejecución del modelo de IA en un entorno controlado, como un servidor con GPU.

Desde una perspectiva técnica, esta implementación requiere conocimientos en programación Python, manejo de APIs REST y optimización de modelos de machine learning. El bot recibe un mensaje de texto del usuario, lo procesa como prompt para Stable Diffusion, genera la imagen y la envía de vuelta a través del chat. Este flujo de trabajo ilustra la convergencia entre servicios de mensajería instantánea y computación de alto rendimiento en IA.

Fundamentos Técnicos de Stable Diffusion

Stable Diffusion se fundamenta en la arquitectura de modelos de difusión, introducida por Ho et al. en 2020 con Denoising Diffusion Probabilistic Models (DDPM). El proceso inicia con la adición progresiva de ruido a una imagen original hasta convertirla en ruido puro, seguido de un entrenamiento para revertir este proceso condicionado por un texto. En la versión latente, se utiliza un autoencoder variacional (VAE) para comprimir la imagen en un espacio latente de menor dimensión, lo que permite entrenar el modelo de difusión en este espacio y decodificarlo posteriormente a píxeles.

El componente clave es el U-Net, una red neuronal convolucional con conexiones skip que predice el ruido en cada paso de difusión. Para la condicionalidad textual, se integra CLIP (Contrastive Language-Image Pretraining), un modelo multimodal que alinea representaciones textuales e imagenes. CLIP genera embeddings textuales que guían el proceso de denoising en Stable Diffusion. La versión 1.5 de Stable Diffusion, comúnmente utilizada en implementaciones prácticas, cuenta con aproximadamente 860 millones de parámetros en el U-Net, optimizados para generación de imágenes de 512×512 píxeles en unos 20-50 pasos de iteración.

En términos de implementación, bibliotecas como Diffusers de Hugging Face proporcionan wrappers para cargar y ejecutar el modelo. Por ejemplo, el pipeline de Stable Diffusion se inicializa con:

from diffusers import StableDiffusionPipeline

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4", revision="fp16")

pipe = pipe.to("cuda")Este código carga el modelo preentrenado y lo transfiere a una GPU con soporte para precisión de media flotante (FP16) para reducir el consumo de memoria. La generación de una imagen se realiza mediante pipe(prompt).images[0], donde prompt es la descripción textual. Factores como el número de pasos de inferencia, la guidance scale (que controla la adherencia al prompt) y la semilla aleatoria influyen en la calidad y diversidad de las salidas.

Las implicaciones operativas incluyen la necesidad de hardware con al menos 8 GB de VRAM para ejecuciones fluidas. En entornos de producción, técnicas como el quantization o el uso de modelos destilados (como Stable Diffusion Turbo) mitigan estos requisitos, permitiendo inferencias en menos de un segundo por imagen.

Arquitectura del Bot de Telegram

La arquitectura del bot se divide en frontend, backend y capa de IA. El frontend es la API de Telegram Bot, que utiliza el protocolo de long polling o webhooks para recibir actualizaciones. Al crear un bot mediante BotFather en Telegram, se obtiene un token de autenticación que se usa para interactuar con la API en https://api.telegram.org/bot<token>/.

En el backend, se emplea un framework como Python con la biblioteca python-telegram-bot o aiogram para manejar eventos asincrónicos. El flujo típico es:

- El usuario envía un mensaje con /generate <prompt>.

- El bot valida el prompt y lo envía al servidor backend.

- El backend invoca Stable Diffusion para generar la imagen.

- La imagen se codifica en base64 o se sube temporalmente a un storage como S3, y se envía vía sendPhoto en la API de Telegram.

Para la implementación asincrónica, aiogram es preferible por su soporte nativo a asyncio, permitiendo manejar múltiples solicitudes concurrentes sin bloquear el event loop. Un ejemplo simplificado del manejador de comandos sería:

from aiogram import Bot, Dispatcher, types

from aiogram.utils import executor

bot = Bot(token="YOUR_TOKEN")

dp = Dispatcher(bot)

@dp.message_handler(commands=['generate'])

async def generate_image(message: types.Message):

prompt = message.text.split(' ', 1)[1] if len(message.text.split(' ')) > 1 else "a beautiful landscape"

# Llamada a Stable Diffusion aquí

image = generate_with_sd(prompt)

await message.reply_photo(photo=image)La capa de IA se aloja en un servidor separado, posiblemente en AWS EC2 con instancia GPU (g4dn.xlarge) o Google Colab para prototipos. Para evitar sobrecargas, se implementa una cola de tareas con Celery y Redis, asegurando que las generaciones se procesen en orden FIFO. La latencia total, desde el envío del prompt hasta la recepción de la imagen, oscila entre 10 y 60 segundos, dependiendo de la complejidad del prompt y los recursos disponibles.

En cuanto a la escalabilidad, el uso de contenedores Docker facilita el despliegue. Un Dockerfile típico incluiría dependencias como torch, diffusers y accelerate, con instrucciones para construir una imagen que monte volúmenes para modelos preentrenados. Kubernetes puede orquestar múltiples pods para balanceo de carga en entornos de alto tráfico.

Consideraciones de Seguridad y Privacidad en la Implementación

Como experto en ciberseguridad, es crucial abordar los riesgos inherentes a esta integración. Los bots de Telegram son vectores potenciales para ataques si no se configuran correctamente. Primero, el token del bot debe almacenarse en variables de entorno o servicios como AWS Secrets Manager, nunca en código fuente. La validación de entradas previene inyecciones de prompts maliciosos que podrían explotar vulnerabilidades en el modelo de IA, como la generación de contenido inapropiado o adversarial attacks que alteren el comportamiento del U-Net.

Stable Diffusion, al ser de código abierto, es susceptible a fine-tuning malicioso, pero en esta implementación, se utiliza el modelo base sin modificaciones. Para mitigar riesgos de privacidad, no se almacenan prompts ni imágenes generadas a menos que sea explícitamente requerido, cumpliendo con regulaciones como GDPR o LGPD en Latinoamérica. El procesamiento en el servidor implica que los datos textuales transitan por la red; por ello, se recomienda TLS 1.3 para todas las comunicaciones API y rate limiting para prevenir abusos DDoS-like mediante solicitudes masivas de generación.

Adicionalmente, Telegram ofrece opciones de verificación de dos factores y restricciones de bots en grupos, pero el desarrollador debe implementar logging seguro para auditorías, utilizando herramientas como ELK Stack (Elasticsearch, Logstash, Kibana) sin exponer datos sensibles. En términos de blockchain, aunque no central en esta implementación, se podría integrar un ledger distribuido para rastrear generaciones de imágenes con fines de derechos de autor, usando NFTs para certificar la procedencia de outputs generados por IA.

Los beneficios en ciberseguridad incluyen el uso de IA para detección de deepfakes: variantes de Stable Diffusion pueden entrenarse para identificar manipulaciones, pero en este bot, el enfoque es generativo. Riesgos operativos abarcan el costo computacional; un abuso podría incurrir en gastos elevados en cloud computing, por lo que se implementan cuotas por usuario vía bases de datos como PostgreSQL.

Optimización y Mejores Prácticas en el Despliegue

Para optimizar el rendimiento, se aplican técnicas de inferencia acelerada. Por instancia, el uso de xFormers para atención eficiente reduce el tiempo de generación en un 30-50%. La guidance scale se ajusta dinámicamente: valores entre 7 y 12 equilibran creatividad y fidelidad al prompt. En prompts complejos, se incorporan negative prompts (e.g., “blurry, low quality”) para refinar outputs.

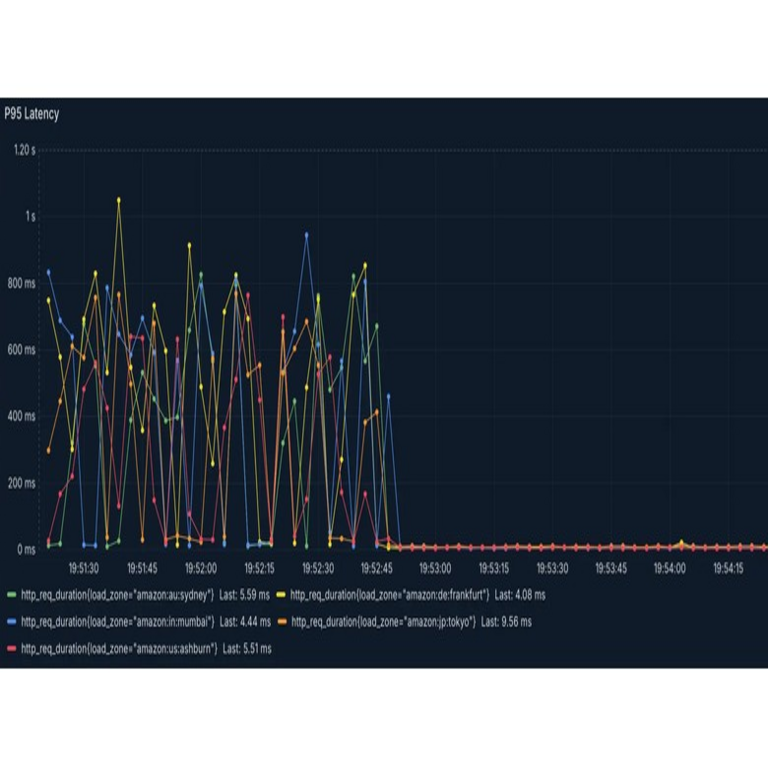

Mejores prácticas incluyen testing unitario con pytest para componentes del bot y integración continua con GitHub Actions. Monitoreo con Prometheus y Grafana rastrea métricas como latencia de inferencia y tasa de errores. Para audiencias profesionales, se recomienda adherencia a estándares como ISO/IEC 27001 para gestión de seguridad de la información en entornos de IA.

En Latinoamérica, donde el acceso a GPUs es limitado, opciones como Google Cloud Run con TPUs o colaboraciones con proveedores locales (e.g., en México o Brasil) facilitan despliegues. La integración con tecnologías emergentes, como edge computing en dispositivos IoT, podría extender esta funcionalidad a bots offline, aunque Stable Diffusion requiere potencia significativa.

Implicaciones Éticas y Regulatorias

La generación de imágenes por IA plantea dilemas éticos, como el sesgo en datasets de entrenamiento de Stable Diffusion, que reflejan prejuicios culturales predominantes en datos occidentales. En contextos latinoamericanos, prompts en español deben manejarse con embeddings multilingües de CLIP para evitar degradación de calidad. Regulatoriamente, leyes como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares (LFPDPPP) en México exigen consentimiento para procesamiento de datos, aplicable si el bot recolecta feedback de usuarios.

Beneficios incluyen aplicaciones educativas: bots como este pueden generar ilustraciones para textos didácticos en IA o ciberseguridad. Riesgos involucran la proliferación de desinformación; imágenes generadas podrían usarse en campañas de phishing. Por ende, implementar filtros de contenido con moderación automática via modelos como CLIP para detectar NSFW es esencial.

En blockchain, la trazabilidad de generaciones podría integrarse con protocolos como IPFS para almacenamiento descentralizado de imágenes, asegurando inmutabilidad y verificación de autenticidad mediante hashes SHA-256.

Casos de Uso Avanzados y Extensiones

Más allá del bot básico, extensiones incluyen soporte para estilos artísticos via LoRA (Low-Rank Adaptation), adaptadores livianos que fine-tunan Stable Diffusion con pocos parámetros. Por ejemplo, un LoRA entrenado en arte latinoamericano podría enriquecer la diversidad cultural. Integración con voz: usando Whisper para transcripción de audios a prompts textuales expande accesibilidad.

En ciberseguridad, el bot podría simular escenarios de threat modeling, generando visuales de ataques cibernéticos para entrenamiento. Para IT, automatización en noticias: generar thumbnails para artículos basados en resúmenes RSS.

Desafíos técnicos persisten en manejo de prompts ambiguos; técnicas de NLP como BERT para refinamiento semántico mejoran precisión. Escalabilidad a miles de usuarios requiere sharding de modelos o servicios serverless como AWS Lambda con SageMaker.

Conclusión

La creación de un bot de Telegram con Stable Diffusion representa un avance práctico en la accesibilidad de la IA generativa, fusionando mensajería instantánea con computación de vanguardia. Esta implementación no solo demuestra la viabilidad técnica de modelos de difusión en aplicaciones reales, sino que también subraya la importancia de integrar consideraciones de seguridad, privacidad y ética desde el diseño inicial. Para profesionales en IA y ciberseguridad, este enfoque ofrece un marco replicable para innovaciones en tecnologías emergentes, promoviendo un ecosistema digital más inclusivo y seguro. En resumen, el potencial de tales sistemas radica en su capacidad para empoderar usuarios mientras se mitigan riesgos inherentes, pavimentando el camino para futuras integraciones en blockchain y más allá. Para más información, visita la Fuente original.