El impacto de la IA generativa en ciberseguridad: ataques de ingeniería social a escala

La llegada de la inteligencia artificial generativa ha transformado radicalmente el panorama de la ciberseguridad. Los atacantes ahora utilizan modelos de lenguaje avanzados (LLMs) para suplantar identidades confiables y automatizar tácticas de ingeniería social a gran escala. Este artículo explora el estado actual de estos ataques, los factores que los impulsan y estrategias efectivas para prevenirlos.

El auge de los ataques basados en IA generativa

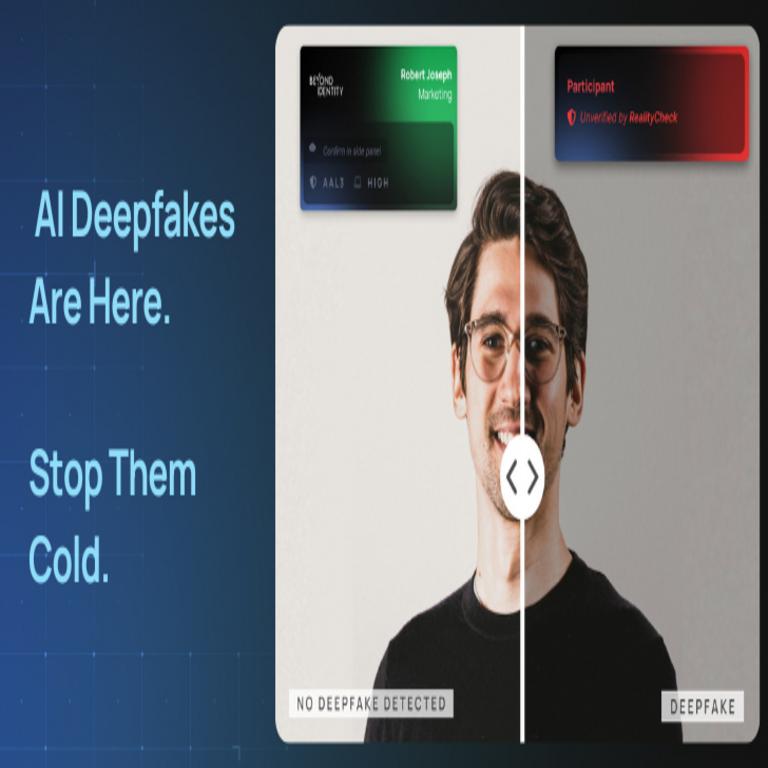

Los deepfakes y contenido generado por IA han evolucionado de ser curiosidades tecnológicas a herramientas sofisticadas para el crimen cibernético. Los atacantes pueden ahora:

- Generar voces idénticas a objetivos específicos mediante solo unos segundos de audio muestral

- Crear videos falsos convincentes de ejecutivos o figuras públicas

- Redactar mensajes de phishing altamente personalizados a escala masiva

- Automatizar conversaciones complejas que imitan el estilo de comunicación de víctimas específicas

Tecnologías subyacentes que potencian estos ataques

Varios avances en IA han hecho posible esta nueva ola de amenazas:

- Modelos de lenguaje (LLMs): GPT-4, Claude y otros modelos permiten generar texto persuasivo y contextualmente relevante

- Síntesis de voz: Tecnologías como VALL-E pueden clonar voces con alta fidelidad usando muestras mínimas

- Generación de imágenes/video: Stable Diffusion, Midjourney y DALL-E facilitan la creación de contenido visual falso

- Frameworks de automatización: Herramientas como AutoGPT permiten encadenar múltiples modelos para crear ataques complejos

Estrategias de prevención más allá de la detección

Enfocarse únicamente en detectar contenido generado por IA es una estrategia insuficiente. Las organizaciones deben implementar:

- Protocolos de verificación multifactorial: Establecer canales alternativos para confirmar solicitudes sensibles

- Controles de acceso basados en comportamiento: Sistemas que analicen patrones anómalos en tiempo real

- Educación continua: Capacitación especializada que vaya más allá del phishing tradicional

- Marcadores digitales: Implementación de watermarking en comunicaciones oficiales

- Arquitecturas Zero Trust: Verificar explícitamente cada solicitud sin asumir confianza

Implicaciones para el futuro de la seguridad corporativa

Esta evolución requiere un cambio fundamental en las estrategias de seguridad:

- Los sistemas basados en firmas estáticas son cada vez menos efectivos

- La autenticación biométrica tradicional (voz, rostro) pierde fiabilidad

- Se necesitan nuevos frameworks para establecer confianza en comunicaciones digitales

- Las políticas de seguridad deben evolucionar para abordar vectores de ataque emergentes

Para profundizar en este tema, consulta la Fuente original.

La ciberseguridad en la era de la IA generativa requiere un enfoque proactivo que combine controles técnicos avanzados con concienciación humana. Las organizaciones que adopten estas medidas estarán mejor preparadas para enfrentar esta nueva generación de amenazas digitales.