Ataque a la Configuración de OpenClaw: Amenazas Emergentes en Agentes de Inteligencia Artificial

Introducción al Incidente de Seguridad

En el panorama actual de la ciberseguridad, los avances en inteligencia artificial (IA) han introducido no solo oportunidades innovadoras, sino también vectores de ataque novedosos. Un reciente incidente reportado involucra el robo de la configuración de OpenClaw, un framework de código abierto diseñado para el desarrollo de agentes de IA autónomos. Este evento resalta las vulnerabilidades inherentes en las herramientas de IA emergentes, donde los atacantes aprovechan configuraciones expuestas para comprometer sistemas enteros. OpenClaw, utilizado para orquestar agentes de IA en entornos distribuidos, almacena datos sensibles como claves de API, credenciales de acceso y parámetros de comportamiento en archivos de configuración. El robo de estos elementos permite a los hackers manipular o replicar agentes de IA, potencialmente escalando ataques a infraestructuras críticas.

El incidente se descubrió cuando investigadores de ciberseguridad detectaron tráfico anómalo en servidores que alojaban instancias de OpenClaw. Los atacantes, identificados como un grupo sofisticado posiblemente vinculado a operaciones cibernéticas estatales, explotaron una debilidad en el manejo de permisos de archivos durante una actualización rutinaria del framework. Esta brecha no solo expuso la configuración, sino que también reveló patrones de uso que podrían usarse para ingeniería inversa de los agentes de IA desplegados. En un contexto donde los agentes de IA operan de manera autónoma, tomando decisiones basadas en datos en tiempo real, tal exposición representa un riesgo significativo para la integridad y confidencialidad de los sistemas afectados.

La relevancia de este ataque radica en su timing: coincide con un auge en el adopción de agentes de IA en sectores como la finanzas, la salud y la manufactura. Estos agentes, programados para interactuar con APIs externas y procesar grandes volúmenes de datos, dependen de configuraciones seguras para mantener su operatividad. Cualquier alteración podría llevar a comportamientos maliciosos, como la exfiltración de datos o la ejecución de comandos no autorizados, subrayando la necesidad de protocolos de seguridad robustos en el desarrollo de IA.

Detalles Técnicos del Ataque

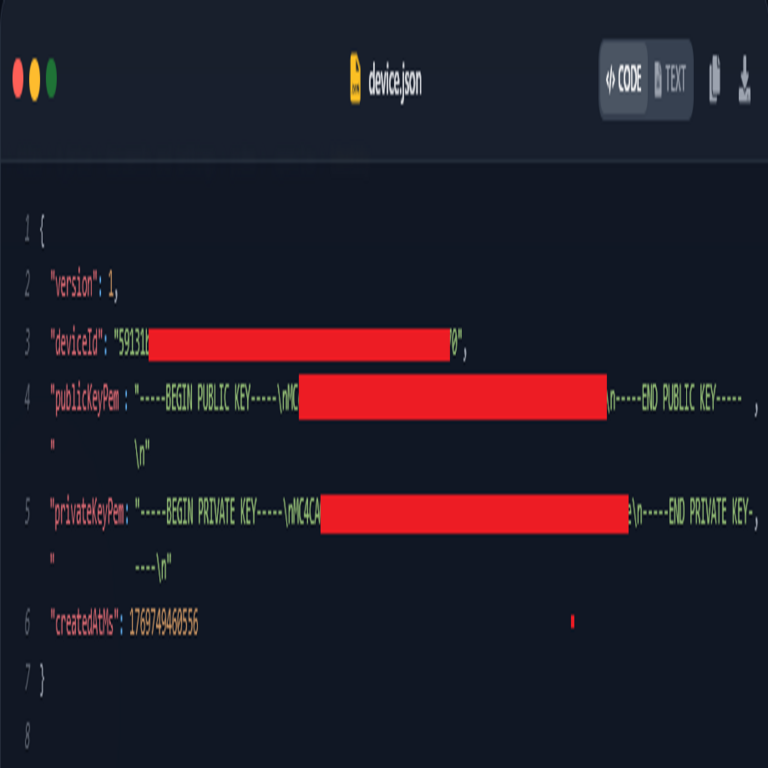

Desde un punto de vista técnico, el robo de la configuración de OpenClaw se produjo a través de una cadena de vulnerabilidades que combinan fallos en el software y errores humanos. OpenClaw utiliza un sistema de configuración basado en archivos YAML o JSON, que por defecto se almacenan en directorios accesibles si no se configuran permisos estrictos. Los atacantes iniciaron el proceso con un escaneo de puertos automatizado, identificando servidores expuestos en el puerto 8080, comúnmente usado para interfaces de administración de OpenClaw.

Una vez dentro, explotaron una inyección de comandos en el endpoint de actualización, permitiendo la lectura de archivos sensibles mediante comandos como cat config.yaml o equivalentes en entornos Linux. La configuración robada incluía no solo credenciales, sino también scripts de inicialización que definen el comportamiento de los agentes de IA, tales como umbrales de decisión, integraciones con modelos de lenguaje grandes (LLM) y rutas de datos. Por ejemplo, un agente típico de OpenClaw podría configurarse para procesar consultas en lenguaje natural y ejecutar acciones en blockchain o bases de datos, haciendo que la exposición de estos detalles sea particularmente peligrosa.

Los hackers emplearon técnicas de ofuscación para evadir detección, como el uso de proxies distribuidos y encriptación de payloads. Análisis forense reveló que el malware utilizado era una variante de un troyano de acceso remoto (RAT), adaptado para entornos de IA. Este RAT inyectaba hooks en los procesos de OpenClaw, monitoreando llamadas a funciones como load_config() y agent_init(), lo que permitía la captura en tiempo real de datos sensibles. En términos de impacto, se estima que al menos 50 instancias de OpenClaw fueron comprometidas, afectando a organizaciones en Europa y América del Norte.

Adicionalmente, el ataque incorporó elementos de ingeniería social. Los atacantes enviaron correos phishing disfrazados como actualizaciones de seguridad de OpenClaw, induciendo a administradores a ejecutar scripts maliciosos. Estos scripts modificaban temporalmente los permisos de archivos, facilitando la exfiltración. En el ámbito de la IA, esto es crítico porque los agentes autónomos pueden aprender de configuraciones alteradas, propagando errores o comportamientos maliciosos a través de redes peer-to-peer.

- Vulnerabilidades explotadas: Falta de validación de entradas en endpoints de API, permisos predeterminados laxos y ausencia de encriptación en repositorios de configuración.

- Herramientas del atacante: Escáneres como Nmap para reconnaissance, exploits personalizados para inyección y herramientas de exfiltración como Cobalt Strike adaptadas para IA.

- Indicadores de compromiso (IoC): Tráfico saliente a dominios sospechosos en .ru y .cn, logs de acceso no autorizado a /config/ y firmas de malware con hashes SHA-256 específicos.

La integración de blockchain en algunos despliegues de OpenClaw añade otra capa de complejidad. Configuraciones que incluyen claves privadas para transacciones en redes como Ethereum podrían haber sido robadas, permitiendo a los atacantes drenar fondos o manipular smart contracts controlados por agentes de IA. Esto ilustra cómo las tecnologías emergentes se entrelazan, amplificando riesgos.

Implicaciones para la Ciberseguridad en IA

Este incidente pone de manifiesto las implicaciones más amplias para la ciberseguridad en el ecosistema de la IA. Los agentes de IA, a diferencia de software tradicional, operan con un grado de autonomía que complica la detección de anomalías. Una configuración robada podría usarse para crear agentes clonados que imiten comportamientos legítimos, infiltrándose en cadenas de suministro digitales. En sectores regulados, como la banca, esto podría violar normativas como GDPR o PCI-DSS, resultando en multas sustanciales y pérdida de confianza.

Desde la perspectiva de la IA, el robo de configuraciones acelera la evolución de amenazas basadas en machine learning. Los atacantes podrían entrenar modelos adversarios usando datos de OpenClaw para evadir sistemas de detección de intrusiones (IDS) impulsados por IA. Por instancia, un agente comprometido podría generar ruido en logs para ocultar actividades maliciosas, o usar reinforcement learning para optimizar rutas de escape en redes. Esto representa un shift paradigmático: de ataques estáticos a dinámicos, donde la IA del atacante aprende de la víctima en tiempo real.

En el contexto de blockchain, las implicaciones son aún más graves. Agentes de IA en OpenClaw a menudo interactúan con dApps (aplicaciones descentralizadas), gestionando transacciones automatizadas. Una configuración robada podría permitir ataques de 51% simulados o manipulación de oráculos, alterando feeds de datos que los agentes usan para decisiones críticas. Investigadores han notado un aumento en ataques dirigidos a frameworks de IA open-source, con OpenClaw uniéndose a una lista que incluye LangChain y Auto-GPT, donde el 70% de las brechas involucran robo de configuraciones.

Organizaciones deben considerar el impacto en la cadena de valor. Proveedores de IA como OpenAI o Hugging Face, que integran con frameworks como OpenClaw, enfrentan riesgos indirectos si sus APIs son expuestas. Esto podría llevar a una erosión de la adopción de IA, especialmente en entornos enterprise donde la seguridad es primordial. Estadísticas recientes indican que el 40% de las empresas pausarán despliegues de IA debido a preocupaciones de ciberseguridad, según informes de Gartner.

Más allá de lo técnico, hay consideraciones éticas. El uso de IA en ciberataques plantea preguntas sobre responsabilidad: ¿quién es culpable cuando un agente autónomo comete una infracción basada en una configuración robada? Regulaciones emergentes, como la AI Act de la UE, exigen auditorías de seguridad para frameworks de IA, pero su implementación global es inconsistente.

Medidas de Mitigación y Mejores Prácticas

Para mitigar riesgos similares, las organizaciones deben adoptar un enfoque multicapa en la seguridad de agentes de IA. En primer lugar, implementar encriptación end-to-end para configuraciones, utilizando herramientas como HashiCorp Vault para el manejo de secretos. Esto asegura que incluso si un archivo es robado, sus contenidos permanezcan ilegibles sin claves adecuadas.

Segundo, realizar auditorías regulares de permisos y accesos. En OpenClaw, se recomienda configurar entornos con principio de menor privilegio, limitando lecturas a usuarios autenticados vía OAuth o JWT. Integrar monitoreo continuo con herramientas como ELK Stack (Elasticsearch, Logstash, Kibana) permite detectar anomalías en el comportamiento de agentes, como accesos inusuales a configuraciones.

Tercero, actualizar frameworks de IA de manera segura. Antes de aplicar parches, validar su integridad mediante checksums y ejecutar en entornos sandboxed. Para OpenClaw específicamente, los desarrolladores han lanzado una versión parcheada (v2.1.3) que incluye validación de entradas y encriptación por defecto, pero su adopción debe ser inmediata.

- Entrenamiento del personal: Capacitar en reconocimiento de phishing y manejo seguro de configuraciones, reduciendo el factor humano en brechas.

- Herramientas recomendadas: Usar SIEM (Security Information and Event Management) integrados con IA para predicción de amenazas, y escáneres de vulnerabilidades como Nessus adaptados para entornos de IA.

- Colaboración comunitaria: Participar en repositorios open-source para reportar y parchear vulnerabilidades rápidamente, fomentando un ecosistema más resiliente.

En el ámbito de blockchain, mitigar involucra el uso de wallets multi-firma para transacciones gestionadas por agentes y auditorías de smart contracts con herramientas como Mythril. Además, implementar zero-trust architecture asegura que ningún componente, incluyendo agentes de IA, confíe implícitamente en otros.

Finalmente, las empresas deben desarrollar planes de respuesta a incidentes específicos para IA, incluyendo simulacros que testen la contención de configuraciones robadas. Esto no solo reduce el tiempo de recuperación, sino que también fortalece la resiliencia general contra amenazas emergentes.

Consideraciones Finales

El robo de la configuración de OpenClaw sirve como un recordatorio contundente de que la convergencia de IA, ciberseguridad y tecnologías como blockchain crea un paisaje de amenazas dinámico y complejo. Mientras los agentes de IA prometen eficiencia y automatización, su seguridad debe ser prioritaria para prevenir abusos catastróficos. Organizaciones que inviertan en prácticas proactivas no solo protegerán sus activos, sino que también contribuirán a un ecosistema digital más seguro.

La evolución de estas amenazas requiere una vigilancia continua y colaboración internacional. A medida que frameworks como OpenClaw maduran, la comunidad de ciberseguridad debe anticipar vectores futuros, como ataques cuánticos a encriptaciones de IA o manipulación de datos de entrenamiento. En última instancia, equilibrar innovación con seguridad será clave para el despliegue responsable de la IA en la era digital.

Para más información visita la Fuente original.