Análisis Técnico del Backdoor SesameOP: Explotación de la API de OpenAI para Comunicaciones de Control y Comando Encubiertas

Introducción al Malware SesameOP

En el panorama evolutivo de las amenazas cibernéticas, los actores maliciosos continúan innovando en técnicas para evadir la detección y mantener la persistencia en sistemas comprometidos. Un ejemplo reciente es el backdoor denominado SesameOP, que representa una sofisticada integración entre malware tradicional y servicios de inteligencia artificial (IA). Este backdoor explota la API de OpenAI para establecer canales de control y comando (C2) encubiertos, lo que complica significativamente su identificación por parte de herramientas de seguridad convencionales. SesameOP no solo demuestra la versatilidad de los atacantes en el aprovechamiento de infraestructuras legítimas, sino que también resalta los riesgos inherentes al uso de APIs de IA en entornos no controlados.

La detección de SesameOP fue reportada por investigadores de ciberseguridad, quienes analizaron muestras que circulan en campañas dirigidas principalmente a entornos empresariales y de investigación. Este malware opera en sistemas operativos como Linux y Windows, adaptándose a diferentes arquitecturas para maximizar su alcance. Su principal innovación radica en el uso de la API de OpenAI, específicamente modelos como GPT, para codificar y decodificar comandos, lo que permite un tráfico de red que se asemeja a interacciones benignas con servicios de IA. Esta técnica no solo oculta el propósito malicioso, sino que también aprovecha la latencia y el volumen de datos inherentes a las consultas de IA para enmascarar operaciones sensibles.

Desde una perspectiva técnica, SesameOP ilustra cómo las APIs de IA, diseñadas para fomentar la innovación, pueden ser subvertidas para fines adversos. OpenAI, como proveedor líder de modelos de lenguaje grandes (LLM), ofrece una API que permite a desarrolladores integrar capacidades de procesamiento de lenguaje natural en aplicaciones. Sin embargo, la falta de restricciones estrictas en el uso de estas APIs por parte de entidades no verificadas abre vectores de abuso. En este artículo, se examinarán los componentes técnicos de SesameOP, sus mecanismos de operación, las implicaciones para la ciberseguridad y estrategias de mitigación, con un enfoque en audiencias profesionales del sector.

Descripción Técnica del Backdoor

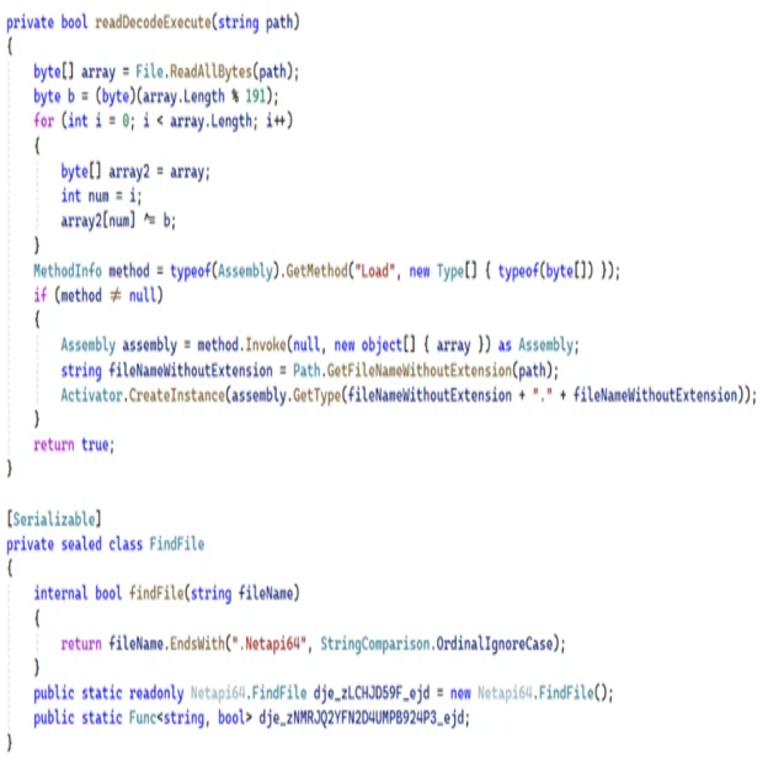

SesameOP se estructura como un backdoor modular, compuesto por un módulo principal de implantación y componentes secundarios para la comunicación y ejecución de payloads. El malware se distribuye típicamente a través de campañas de phishing o explotación de vulnerabilidades en software de gestión de servidores, como en entornos de contenedores Docker o servicios web desactualizados. Una vez implantado, el backdoor establece persistencia mediante modificaciones en el registro de Windows o en archivos de inicio de sesión en Linux, asegurando su ejecución en reinicios del sistema.

El núcleo del backdoor reside en su motor de comunicación C2, que diverge de enfoques tradicionales basados en servidores dedicados o protocolos como HTTP/HTTPS simples. En lugar de ello, SesameOP utiliza la API de OpenAI para intermediar todas las interacciones con el operador remoto. Esta elección se debe a varios factores técnicos: la API de OpenAI soporta solicitudes POST con payloads JSON que pueden contener datos codificados en base64 o cifrados con algoritmos simétricos como AES-256. El malware genera consultas que parecen ser prompts legítimos para generación de texto, pero que en realidad encapsulan comandos operativos.

Por ejemplo, un comando para exfiltrar datos podría ser codificado como un prompt que solicita “resumir el siguiente texto en español”, donde el “texto” es el payload malicioso. La respuesta del modelo de IA, procesada por el backdoor, contiene la decodificación del comando ejecutado o datos recolectados. Esta interacción se realiza a través de endpoints como https://api.openai.com/v1/chat/completions, requiriendo una clave API válida. Los atacantes obtienen estas claves mediante robo de credenciales o generación de cuentas desechables, lo que añade una capa de anonimato al no depender de infraestructura propia.

En términos de implementación, SesameOP emplea bibliotecas como requests en Python para las llamadas API, o equivalentes en C++ para versiones compiladas. El código fuente analizado revela el uso de hashing SHA-256 para validar la integridad de las respuestas de la API, asegurando que no hayan sido alteradas por filtros de contenido de OpenAI. Además, el backdoor implementa un mecanismo de rotación de claves API para evitar bloqueos por abuso, consultando un servidor secundario para actualizaciones periódicas.

Mecanismos de Explotación de la API de OpenAI

La explotación de la API de OpenAI por parte de SesameOP se basa en la comprensión profunda de su arquitectura. La API de OpenAI sigue el estándar RESTful, con autenticación vía encabezados Bearer Token. Cada solicitud incluye parámetros como model (por ejemplo, “gpt-3.5-turbo”), messages (un array de roles y contenidos) y max_tokens para limitar la respuesta. SesameOP abusa de estos parámetros para inyectar payloads que evaden los moderadores de contenido integrados en los modelos de IA.

Los moderadores de OpenAI, diseñados para detectar y rechazar prompts maliciosos, se centran en patrones de lenguaje explícito como instrucciones para generar código malicioso o contenido ilegal. Sin embargo, SesameOP emplea ofuscación semántica: los comandos se fragmentan en múltiples prompts que parecen inofensivos individualmente, pero que en conjunto forman instrucciones coherentes. Por instancia, un primer prompt podría solicitar “traducir este código a Python”, seguido de un segundo que pide “ejecutar y reportar el resultado”. Esta fragmentación reduce la probabilidad de activación de filtros, ya que los modelos de IA procesan contextos limitados por ventana de tokens.

Adicionalmente, el backdoor aprovecha la capacidad de los LLM para tareas de codificación y decodificación. Utilizando técnicas como steganografía textual, SesameOP incrusta datos en respuestas generadas, donde palabras clave o patrones numéricos representan bits de información. Un análisis forense de muestras muestra que el malware emplea un esquema de codificación personalizado basado en el índice de tokens del vocabulario de GPT, permitiendo una densidad de datos superior a métodos tradicionales como base64 puro.

Desde el punto de vista de la red, las comunicaciones de SesameOP generan tráfico que mimetiza el de aplicaciones legítimas de IA. Herramientas como Wireshark revelan paquetes HTTPS estándar hacia dominios de OpenAI, con tamaños de payload variables que coinciden con consultas de chatbots o asistentes virtuales. Esta similitud complica la detección basada en firmas de red, ya que el tráfico no exhibe anomalías como puertos no estándar o dominios sospechosos.

Implicaciones Operativas y de Riesgo

La aparición de SesameOP tiene implicaciones profundas para las operaciones de ciberseguridad en organizaciones que dependen de servicios en la nube y APIs de IA. En primer lugar, resalta la necesidad de segmentación en el uso de claves API: las credenciales de OpenAI deben limitarse a entornos específicos, con rotación frecuente y monitoreo de uso vía logs de la plataforma. Un abuso no detectado puede resultar en costos elevados para la organización, ya que cada llamada API incurre en tarifas, y en exposición de datos sensibles si el malware exfiltra información a través de prompts.

En términos de riesgos regulatorios, este backdoor plantea desafíos para el cumplimiento de normativas como el GDPR en Europa o la Ley de Privacidad de California (CCPA) en Estados Unidos. La exfiltración de datos personales a través de APIs de IA podría violar principios de minimización de datos y consentimiento, exponiendo a las empresas a sanciones. Además, en sectores regulados como finanzas o salud, donde se aplican estándares como PCI-DSS o HIPAA, el uso encubierto de IA para C2 podría comprometer auditorías de seguridad.

Los beneficios para los atacantes son evidentes: la resiliencia del canal C2. A diferencia de servidores C2 tradicionales, que pueden ser bloqueados por firewalls o listados negros, la API de OpenAI es un servicio legítimo y ampliamente accesible. Esto permite a SesameOP operar en redes corporativas con políticas de salida restrictivas, ya que el tráfico a openai.com rara vez se filtra. Sin embargo, este enfoque introduce dependencias: interrupciones en el servicio de OpenAI o mejoras en sus moderadores podrían desactivar el backdoor temporalmente.

En un contexto más amplio, SesameOP acelera la convergencia entre ciberseguridad e IA. Los profesionales deben considerar escenarios donde los modelos de IA no solo son objetivos, sino también vectores de ataque. Esto implica la adopción de frameworks como MITRE ATT&CK para mapear tácticas como TA0002 (Execution) y TA0011 (Command and Control), adaptándolos a amenazas basadas en IA.

Estrategias de Detección y Mitigación

La detección de SesameOP requiere un enfoque multifacético, combinando análisis estático, dinámico y de comportamiento. En el análisis estático, herramientas como IDA Pro o Ghidra pueden desensamblar binarios para identificar llamadas a bibliotecas de red y referencias a endpoints de OpenAI. Patrones como importaciones de curl o libcurl junto con cadenas que contienen “api.openai.com” son indicadores clave.

Para el análisis dinámico, entornos de sandbox como Cuckoo Sandbox permiten observar el comportamiento en ejecución. Monitorear llamadas API salientes y decodificar payloads en prompts puede revelar anomalías, como prompts con alta entropía o repeticiones inusuales. Herramientas de EDR (Endpoint Detection and Response) como CrowdStrike o Microsoft Defender deben configurarse para alertar sobre accesos no autorizados a APIs de terceros.

En mitigación, se recomienda la implementación de políticas de acceso basado en roles (RBAC) para claves API, utilizando servicios como Azure Key Vault o AWS Secrets Manager para su gestión segura. Monitoreo continuo con SIEM (Security Information and Event Management) como Splunk puede correlacionar logs de API con eventos de endpoint, detectando patrones como volúmenes inusuales de consultas a OpenAI desde hosts internos.

Además, las organizaciones deben adoptar mejores prácticas en el uso de IA: validar entradas y salidas de modelos con filtros personalizados, y emplear técnicas de adversarial robustness para prevenir inyecciones. En el plano defensivo, colaboraciones con proveedores como OpenAI para reportar abusos son esenciales, permitiendo la revocación rápida de claves comprometidas.

Para entornos empresariales, la integración de machine learning en detección de anomalías puede entrenarse en datasets de tráfico benigno de IA, identificando desviaciones sutiles. Frameworks como Suricata con reglas personalizadas para inspección de payloads HTTPS (usando TLS decryption) ofrecen una capa adicional de visibilidad.

Análisis Comparativo con Amenazas Similares

SesameOP no es un caso aislado; se alinea con una tendencia creciente de malware que integra servicios de IA para operaciones encubiertas. Por ejemplo, variantes anteriores como el troyano Emotet han utilizado APIs de correo electrónico para C2, pero carecen de la sofisticación semántica de SesameOP. En contraste, herramientas como Cobalt Strike han incorporado beacons que mimetizan tráfico web, pero sin el leverage de procesamiento de IA.

Otro paralelo es el uso de APIs de Google Cloud o AWS para exfiltración, donde atacantes abusan de servicios de almacenamiento para payloads. Sin embargo, la elección de OpenAI por SesameOP es particularmente ingeniosa debido a la naturaleza conversacional de los LLM, que facilita la bidireccionalidad del C2. Comparativamente, un backdoor tradicional basado en DNS tunneling exhibe patrones más predecibles, mientras que SesameOP genera ruido semántico que confunde heurísticas basadas en entropía.

En términos de evolución, este malware podría inspirar variantes que usen APIs de otros proveedores, como Anthropic o Google Bard, ampliando el ecosistema de amenazas. Los investigadores deben anticipar esto mediante estudios de threat modeling que incorporen dependencias en servicios de IA, evaluando impactos en cadenas de suministro digitales.

Consideraciones Éticas y Futuras en Ciberseguridad e IA

El surgimiento de SesameOP subraya dilemas éticos en el desarrollo de IA: ¿cómo equilibrar la accesibilidad de APIs con la prevención de abusos? Proveedores como OpenAI han implementado rate limiting y monitoreo, pero estos son reactivos. Hacia el futuro, estándares como los propuestos por NIST en su framework de IA responsable podrían estandarizar auditorías de APIs, requiriendo transparencia en el uso de datos de entrenamiento y endpoints.

Para profesionales de ciberseguridad, esto implica upskilling en IA: comprensión de tokenización, fine-tuning y prompting adversarial. Cursos certificados como CISSP con módulos de IA o especializaciones en ethical hacking de ML son recomendables. En el ámbito organizacional, políticas de zero-trust extendidas a servicios de IA aseguran verificación continua de accesos.

Finalmente, la mitigación proactiva involucra inteligencia de amenazas compartida a través de plataformas como ISACs (Information Sharing and Analysis Centers), donde se reportan IOCs (Indicators of Compromise) específicos de SesameOP, como hashes de muestras o patrones de prompts.

Conclusión

El backdoor SesameOP marca un punto de inflexión en la intersección de malware y inteligencia artificial, demostrando cómo las innovaciones legítimas pueden ser cooptadas para amplificar amenazas cibernéticas. Su explotación de la API de OpenAI para C2 encubierto no solo evade defensas tradicionales, sino que también desafía paradigmas de detección y respuesta. Las organizaciones deben priorizar la gobernanza de APIs, el monitoreo comportamental y la colaboración intersectorial para contrarrestar estas evoluciones.

En resumen, mientras la IA continúa transformando la ciberseguridad, amenazas como SesameOP exigen una adaptación rápida y técnica. Implementar las estrategias delineadas —desde análisis forense hasta políticas de acceso— fortalecerá la resiliencia contra abusos futuros, asegurando que los beneficios de la IA superen sus riesgos inherentes. Para más información, visita la fuente original.