Campañas de Fraude en Streaming: El Rol de las Herramientas de Inteligencia Artificial y Bots en Ataques Cibernéticos

Introducción al Fraude en Plataformas de Streaming

En el ecosistema digital actual, las plataformas de streaming de video y audio representan un sector en expansión que genera miles de millones de dólares en ingresos anuales. Sin embargo, esta popularidad ha atraído a actores maliciosos que explotan vulnerabilidades para perpetrar fraudes sofisticados. Las campañas de fraude en streaming involucran la manipulación artificial de métricas como vistas, reproducciones y engagement, con el objetivo de inflar ingresos publicitarios, evadir restricciones de contenido o monetizar cuentas falsas. Un análisis reciente revela que estas operaciones dependen en gran medida de herramientas de inteligencia artificial (IA) y bots automatizados, combinando algoritmos avanzados con scripts de bajo nivel para simular comportamientos humanos realistas.

El fraude en streaming no es un fenómeno nuevo, pero su evolución ha sido impulsada por avances en IA, como modelos de aprendizaje automático que generan patrones de interacción indistinguibles de los usuarios legítimos. Según informes de inteligencia de amenazas, estas campañas pueden generar pérdidas estimadas en cientos de millones de dólares para proveedores de servicios como Netflix, Spotify o YouTube, al diluir la autenticidad de las métricas y erosionar la confianza de los anunciantes. Este artículo examina los mecanismos técnicos subyacentes, las tecnologías implicadas y las implicaciones operativas para profesionales en ciberseguridad y tecnologías emergentes.

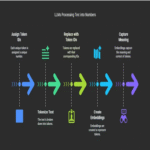

Mecanismos Técnicos de las Campañas de Fraude

Las campañas de fraude en streaming operan mediante una arquitectura multicapa que integra bots residenciales, proxies dinámicos y algoritmos de IA para evadir sistemas de detección. En su núcleo, los bots son programas automatizados que simulan acciones de usuarios, como iniciar sesiones, reproducir contenido y generar interacciones. Estos bots se despliegan en redes distribuidas, a menudo utilizando dispositivos IoT comprometidos o servidores virtuales en la nube, para distribuir el tráfico y evitar patrones detectables de IP concentrados.

La integración de IA eleva la sofisticación de estas operaciones. Modelos de machine learning, como redes neuronales recurrentes (RNN) o transformadores basados en atención, se emplean para predecir y replicar secuencias de comportamiento humano. Por ejemplo, un bot impulsado por IA puede analizar datos históricos de navegación para ajustar velocidades de reproducción, pausas y saltos de contenido, imitando variaciones naturales en el consumo de medios. Herramientas como TensorFlow o PyTorch facilitan el entrenamiento de estos modelos, permitiendo a los fraudsters adaptar sus campañas en tiempo real basados en retroalimentación de APIs de las plataformas.

Una capa crítica es el uso de proxies y VPNs residenciales, que proporcionan direcciones IP auténticas de usuarios reales para enmascarar el origen del tráfico fraudulento. Protocolos como SOCKS5 o HTTP/2 se configuran en estos proxies para manejar sesiones persistentes, mientras que scripts en Python o Node.js orquestan el flujo de datos. En campañas avanzadas, se incorporan generadores de contenido IA, como GANs (Generative Adversarial Networks), para crear perfiles falsos o incluso thumbnails y metadatos que apoyen la ilusión de engagement orgánico.

El Papel de la Inteligencia Artificial en la Generación de Tráfico Falso

La IA no solo automatiza tareas repetitivas, sino que introduce elementos de adaptabilidad que desafían los sistemas de mitigación tradicionales. En el contexto del streaming, algoritmos de refuerzo learning permiten a los bots optimizar rutas de navegación, seleccionando contenido basado en recomendaciones algorítmicas de la plataforma para maximizar el impacto. Por instancia, un modelo entrenado con datos de Q-Learning puede aprender a priorizar videos con alto potencial de monetización, simulando preferencias culturales o geográficas para evadir filtros basados en anomalías estadísticas.

Además, herramientas de procesamiento de lenguaje natural (NLP), como BERT o GPT variantes, se utilizan para generar comentarios, likes y shares que complementan el tráfico de vistas. Estos elementos sociales amplifican la credibilidad del fraude, ya que las plataformas de streaming a menudo ponderan el engagement holístico en sus algoritmos de recomendación. La implementación técnica involucra APIs de IA accesibles, como las de OpenAI o Hugging Face, integradas en pipelines de bots que operan en contenedores Docker para escalabilidad.

Desde una perspectiva de ciberseguridad, esta dependencia en IA plantea desafíos en la atribución de amenazas. Los patrones generados por IA exhiben entropía alta, similar a datos humanos, lo que complica la aplicación de heurísticas basadas en reglas. En su lugar, se requiere el despliegue de contramedidas basadas en IA, como modelos de detección de anomalías que utilizan autoencoders para identificar desviaciones sutiles en el comportamiento de usuarios.

Bots y su Evolución en Entornos de Streaming

Los bots en campañas de fraude han evolucionado de scripts simples a entidades semi-autónomas impulsadas por IA. En términos técnicos, un bot típico para streaming se construye con frameworks como Selenium o Puppeteer para interactuar con interfaces web, emulando clics, scrolls y reproducciones mediante control de navegadores headless. Estos bots se coordinan a través de C2 (Command and Control) servers, utilizando protocolos seguros como WebSockets o MQTT para recibir instrucciones en tiempo real.

La escalabilidad se logra mediante orquestación en la nube, con plataformas como AWS Lambda o Kubernetes desplegando miles de instancias en paralelo. Para mitigar detecciones, los bots incorporan técnicas de ofuscación, como rotación de user-agents y fingerprints de navegador generados dinámicamente con bibliotecas como FingerprintJS. En campañas dirigidas a audio streaming, como Spotify, los bots simulan listening sessions prolongadas, ajustando volúmenes y skips para alinearse con patrones de playlists reales.

Implicaciones operativas incluyen el consumo excesivo de recursos en servidores de plataformas, lo que puede llevar a denegaciones de servicio indirectas. Profesionales en ciberseguridad deben monitorear métricas como latencia de API y picos de tráfico no correlacionados con eventos globales, utilizando herramientas como Splunk o ELK Stack para análisis forense.

Implicaciones Regulatorias y Riesgos Económicos

Las campañas de fraude en streaming no solo representan amenazas técnicas, sino también riesgos regulatorios significativos. En jurisdicciones como la Unión Europea, el Reglamento General de Protección de Datos (GDPR) impone sanciones por manipulación de datos de usuarios, mientras que en Estados Unidos, la Federal Trade Commission (FTC) investiga prácticas de publicidad fraudulenta bajo la Ley LANHAM. Estas regulaciones exigen que las plataformas implementen controles robustos, como auditorías de tráfico y certificaciones de integridad de datos.

Económicamente, el impacto es profundo: anunciantes pagan por impresiones infladas, lo que distorsiona mercados publicitarios programáticos basados en RTB (Real-Time Bidding). Un estudio de la industria estima que el fraude en streaming cuesta al sector global más de 1.000 millones de dólares anuales, con un crecimiento proyectado del 20% debido a la adopción de IA. Para mitigar esto, se recomiendan estándares como los del Interactive Advertising Bureau (IAB), que promueven el uso de ads.txt y sellers.json para validar proveedores de inventario.

Desde el punto de vista de riesgos, las campañas pueden servir como vectores para malware más amplio. Bots distribuidos a menudo inyectan payloads maliciosos, explotando vulnerabilidades en reproductores de streaming como CVE conocidas en bibliotecas FFmpeg. La intersección con blockchain emerge como una contramedida, donde tokens no fungibles (NFTs) o ledgers distribuidos verifican autenticidad de vistas, aunque su adopción en streaming aún es incipiente.

Estrategias de Detección y Mitigación Basadas en IA

Combatir el fraude en streaming requiere un enfoque multifacético, con IA en el centro de las defensas. Sistemas de detección basados en graph neural networks (GNN) analizan redes de interacciones para identificar clústeres de bots, modelando relaciones entre cuentas y contenidos. Por ejemplo, un GNN puede detectar comunidades de perfiles con similitudes en timestamps de actividad, superando limitaciones de análisis univariados.

Otras técnicas incluyen el análisis de comportamiento en tiempo real con streaming analytics, utilizando Apache Kafka para procesar flujos de datos de sesiones. Machine learning supervisado, entrenado con datasets etiquetados de tráfico fraudulento, clasifica patrones con precisión superior al 95%, incorporando features como variabilidad de duración de sesión y diversidad de dispositivos.

En el ámbito de blockchain, protocolos como IPFS combinados con smart contracts en Ethereum permiten la verificación inmutable de métricas de streaming, reduciendo la dependencia en servidores centralizados. Herramientas open-source como Botometer o TrafficGuard ofrecen baselines para integración, mientras que colaboraciones público-privadas, como las del Media Rating Council, establecen benchmarks para validación de tráfico.

Casos de Estudio y Lecciones Aprendidas

Un caso emblemático involucra campañas contra plataformas de video en vivo, donde bots IA generaron vistas falsas durante eventos deportivos, inflando ingresos por publicidad en un 30%. El análisis post-mortem reveló el uso de modelos de IA para sincronizar bots con picos de audiencia real, utilizando APIs de geolocalización para simular distribución global.

En audio streaming, operaciones similares han explotado algoritmos de descubrimiento, con bots reproduciendo tracks de artistas emergentes para manipular charts. Lecciones incluyen la necesidad de hybridar detección rule-based con IA, y la implementación de CAPTCHA avanzados basados en desafíos de IA, como reCAPTCHA v3, que evalúan scores de riesgo sin interrupir la experiencia del usuario.

Estos casos subrayan la importancia de inteligencia de amenazas continua, con feeds como los de Dark Reading proporcionando insights accionables. Para profesionales, adoptar frameworks como MITRE ATT&CK para fraude cibernético ayuda a mapear tácticas y técnicas, facilitando respuestas proactivas.

Avances Tecnológicos y Futuro del Fraude en Streaming

El futuro de estas campañas apunta hacia una mayor integración de IA generativa, con bots capaces de crear contenido completo, como videos deepfake para streaming fraudulento. Tecnologías emergentes como edge computing distribuirán la computación de bots más cerca de los usuarios, reduciendo latencias y mejorando la stealth.

Contramedidas evolucionarán paralelamente, con quantum-resistant cryptography protegiendo APIs de streaming y federated learning permitiendo entrenamiento de modelos de detección sin compartir datos sensibles. En blockchain, soluciones como Chainlink oráculos integrarán datos off-chain para verificación de engagement, prometiendo un ecosistema más resiliente.

La colaboración entre industria y reguladores será clave, con estándares globales como ISO/IEC 27001 adaptados para integridad de datos en streaming. Profesionales deben priorizar upskilling en IA ética y ciberseguridad, asegurando que la innovación no socave la confianza digital.

Conclusión

En resumen, las campañas de fraude en streaming representan una convergencia peligrosa de IA y automatización, desafiando los fundamentos de la economía digital. Al comprender los mecanismos técnicos —desde bots residenciales hasta modelos de aprendizaje profundo— y adoptar estrategias de mitigación avanzadas, las plataformas pueden salvaguardar su integridad. Finalmente, el compromiso continuo con mejores prácticas y regulaciones robustas es esencial para preservar la autenticidad en un paisaje de contenidos cada vez más automatizado. Para más información, visita la fuente original.