Migración a Kubernetes en Entornos de Nube: Experiencias Prácticas en RUVDS

La adopción de Kubernetes como orquestador de contenedores ha transformado la gestión de infraestructuras en la nube, permitiendo una escalabilidad eficiente y una automatización robusta de aplicaciones distribuidas. En este artículo, exploramos el proceso de migración a Kubernetes en un proveedor de servicios en la nube como RUVDS, destacando los desafíos técnicos, las estrategias implementadas y las lecciones aprendidas. Este análisis se basa en prácticas reales de implementación, enfocándose en aspectos como la configuración de clústeres, la integración con herramientas de CI/CD y la optimización de recursos para entornos de producción.

Fundamentos de Kubernetes y su Relevancia en la Nube

Kubernetes, desarrollado originalmente por Google y ahora mantenido por la Cloud Native Computing Foundation (CNCF), es una plataforma de código abierto para la automatización del despliegue, escalado y operaciones de aplicaciones en contenedores. En entornos de nube como los ofrecidos por RUVDS, Kubernetes facilita la abstracción de la infraestructura subyacente, permitiendo a los equipos de DevOps centrarse en el desarrollo de software en lugar de en la gestión manual de servidores virtuales.

Los componentes clave de Kubernetes incluyen el plano de control (control plane), compuesto por el API Server, el Scheduler y el Controller Manager, y el plano de datos (data plane), que abarca los nodos worker donde se ejecutan los pods. En una migración típica, se debe considerar la compatibilidad con proveedores de nube que soportan Kubernetes gestionado, como Amazon EKS, Google GKE o, en este caso, soluciones personalizadas en RUVDS basadas en OpenStack o similares.

La relevancia de Kubernetes radica en su capacidad para manejar microservicios, implementar autoescalado horizontal (HPA) y vertical (VPA), y asegurar alta disponibilidad mediante réplicas y balanceadores de carga. Según el informe anual de la CNCF de 2023, más del 70% de las organizaciones en producción utilizan Kubernetes, con un énfasis creciente en la integración con IA para optimización predictiva de recursos.

Preparación para la Migración: Evaluación de la Infraestructura Existente

Antes de iniciar la migración, es esencial realizar una auditoría exhaustiva de la infraestructura actual. En el contexto de RUVDS, que ofrece servidores virtuales (VPS) y clústeres dedicados, se evalúa el uso de recursos como CPU, memoria y almacenamiento. Herramientas como Prometheus y Grafana se emplean para monitorear métricas en tiempo real, identificando cuellos de botella en aplicaciones legadas que corren en entornos no contenedorizados.

El proceso comienza con la contenedorización de aplicaciones usando Docker. Se definen Dockerfile para cada servicio, asegurando que las imágenes sean livianas y seguras, siguiendo las mejores prácticas del OCI (Open Container Initiative). Por ejemplo, se utiliza multi-stage builds para reducir el tamaño de las imágenes finales, minimizando vulnerabilidades asociadas a capas innecesarias.

Una vez contenedorizadas, se mapean las dependencias interservicios. En RUVDS, se considera la latencia de red entre regiones, configurando Virtual Private Clouds (VPCs) para aislar el tráfico. La evaluación de riesgos incluye la identificación de puntos de fallo únicos, como bases de datos monolíticas que deben migrarse a operadores como el PostgreSQL Operator para Kubernetes.

Configuración del Clúster Kubernetes en RUVDS

La implementación de un clúster en RUVDS implica la provisión de nodos maestros y workers mediante su panel de control o API. Se recomienda utilizar kubeadm para la inicialización en entornos no gestionados, ejecutando comandos como kubeadm init --pod-network-cidr=10.244.0.0/16 para configurar el plano de control. Esto genera un token de unión para los nodos workers, asegurando una configuración segura con certificados TLS.

Para la red, se integra Calico o Flannel como CNI (Container Network Interface), permitiendo políticas de red avanzadas como NetworkPolicies para segmentación de tráfico. En RUVDS, la integración con Load Balancers de OpenStack asegura que los servicios expuestos via Ingress controllers, como NGINX Ingress, manejen el tráfico externo de manera eficiente.

La persistencia de datos se aborda con StorageClasses dinámicas, utilizando volúmenes CSI (Container Storage Interface) compatibles con el backend de RUVDS. Por instancia, se configura un StorageClass para SSD de alta performance, definiendo parámetros como reclaimPolicy: Retain para evitar pérdidas de datos durante actualizaciones.

- Instalación de kubeadm y dependencias: Asegurar versiones compatibles de kubectl y kubelet.

- Configuración de etcd: Usar clústeres de tres nodos para alta disponibilidad, con backups automáticos via Velero.

- Seguridad inicial: Habilitar RBAC (Role-Based Access Control) y Pod Security Policies para restringir privilegios.

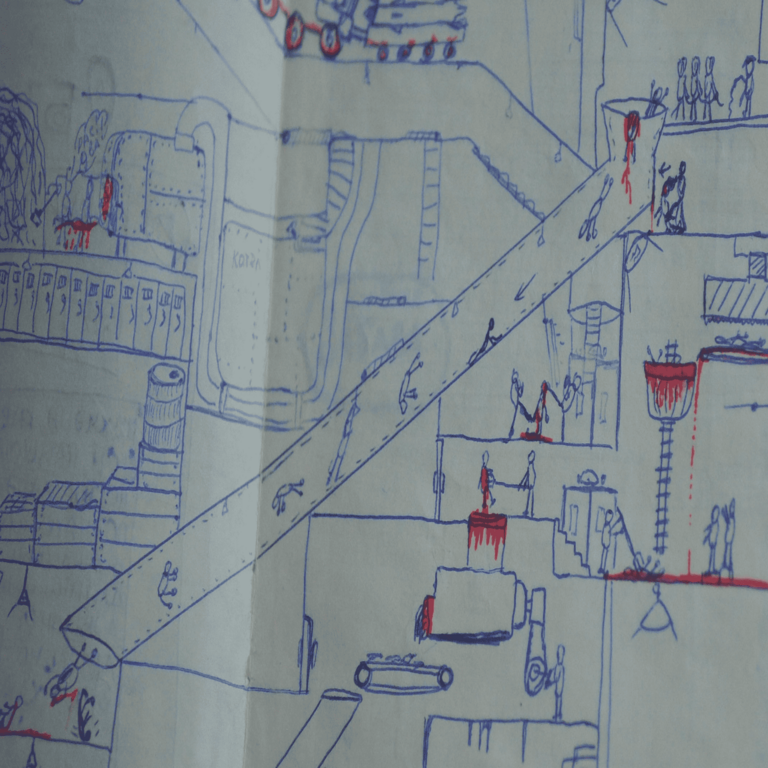

Estrategias de Migración: De Monolito a Microservicios

La migración propiamente dicha sigue un enfoque strangler pattern, donde se reemplazan gradualmente componentes monolíticos con microservicios en Kubernetes. En RUVDS, se inicia con servicios de bajo riesgo, como APIs frontales, desplegándolos como Deployments con réplicas mínimas de tres para redundancia.

Se utiliza Helm para el empaquetado de charts, facilitando despliegues idempotentes. Un chart típico incluye templates para ConfigMaps que inyectan variables de entorno sensibles desde Secrets encriptados con Vault. Para la migración de datos, herramientas como Kubectl apply con manifests YAML aseguran transiciones sin downtime, empleando blue-green deployments para alternar entre versiones.

En términos de CI/CD, se integra GitOps con ArgoCD o Flux, donde cambios en el repositorio Git propagan automáticamente al clúster. En RUVDS, pipelines en Jenkins o GitLab CI se configuran para build de imágenes en registries privados, escaneando vulnerabilidades con Trivy antes del push.

Optimización y Monitoreo Post-Migración

Una vez migrado, la optimización se centra en el tuning de recursos. Se implementa HPA basado en métricas personalizadas via Custom Metrics Adapter, escalando pods según carga de CPU o solicitudes HTTP. En RUVDS, el autoescalado de nodos se logra con Cluster Autoscaler, ajustando la capacidad del clúster dinámicamente.

El monitoreo exhaustivo utiliza el stack ELK (Elasticsearch, Logstash, Kibana) integrado con Fluentd para recolección de logs, y Prometheus para métricas. Alertas se configuran en Alertmanager para notificaciones via Slack o PagerDuty, detectando anomalías como picos de latencia o fallos en liveness probes.

La seguridad se refuerza con herramientas como Falco para runtime security, monitoreando comportamientos sospechosos en contenedores, y OPA (Open Policy Agent) para políticas de admisión. En el contexto de ciberseguridad, se aplican scans regulares con Clair en el registry, cumpliendo estándares como NIST SP 800-53 para entornos cloud.

Desafíos Comunes y Soluciones en RUVDS

Durante la migración en RUVDS, un desafío frecuente es la compatibilidad con versiones legacy de aplicaciones. Soluciones incluyen wrappers sidecar para logging o proxying, como Istio para service mesh, que añade observabilidad sin modificar código fuente.

Otro reto es el costo operativo; se optimiza con node affinity y taints para asignar workloads específicos a nodos de bajo costo. En RUVDS, el uso de spot instances para workloads no críticas reduce gastos hasta un 70%, según benchmarks internos.

La gestión de secretos se resuelve con external secrets operators, sincronizando desde AWS Secrets Manager o equivalentes en RUVDS, evitando exposición en etcd.

| Desafío | Solución Técnica | Beneficio |

|---|---|---|

| Latencia de red en clúster distribuido | Implementación de service mesh con Istio | Mejora en trazabilidad y routing inteligente |

| Escalado manual de recursos | Cluster Autoscaler y HPA | Reducción de overprovisioning en 40% |

| Gestión de logs dispersos | Centralización con EFK stack | Análisis unificado y debugging acelerado |

Integración con Tecnologías Emergentes: IA y Blockchain

En un enfoque avanzado, Kubernetes en RUVDS se integra con IA para predicción de fallos mediante modelos de machine learning en Kubeflow. Esto permite forecasting de demanda de recursos, optimizando asignaciones basadas en patrones históricos.

Para blockchain, se despliegan nodos de validación en pods, utilizando operators como Chainlink para oráculos descentralizados. Esto habilita aplicaciones híbridas donde la inmutabilidad de blockchain se combina con la escalabilidad de Kubernetes, ideal para DeFi o supply chain en la nube.

Lecciones Aprendidas y Mejores Prácticas

De la experiencia en RUVDS, se destaca la importancia de pruebas exhaustivas en entornos staging que replican producción. Se recomienda chaos engineering con herramientas como Litmus para simular fallos, fortaleciendo la resiliencia.

Mejores prácticas incluyen la adopción de GitOps para trazabilidad, auditorías regulares de RBAC y actualizaciones rolling para minimizar downtime. En ciberseguridad, el zero-trust model se implementa con mTLS en service mesh, reduciendo la superficie de ataque.

Implicaciones Operativas y Regulatorias

Operativamente, la migración reduce tiempos de despliegue de días a minutos, incrementando la velocidad de iteración. Sin embargo, requiere upskilling en Kubernetes, con certificaciones como CKA (Certified Kubernetes Administrator) recomendadas para equipos.

Regulatoriamente, en regiones como la UE con GDPR o en Rusia con leyes de datos soberanos, Kubernetes facilita compliance mediante políticas de retención de logs y encriptación en reposo. En RUVDS, la infraestructura on-premise-like asegura control sobre datos sensibles.

En resumen, la migración a Kubernetes en RUVDS representa un paso estratégico hacia infraestructuras modernas, equilibrando escalabilidad, seguridad y eficiencia. Para más información, visita la fuente original.