Cómo entrenar un modelo de inteligencia artificial para detectar deepfakes en videos: Una guía técnica integral

Introducción a los deepfakes y su relevancia en ciberseguridad

Los deepfakes representan una de las amenazas más avanzadas en el panorama de la ciberseguridad contemporánea. Estos contenidos multimedia falsos, generados mediante técnicas de aprendizaje profundo, consisten en videos o audios manipulados que sustituyen el rostro o la voz de una persona por otra de manera hiperrealista. Su proliferación ha generado preocupaciones significativas en ámbitos como la desinformación política, el fraude financiero y la violación de la privacidad. En este contexto, el desarrollo de modelos de inteligencia artificial (IA) capaces de detectar deepfakes se ha convertido en una prioridad técnica y operativa para profesionales de la ciberseguridad.

Desde un punto de vista técnico, los deepfakes se basan en redes generativas antagónicas (GAN, por sus siglas en inglés: Generative Adversarial Networks), un marco introducido por Ian Goodfellow en 2014. Estas redes consisten en dos componentes principales: un generador que crea datos sintéticos y un discriminador que evalúa su autenticidad. La interacción adversarial entre ambos permite producir manipulaciones indistinguibles de contenidos reales. Sin embargo, esta misma dinámica adversarial abre la puerta a contramedidas basadas en IA, donde modelos de detección aprenden a identificar anomalías en patrones visuales, temporales y espectrales que delatan la falsificación.

En términos de implicaciones operativas, la detección de deepfakes no solo mitiga riesgos inmediatos, como el uso en campañas de ingeniería social, sino que también fortalece marcos regulatorios como el Reglamento General de Protección de Datos (RGPD) en Europa o la Ley de Inteligencia Artificial de la Unión Europea, que exigen herramientas para verificar la autenticidad de contenidos digitales. Los beneficios incluyen una mayor resiliencia en sistemas de verificación biométrica y la prevención de daños reputacionales en entornos corporativos. No obstante, los riesgos persisten: los modelos de detección pueden ser vulnerables a ataques adversarios que los engañen, destacando la necesidad de enfoques robustos y actualizados.

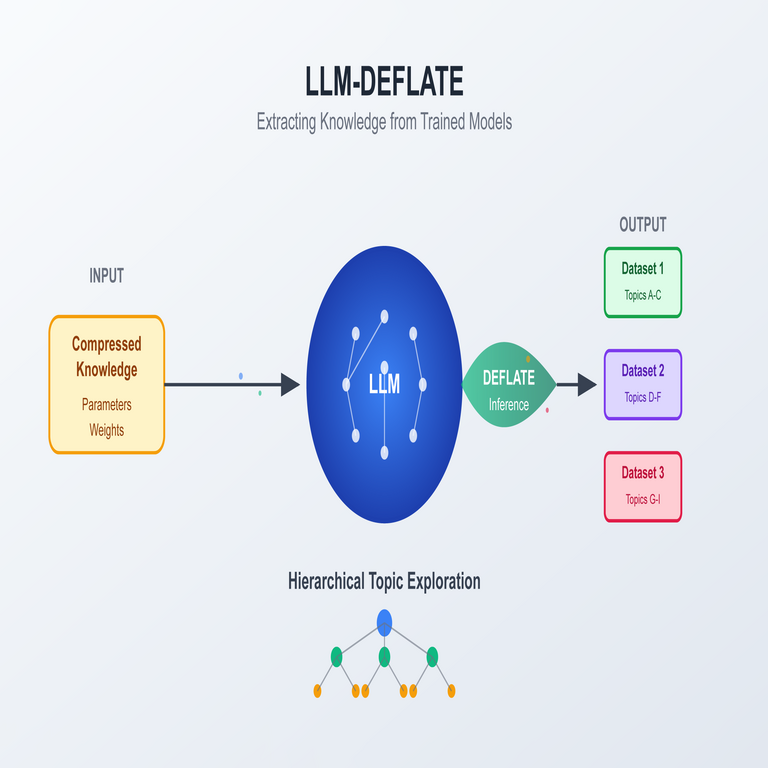

Fundamentos teóricos de la detección de deepfakes mediante IA

La detección de deepfakes se ancla en principios de visión por computadora y aprendizaje automático supervisado o no supervisado. En el aprendizaje supervisado, se utilizan datasets etiquetados que distinguen entre videos reales y falsos, permitiendo al modelo aprender características discriminativas. Datasets clave incluyen FaceForensics++, que comprende más de 1.000 videos manipulados con técnicas como DeepFaceLab y FaceSwap, y Celeb-DF, enfocado en celebridades para simular escenarios de alto impacto.

Desde la perspectiva de las arquitecturas neuronales, las redes convolucionales (CNN) son fundamentales. Una CNN típica para detección de deepfakes procesa frames de video extrayendo características de bajo nivel (bordes, texturas) en capas iniciales y de alto nivel (expresiones faciales, inconsistencias de iluminación) en capas superiores. Extensiones como las redes convolucionales 3D (C3D) incorporan la dimensión temporal, analizando secuencias de frames para detectar artefactos en el movimiento, como parpadeos irregulares o sincronización labial defectuosa, comunes en deepfakes de baja calidad.

Adicionalmente, técnicas de aprendizaje profundo avanzado, como las transformadas de Fourier para análisis espectral, revelan inconsistencias en el dominio de la frecuencia que los generadores de deepfakes no replican perfectamente. Por ejemplo, los deepfakes a menudo exhiben ruido de alta frecuencia en las regiones faciales manipuladas, detectable mediante filtros pasa-altos. En el ámbito de la blockchain, aunque no directamente aplicada aquí, se explora la integración de hashes criptográficos para verificar la inmutabilidad de videos originales, complementando la detección IA.

Los estándares relevantes incluyen el ISO/IEC 30107 para biometría y detección de presentaciones, que establece métricas como la tasa de falsos positivos (FPR) y la tasa de falsos negativos (FNR). Un modelo efectivo debe lograr un AUC-ROC (Área Bajo la Curva de Características Operativas del Receptor) superior a 0.95 en benchmarks estándar, asegurando precisión en entornos reales con variabilidad en iluminación, ángulos y resoluciones.

Preparación de datos y preprocesamiento para el entrenamiento

El éxito de un modelo de detección depende en gran medida de la calidad y diversidad del dataset de entrenamiento. El preprocesamiento inicia con la extracción de frames de videos utilizando bibliotecas como OpenCV en Python, que permite decodificar flujos de video en secuencias de imágenes a una tasa de 30 FPS (fotogramas por segundo). Posteriormente, se aplica detección facial con algoritmos como MTCNN (Multi-task Cascaded Convolutional Networks) o DLib, que localizan y recortan regiones de interés (ROI) para enfocarse en el rostro, reduciendo el ruido computacional.

Una lista de pasos clave en el preprocesamiento incluye:

- Alineación facial: Normalizar la orientación del rostro mediante landmarks (puntos clave) para alinear ojos, nariz y boca, utilizando transformadas afines que minimizan variaciones geométricas.

- Normalización de intensidad: Aplicar histograma de ecualización o CLAHE (Contrast Limited Adaptive Histogram Equalization) para estandarizar la iluminación, crucial en videos con condiciones variables.

- Aumento de datos: Generar variaciones sintéticas mediante rotaciones, escalados y adiciones de ruido gaussiano, incrementando la robustez del modelo contra overfitting. Herramientas como Albumentations facilitan este proceso.

- Extracción de características temporales: Computar flujos ópticos entre frames consecutivos con el algoritmo de Farneback, capturando movimientos sutiles que los deepfakes fallan en simular coherentemente.

En cuanto a datasets, FF++ ofrece cuatro subconjuntos basados en métodos de falsificación (Deepfakes, Face2Face, FaceSwap, NeuralTextures), con compresión a diferentes calidades (C23, C40) para simular escenarios web reales. Para equilibrar clases, se emplea sobremuestreo de muestras minoritarias o undersampling, manteniendo una proporción 1:1 entre reales y falsos. La división típica es 80% entrenamiento, 10% validación y 10% prueba, asegurando generalización.

Implicaciones operativas incluyen el manejo de sesgos: datasets dominados por rostros caucásicos pueden fallar en detecciones multiculturales, por lo que se recomienda diversificar con fuentes como FFHQ (Flickr-Faces-HQ) o datasets africanos específicos. En ciberseguridad, el preprocesamiento debe considerar privacidad, anonimizando datos sensibles conforme a estándares como GDPR mediante técnicas de borrado diferencial.

Arquitecturas de modelos recomendadas para detección

Entre las arquitecturas más efectivas, XceptionNet destaca por su uso en el benchmark FaceForensics++. Esta red, una variante de Inception, emplea separables convoluciones profundas que reducen parámetros computacionales mientras mantienen precisión. En un flujo típico, los frames preprocesados se alimentan a Xception, cuya salida se pasa por capas densas con activación ReLU y dropout (tasa 0.5) para regularización, culminando en una capa sigmoide para clasificación binaria (real/falso).

Para incorporar temporalidad, se integra LSTM (Long Short-Term Memory) o GRU (Gated Recurrent Units) sobre extracciones de CNN. Por ejemplo, un modelo híbrido CNN-LSTM procesa secuencias de 16 frames, donde la CNN extrae features por frame y la LSTM modela dependencias secuenciales, detectando inconsistencias en transiciones como el cierre de ojos. La función de pérdida comúnmente usada es la entropía cruzada binaria, optimizada con Adam (learning rate inicial 1e-4) y un scheduler de decaimiento exponencial.

Otras opciones avanzadas incluyen MesoNet, una red ligera diseñada específicamente para deepfakes, que opera en resoluciones bajas (256×256) para eficiencia en dispositivos edge. Su arquitectura de cuatro capas convolucionales con pooling máximo enfoca en mesenquimales (tejidos intermedios) faciales, donde las falsificaciones dejan huellas. En términos de rendimiento, MesoNet logra un 98% de precisión en datasets controlados, pero cae al 85% en videos comprimidos, subrayando la necesidad de fine-tuning.

En el contexto de tecnologías emergentes, la integración de transformers de visión (ViT) ofrece promesas. Modelos como DETR (DEtection TRansformer) adaptados para detección de anomalías procesan secuencias enteras como tokens, capturando relaciones globales que CNNs locales podrían omitir. Sin embargo, su alto costo computacional (requiriendo GPUs como NVIDIA A100) limita su uso en entornos de bajo recurso, donde se prefiere quantización post-entrenamiento para reducir precisión a 8 bits.

Mejores prácticas incluyen ensemble learning: combinar predicciones de múltiples modelos (e.g., Xception + MesoNet) mediante votación mayoritaria o promediado de logits, elevando la precisión en un 5-10%. En ciberseguridad, estos modelos se despliegan en pipelines con verificación multifactor, como análisis forense complementario con herramientas como Amped Authenticate.

Proceso de entrenamiento y optimización del modelo

El entrenamiento inicia con la inicialización de pesos, preferentemente desde checkpoints pre-entrenados en ImageNet para transfer learning, acelerando convergencia. En frameworks como TensorFlow o PyTorch, se configura un DataLoader con batch size de 32, shuffle activado y workers paralelos para eficiencia. El entrenamiento se realiza en epochs de 50-100, monitoreando métricas como accuracy, precision, recall y F1-score en el set de validación.

Para mitigar overfitting, se aplican técnicas de regularización: L2 (peso 1e-4) en pesos, early stopping basado en paciencia de 10 epochs sin mejora, y validación cruzada k-fold (k=5) para robustez estadística. En hardware, se recomienda entornos con al menos 16 GB de VRAM; para escalabilidad, distributed training con Horovod o PyTorch DDP permite paralelismo en clústers multi-GPU.

La optimización adversarial es crucial: exponer el modelo a muestras perturbadas con Projected Gradient Descent (PGD) genera robustez contra ataques que alteran píxeles imperceptiblemente. Por instancia, un ataque FGSM (Fast Gradient Sign Method) con epsilon 0.01 simula deepfakes mejorados, forzando al detector a aprender features invariantes.

En evaluación, se utilizan curvas PR (Precision-Recall) para datasets desbalanceados, priorizando recall en escenarios de ciberseguridad donde falsos negativos (deepfakes no detectados) son costosos. Benchmarks como DFDC (DeepFake Detection Challenge) de Facebook proveen métricas estandarizadas, donde modelos top logran EER (Equal Error Rate) por debajo del 5%.

Implicaciones regulatorias incluyen auditorías de modelos bajo frameworks como NIST AI RMF (Risk Management Framework), asegurando transparencia en decisiones. Beneficios operativos abarcan integración en plataformas como Microsoft Video Authenticator, que combina IA con metadatos EXIF para verificación holística.

Despliegue y aplicaciones prácticas en ciberseguridad

Una vez entrenado, el modelo se despliega en entornos productivos mediante contenedores Docker y orquestación con Kubernetes para escalabilidad. APIs RESTful en Flask o FastAPI permiten integración en sistemas existentes, procesando videos en tiempo real con latencia inferior a 500 ms por frame. Para edge computing, se optimiza con TensorRT de NVIDIA, reduciendo inferencia en un 70% en dispositivos IoT.

En ciberseguridad, aplicaciones incluyen monitoreo de redes sociales para detectar campañas de desinformación, utilizando el modelo en pipelines con scraping ético y análisis de sentimiento. En banca, verifica identidades en videollamadas KYC (Know Your Customer), previniendo fraudes de suplantación. Herramientas como Hive Moderation integran detectores similares para moderación de contenido en plataformas.

Riesgos incluyen evasión mediante GANs adversarias que entrenan contra el detector específico, requiriendo actualizaciones continuas (re-entrenamiento semanal con datos frescos). Beneficios en blockchain surgen al combinar detección con NFTs verificados, asegurando autenticidad en mercados digitales.

Estándares como ISO 27001 guían el despliegue seguro, con encriptación de modelos (usando TensorFlow Privacy) y logging de inferencias para trazabilidad. En noticias IT, iniciativas como el Deepfake Task Force de la ONU promueven colaboración global para datasets compartidos.

Desafíos actuales y direcciones futuras en detección de deepfakes

A pesar de avances, desafíos persisten: la generalización a nuevos métodos de falsificación, como StyleGAN3, que produce deepfakes de mayor fidelidad temporal. Modelos zero-shot, basados en few-shot learning con Meta-Learning (e.g., MAML), emergen para adaptarse sin re-entrenamiento extenso.

Otro reto es la computabilidad: procesar videos HD en 4K demanda optimizaciones como sparse convolutions. En ciberseguridad, la integración con quantum computing se explora para cracking de encriptaciones en metadatos, aunque aún incipiente.

Direcciones futuras incluyen multimodalidad: combinar video con audio usando wav2vec para detectar desincronizaciones voz-labio. La federación de aprendizaje permite entrenar colaborativamente sin compartir datos, preservando privacidad en consorcios empresariales.

En resumen, entrenar modelos de IA para detectar deepfakes exige un enfoque riguroso que equilibre precisión técnica con consideraciones éticas y operativas. Esta capacidad no solo contrarresta amenazas emergentes sino que fortalece la integridad digital en un ecosistema interconectado. Para más información, visita la fuente original.