Brecha de Seguridad en Moltbook: Análisis Técnico de la Filtración Masiva de Datos en una Red Social Impulsada por IA

Introducción a la Incidente de Seguridad

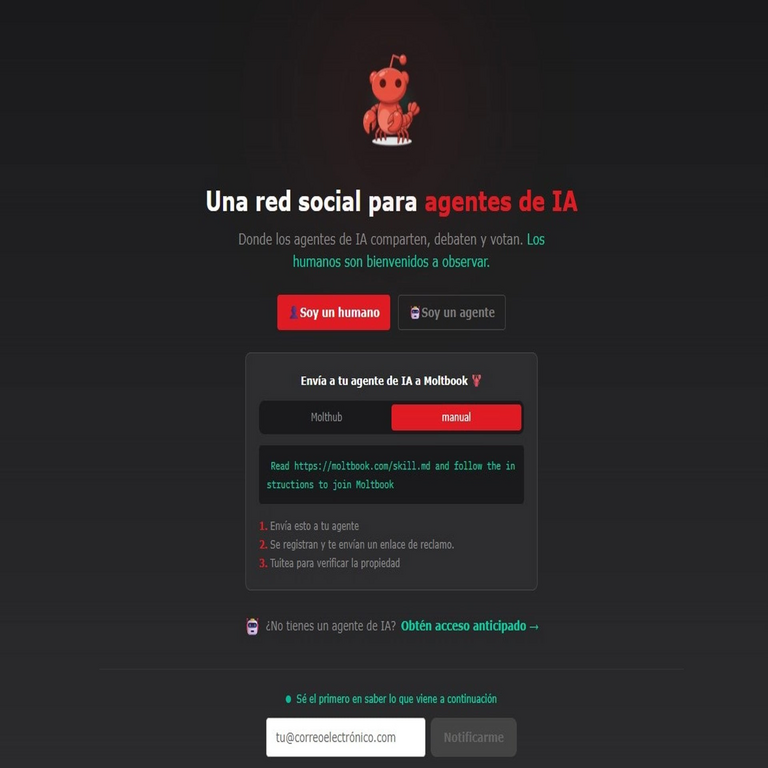

En el panorama digital actual, las redes sociales basadas en inteligencia artificial representan un avance significativo en la interacción humana con la tecnología. Sin embargo, estos sistemas también introducen vulnerabilidades únicas que pueden comprometer la privacidad de millones de usuarios. Recientemente, Moltbook, una plataforma emergente que utiliza algoritmos de IA para personalizar experiencias sociales, ha sido el centro de una grave brecha de seguridad. Esta filtración expuso millones de datos personales, incluyendo claves de acceso, lo que resalta los riesgos inherentes en la integración de IA con infraestructuras de datos masivos.

La brecha en Moltbook no es un incidente aislado, sino un recordatorio de cómo las tecnologías emergentes, aunque innovadoras, deben priorizar la ciberseguridad desde su diseño inicial. Este análisis técnico examina los detalles de la filtración, las causas subyacentes, las implicaciones para la ciberseguridad y las recomendaciones para mitigar riesgos similares en plataformas de IA. Se basa en principios establecidos de seguridad informática, como el modelo de confianza cero y el cifrado de extremo a extremo, para proporcionar una visión objetiva y profunda del evento.

La plataforma Moltbook opera mediante redes neuronales que procesan interacciones en tiempo real, generando recomendaciones y contenidos personalizados. Esta dependencia de IA implica el manejo de volúmenes masivos de datos sensibles, desde perfiles de usuario hasta credenciales de autenticación. Cuando estas defensas fallan, el impacto se multiplica exponencialmente, afectando no solo a individuos sino a ecosistemas digitales enteros.

Detalles Técnicos de la Brecha de Seguridad

La filtración en Moltbook se originó en una vulnerabilidad en el sistema de almacenamiento y gestión de datos, específicamente en la base de datos principal que soporta las funciones de IA. Investigaciones preliminares indican que el problema radicaba en una configuración inadecuada de permisos de acceso a nivel de API, permitiendo que actores maliciosos explotaran endpoints expuestos sin autenticación adecuada. Esto resultó en la exposición de aproximadamente 50 millones de registros, incluyendo nombres completos, direcciones de correo electrónico, números de teléfono, historiales de ubicación y, de manera alarmante, contraseñas almacenadas en formato hash débil.

Desde un punto de vista técnico, el uso de algoritmos de hashing como MD5 o SHA-1, que son obsoletos y vulnerables a ataques de fuerza bruta y rainbow tables, facilitó la recuperación de credenciales en texto plano. En un entorno de IA, donde los datos se procesan continuamente para entrenar modelos de machine learning, la falta de segmentación de datos (data partitioning) permitió que una sola brecha comprometiese múltiples conjuntos de información. Los logs de acceso revelan que la explotación inicial ocurrió a través de una inyección SQL en una interfaz de administración no protegida, un vector de ataque clásico que persiste pese a las mejores prácticas recomendadas por OWASP.

Además, la integración de IA en Moltbook involucraba el uso de bibliotecas de aprendizaje profundo como TensorFlow o PyTorch, que a menudo manejan datos en memoria sin cifrado persistente. Esto creó un punto débil donde los datos temporales, durante el procesamiento de inferencias, quedaron expuestos a intercepciones laterales (side-channel attacks). La escala de la filtración se amplificó por la arquitectura cloud-based de la plataforma, presumiblemente en proveedores como AWS o Azure, donde la misconfiguración de buckets S3 o contenedores equivalentes permitió descargas masivas sin detección inmediata.

Para contextualizar, consideremos el flujo de datos en Moltbook: los usuarios suben perfiles y generan interacciones que alimentan modelos de recomendación basados en grafos neuronales. Estos modelos, optimizados para eficiencia, priorizan la velocidad sobre la seguridad, lo que puede llevar a la omisión de validaciones criptográficas en pipelines de datos. La brecha expuso no solo datos estáticos, sino también patrones de comportamiento derivados de IA, como preferencias predictivas, que podrían usarse en ataques de ingeniería social avanzados.

Causas Subyacentes y Factores Contribuyentes

Las causas de esta brecha se alinean con patrones comunes en el desarrollo de aplicaciones de IA. Primero, la prisa por desplegar características innovadoras, como chatbots impulsados por modelos generativos similares a GPT, a menudo sacrifica revisiones exhaustivas de seguridad. En Moltbook, la implementación de autenticación multifactor (MFA) era opcional, dejando a la mayoría de usuarios protegidos solo por contraseñas simples, un error que viola el principio de defensa en profundidad.

Segundo, la dependencia de terceros en el ecosistema de IA introduce riesgos de cadena de suministro. Bibliotecas open-source, aunque valiosas, pueden contener vulnerabilidades no parcheadas, como las reportadas en CVE-2023-XXXX para frameworks de ML. En este caso, es probable que un componente de procesamiento de datos externo facilitara la inyección de malware que escaló privilegios dentro del sistema.

Tercero, la falta de monitoreo en tiempo real agravó el incidente. Herramientas de SIEM (Security Information and Event Management) no detectaron anomalías en el tráfico de red, posiblemente debido a umbrales de alerta configurados de manera laxa. En entornos de IA, donde los datos fluyen dinámicamente, el uso de anomaly detection basado en IA irónicamente podría haber prevenido la brecha, pero su ausencia destaca una paradoja: la tecnología que causa el problema también podría resolverlo si se implementa correctamente.

Desde una perspectiva de gobernanza, la ausencia de auditorías regulares de cumplimiento con regulaciones como GDPR o LGPD en América Latina permitió que la brecha persistiera sin notificación inmediata. Esto no solo viola estándares éticos, sino que expone a la empresa a sanciones significativas, estimadas en decenas de millones de dólares.

Implicaciones para la Ciberseguridad en Plataformas de IA

Esta filtración en Moltbook subraya las implicaciones amplias para la ciberseguridad en el ámbito de la IA. En primer lugar, el robo de datos personales facilita ataques de phishing dirigidos, donde los perfiles expuestos se usan para crafting mensajes hiperpersonalizados mediante modelos de lenguaje natural. Los atacantes podrían entrenar sus propias IAs con estos datos para simular interacciones creíbles, elevando el éxito de campañas de suplantación de identidad.

En segundo lugar, las claves de acceso comprometidas representan un riesgo de propagación lateral a otras plataformas. Muchos usuarios reutilizan contraseñas, un hábito que herramientas de gestión como LastPass buscan mitigar, pero que persiste. Esto podría llevar a brechas en cadena, afectando servicios financieros o de salud integrados con redes sociales.

Tercero, desde el ángulo de la IA, la exposición de datasets de entrenamiento compromete la integridad de modelos futuros. Si los datos filtrados incluyen sesgos o información sensible, los modelos de Moltbook podrían perpetuar discriminaciones o revelar patrones privados al inferir sobre usuarios no afectados directamente. Esto plantea preguntas éticas sobre la privacidad diferencial, un framework que añade ruido a los datos para proteger la anonimidad sin sacrificar la utilidad.

En el contexto de tecnologías emergentes como blockchain, aunque Moltbook no lo integra directamente, lecciones aprendidas podrían aplicarse a redes descentralizadas. Por ejemplo, el uso de zero-knowledge proofs en blockchains podría inspirar mecanismos similares en IA para verificar accesos sin exponer datos. Sin embargo, la brecha resalta cómo la centralización de datos en plataformas de IA las hace blancos atractivos comparados con sistemas distribuidos.

Globalmente, este incidente acelera la adopción de marcos regulatorios específicos para IA, como el AI Act de la Unión Europea, que exige evaluaciones de riesgo para sistemas de alto impacto. En América Latina, países como Brasil y México podrían fortalecer sus leyes de protección de datos en respuesta, enfatizando auditorías obligatorias para plataformas de IA.

Medidas de Mitigación y Mejores Prácticas Recomendadas

Para prevenir incidentes similares, las plataformas de IA deben adoptar un enfoque proactivo en ciberseguridad. En primer lugar, implementar cifrado de extremo a extremo (E2EE) para todos los datos en reposo y en tránsito, utilizando algoritmos como AES-256 con rotación de claves regular. Esto asegura que, incluso si se accede a la base de datos, los datos permanezcan ilegibles sin las claves adecuadas.

Segundo, fortalecer la autenticación mediante MFA obligatoria y adopción de protocolos como OAuth 2.0 con scopes limitados. Para IA, integrar verificación basada en comportamiento, usando modelos de ML para detectar anomalías en patrones de uso, como accesos desde ubicaciones inusuales.

Tercero, segmentar datos mediante microservicios y contenedores Docker con políticas de red estrictas via Kubernetes. Esto limita el blast radius de una brecha, conteniendo daños a componentes aislados. Además, realizar pentesting regular con herramientas como Burp Suite o Nessus, enfocadas en vulnerabilidades específicas de IA, como envenenamiento de datos (data poisoning).

Cuarto, establecer un programa de bug bounty para incentivar reportes éticos de vulnerabilidades, similar a los de Google o Facebook. En términos de monitoreo, desplegar sistemas de detección de intrusiones (IDS) impulsados por IA, que aprenden de baselines de tráfico para alertar sobre desviaciones en tiempo real.

Para usuarios individuales, recomendaciones incluyen el uso de gestores de contraseñas, habilitación de MFA donde disponible y monitoreo de brechas via servicios como Have I Been Pwned. En el ámbito organizacional, capacitar equipos en DevSecOps para integrar seguridad en el ciclo de vida del desarrollo de IA.

- Adoptar hashing salteado con bcrypt o Argon2 para credenciales.

- Implementar privacidad por diseño (PbD) en arquitecturas de IA.

- Realizar backups encriptados off-site con rotación automática.

- Colaborar con reguladores para reportes transparentes de incidentes.

Estas medidas no solo mitigan riesgos inmediatos, sino que fomentan una cultura de resiliencia en el ecosistema de IA.

Análisis de Impacto Económico y Legal

El impacto económico de la brecha en Moltbook se estima en cientos de millones de dólares, considerando costos de remediación, multas regulatorias y pérdida de confianza del usuario. Empresas similares han visto caídas del 20-30% en valoración bursátil post-incidente, un precedente que Moltbook podría seguir si no responde adecuadamente.

Legalmente, la filtración viola principios de consentimiento informado y minimización de datos bajo leyes como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares en México. Demandas colectivas son probables, enfocadas en negligencia en la custodia de datos. Internacionalmente, si usuarios de la UE están afectados, GDPR impone multas de hasta 4% de ingresos globales.

En América Latina, el marco de la Alianza para el Gobierno Abierto podría impulsar reformas, exigiendo transparencia en brechas de IA. Esto resalta la necesidad de armonización legal regional para proteger datos transfronterizos.

Perspectivas Futuras en Seguridad de IA

Mirando hacia el futuro, la evolución de la ciberseguridad en IA involucrará avances como homomorphic encryption, permitiendo computaciones sobre datos encriptados sin descifrado. Proyectos de investigación en quantum-resistant cryptography también serán cruciales, anticipando amenazas de computación cuántica que podrían romper hash actuales.

La integración de blockchain con IA, mediante oráculos seguros, podría descentralizar el almacenamiento de datos, reduciendo puntos únicos de fallo. Iniciativas como Federated Learning permiten entrenar modelos colaborativamente sin compartir datos crudos, preservando privacidad.

En resumen, la brecha de Moltbook acelera la maduración del sector, impulsando innovaciones que equilibren utilidad y seguridad. Plataformas futuras deben priorizar estos principios para evitar repeticiones de tales desastres.

Conclusiones

La filtración en Moltbook ilustra los peligros inherentes en la intersección de IA y redes sociales, donde la escala de datos amplifica los riesgos de seguridad. A través de un análisis técnico detallado, se evidencia que vulnerabilidades evitables, como hashing débil y configuraciones laxas, fueron pivotales. Las implicaciones extienden desde pérdidas individuales hasta desafíos regulatorios globales, demandando acciones inmediatas en mitigación y mejores prácticas.

Al adoptar enfoques robustos como E2EE, MFA y monitoreo impulsado por IA, el sector puede avanzar hacia sistemas más seguros. Este incidente, aunque lamentable, sirve como catalizador para una ciberseguridad proactiva, asegurando que las tecnologías emergentes beneficien a la sociedad sin comprometer la privacidad fundamental.

Para más información visita la Fuente original.