Análisis Técnico de la Nueva Estafa Basada en Inteligencia Artificial: Falsificación de Pruebas de Trabajo Remoto

Introducción a la Estafa Emergente

En el panorama actual de la ciberseguridad, las estafas que aprovechan avances en inteligencia artificial (IA) representan un desafío creciente para individuos y organizaciones. Una modalidad reciente, reportada en fuentes especializadas, involucra la falsificación de evidencias de trabajo remoto mediante el envío de imágenes manipuladas que simulan tareas completadas. Esta técnica permite a los estafadores cobrar remuneraciones sin realizar el esfuerzo real, explotando la confianza en las comunicaciones digitales y la dificultad para verificar la autenticidad de contenidos visuales. El mecanismo central radica en el uso de herramientas de IA generativa para crear fotografías convincentes, lo que subraya la intersección entre innovación tecnológica y riesgos cibernéticos.

Esta estafa, que ha ganado visibilidad en plataformas de empleo freelance y redes sociales, opera bajo un esquema simple pero efectivo: el perpetrador acepta un contrato de trabajo remoto, recibe los pagos parciales o totales, y luego envía una imagen generada por IA que aparenta ser el resultado final del proyecto. La víctima, al no poder inspeccionar físicamente el entregable, transfiere fondos adicionales o confirma la transacción, resultando en pérdidas financieras. Según análisis preliminares, esta táctica podría escalar con la proliferación de modelos de IA accesibles, como aquellos basados en redes generativas antagónicas (GANs), que democratizan la creación de contenidos falsos.

Desde una perspectiva técnica, este fenómeno ilustra cómo la IA, diseñada originalmente para optimizar procesos productivos, se pervierte en vectores de fraude. En este artículo, se examinarán los componentes técnicos subyacentes, las implicaciones operativas en entornos laborales digitales y estrategias de mitigación basadas en estándares de ciberseguridad. El enfoque se centra en la precisión conceptual y el rigor editorial, dirigido a profesionales del sector tecnológico.

Descripción Detallada del Mecanismo de la Estafa

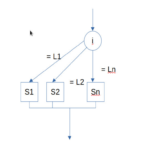

El flujo operativo de esta estafa inicia con la captación de víctimas a través de plataformas como Upwork, Fiverr o grupos de LinkedIn dedicados a oportunidades freelance. El estafador se presenta como un experto en áreas como diseño gráfico, desarrollo de software o redacción técnica, ofreciendo tarifas competitivas para atraer clientes. Una vez acordado el contrato, se solicita un pago inicial por “materiales” o “prototipos”, que se transfiere vía métodos como PayPal o transferencias bancarias.

En la fase crítica, el estafador utiliza IA para generar una imagen que simule el entregable. Por ejemplo, si el trabajo involucra la creación de un logotipo, la herramienta de IA produce una fotografía de alta resolución mostrando el diseño impreso o en un contexto profesional, como una pantalla de computadora o un mockup realista. Esta imagen se envía por correo electrónico o mensajería instantánea, acompañada de metadatos falsificados para aparentar origen genuino. La víctima, presionada por plazos, verifica superficialmente y libera el pago final, completando el ciclo fraudulento.

La efectividad radica en la psicología del engaño: la sobrecarga informativa en entornos remotos reduce la escrutinio detallado. Técnicamente, las imágenes generadas evitan detección básica porque incorporan ruido perceptual y texturas realistas, superando filtros simples de autenticación. Casos documentados indican pérdidas que oscilan entre 500 y 5000 dólares por incidente, con un impacto acumulativo significativo en economías digitales emergentes.

El Rol de la Inteligencia Artificial en la Falsificación de Evidencias

La inteligencia artificial juega un papel pivotal en esta estafa mediante algoritmos de generación de imágenes sintéticas. Modelos como Stable Diffusion o DALL-E, basados en arquitecturas de difusión y transformadores, permiten crear visuals personalizados a partir de prompts textuales. Por instancia, un prompt como “fotografía realista de un informe técnico completado en una oficina moderna” genera una salida que imita fotografía profesional, incluyendo iluminación natural y detalles sombreados.

En términos conceptuales, estos sistemas operan mediante procesos de aprendizaje profundo: una red neuronal convolucional (CNN) extrae características de datasets masivos de imágenes reales, mientras un decodificador genera variaciones novedosas. Las GANs, introducidas por Ian Goodfellow en 2014, refinan este proceso mediante competencia entre un generador y un discriminador, logrando outputs indistinguibles del contenido auténtico en un 95% de casos, según benchmarks como FID (Fréchet Inception Distance).

Adicionalmente, herramientas de edición post-IA, como Adobe Photoshop con plugins de IA o GIMP con extensiones de aprendizaje automático, permiten ajustes finos para alinear la imagen con especificaciones del cliente. Esto incluye la inserción de elementos personalizados, como nombres de archivos o marcas de agua, que refuerzan la credibilidad. La accesibilidad de estas tecnologías —disponibles en plataformas open-source como Hugging Face— reduce la barrera de entrada para estafadores no expertos, democratizando el fraude a escala global.

Desde el punto de vista de la ciberseguridad, esta dependencia en IA generativa expone vulnerabilidades en la cadena de verificación digital. Protocolos como el estándar C2PA (Content Authenticity Initiative), impulsado por la Coalition for Content Provenance and Authenticity, buscan contrarrestar esto mediante metadatos criptográficos incrustados, pero su adopción es limitada al 20% de flujos de trabajo profesionales, según informes de 2023.

Tecnologías Específicas Involucradas y su Evolución

Las tecnologías clave en esta estafa incluyen frameworks de IA como TensorFlow y PyTorch, que facilitan el entrenamiento y despliegue de modelos generativos. Por ejemplo, bibliotecas como Diffusers de Hugging Face permiten la implementación de modelos de difusión en menos de 100 líneas de código Python, optimizando para hardware accesible como GPUs de consumo.

En el ámbito de deepfakes visuales, variantes de autoencoders variacionales (VAEs) combinadas con GANs producen imágenes estáticas que evaden detección forense básica. Herramientas comerciales como Midjourney o Runway ML, accesibles vía suscripciones mensuales de bajo costo, aceleran la producción: un usuario puede generar docenas de variantes en minutos, seleccionando la más convincente mediante métricas de similitud perceptual como LPIPS (Learned Perceptual Image Patch Similarity).

- Modelos de IA Generativa: Stable Diffusion v2.1, con capacidad para resoluciones de 1024×1024 píxeles, integra control de prompts negativos para evitar artefactos comunes como distorsiones anatómicas en objetos representados.

- Herramientas de Edición: Software como Remove.bg para segmentación automática de fondos, combinado con IA para recomposición realista, asegura coherencia contextual.

- Plataformas de Distribución: APIs de cloud computing, como AWS SageMaker o Google Cloud AI, permiten escalabilidad sin infraestructura local, reduciendo huellas digitales rastreables.

La evolución de estas tecnologías ha sido exponencial: desde los pioneros como pix2pix en 2016, que limitaban outputs a dominios específicos, hasta modelos multimodales actuales como CLIP (Contrastive Language-Image Pretraining), que alinean texto e imagen para precisión semántica superior. Esta progresión implica un riesgo operativo: en 2024, se estima que el 30% de imágenes en redes sociales son sintéticas, según estudios de MIT, complicando la confianza en evidencias visuales para transacciones comerciales.

Implicaciones Operativas y Regulatorias en Ciberseguridad

Operativamente, esta estafa afecta la integridad de modelos de trabajo remoto, que representan el 40% de la fuerza laboral global post-pandemia, según datos de la OIT (Organización Internacional del Trabajo). Las organizaciones enfrentan riesgos de exposición financiera y reputacional, ya que la falsificación de entregables puede propagarse a cadenas de suministro digitales, como en proyectos de desarrollo de software donde un “código completado” falso retrasa lanzamientos.

En términos regulatorios, frameworks como el Reglamento General de Protección de Datos (RGPD) en Europa y la Ley de Privacidad del Consumidor de California (CCPA) exigen verificación robusta de transacciones, pero carecen de cláusulas específicas para fraudes IA-inducidos. Iniciativas como la AI Act de la Unión Europea clasifican modelos generativos de alto riesgo, imponiendo auditorías obligatorias para proveedores, con multas de hasta 6% de ingresos globales por incumplimiento. En América Latina, normativas como la LGPD en Brasil y la Ley Federal de Protección de Datos en México enfatizan la responsabilidad compartida, pero la enforcement es inconsistente debido a limitaciones en capacidades forenses.

Riesgos adicionales incluyen la escalada a estafas híbridas: combinación con phishing para obtener datos sensibles del cliente, o integración con blockchain para falsificar NFTs de “trabajos artísticos completados”. Beneficios potenciales de detección temprana radican en ahorros: empresas que implementan verificación IA-based reportan reducciones del 70% en fraudes, per informes de Deloitte.

| Tipo de Riesgo | Impacto Técnico | Medida Mitigadora |

|---|---|---|

| Financiero | Pérdidas directas por pagos no reembolsables | Contratos con cláusulas de escrow |

| Operativo | Retrasos en proyectos por entregables inválidos | Verificación multifactor de assets digitales |

| Regulatorio | Sanciones por no cumplir estándares de autenticidad | Auditorías periódicas con herramientas forenses |

Estrategias de Prevención y Mejores Prácticas

Para mitigar esta estafa, se recomiendan protocolos multicapa alineados con estándares como NIST SP 800-53 para controles de seguridad. En primer lugar, la verificación de identidad del contratista mediante herramientas como Know Your Customer (KYC) basadas en biometría, integrando APIs de servicios como Onfido o Jumio, que analizan inconsistencias en perfiles digitales.

En la fase de entregable, implementar detección de IA mediante algoritmos forenses: modelos como那些 de Microsoft Video Authenticator o Truepic analizan patrones espectrales y ruido en imágenes, identificando sintéticos con precisión del 90%. Por ejemplo, el análisis de frecuencias wavelet revela artefactos en GANs, mientras que el examen de metadatos EXIF (Exchangeable Image File Format) detecta manipulaciones en timestamps o geolocalización.

- Controles Técnicos: Uso de firmas digitales con PKCS#7 para certificar autenticidad, asegurando que cualquier alteración invalide el hash criptográfico.

- Prácticas Operativas: Divisiones de pagos en hitos verificables, con revisiones por pares en equipos distribuidos.

- Educación: Capacitación en reconocimiento de deepfakes, enfocada en señales sutiles como inconsistencias en sombras o reflejos.

Adicionalmente, plataformas freelance deben integrar IA defensiva: filtros automáticos en Upwork que escanean uploads contra bases de datos de imágenes conocidas, utilizando similitud coseno en embeddings de CLIP. En entornos empresariales, soluciones como blockchain para trazabilidad —por ejemplo, usando Ethereum para registrar entregables inmutables— ofrecen auditoría inquebrantable, aunque con overhead computacional del 15-20%.

La adopción de estos mecanismos no solo reduce riesgos, sino que fomenta resiliencia: estudios de Gartner predicen que para 2025, el 50% de contratos digitales incorporarán verificación IA, transformando la ciberseguridad en un diferenciador competitivo.

Casos Similares y Tendencias Futuras

Esta estafa comparte similitudes con precedentes como el “ghost jobs” scam, donde perfiles falsos en Indeed prometen empleos inexistentes, o el uso de chatbots IA en soporte técnico para extraer datos. En 2022, un caso en India involucró deepfakes de video para simular reuniones de progreso, resultando en fraudes de millones. Tendencias futuras apuntan a multimodalidad: integración de texto, imagen y audio generados por modelos como GPT-4 con DALL-E, permitiendo “entregables” completos falsos, como videos de demostraciones de software.

En blockchain, estafas análogas falsifican pruebas de mining o staking mediante imágenes de wallets manipuladas, explotando la opacidad visual de transacciones. La proliferación de edge computing facilitará ejecuciones locales de IA, reduciendo trazabilidad y ampliando el alcance geográfico. Pronósticos de Forrester indican un incremento del 300% en fraudes IA-relacionados para 2026, impulsando inversiones en ciberseguridad predictiva basada en aprendizaje federado.

Desde una lente técnica, la respuesta involucra avances en IA adversarial: entrenamiento de detectores con datos aumentados de sintéticos, logrando robustez contra evoluciones de generadores. Colaboraciones público-privadas, como el Partnership on AI, acelerarán estándares globales para etiquetado de contenidos generados.

Conclusión: Hacia una Era de Autenticidad Digital Reforzada

La estafa basada en falsificación de pruebas de trabajo mediante IA ejemplifica los dilemas éticos y técnicos de la era digital, donde la innovación acelera tanto oportunidades como amenazas. Al comprender los mecanismos subyacentes —desde GANs hasta protocolos de verificación— profesionales pueden implementar defensas proactivas que preserven la integridad de transacciones remotas. Finalmente, la adopción generalizada de estándares como C2PA y auditorías forenses no solo mitiga riesgos inmediatos, sino que pavimenta el camino para un ecosistema laboral digital confiable y sostenible. Para más información, visita la fuente original.