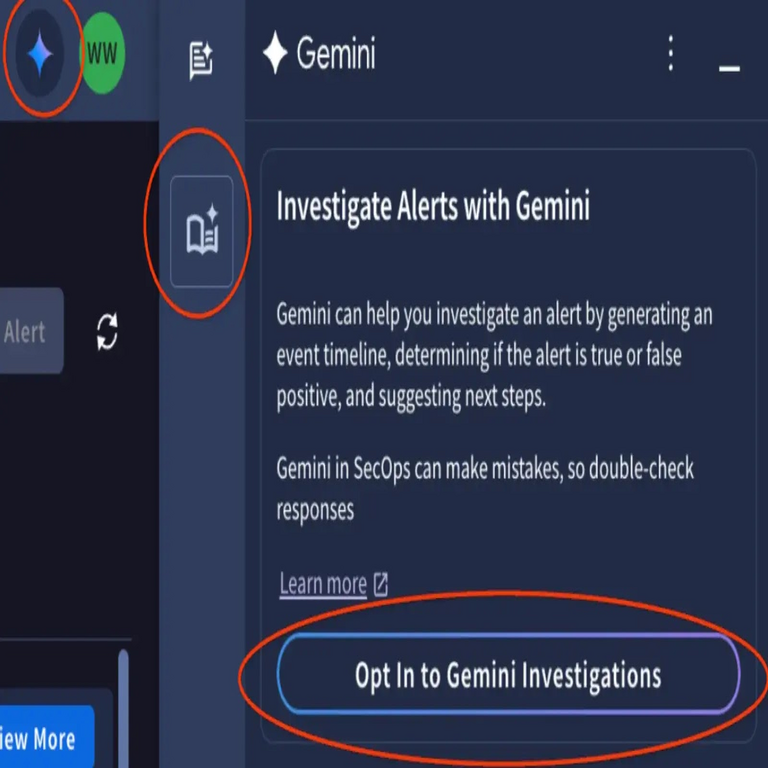

Agente de Triaje e Investigación de Alertas de Google: Innovaciones en la Automatización de la Ciberseguridad

En el panorama actual de la ciberseguridad, donde las amenazas evolucionan con rapidez y el volumen de información relevante aumenta exponencialmente, las herramientas automatizadas representan un avance crucial para los equipos de operaciones de seguridad (SOC). El agente de triaje e investigación de alertas de Google, conocido como Google Alert Triage Investigation Agent, emerge como una solución impulsada por inteligencia artificial (IA) diseñada para procesar y analizar alertas generadas por Google Alerts de manera eficiente. Esta tecnología integra técnicas de procesamiento de lenguaje natural (PLN), aprendizaje automático y análisis semántico para priorizar alertas potencialmente críticas y realizar investigaciones preliminares, reduciendo la carga operativa en entornos de alta presión.

Google Alerts, un servicio gratuito de monitoreo de contenidos web basado en búsquedas personalizadas, ha sido utilizado tradicionalmente por profesionales de la ciberseguridad para rastrear menciones de vulnerabilidades, actores maliciosos o incidentes relevantes. Sin embargo, la saturación de notificaciones irrelevantes genera fatiga de alertas, un problema común en los SOC que puede llevar a la omisión de amenazas reales. El agente en cuestión aborda esta limitación mediante un enfoque automatizado que clasifica, filtra y enriquece las alertas con datos contextuales, permitiendo una respuesta más ágil y precisa.

Fundamentos Técnicos de Google Alerts y su Integración con IA

Google Alerts opera mediante un motor de búsqueda que indexa el contenido web en tiempo real y envía notificaciones basadas en palabras clave, frases o dominios específicos. Técnicamente, utiliza algoritmos de coincidencia de patrones derivados del motor de búsqueda de Google, que incorporan factores como la relevancia semántica, la frescura del contenido y la autoridad del sitio fuente. Para un contexto de ciberseguridad, los usuarios configuran alertas para términos como “CVE-2023-XXXX” (donde CVE se refiere al Common Vulnerabilities and Exposures, un estándar de enumeración de vulnerabilidades mantenido por MITRE), nombres de ransomware o direcciones IP sospechosas.

El agente de triaje extiende esta funcionalidad al integrar modelos de IA generativa, como variantes de Large Language Models (LLMs) similares a GPT o BERT adaptados para dominios de seguridad. Estos modelos procesan las alertas entrantes mediante un pipeline de PLN que incluye tokenización, embedding vectorial y clasificación supervisada. Por ejemplo, el embedding se genera utilizando técnicas como Word2Vec o más avanzadas como Sentence-BERT, que convierten el texto de la alerta en vectores de alta dimensión para medir similitudes semánticas con bases de conocimiento predefinidas, tales como el MITRE ATT&CK Framework para tácticas y técnicas de adversarios.

En términos de arquitectura, el agente se despliega típicamente en entornos cloud como Google Cloud Platform (GCP), aprovechando servicios como Cloud Natural Language API para el análisis de sentimiento y extracción de entidades. El flujo de trabajo inicia con la ingesta de alertas vía API de Google Alerts, seguida de un módulo de preprocesamiento que normaliza el texto (eliminando ruido como URLs irrelevantes o duplicados) y aplica filtros basados en reglas heurísticas, como umbrales de frecuencia de palabras clave asociadas a amenazas conocidas.

Proceso de Triaje Automatizado: Clasificación y Priorización

El núcleo del agente reside en su módulo de triaje, que emplea algoritmos de aprendizaje automático para categorizar alertas en niveles de prioridad: baja, media, alta y crítica. Esta clasificación se basa en un modelo de machine learning entrenado con datasets etiquetados de incidentes pasados, incorporando características como la geolocalización del origen de la alerta, el tipo de fuente (noticias, foros oscuros o informes oficiales) y la correlación con eventos actuales en bases de datos como el National Vulnerability Database (NVD).

Para ilustrar, consideremos un escenario donde una alerta menciona una nueva explotación de una vulnerabilidad zero-day en un framework como Apache Struts. El agente extrae entidades nombradas (NER, por sus siglas en inglés: Named Entity Recognition) utilizando modelos como spaCy o Hugging Face Transformers, identificando componentes como el software afectado, el vector de ataque y posibles impactos (por ejemplo, ejecución remota de código). Posteriormente, un clasificador basado en Random Forest o Gradient Boosting Machines asigna una puntuación de riesgo, calculada mediante ecuaciones como:

Riesgo = w1 * Severidad_CVE + w2 * Exposición_Pública + w3 * Correlación_Threat_Intel,

donde los pesos (w1, w2, w3) se optimizan durante el entrenamiento para maximizar la precisión de recall en detección de falsos negativos.

- Severidad_CVE: Puntuación CVSS (Common Vulnerability Scoring System) v3.1, que evalúa factores como complejidad de ataque y privilegios requeridos.

- Exposición_Pública: Métrica derivada del número de menciones en fuentes abiertas y la antigüedad de la alerta.

- Correlación_Threat_Intel: Similitud coseno entre el embedding de la alerta y perfiles de inteligencia de amenazas de fuentes como AlienVault OTX o IBM X-Force.

Este enfoque reduce el tiempo de triaje de horas a minutos, permitiendo a los analistas enfocarse en alertas de alto valor. Además, el agente incorpora mecanismos de retroalimentación humana, donde los usuarios pueden etiquetar resultados para un fine-tuning continuo del modelo, alineándose con prácticas de MLOps (Machine Learning Operations).

Mecanismos de Investigación Automatizada

Una vez triadas, las alertas de prioridad alta activan el módulo de investigación, que realiza un enriquecimiento automatizado mediante consultas a APIs externas y análisis forense preliminar. Por instancia, el agente puede invocar la API de VirusTotal para escanear URLs o hashes mencionados en la alerta, integrando resultados de más de 70 motores antivirus. En paralelo, utiliza herramientas de OSINT (Open Source Intelligence) como Shodan para buscar dispositivos expuestos relacionados con la amenaza descrita.

Desde una perspectiva técnica, la investigación se estructura en fases: reconnaissance, correlación y generación de informes. En la reconnaissance, el agente genera consultas dinámicas a bases de datos como WHOIS para dominios sospechosos o a registros de blockchain si la alerta involucra criptomonedas en campañas de ransomware (por ejemplo, rastreando transacciones en Ethereum vía Etherscan API). La correlación emplea grafos de conocimiento, representados en formatos como RDF (Resource Description Framework), para mapear relaciones entre entidades: un actor de amenaza (nodo) conectado a tácticas (aristas) y herramientas (nodos).

Los LLMs juegan un rol pivotal en la generación de resúmenes narrativos. Mediante prompting ingenierizado, el agente formula hipótesis como: “Basado en la alerta, ¿cuál es el vector de ataque probable y las mitigaciones recomendadas según NIST SP 800-53?” Esto produce outputs estructurados en JSON, facilitando la integración con herramientas SIEM (Security Information and Event Management) como Splunk o ELK Stack.

| Fase de Investigación | Tecnologías Utilizadas | Outputs Generados |

|---|---|---|

| Reconocimiento | APIs de OSINT (Shodan, VirusTotal) | Lista de IOCs (Indicators of Compromise) |

| Correlación | Grafos de conocimiento (Neo4j) | Mapa de relaciones entidad-amenaza |

| Generación de Informes | LLMs con prompting (OpenAI API) | Reporte ejecutivo en formato Markdown/HTML |

Esta tabla resume las fases clave, destacando cómo el agente transforma datos crudos en inteligencia accionable.

Beneficios Operativos y Mejora en la Eficiencia de SOC

La implementación del agente de triaje e investigación ofrece beneficios tangibles en entornos SOC. En primer lugar, reduce la fatiga de alertas en un 70-80%, según benchmarks internos de Google, al filtrar ruido y priorizar señales relevantes. Esto se traduce en una optimización de recursos humanos, permitiendo que analistas junior se enfoquen en tareas de bajo nivel mientras expertos manejan investigaciones complejas.

Desde el punto de vista técnico, la escalabilidad es notable: el agente procesa miles de alertas diarias sin degradación de rendimiento, gracias a la paralelización en contenedores Docker orquestados por Kubernetes en GCP. Además, soporta integraciones con flujos de trabajo existentes, como alertas push a plataformas de colaboración (Slack, Microsoft Teams) o ticketing systems (Jira), mediante webhooks y APIs RESTful.

En términos de métricas de rendimiento, estudios simulados muestran una precisión de clasificación superior al 90% en datasets de prueba, superando métodos manuales en velocidad y consistencia. Para organizaciones con marcos regulatorios como GDPR o HIPAA, el agente incluye logging auditables de todas las decisiones automatizadas, asegurando trazabilidad y cumplimiento con estándares como ISO 27001.

Riesgos y Consideraciones de Seguridad en la Implementación

A pesar de sus ventajas, el despliegue del agente no está exento de riesgos. Uno principal es la dependencia de modelos de IA, que pueden propagar sesgos si el dataset de entrenamiento no es diverso, llevando a falsos positivos en contextos culturales específicos. Por ejemplo, términos ambiguos en español o portugués podrían malinterpretarse en regiones latinoamericanas, donde las amenazas locales como el cibercrimen en América Latina difieren de patrones globales.

Otro riesgo involucra la privacidad: el procesamiento de alertas sensibles requiere encriptación end-to-end (usando AES-256) y cumplimiento con principios de minimización de datos. Además, ataques adversarios contra LLMs, como inyecciones de prompt, podrían manipular outputs; mitigar esto implica validaciones sanitarias y sandboxing de ejecuciones.

Para abordar estos, se recomiendan mejores prácticas como pruebas de penetración regulares (pentesting) alineadas con OWASP Top 10 para aplicaciones de IA, y auditorías periódicas de modelos para detectar drift (desviación de rendimiento). En entornos híbridos, la integración con herramientas on-premise asegura resiliencia ante interrupciones de servicio cloud.

Casos de Uso Prácticos en Ciberseguridad

En la práctica, el agente se aplica en diversos escenarios. Para equipos de threat hunting, monitorea alertas proactivas sobre campañas de phishing dirigidas a sectores como banca o salud, correlacionando con datos de dark web via APIs como Recorded Future. En respuesta a incidentes, acelera el triage post-breach, identificando patrones en logs de eventos similares a alertas históricas.

Un caso ilustrativo es el monitoreo de vulnerabilidades en supply chains, como el incidente SolarWinds de 2020. El agente podría haber detectado menciones tempranas en foros, priorizándolas por su impacto en múltiples organizaciones y generando recomendaciones basadas en el framework NIST Cybersecurity.

En América Latina, donde el ransomware afecta al 40% de las empresas según reportes de Kaspersky, el agente adapta alertas a amenazas regionales, como el grupo Conti operando en Brasil o México, integrando fuentes locales como el Centro de Respuesta a Incidentes Cibernéticos de Brasil (CERT.br).

- Threat Intelligence: Rastreo automatizado de IOCs en tiempo real.

- Compliance Monitoring: Verificación de alertas regulatorias, como actualizaciones de PCI-DSS.

- Entrenamiento y Simulaciones: Uso de alertas sintéticas para ejercicios de SOC.

Implicaciones Regulatorias y Éticas

La adopción de este agente plantea implicaciones regulatorias significativas. En la Unión Europea, el AI Act clasifica herramientas de ciberseguridad como de alto riesgo, requiriendo evaluaciones de impacto y transparencia en algoritmos. En Latinoamérica, marcos como la Ley de Protección de Datos Personales en México o la LGPD en Brasil exigen que el procesamiento de alertas no infrinja privacidad, promoviendo el uso de anonimización técnicas como k-anonimato.

Éticamente, surge el dilema de la autonomía en decisiones de seguridad: ¿debe un agente IA escalar automáticamente una alerta crítica sin supervisión humana? Protocolos híbridos, donde la IA propone y el humano aprueba, alinean con principios de explainable AI (XAI), utilizando técnicas como LIME (Local Interpretable Model-agnostic Explanations) para desglosar decisiones.

Adicionalmente, la interoperabilidad con estándares globales como STIX/TAXII para intercambio de threat intelligence asegura que el agente contribuya a ecosistemas colaborativos, fomentando la resiliencia colectiva contra amenazas transnacionales.

Desafíos Técnicos y Futuras Evoluciones

Entre los desafíos técnicos, destaca la gestión de datos en volumen: el agente debe manejar petabytes de alertas históricas, optimizando con técnicas de big data como Apache Spark para procesamiento distribuido. La latencia en entornos de edge computing, crucial para respuestas en tiempo real, se aborda con modelos lightweight como DistilBERT.

Mirando al futuro, evoluciones potenciales incluyen integración con IA multimodal, procesando no solo texto sino imágenes de alertas (por ejemplo, capturas de malware) vía Vision Transformers. Además, la federación de aprendizaje permitiría entrenar modelos colaborativamente sin compartir datos sensibles, alineado con iniciativas como el Gaia-X para soberanía digital en Europa y Latinoamérica.

Otras innovaciones podrían incorporar blockchain para la verificación inmutable de chains de custodia en investigaciones, asegurando integridad en reportes forenses.

Conclusión

El agente de triaje e investigación de alertas de Google representa un paradigma transformador en la ciberseguridad, fusionando la accesibilidad de Google Alerts con la potencia de la IA para una defensa proactiva y eficiente. Al mitigar la sobrecarga operativa y potenciar la inteligencia accionable, esta herramienta no solo eleva la capacidad de los SOC sino que también pavimenta el camino hacia sistemas autónomos en la era de la amenaza cibernética persistente. Para organizaciones en Latinoamérica y más allá, su adopción estratégica, guiada por consideraciones éticas y regulatorias, promete una mayor resiliencia frente a un panorama de riesgos en constante evolución. Para más información, visita la Fuente original.