Clonación de Voz mediante Inteligencia Artificial: Riesgos y Mecanismos en Estafas Cibernéticas

Introducción a la Tecnología de Clonación Vocal

La inteligencia artificial ha avanzado en la síntesis de voz, permitiendo la clonación de patrones vocales humanos con muestras mínimas de audio. Investigaciones recientes demuestran que solo tres segundos de grabación son suficientes para generar réplicas convincentes. Esta capacidad se basa en modelos de aprendizaje profundo, como las redes neuronales generativas adversarias (GAN), que analizan y replican timbre, entonación y acentos. En el ámbito de la ciberseguridad, esta tecnología representa un vector de ataque sofisticado, facilitando fraudes impersonales que explotan la confianza interpersonal.

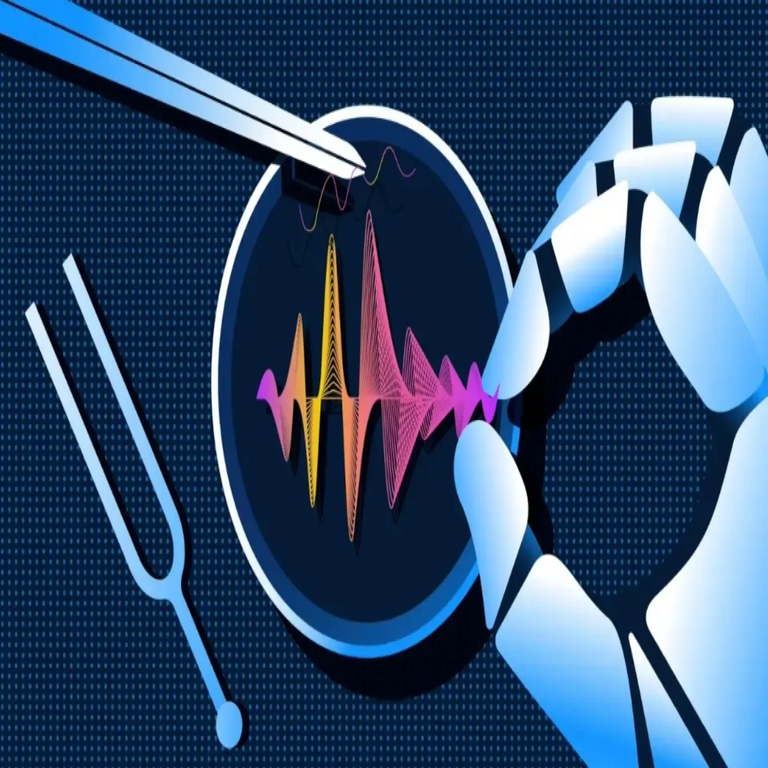

Mecanismos Técnicos de la Clonación de Voz

El proceso inicia con la extracción de características acústicas de la muestra de audio original. Herramientas de IA, tales como modelos de texto a voz (TTS) mejorados con aprendizaje automático, descomponen el espectrograma del sonido en componentes como frecuencia fundamental y formantes. Posteriormente, un generador de voz sintética reconstruye el audio utilizando bases de datos de entrenamiento masivas, que incluyen miles de horas de grabaciones humanas.

- Análisis de Muestra: Se emplean algoritmos de procesamiento de señales para identificar patrones únicos, como variaciones en el flujo de aire y resonancias vocales.

- Síntesis Generativa: Modelos como WaveNet o Tacotron 2 convierten texto en fonemas y los modulan para emular la voz objetivo, alcanzando una similitud superior al 95% en pruebas controladas.

- Integración con IA Multimodal: En escenarios avanzados, se combina con reconocimiento facial para deepfakes audiovisuales, incrementando la credibilidad del engaño.

Plataformas accesibles como ElevenLabs o servicios de código abierto en GitHub democratizan esta tecnología, reduciendo la barrera de entrada para actores maliciosos.

Aplicación en Estafas por WhatsApp y Llamadas Telefónicas

Los hackers aprovechan la clonación vocal para orquestar estafas de ingeniería social. Un método común implica la obtención de muestras de voz a través de redes sociales, videos públicos o intercepciones en llamadas. Con esta data, generan audios falsos que simulan emergencias, como un familiar secuestrado o un accidente, solicitando transferencias urgentes de dinero.

- Escenario Típico: El atacante envía un mensaje de WhatsApp con un audio clonado, seguido de una llamada para reforzar la urgencia, explotando el pánico emocional.

- Vectores de Adquisición: Fuentes incluyen perfiles de LinkedIn, YouTube o incluso asistentes virtuales hackeados, donde se recolectan fragmentos de tres segundos o más.

- Impacto Económico: Estas estafas han reportado pérdidas millonarias, con tasas de éxito elevadas debido a la indistinguibilidad de las voces sintéticas de las reales.

En términos técnicos, la latencia de generación es inferior a un minuto en hardware estándar, permitiendo ataques en tiempo real durante interacciones.

Medidas de Prevención y Detección

Para mitigar estos riesgos, se recomiendan protocolos de verificación multifactor en comunicaciones sensibles. La detección de deepfakes vocales involucra análisis forense de audio, buscando anomalías como inconsistencias en el espectro de frecuencias o patrones de ruido artificiales generados por IA.

- Herramientas de Detección: Software como Deepware Scanner o algoritmos basados en machine learning identifican artefactos en el audio, tales como transiciones abruptas en el flujo fonético.

- Prácticas Recomendadas: Establecer códigos verbales predefinidos con familiares, evitar compartir audios personales en línea y utilizar aplicaciones con encriptación end-to-end para validar identidades.

- Avances Regulatorios: Iniciativas como las directrices de la Unión Europea sobre IA exigen watermarking en contenidos sintéticos, aunque su implementación global es limitada.

La educación en ciberseguridad es crucial, enfatizando la verificación independiente antes de cualquier transacción financiera inducida por audio.

Consideraciones Finales

La clonación de voz con IA ilustra la convergencia entre avances tecnológicos y vulnerabilidades cibernéticas, demandando una respuesta integrada que combine innovación defensiva con conciencia usuario. A medida que los modelos de IA evolucionan, la ciberseguridad debe priorizar la robustez contra manipulaciones auditivas, asegurando la integridad de las interacciones digitales.

Para más información visita la Fuente original.