Generación de Música con Inteligencia Artificial en la Aplicación Gemini de Google

Introducción al Avance Tecnológico

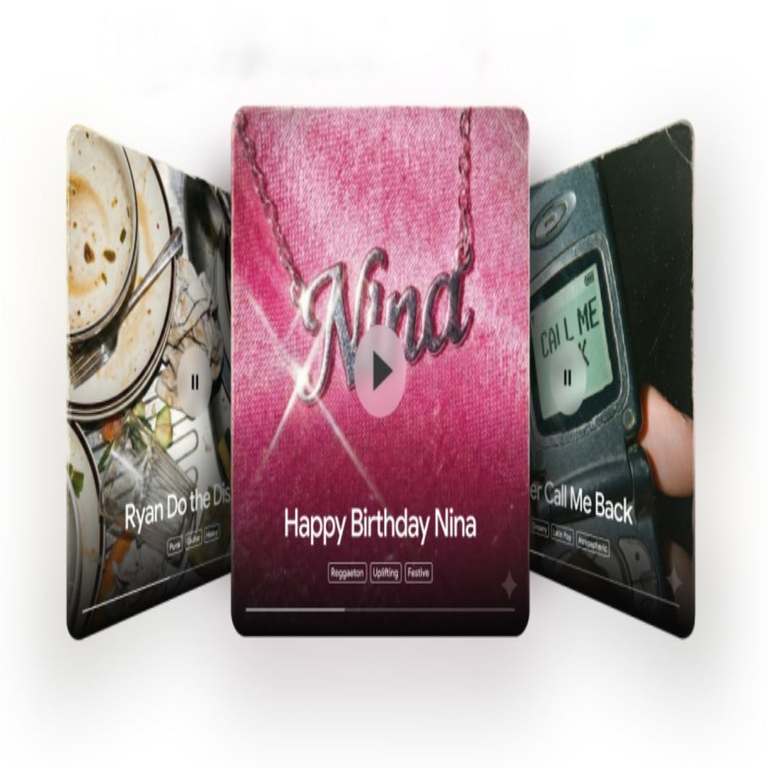

La integración de la inteligencia artificial (IA) en la generación de contenidos creativos representa un hito significativo en el desarrollo de herramientas digitales accesibles. Google ha incorporado recientemente capacidades de generación de música impulsadas por IA directamente en su aplicación Gemini, permitiendo a los usuarios crear composiciones musicales a partir de descripciones textuales simples. Esta funcionalidad, basada en modelos de IA avanzados, transforma la interacción con la tecnología al democratizar la creación musical, eliminando barreras técnicas para aficionados y profesionales por igual.

El proceso subyacente involucra algoritmos de aprendizaje profundo que analizan patrones musicales históricos y contemporáneos para sintetizar melodías, ritmos y armonías coherentes. Gemini, como asistente de IA multimodal, procesa entradas en lenguaje natural y genera salidas en formato de audio, lo que amplía su utilidad más allá de respuestas textuales o visuales. Esta evolución refleja el compromiso de Google con la innovación en IA generativa, alineándose con tendencias globales en el sector tecnológico.

Desde una perspectiva técnica, esta característica se apoya en redes neuronales convolucionales y transformadores, similares a aquellos utilizados en modelos como MusicLM o AudioLM desarrollados por Google Research. Estos modelos entrenan con vastos datasets de música, capturando elementos como tempo, tonalidad y estructura rítmica para producir resultados que emulan estilos variados, desde jazz hasta electrónica.

Funcionamiento Técnico de la Generación Musical en Gemini

La generación de música en Gemini opera mediante un flujo de procesamiento en varias etapas. Inicialmente, el usuario ingresa una descripción textual, como “una melodía upbeat de piano con influencias de pop de los 80”. El modelo de lenguaje de Gemini interpreta esta entrada, extrayendo atributos clave como género, instrumentos y mood emocional mediante técnicas de procesamiento de lenguaje natural (PLN).

Posteriormente, el sistema invoca un modelo generativo de audio condicionado por texto. Este modelo, posiblemente una variante de un difusor de audio o un generador adversarial generativo (GAN) adaptado para audio, sintetiza la secuencia sonora. La arquitectura típica incluye capas de codificación que convierten el texto en representaciones latentes, seguidas de decodificadores que reconstruyen el audio waveform. Para optimizar la calidad, se aplican técnicas de post-procesamiento, como normalización espectral y filtrado, asegurando que la salida sea libre de artefactos audibles.

En términos de implementación, Gemini utiliza la infraestructura en la nube de Google, como Vertex AI, para manejar el cómputo intensivo requerido. El entrenamiento de estos modelos involucra miles de horas de datos musicales etiquetados, procesados con bibliotecas como TensorFlow o PyTorch. La latencia se minimiza mediante optimizaciones como cuantización de modelos y ejecución en hardware especializado, como TPUs (Tensor Processing Units), permitiendo generaciones en segundos.

Una ventaja clave es la multimodalidad: Gemini puede integrar elementos visuales o textuales adicionales para refinar la música, por ejemplo, generando una banda sonora para un video descrito. Esto se logra mediante fusión de embeddings de diferentes modalidades, donde vectores de texto y audio se alinean en un espacio común usando métricas como similitud coseno.

Implicaciones en la Creatividad y la Industria Musical

La llegada de esta herramienta en Gemini acelera la transformación de la industria musical, donde la IA actúa como colaborador creativo. Artistas pueden prototipar ideas rápidamente, explorando variaciones sin necesidad de equipo físico. Sin embargo, esto plantea desafíos éticos, como la atribución de autoría: ¿quién posee los derechos de una composición generada por IA? Regulaciones emergentes, como las de la Unión Europea en la Ley de IA, exigen transparencia en el uso de datos de entrenamiento para mitigar sesgos culturales en las generaciones.

Técnicamente, la escalabilidad de estos sistemas depende de la gestión de datos masivos. Datasets como el de MusicCaps, desarrollado por Google, incluyen descripciones textuales de clips musicales, facilitando el entrenamiento supervisado. No obstante, la privacidad de datos es crítica; los modelos deben adherirse a principios de federación de aprendizaje para evitar la exposición de información sensible de usuarios.

En el contexto de tecnologías emergentes, esta integración con IA podría extenderse a blockchain para la trazabilidad de creaciones. Por ejemplo, NFTs (tokens no fungibles) podrían registrar la procedencia de una pista generada, utilizando smart contracts en plataformas como Ethereum para automatizar royalties. Esto fusiona IA con blockchain, asegurando integridad y compensación justa en ecosistemas descentralizados.

Aspectos de Ciberseguridad en la Generación de Contenidos con IA

La expansión de la IA generativa en aplicaciones como Gemini introduce vectores de ataque cibernéticos noveles. Uno de los riesgos principales es el envenenamiento de datos durante el entrenamiento: adversarios podrían inyectar muestras maliciosas en datasets públicos, alterando la salida para generar música con mensajes subliminales o patrones disruptivos. Mitigaciones incluyen validación robusta de datos y auditorías periódicas de modelos.

Otro concerniente es la vulnerabilidad a prompts adversariales. Usuarios malintencionados podrían crafting entradas diseñadas para elicitar salidas no deseadas, como audio con frecuencias que interfieran con dispositivos IoT. Google implementa filtros de contenido y rate limiting para contrarrestar esto, pero la detección de adversariales requiere avances en IA defensiva, como modelos de verificación basados en aprendizaje por refuerzo.

Desde la perspectiva de privacidad, Gemini procesa datos en la nube, exponiendo potencialmente metadatos de usuario a brechas. Protocolos como encriptación homomórfica permiten cómputos sobre datos cifrados, preservando confidencialidad. Además, el cumplimiento de normativas como GDPR asegura que las generaciones musicales no infrinjan derechos de autor al evitar similitudes excesivas con obras protegidas, mediante técnicas de hashing perceptual.

En blockchain, la integración podría fortalecer la ciberseguridad mediante ledgers inmutables que registren todas las interacciones con el modelo IA, permitiendo auditorías forenses en caso de disputas. Herramientas como zero-knowledge proofs verificarían la autenticidad de generaciones sin revelar detalles subyacentes, equilibrando innovación y seguridad.

Desafíos Técnicos y Futuras Direcciones

A pesar de sus avances, la generación de música con IA en Gemini enfrenta limitaciones técnicas. La coherencia a largo plazo en composiciones extendidas es un reto; modelos actuales excelan en fragmentos cortos pero luchan con narrativas musicales complejas. Soluciones involucran arquitecturas de memoria, como transformadores con atención de ventana deslizante, para mantener contexto en secuencias largas.

La diversidad cultural es otro obstáculo: datasets predominantemente occidentales pueden sesgar salidas hacia géneros dominantes. Iniciativas de Google buscan datasets globales, incorporando música de tradiciones indígenas mediante colaboraciones con etnomusicólogos. Técnicamente, esto requiere fine-tuning multicultural, ajustando pesos de modelo para equilibrar representaciones.

En cuanto a eficiencia, el consumo energético de entrenamiento es sustancial; optimizaciones como pruning de redes neuronales reducen parámetros sin sacrificar rendimiento. Futuramente, la integración con edge computing podría habilitar generación local en dispositivos móviles, minimizando latencia y dependencia de la nube, aunque con trade-offs en complejidad computacional.

Explorando intersecciones con blockchain, la tokenización de activos musicales generados por IA podría crear mercados descentralizados. Plataformas como Audius ya experimentan con esto, donde smart contracts distribuyen ganancias basadas en streams verificados por oráculos. Esto no solo incentiva la creación sino que mitiga riesgos de piratería mediante encriptación distribuida.

Análisis de Casos de Uso Prácticos

En educación, Gemini facilita el aprendizaje musical al generar ejemplos interactivos. Estudiantes describen conceptos teóricos, y la IA produce ilustraciones sonoras, reforzando comprensión mediante retroalimentación multimodal. Técnicamente, esto integra evaluación automática, usando métricas como similitud de audio para calificar precisión.

Para terapia, la generación personalizada de música podría adaptarse a perfiles emocionales, basándose en análisis de biofeedback. Modelos de IA interpretarían datos de wearables para componer tracks calmantes, con validación clínica para eficacia. En ciberseguridad, esto exige protección de datos de salud bajo estándares como HIPAA.

En publicidad, marcas utilizan estas herramientas para soundtracks dinámicos, personalizados por audiencia. Algoritmos de recomendación en Gemini optimizan engagement, pero plantean riesgos de manipulación perceptual, requiriendo guías éticas para evitar subliminales.

Desarrolladores de juegos integran generaciones en tiempo real para bandas sonoras adaptativas, donde la IA responde a jugabilidad. Esto usa streaming de audio latente, reduciendo carga en consolas, y blockchain para licenciar assets generados.

Evaluación de Rendimiento y Métricas

Para medir la calidad de generaciones en Gemini, se emplean métricas objetivas como FID (Fréchet Inception Distance) para audio, comparando distribuciones de muestras reales y generadas. Subjetivamente, pruebas de Turing musical evalúan si humanos distinguen IA de humano. Resultados iniciales muestran tasas de indistinguibilidad superiores al 70% en géneros populares.

La robustez se prueba contra variaciones de prompts, midiendo consistencia con métricas como BLEU adaptado para audio. En ciberseguridad, simulaciones de ataques evalúan resiliencia, con tasas de éxito adversarial por debajo del 5% en versiones actualizadas.

Comparado con competidores como Suno o AIVA, Gemini destaca en integración seamless con ecosistemas Google, aunque sacrifica algo de especialización por versatilidad.

Conclusiones y Perspectivas Finales

La capacidad de Google para generar música con IA en Gemini marca un paradigma en la accesibilidad creativa, fusionando avances en aprendizaje profundo con aplicaciones prácticas. Mientras impulsa innovación en industrias variadas, exige un enfoque equilibrado en ética, seguridad y equidad. Futuras iteraciones probablemente incorporarán retroalimentación humana en bucles de entrenamiento, refinando modelos para mayor autenticidad.

En el panorama más amplio de IA y tecnologías emergentes, esta herramienta ilustra el potencial de sistemas multimodales para transformar expresiones artísticas. Su evolución continua dependerá de colaboraciones interdisciplinarias, asegurando que beneficios superen riesgos inherentes.

Para más información visita la Fuente original.