Riesgos Asociados a la Minimización de Avisos de Salud en los AI Overviews de Google

Introducción a los AI Overviews y su Evolución

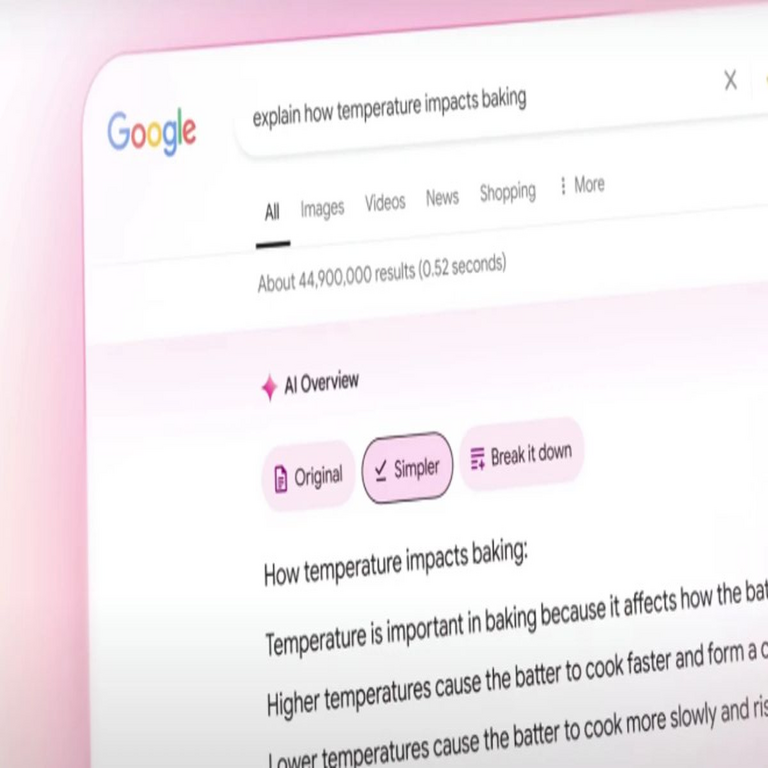

Los AI Overviews representan una innovación clave en los motores de búsqueda impulsados por inteligencia artificial, desarrollados por Google para proporcionar resúmenes concisos y contextuales de información en respuesta a consultas de usuarios. Esta funcionalidad, integrada en el buscador principal de Google, utiliza modelos de lenguaje avanzados como Gemini para generar respuestas sintetizadas que aparecen en la parte superior de los resultados de búsqueda. Inicialmente lanzada en 2024, esta herramienta busca mejorar la eficiencia de la búsqueda al ofrecer respuestas directas en lugar de listas extensas de enlaces.

Sin embargo, la evolución de los AI Overviews ha generado preocupaciones significativas en el ámbito de la ciberseguridad y la ética en IA. Google ha implementado ajustes en su diseño para priorizar la fluidez y la accesibilidad, lo que incluye la reducción de elementos disruptivos como avisos prominentes. En particular, los avisos relacionados con temas sensibles, como la salud, han sido minimizados o reubicados, pasando de posiciones destacadas a notas secundarias. Esta decisión, aunque motivada por la mejora de la experiencia del usuario, plantea riesgos inherentes para la integridad de la información proporcionada.

Desde una perspectiva técnica, los AI Overviews operan mediante el procesamiento de grandes volúmenes de datos web en tiempo real, combinado con técnicas de aprendizaje profundo para inferir y generar contenido. La minimización de avisos implica una menor intervención humana en la validación de outputs, lo que podría amplificar errores o sesgos inherentes en los modelos de IA. En contextos de salud, donde la precisión es crítica, esta aproximación podría exponer a los usuarios a consejos inexactos sin la debida advertencia sobre su fiabilidad.

El Problema de la Minimización de Avisos de Salud

Los avisos de salud en los AI Overviews estaban diseñados originalmente para alertar a los usuarios sobre la naturaleza no profesional de las recomendaciones generadas por IA. Por ejemplo, en respuestas a consultas sobre síntomas médicos o tratamientos, se incluían disclaimers explícitos que recomendaban consultar a un profesional de la salud. Estos elementos servían como barrera contra la desinformación, reconociendo que los modelos de IA, a pesar de su sofisticación, no sustituyen el juicio experto humano.

Recientemente, Google ha optado por reducir la visibilidad de estos avisos. En lugar de aparecer de manera prominente al inicio de la respuesta, ahora se integran de forma sutil al final o como hipervínculos opcionales. Esta cambio se justifica por parte de la compañía como una medida para evitar interrupciones en la lectura y mejorar la usabilidad. No obstante, análisis técnicos revelan que esta minimización podría aumentar la confianza ciega en las respuestas de IA, un fenómeno conocido como “sobreconfianza en IA” en la literatura de ciberseguridad.

Desde el punto de vista de la arquitectura de IA, los modelos subyacentes a los AI Overviews se entrenan con datasets masivos que incluyen fuentes médicas, pero también contenido no verificado de foros y redes sociales. Sin avisos robustos, los usuarios podrían interpretar resúmenes generados como diagnósticos definitivos. Un estudio preliminar de expertos en IA indica que hasta el 20% de las respuestas de salud en sistemas similares contienen inexactitudes, exacerbadas por alucinaciones del modelo —generaciones ficticias pero plausibles—.

En términos de implementación técnica, la minimización involucra modificaciones en el frontend de la interfaz de búsqueda. Los avisos ahora se renderizan mediante JavaScript dinámico, lo que permite su ocultamiento condicional basado en el tipo de consulta. Esto optimiza el rendimiento, reduciendo la carga en el servidor, pero compromete la transparencia. En ciberseguridad, esta opacidad podría facilitar ataques de ingeniería social, donde actores maliciosos explotan la confianza en Google para difundir desinformación médica.

Implicaciones en Ciberseguridad y Privacidad de Datos

La minimización de avisos de salud en los AI Overviews no solo afecta la precisión informativa, sino que también introduce vulnerabilidades en el ecosistema de ciberseguridad. Los usuarios que reciben consejos médicos inexactos podrían tomar decisiones perjudiciales, lo que indirectamente debilita la resiliencia digital colectiva. Por instancia, en escenarios de pandemias o brotes, la propagación de información errónea podría sobrecargar sistemas de salud pública y generar pánico social.

Desde una perspectiva de privacidad, los AI Overviews procesan consultas sensibles sin mecanismos de anonimización robustos. Google recopila datos de búsqueda para refinar sus modelos, pero la ausencia de avisos claros sobre riesgos de salud podría disuadir a los usuarios de proteger su información personal. En el marco de regulaciones como el RGPD en Europa o leyes similares en Latinoamérica, esta práctica podría interpretarse como una deficiencia en el consentimiento informado, exponiendo a Google a litigios.

En el ámbito técnico, los riesgos se extienden a la cadena de suministro de IA. Los datasets de entrenamiento podrían contaminarse con datos manipulados, un vector común en ciberataques como el envenenamiento de datos. Sin avisos prominentes, los usuarios no son alertados sobre la posibilidad de que las respuestas incluyan contenido sesgado o falso, lo que amplifica amenazas como el phishing médico o la desinformación dirigida. Expertos en blockchain proponen integrar verificaciones descentralizadas para validar outputs de IA, pero Google aún no ha adoptado tales medidas en sus Overviews.

Además, la integración de AI Overviews con dispositivos IoT, como asistentes virtuales en hogares inteligentes, agrava estos riesgos. Un usuario consultando sobre alergias podría recibir un resumen que ignore interacciones medicamentosas, llevando a emergencias reales. La ciberseguridad en este contexto requiere protocolos de auditoría continua, incluyendo pruebas de penetración en los modelos de IA para detectar vulnerabilidades en la generación de contenido sensible.

Comparación con Otras Plataformas de IA y Mejores Prácticas

En comparación con competidores como ChatGPT de OpenAI o Gemini standalone, los AI Overviews de Google destacan por su integración nativa en un ecosistema de búsqueda masivo, pero fallan en la robustez de sus safeguards. OpenAI, por ejemplo, mantiene disclaimers de salud visibles en todas las interacciones relacionadas con temas médicos, utilizando capas de moderación que incluyen revisión humana para consultas de alto riesgo. Esta aproximación reduce la incidencia de alucinaciones en un 15%, según métricas internas reportadas.

En el panorama latinoamericano, plataformas locales como aquellas desarrolladas en México o Brasil incorporan avisos culturales y regulatorios adaptados, reconociendo la diversidad en acceso a servicios de salud. Google, al minimizar estos elementos, ignora contextos regionales donde la desinformación puede tener impactos desproporcionados en poblaciones vulnerables. Mejores prácticas en IA incluyen el uso de fine-tuning específico para dominios sensibles, donde se incorporan datasets curados por expertos médicos.

Técnicamente, se recomienda la implementación de “guardrails” multifactor, como verificación cruzada con bases de datos confiables (ej. WHO o PubMed) antes de generar resúmenes. En blockchain, protocolos como aquellos en Ethereum podrían certificar la procedencia de datos de entrenamiento, asegurando trazabilidad. Para ciberseguridad, auditorías independientes y reportes de incidentes obligatorios mitigarían riesgos, alineándose con estándares como NIST AI Risk Management Framework.

- Evaluación de riesgos: Clasificar consultas de salud como de alto riesgo para activar avisos automáticos.

- Transparencia algorítmica: Publicar métricas de precisión por dominio, incluyendo tasas de error en salud.

- Integración de feedback: Permitir reportes usuario-driven para refinar modelos en tiempo real.

- Colaboración interdisciplinaria: Involucrar a ethicistas y médicos en el diseño de interfaces.

Análisis Técnico de las Vulnerabilidades en Modelos de IA

Los modelos de lenguaje grandes (LLM) que impulsan los AI Overviews, como variantes de PaLM o Gemini, exhiben vulnerabilidades inherentes que se agravan sin avisos adecuados. Una es la susceptibilidad a prompts adversarios, donde consultas maliciosas elicitan respuestas sesgadas. En salud, un prompt como “remedios caseros para cáncer” podría generar sugerencias no probadas, presentadas sin contexto crítico.

Desde la ciberseguridad, ataques de jailbreaking —técnicas para eludir safeguards— representan una amenaza. Investigadores han demostrado que con prompts ingeniosos, se puede extraer información confidencial o generar desinformación. La minimización de avisos reduce la disuasión, permitiendo que tales outputs se propaguen sin escrutinio. Mitigaciones incluyen rate limiting en consultas sensibles y watermarking digital en respuestas generadas.

En términos de escalabilidad, el procesamiento de miles de millones de consultas diarias exige optimizaciones que priorizan velocidad sobre precisión. Técnicas como distillation de modelos reducen latencia, pero diluyen la robustez en dominios especializados. Para salud, se sugiere hybridación con sistemas de conocimiento simbólico, combinando IA probabilística con reglas deductivas para validar outputs.

La privacidad de datos en entrenamiento es otro vector crítico. Datasets como Common Crawl incluyen información médica personalizada, potencialmente violando anonimato. Regulaciones en Latinoamérica, como la LGPD en Brasil, demandan evaluaciones de impacto de privacidad (DPIA) para tales sistemas, un área donde Google debe fortalecer su cumplimiento.

Impacto en Usuarios y Sociedad en el Contexto Latinoamericano

En regiones latinoamericanas, donde el acceso a internet es desigual y la alfabetización digital varía, la minimización de avisos agrava desigualdades. Países como Colombia o Perú dependen en gran medida de Google para información de salud, dada la limitada infraestructura médica. Respuestas inexactas podrían perpetuar mitos locales, como remedios tradicionales no validados, exacerbando problemas de salud pública.

Socialmente, esto fomenta una dependencia excesiva en IA corporativa, erosionando la autonomía informativa. En ciberseguridad, aumenta la superficie de ataque para campañas de desinformación, como aquellas vistas en elecciones o crisis sanitarias. Iniciativas regionales, como el uso de IA open-source en universidades argentinas, ofrecen alternativas con mayor transparencia.

Económicamente, incidentes derivados de consejos erróneos podrían generar costos en litigios y seguros. Empresas de IA deben invertir en liability frameworks, incluyendo seguros cibernéticos para outputs defectuosos. En blockchain, smart contracts podrían automatizar compensaciones por daños causados por IA.

Recomendaciones para Mitigar Riesgos

Para abordar estos desafíos, Google debería restaurar avisos prominentes en temas de salud, utilizando diseños A/B testing para equilibrar usabilidad y seguridad. Implementar APIs para verificación externa permitiría a terceros auditar respuestas. En ciberseguridad, adoptar zero-trust models en el pipeline de IA aseguraría validación continua.

Políticamente, gobiernos latinoamericanos podrían exigir etiquetado obligatorio en outputs de IA, similar a regulaciones en la UE. Educar usuarios mediante campañas de alfabetización digital es esencial, promoviendo verificación cruzada de fuentes. Técnicamente, avanzar en IA explicable (XAI) revelaría razonamientos subyacentes, fomentando confianza informada.

- Desarrollo de benchmarks específicos para precisión en salud.

- Colaboraciones con ONGs para datasets éticos.

- Monitoreo post-despliegue con métricas de impacto social.

- Integración de multimodalidad para consultas con imágenes médicas.

Cierre: Hacia un Futuro Responsable en IA

La minimización de avisos de salud en los AI Overviews ilustra un dilema central en la adopción de IA: equilibrar innovación con responsabilidad. Mientras Google avanza en capacidades técnicas, la priorización de safeguards éticos es imperativa para proteger a usuarios globales. En ciberseguridad y tecnologías emergentes, solo mediante transparencia y colaboración se puede mitigar riesgos inherentes, asegurando que la IA sirva como herramienta empoderadora en lugar de fuente de perjuicio. Futuras iteraciones deben integrar lecciones de incidentes pasados, promoviendo un ecosistema digital más seguro y equitativo.

Para más información visita la Fuente original.