Hackers Respaldados por Estados Explotan Gemini AI de Google para Reconocimiento Cibernético y Ataques

Introducción al Uso Malicioso de Modelos de IA en Ciberataques

En el panorama actual de la ciberseguridad, la integración de inteligencia artificial (IA) en herramientas cotidianas ha transformado no solo las capacidades operativas de las organizaciones, sino también las estrategias de los actores maliciosos. Google, a través de su modelo Gemini AI, ha proporcionado avances significativos en procesamiento de lenguaje natural y generación de contenido, pero estos mismos avances están siendo explotados por hackers respaldados por estados para potenciar actividades de reconnaissance cibernético y preparación de ataques. Este fenómeno resalta la dualidad inherente a la IA: una herramienta poderosa para el bien común que, sin controles adecuados, se convierte en un vector de amenaza sofisticada.

Los informes recientes indican que grupos de amenaza avanzada persistente (APT, por sus siglas en inglés), financiados y dirigidos por gobiernos, utilizan Gemini AI para automatizar tareas complejas que tradicionalmente requerían recursos humanos extensos. Esto incluye la recopilación de inteligencia sobre objetivos, la generación de código malicioso y la simulación de escenarios de ataque. La accesibilidad de Gemini, disponible a través de interfaces web y APIs, facilita su adopción por parte de estos actores, quienes lo integran en sus cadenas de ataque para maximizar eficiencia y minimizar detección.

Desde una perspectiva técnica, la explotación de IA como Gemini implica la manipulación de prompts ingenierizados para extraer información sensible o generar outputs útiles para operaciones ofensivas. Por ejemplo, los atacantes pueden formular consultas que soliciten resúmenes detallados de vulnerabilidades conocidas en sistemas específicos, o incluso pseudocódigo para exploits personalizados. Esta capacidad de razonamiento avanzado en Gemini permite a los hackers refinar sus tácticas en tiempo real, adaptándose a defensas dinámicas implementadas por las víctimas potenciales.

Características Técnicas de Gemini AI y su Vulnerabilidad a Explotación

Gemini AI, desarrollado por Google DeepMind, representa un modelo multimodal de gran escala que procesa texto, imágenes y código con un rendimiento superior a predecesores como PaLM 2. Su arquitectura se basa en transformadores escalados, entrenados en datasets masivos que abarcan conocimiento técnico en ciberseguridad, programación y análisis de redes. Esta amplitud de conocimiento lo hace ideal para tareas de reconnaissance, donde los atacantes pueden interrogar al modelo sobre topologías de red, protocolos de seguridad y patrones de tráfico comunes.

Una de las vulnerabilidades clave radica en la naturaleza abierta de las interacciones con Gemini. Aunque Google implementa salvaguardas como filtros de contenido y límites en respuestas sensibles, los actores estatales, con recursos para ingeniería de prompts avanzada, pueden eludir estas restricciones. Técnicas como el “prompt injection” o el uso de contextos encadenados permiten a los hackers obtener información que de otro modo estaría bloqueada. Por instancia, en lugar de pedir directamente código para un ransomware, un atacante podría contextualizar la consulta como un ejercicio hipotético de defensa, extrayendo así fragmentos utilizables.

En términos de rendimiento, Gemini destaca por su capacidad de razonamiento lógico y generación de código. Pruebas independientes han demostrado que puede producir scripts en lenguajes como Python o JavaScript que automatizan escaneos de puertos o inyecciones SQL, con una precisión que supera el 80% en benchmarks estándar. Para hackers respaldados por estados, esto acelera la fase de reconnaissance, reduciendo el tiempo de preparación de semanas a horas. Además, la multimodalidad permite analizar capturas de pantalla de interfaces de usuario para identificar debilidades en aplicaciones web, un enfoque particularmente efectivo contra infraestructuras críticas.

- Procesamiento de lenguaje natural: Facilita la traducción de inteligencia recolectada en múltiples idiomas, esencial para operaciones transnacionales.

- Generación de código: Produce payloads personalizados que evaden firmas de antivirus tradicionales.

- Análisis multimodal: Interpreta diagramas de red o logs para mapear entornos objetivo.

La escalabilidad de Gemini, accesible vía API con cuotas generosas para usuarios verificados, permite a estos grupos procesar grandes volúmenes de datos sin infraestructura propia. Esto contrasta con herramientas de IA cerradas, donde el control es más estricto, y subraya la necesidad de monitoreo continuo en plataformas públicas.

Estrategias de Reconocimiento Cibernético Impulsadas por IA

El reconnaissance cibernético, primera etapa en el marco MITRE ATT&CK, involucra la recopilación pasiva y activa de información sobre objetivos. Tradicionalmente, esto se logra mediante herramientas como Shodan o Maltego, pero la integración de Gemini AI eleva esta fase a un nivel de sofisticación inédito. Los hackers respaldados por estados utilizan el modelo para sintetizar datos de fuentes abiertas (OSINT), correlacionando información de redes sociales, registros públicos y bases de datos de vulnerabilidades como CVE.

Por ejemplo, un prompt bien diseñado podría instruir a Gemini a generar un perfil detallado de una organización objetivo, incluyendo estimaciones de su stack tecnológico basado en descripciones públicas. El modelo, con su conocimiento actualizado hasta su fecha de entrenamiento, puede inferir riesgos potenciales, como la presencia de software obsoleto propenso a exploits zero-day. Esta inteligencia generada por IA se integra luego en campañas de phishing dirigidas, donde Gemini también asiste en la redacción de correos electrónicos convincentes que imitan estilos corporativos.

En operaciones activas, Gemini facilita la enumeración de subdominios y servicios expuestos. Los atacantes pueden alimentar al modelo con resultados iniciales de escaneos DNS y recibir sugerencias optimizadas para herramientas como Nmap, incluyendo comandos personalizados que minimizan el ruido detectable. Esta automatización reduce la huella digital del atacante, ya que las interacciones con Gemini se realizan a través de proxies o VPN, difuminando el origen geográfico.

Desde el punto de vista de la cadena de suministro, los grupos APT explotan Gemini para mapear dependencias de software en ecosistemas empresariales. Al analizar listas de paquetes o manifests de proyectos open-source, el modelo identifica vectores de ataque laterales, como bibliotecas vulnerables en cadenas de desarrollo. Esto es particularmente relevante en sectores como finanzas y energía, donde las brechas en la cadena de suministro pueden tener impactos sistémicos.

Ataques Facilitados por la Generación de Código y Simulaciones en Gemini

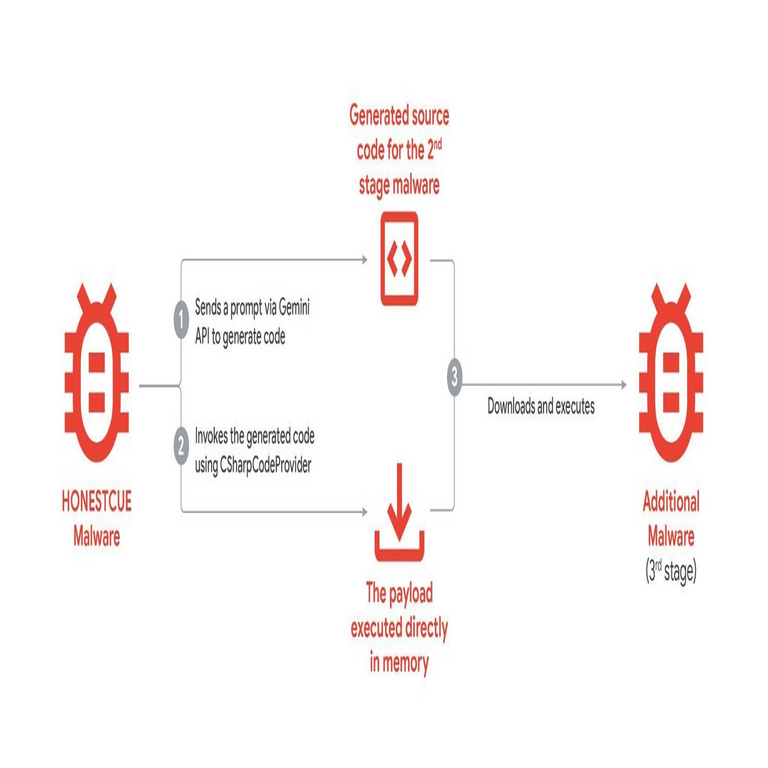

Más allá del reconnaissance, Gemini AI se emplea en la fase de weaponización y entrega de payloads. Su capacidad para generar código funcional permite a los hackers crear malware adaptado a entornos específicos, incorporando técnicas de ofuscación para evadir detección por sistemas EDR (Endpoint Detection and Response). Por instancia, un actor podría solicitar variaciones de un troyano de acceso remoto (RAT) que incorpore llamadas a APIs legítimas de Google, disfrazando el tráfico malicioso como actividad benigna.

Las simulaciones de ataque representan otro uso crítico. Gemini puede modelar escenarios de intrusión, prediciendo respuestas de defensas basadas en configuraciones conocidas. Esto incluye la evaluación de efectividad de exploits contra firewalls o sistemas SIEM, permitiendo iteraciones rápidas sin riesgo de exposición. En un caso documentado, un grupo APT utilizó IA similar para simular un ataque de envenenamiento de caché DNS, refinando el timing y los parámetros para maximizar el impacto.

La persistencia post-explotación también se beneficia de esta tecnología. Una vez dentro de una red, los atacantes consultan Gemini para generar scripts de movimiento lateral, como enumeración de credenciales Active Directory o exfiltración de datos codificados. La multimodalidad extiende esto a la interpretación de binarios o logs en tiempo real, acelerando la caza de privilegios elevados.

- Ofuscación dinámica: Genera código que muta en ejecución para eludir heurísticas de malware.

- Integración con C2: Sugiere canales de comando y control que mimetizan tráfico HTTPS legítimo.

- Exfiltración optimizada: Calcula rutas de salida que minimizan latencia y detección.

Estos avances técnicos democratizan el acceso a capacidades previamente reservadas para naciones con presupuestos elevados, nivelando el campo de juego en ciberconflicto geopolítico.

Implicaciones para la Ciberseguridad Global y Respuestas Institucionales

La explotación de Gemini AI por hackers estatales plantea desafíos profundos para la ciberseguridad global. En primer lugar, acelera el ciclo de vida de las amenazas, desde reconnaissance hasta ejecución, comprimiendo ventanas de oportunidad para la detección y mitigación. Organizaciones como Mandiant y CrowdStrike han reportado un aumento en campañas APT que incorporan IA, con tasas de éxito en intrusiones que superan el 30% comparado con métodos tradicionales.

Desde una perspectiva regulatoria, esto urge la adopción de marcos como el NIST AI Risk Management Framework, adaptados a contextos de ciberseguridad. Empresas deben implementar monitoreo de uso de IA en sus entornos, detectando patrones anómalos en consultas a modelos externos. Google, por su parte, ha respondido fortaleciendo safeguards en Gemini, incluyendo rate limiting y auditorías de prompts sospechosos, aunque la efectividad contra adversarios determinados permanece en debate.

En el ámbito internacional, iniciativas como la Convención de Budapest sobre Ciberdelito podrían expandirse para abarcar el mal uso de IA, promoviendo colaboración entre estados para rastrear y atribuir exploits basados en modelos. Sin embargo, la atribución técnica se complica por la naturaleza proxy de las interacciones con IA, donde los atacantes operan a través de bots o cuentas comprometidas.

Para defensores, la contramedida radica en IA defensiva: modelos que analizan tráfico de red en busca de firmas de prompts maliciosos o outputs generados por IA. Herramientas como Vectra AI o Darktrace ya incorporan elementos de machine learning para esta purpose, pero requieren entrenamiento en datasets actualizados con muestras de exploits de IA.

Medidas de Mitigación y Mejores Prácticas para Organizaciones

Las organizaciones enfrentan la necesidad de adoptar un enfoque multicapa para contrarrestar estas amenazas. En primer lugar, la segmentación de red y el principio de menor privilegio limitan el impacto de reconnaissance impulsado por IA, al reducir la superficie expuesta. Implementar zero-trust architecture asegura que incluso accesos internos requieran verificación continua, frustrando movimientos laterales generados por scripts de IA.

En el plano de la detección, el despliegue de honeypots avanzados puede atraer y registrar interacciones con herramientas de IA, proporcionando inteligencia para refinar defensas. Además, capacitar a equipos de seguridad en prompt engineering inversa permite identificar y bloquear consultas maliciosas en logs de API.

Políticas internas deben restringir el uso de modelos de IA públicos para tareas sensibles, optando por instancias on-premise o proveedores con compliance estricto. Auditorías regulares de código generado por IA, utilizando herramientas como SonarQube, detectan anomalías que indiquen origen malicioso.

- Entrenamiento continuo: Educar a empleados en reconocimiento de phishing asistido por IA.

- Colaboración sectorial: Compartir IOCs (Indicators of Compromise) relacionados con exploits de IA.

- Inversión en R&D: Desarrollar contramedidas basadas en IA adversarial para neutralizar modelos ofensivos.

Finalmente, la adopción de estándares como ISO 27001, actualizados para incluir riesgos de IA, fortalece la resiliencia organizacional contra estas evoluciones.

Cierre: Hacia un Futuro Seguro en la Era de la IA Avanzada

La explotación de Gemini AI por hackers respaldados por estados ilustra la convergencia inevitable entre avances tecnológicos y riesgos cibernéticos. Mientras la IA potencia innovaciones en múltiples dominios, su mal uso demanda una respuesta proactiva y coordinada. Al priorizar la ética en el diseño de modelos, fortalecer regulaciones internacionales y fomentar la innovación defensiva, la comunidad global puede mitigar estos peligros. El equilibrio entre accesibilidad y seguridad definirá el legado de herramientas como Gemini, asegurando que sirvan al progreso humano sin comprometer la integridad digital.

En última instancia, este escenario subraya la importancia de la vigilancia continua y la adaptación estratégica, posicionando a la ciberseguridad como un pilar esencial en la gobernanza de tecnologías emergentes.

Para más información visita la Fuente original.