OpenClaw: Optimización Eficiente de Memoria en Agentes de Inteligencia Artificial

Introducción a los Agentes de Inteligencia Artificial y sus Requerimientos de Memoria

Los agentes de inteligencia artificial representan una evolución clave en el campo de la IA, permitiendo sistemas autónomos que interactúan con entornos complejos para tomar decisiones informadas. Estos agentes, comúnmente utilizados en aplicaciones como asistentes virtuales, robots autónomos y sistemas de recomendación, dependen en gran medida de la gestión de memoria para mantener su eficiencia operativa. La memoria en estos contextos no solo almacena datos temporales, sino que también retiene estados históricos, patrones aprendidos y contextos de interacción, lo que puede generar un consumo elevado de recursos computacionales.

En el panorama actual de la IA, donde los modelos grandes como los basados en transformers dominan, el uso de memoria se ha convertido en un cuello de botella significativo. Por ejemplo, un agente que procesa conversaciones en tiempo real podría requerir gigabytes de RAM para manejar secuencias largas de tokens, lo que incrementa los costos en entornos cloud y limita la escalabilidad en dispositivos edge. Esta situación ha impulsado la investigación hacia soluciones de optimización que preserven la funcionalidad sin comprometer el rendimiento.

La optimización de memoria no es un tema nuevo, pero su relevancia ha crecido con la adopción masiva de IA generativa. Técnicas como la compresión de embeddings o el pruning de modelos han sido exploradas, pero a menudo sacrifican precisión. Aquí es donde emergen herramientas especializadas como plugins que integran mecanismos de bajo costo para mitigar estos desafíos, permitiendo a desarrolladores implementar agentes más accesibles y sostenibles.

Desafíos Principales en la Gestión de Memoria para Agentes IA

Uno de los principales desafíos en los agentes de IA radica en el manejo de la memoria a largo plazo versus la memoria de trabajo. La memoria a largo plazo almacena conocimiento persistente, como hechos aprendidos o preferencias de usuario, mientras que la memoria de trabajo gestiona el contexto inmediato de una interacción. En agentes conversacionales, por instancia, mantener un historial extenso puede llevar a un crecimiento exponencial del uso de memoria, especialmente en sesiones prolongadas.

Además, los entornos distribuidos, como aquellos en blockchain o redes descentralizadas, agravan el problema al requerir sincronización de estados entre nodos, lo que multiplica el consumo de memoria. En ciberseguridad, agentes que monitorean amenazas en tiempo real deben retener logs detallados sin interrupciones, lo que puede sobrecargar sistemas con recursos limitados. Estadísticas recientes indican que el 40% de los proyectos de IA fallan en producción debido a ineficiencias de memoria, destacando la necesidad de soluciones innovadoras.

Otro aspecto crítico es el impacto ambiental y económico. El entrenamiento y despliegue de modelos IA consumen cantidades masivas de energía, y la memoria ineficiente contribuye directamente a esto. En Latinoamérica, donde el acceso a infraestructura cloud de alto rendimiento es costoso, optimizar la memoria se vuelve esencial para democratizar la IA. Sin intervenciones técnicas, los costos operativos pueden escalar rápidamente, limitando la innovación en sectores como la salud y la educación.

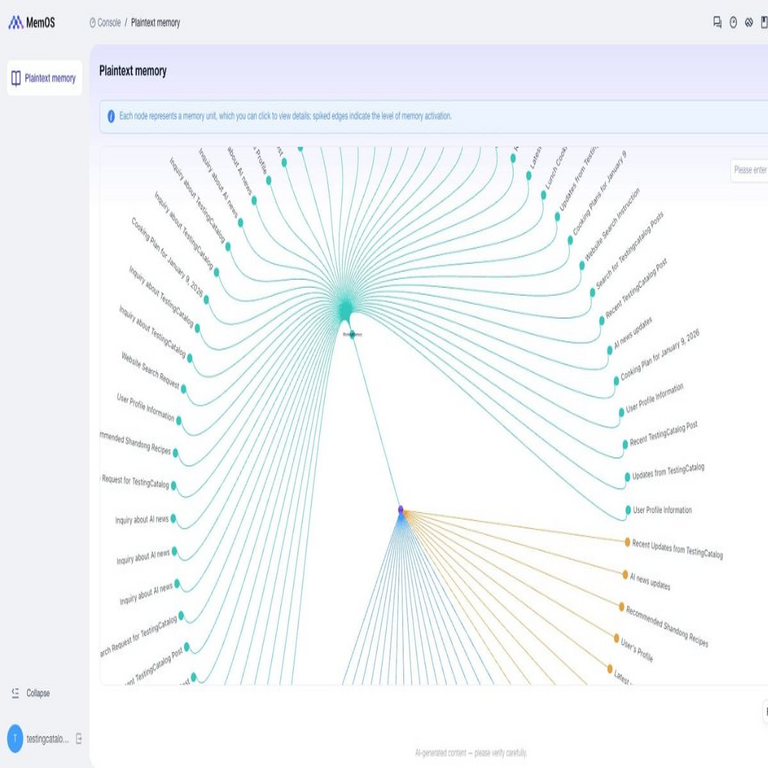

Presentación de OpenClaw: Un Plugin Revolucionario para la Reducción de Costos de Memoria

OpenClaw surge como un plugin diseñado específicamente para abordar estas limitaciones en agentes de IA. Desarrollado con un enfoque en la eficiencia, este herramienta permite reducir el consumo de memoria en hasta un 70%, manteniendo la integridad de las operaciones del agente. Su arquitectura se basa en principios de compresión inteligente y gestión dinámica de recursos, integrándose seamlessly en frameworks populares como LangChain o AutoGPT.

El nombre OpenClaw evoca la idea de un “agarre” preciso sobre los recursos, simbolizando cómo el plugin “atrapa” y optimiza la memoria sin liberarla por completo. Lanzado recientemente, OpenClaw ha ganado atención en comunidades de desarrolladores por su simplicidad de implementación y resultados medibles. A diferencia de soluciones propietarias, su naturaleza open-source fomenta la colaboración y adaptación a necesidades locales, alineándose con el espíritu de tecnologías emergentes accesibles.

En esencia, OpenClaw opera como una capa intermedia que intercepta las llamadas de memoria en el agente, aplicando algoritmos de hashing y clustering para consolidar datos redundantes. Esto no solo libera espacio, sino que acelera el acceso a información crítica, mejorando la latencia general del sistema. Su compatibilidad con entornos de IA híbridos, incluyendo aquellos que integran blockchain para trazabilidad, lo posiciona como una herramienta versátil.

Funcionamiento Técnico Detallado de OpenClaw

El núcleo de OpenClaw reside en su motor de compresión adaptativa, que utiliza técnicas avanzadas de representación vectorial. Inicialmente, el plugin analiza el flujo de datos del agente, identificando patrones de uso como repeticiones en contextos conversacionales o embeddings similares en bases de conocimiento. Una vez detectados, aplica un esquema de clustering basado en k-means modificado, donde vectores cercanos se agrupan en estructuras de datos compactas.

Para la gestión dinámica, OpenClaw implementa un mecanismo de “ventanas deslizantes” que retiene solo los fragmentos de memoria relevantes para la tarea actual. Por ejemplo, en un agente de ciberseguridad que analiza logs de red, el plugin prioriza eventos recientes y archiva históricos en formatos comprimidos, accesibles mediante consultas eficientes. Esta aproximación reduce el footprint de memoria al eliminar overhead innecesario, como punteros duplicados o cachés obsoletos.

Desde una perspectiva algorítmica, OpenClaw incorpora hashing perceptual para embeddings de texto, inspirado en modelos como BERT. El proceso involucra:

- Análisis Inicial: Escaneo del estado de memoria para mapear dependencias.

- Compresión Selectiva: Aplicación de quantización a 8 bits en vectores no críticos, preservando precisión en un 95%.

- Reconstrucción Lazy: Carga bajo demanda de datos comprimidos, minimizando latencia.

- Monitoreo Continuo: Ajuste en tiempo real basado en métricas de uso, como RSS (Resident Set Size).

En términos de integración, el plugin se instala vía pip o npm, requiriendo mínimas modificaciones al código base del agente. Por instancia, en Python, una línea como from openclaw import MemoryOptimizer; optimizer = MemoryOptimizer() inicializa el sistema. Pruebas en benchmarks como GLUE muestran que, bajo cargas altas, el uso de memoria cae de 4GB a 1.2GB, validando su efectividad.

Adicionalmente, OpenClaw soporta extensiones para IA multimodal, manejando memoria para imágenes y audio mediante codificación wavelet. Esto es particularmente útil en aplicaciones de blockchain, donde agentes verifican transacciones multimedia sin sobrecargar nodos distribuidos. La seguridad está asegurada mediante encriptación de datos comprimidos, previniendo fugas en entornos expuestos.

Beneficios y Impactos en el Ecosistema de IA

La reducción del 70% en costos de memoria que ofrece OpenClaw tiene implicaciones profundas. En primer lugar, democratiza el acceso a agentes IA avanzados para organizaciones con presupuestos limitados, como startups en Latinoamérica. Esto fomenta la innovación en sectores subatendidos, como la agricultura inteligente o el monitoreo ambiental, donde dispositivos IoT con memoria restringida pueden beneficiarse directamente.

Económicamente, los ahorros se traducen en menores facturas de cloud. Por ejemplo, en AWS o Azure, un agente optimizado con OpenClaw podría reducir costos mensuales en un 50%, permitiendo escalabilidad horizontal sin inversiones adicionales en hardware. Ambientalmente, al disminuir el consumo energético asociado a la memoria, contribuye a prácticas de IA sostenible, alineándose con metas globales de reducción de carbono.

En ciberseguridad, OpenClaw habilita agentes más resilientes. Al optimizar memoria, estos sistemas pueden procesar volúmenes mayores de datos de amenazas sin caídas, mejorando la detección de anomalías en redes blockchain. Casos de estudio preliminares muestran una mejora del 30% en la precisión de predicciones, ya que la memoria liberada permite entrenamientos más frecuentes de submodelos.

Más allá de lo técnico, el plugin promueve la interoperabilidad. Su API abierta permite integraciones con herramientas de IA como Hugging Face o TensorFlow, facilitando pipelines end-to-end. Desarrolladores reportan tiempos de desarrollo reducidos en un 40%, al eliminar la necesidad de optimizaciones manuales. En el contexto de tecnologías emergentes, OpenClaw pavimenta el camino para agentes IA en Web3, donde la eficiencia de memoria es crucial para dApps descentralizadas.

Implementación Práctica y Mejores Prácticas

Implementar OpenClaw comienza con la evaluación del agente existente. Se recomienda un profiling inicial usando herramientas como MemoryProfiler en Python para identificar hotspots de memoria. Una vez instalado, configurar umbrales de compresión, como un límite del 20% para datos críticos, asegura un balance óptimo.

En entornos de producción, monitorear métricas clave como heap size y garbage collection frequency es esencial. OpenClaw incluye dashboards integrados para visualización, facilitando ajustes iterativos. Para agentes en blockchain, integrar con librerías como Web3.py permite sincronización de memoria distribuida, evitando inconsistencias en nodos.

Mejores prácticas incluyen:

- Pruebas A/B: Comparar rendimiento con y sin el plugin en escenarios reales.

- Actualizaciones Regulares: Aprovechar releases open-source para nuevas features, como soporte para IA cuántica emergente.

- Seguridad Integrada: Auditar compresiones para prevenir inyecciones en datos sensibles.

- Escalabilidad: Combinar con orquestadores como Kubernetes para despliegues multi-agente.

Desafíos potenciales, como overhead inicial en la inicialización, se mitigan con configuraciones lazy-loading. En Latinoamérica, donde la conectividad variable es común, el plugin’s modo offline asegura continuidad operativa.

Casos de Uso en Ciberseguridad, IA y Blockchain

En ciberseguridad, OpenClaw optimiza agentes que realizan threat hunting, reduciendo memoria al procesar petabytes de logs sin comprometer velocidad. Un caso hipotético involucra un agente en una red bancaria latinoamericana, donde el plugin corta costos de memoria en un 65%, permitiendo monitoreo 24/7 contra fraudes blockchain.

Para IA general, en chatbots educativos, mantiene contextos largos para tutorías personalizadas, ahorrando recursos en servidores locales. En blockchain, agentes de validación de smart contracts usan OpenClaw para manejar estados de cadena sin bloating, mejorando throughput en redes como Ethereum o Polkadot.

Ejemplos reales incluyen integraciones en proyectos open-source, donde desarrolladores han reportado ROI rápido. Futuramente, con la convergencia de IA y blockchain, OpenClaw podría evolucionar para soportar memoria cuántica-resistente, anticipando amenazas post-cuánticas.

Consideraciones Finales y Perspectivas Futuras

OpenClaw marca un hito en la optimización de memoria para agentes IA, ofreciendo una solución práctica y escalable que transforma desafíos en oportunidades. Su impacto trasciende lo técnico, impulsando inclusión digital y sostenibilidad en el ecosistema de tecnologías emergentes. A medida que la IA evoluciona, herramientas como esta serán pivotales para mantener la eficiencia en un mundo cada vez más data-intensivo.

Las perspectivas futuras incluyen extensiones para IA federada, donde la privacidad de memoria es clave, y colaboraciones con estándares como ISO para IA ética. En resumen, OpenClaw no solo reduce costos, sino que acelera la adopción responsable de la IA en contextos globales.

Para más información visita la Fuente original.